Kafka监控与日志分析秘籍:诊断node -1问题的必备工具

发布时间: 2024-12-28 18:52:19 阅读量: 4 订阅数: 4

kafka-node-tsd:kafka-node 库的 TSD 文件。 开发中

# 摘要

本文全面探讨了Kafka监控与日志分析的关键概念和实践技巧。首先,概述了监控与日志分析的重要性和基础架构,包括Kafka日志的结构和分析工具。随后,深入分析了如何实施有效的监控策略,并对node -1问题进行了成因分析、诊断和解决方法的讨论。最后,探索了Kafka安全监控、故障自愈和在大数据环境下监控挑战的进阶应用。文章旨在为Kafka系统的稳定运行提供全面的监控和日志分析指南,以确保系统的高效性和可靠性。

# 关键字

Kafka监控;日志分析;node -1问题;安全审计;故障自愈;大数据挑战

参考资源链接:[kafka调试中遇到Connection to node -1 could not be established. Broker may not be available.](https://wenku.csdn.net/doc/6412b6b7be7fbd1778d47b97?spm=1055.2635.3001.10343)

# 1. Kafka监控与日志分析概述

## Kafka监控与日志分析的意义

在大数据处理的生态系统中,Apache Kafka作为一个分布式的流媒体平台,广泛应用于实时数据管道、消息队列、事件源等多种场景。对Kafka进行监控和日志分析对于确保消息传递的可靠性、系统的稳定性及性能优化至关重要。有效的监控可以帮助运维团队及时发现并响应系统中的问题,而日志分析则为问题诊断提供了直接的线索。

## 监控与日志分析的目标

监控的主要目标包括:

- **系统稳定性保障**:预防系统故障,确保消息传递无丢失。

- **性能监控**:检测瓶颈,提升Kafka集群的处理能力。

日志分析的目的在于:

- **问题定位**:快速定位系统运行中的异常。

- **性能优化**:根据日志分析结果调整配置,提升系统性能。

## 关键技术和工具

在监控和日志分析方面,存在着多种技术和工具,比如:

- **内置工具**:Kafka自带命令行工具,如`kafka-run-class.sh`,可以用来执行日志分析。

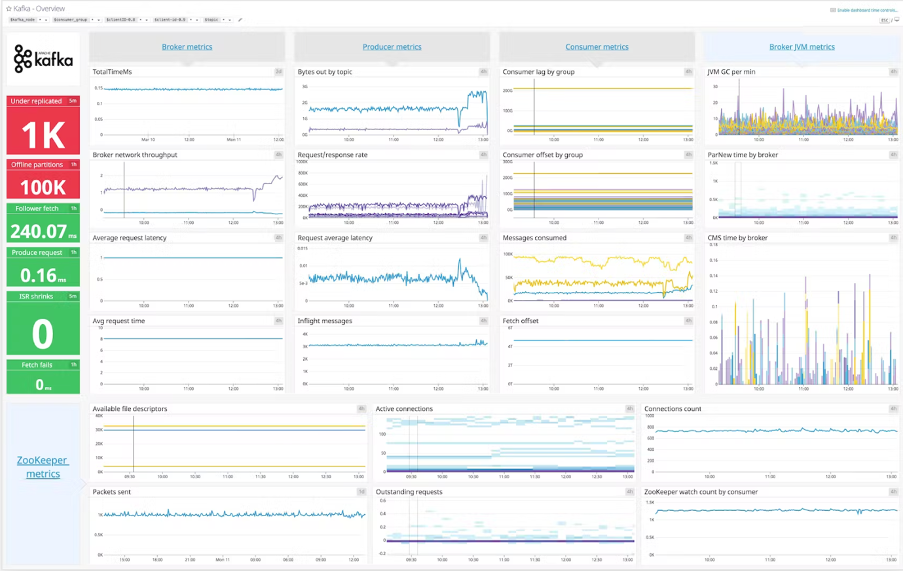

- **第三方监控系统**:如Prometheus、Grafana等,提供可视化监控面板。

- **日志分析工具**:如ELK Stack(Elasticsearch、Logstash、Kibana),用于日志的收集、存储和分析。

接下来的章节将深入探讨Kafka的监控和日志分析的各个方面,包括日志结构解析、常用分析工具和命令、监控实践与策略,以及node -1问题的诊断与解决等。通过这些内容,读者将能更好地理解和掌握Kafka系统的监控与日志分析技术。

# 2. Kafka日志结构与分析基础

## 2.1 Kafka日志架构解析

### 2.1.1 Kafka日志分段机制

Kafka 日志分段机制是其高效存储和管理消息的关键特性之一。Kafka 将每个分区的数据文件分成多个段,以便于管理和提高性能。段文件通常包含多个消息记录,每当达到配置的最大消息数或者段的最大大小(log segment bytes)时,就会创建一个新的段。

分段机制有几个主要优点:

- **数据管理**:通过分段,可以有效地管理存储空间,当数据过期时,只需删除整个段文件,而不是单条消息。

- **提高性能**:为了读写操作的效率,Kafka 会将热点段文件加载到内存中,分段可以限制内存使用,避免一次性加载整个分区。

- **便于维护**:分段使得日志的滚动备份和灾难恢复变得简单。

在实现层面,Kafka 使用一个称为 `LogSegment` 的类来表示单个日志段,每个段都会有一个对应的 `.log` 文件存储数据和一个 `.index` 文件存储索引信息。

### 2.1.2 日志索引结构及其作用

Kafka 日志索引结构主要提供了消息偏移量到物理位置的映射功能,这使得快速查找和读取消息成为可能。每个日志段包含一个索引文件,该索引文件记录了消息的偏移量和它在日志段中的位置。

索引文件有两层结构:

- **稀疏索引**:默认情况下,每隔 `log.index.interval.bytes` 配置的字节数,就会在索引文件中添加一个索引项。

- **时间戳索引**(可选):Kafka 0.11.0版本引入,允许根据时间戳快速访问消息。

索引结构中的每个索引项包含以下信息:

- 消息的偏移量:表示消息在日志中的位置。

- 物理位置:表示消息在日志段文件中的位置(文件偏移量和长度)。

- 时间戳:可选的时间戳信息。

这允许Kafka执行快速查找,例如查找某个偏移量的消息或给定时间戳的消息。索引的维护会增加写操作的开销,但Kafka对此做了优化,如采用异步索引更新和稀疏索引策略来平衡性能。

## 2.2 Kafka日志分析工具和命令

### 2.2.1 常用Kafka日志分析命令

在 Kafka 的安装目录的 bin 文件夹中,我们能找到一系列与日志管理相关的脚本工具。其中,`kafka-run-class.sh` 是运行 Kafka 内建工具的入口脚本。以下是一些常用的命令:

- `kafka-console-consumer.sh`:用于从 Kafka 主题中消费消息,可以配合参数 `--from-beginning` 来从最早的消息开始消费。

- `kafka-console-producer.sh`:用于向 Kafka 主题发送消息。

- `kafka-consumer-groups.sh`:用于查看和管理消费者群组的状态,它可以帮助我们了解哪些消费者正在处理消息。

在这些脚本中,我们能够执行如下的操作:

- 查看主题信息:`kafka-topics.sh --describe --topic <topic-name>`

- 列出所有主题:`kafka-topics.sh --list`

- 查看消费者的消费位置:`kafka-consumer-groups.sh --bootstrap-server <broker-list> --describe --group <consumer-group-id>`

例如,获取一个特定主题的详细信息的命令可以这样执行:

```sh

kafka-topics.sh --bootstrap-server localhost:9092 --describe --topic my-topic

```

这将返回关于 `my-topic` 的一系列信息,包括分区数量、副本因子、ISR 列表、leader 副本等。

### 2.2.2 日志分析工具的使用案例

Kafka自带的工具足以进行初步的日志分析,但还有第三方工具如 `kafka-tools`、`kafka-manager`、`confluent-control-center` 等可以进行更为复杂的监控和分析。

例如,使用 `kafka-consumer-groups.sh` 工具来查看消费者群组的详细信息:

```sh

kafka-consumer-groups.sh --bootstrap-ser

```

0

0