Java算法自学与大数据处理:算法在海量数据中的应用

发布时间: 2024-08-28 06:15:27 阅读量: 33 订阅数: 22

java数据结构与算法.pdf

# 1. Java算法基础

Java算法是计算机科学的基础,也是大数据处理中的核心技术。本章将介绍Java算法的基本概念、分类和设计原则,为后续章节深入探讨算法在海量数据处理中的应用奠定基础。

**1.1 算法的概念**

算法是一种明确定义的、有限的指令序列,用于解决特定问题。它具有输入、输出、计算过程和终止条件等基本要素。

**1.2 算法的分类**

根据算法解决问题的不同方式,可以将其分为以下几类:

- 搜索算法:用于在数据结构中查找特定元素或满足特定条件的元素。

- 排序算法:用于将数据元素按特定顺序排列。

- 图形算法:用于处理图结构,如查找最短路径、最大匹配等。

- 数值算法:用于解决数学问题,如求解方程、计算积分等。

# 2. 大数据处理中的算法应用

### 2.1 大数据处理概述

#### 2.1.1 大数据的特点和挑战

大数据具有以下特点:

- **体量庞大:**数据量达到 PB 级甚至 EB 级。

- **多样性:**数据类型丰富,包括结构化、非结构化和半结构化数据。

- **速度快:**数据生成和处理速度极快,需要实时或近实时处理。

- **价值密度低:**有价值的信息往往隐藏在海量数据中,需要挖掘和分析。

这些特点给大数据处理带来了以下挑战:

- **存储和管理:**如何高效存储和管理海量数据。

- **处理和分析:**如何快速处理和分析大数据,从中提取有价值的信息。

- **可视化和交互:**如何将大数据处理结果以直观易懂的方式呈现给用户。

#### 2.1.2 大数据处理技术

为了应对大数据处理的挑战,出现了以下技术:

- **分布式计算:**将大数据分布在多个节点上进行处理,提高处理效率。

- **云计算:**利用云平台提供的弹性计算资源,按需扩展大数据处理能力。

- **数据仓库:**用于存储和管理大数据,并提供快速查询和分析功能。

- **数据湖:**用于存储和管理原始数据,支持多种数据类型和灵活的查询。

### 2.2 算法在海量数据中的应用场景

算法在海量数据处理中有着广泛的应用,主要场景包括:

#### 2.2.1 数据挖掘和机器学习

- **数据挖掘:**从大数据中发现隐藏的模式和规律,用于预测、分类和异常检测。

- **机器学习:**训练算法模型,让计算机从数据中自动学习,进行预测、分类和决策。

#### 2.2.2 图形处理和网络分析

- **图形处理:**处理大规模图形数据,用于社交网络分析、推荐系统和欺诈检测。

- **网络分析:**分析网络结构和流量,用于网络安全、网络优化和社交网络研究。

### 2.3 算法在海量数据中的应用实践

#### 2.3.1 MapReduce编程模型

MapReduce是一种分布式计算编程模型,用于处理海量数据。其核心思想是将数据分成块,并将其分配给不同的节点进行处理,最后汇总处理结果。

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCount {

public static class Map extends Mapper<Object, Text, Text, IntWritable> {

@Override

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

String[] words = value.toString().split(" ");

for (String word : words) {

context.write(new Text(word), new IntWritable(1));

}

}

}

public static class Reduce extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable value : values) {

sum += value.get();

}

context.write(key, new IntWritable(sum));

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(Map.class);

job.setReducerClass(Reduce.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

job.waitForCompletion(true);

}

}

```

**参数说明:**

- `key`:输入数据的键,通常是行号或文件偏移量。

- `value`:输入数据的行文本。

- `context`:MapReduce框架提供的上下文对象,用于输出中间结果。

**逻辑分析:**

1. Map阶段:将输入数据按行分割成单词,并输出单词和单词计数为1的键值对。

2. Reduce阶段:将相同单词的键值对聚合在一起,并计算单词的总计数。

#### 2.3.2 Spark分布式计算框架

Spark是一种分布式计算框架,用于处理海量数据。其核心思想是将数据分成块,并将其缓存到内存中,以提高处理效率。

```scala

import org.apache.spark.SparkConf

import org.apache.spark.SparkContext

import org.apache.spark.rdd.RDD

object WordCount {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("word count").setMaster("local")

val sc = new SparkContext(conf)

val textFile = sc.textFile("input.txt")

val words = textFile.flatMap(_.split(" "))

val wordCounts = words.map(word => (word, 1)).reduceByKey(_ + _)

wordCounts.saveAsTextFile("output.txt")

}

}

```

**参数说明:**

- `conf`:Spark配置对象,用于设置应用程序名称和运行模式。

- `sc`:Spark上下文对象,用于创建RDD和执行操作。

- `textFile`:RDD,代表输入文本文件。

**逻辑分析:**

1. 加载输入文本文件,创建RDD。

2. 将文本文件按行分割成单词,创建新的RDD。

3. 将单词映射为键值对,其中单词为键,单词计数为1。

4. 根据键聚合单词计数,创建新的RDD。

5. 将单词计数保存到输出文本文件中。

# 3. Java算法在海量数据处理中的优化

### 3.1 算法优化技术

**3.1.1 时间复杂度和空间复杂度分析**

算法的效率由其时间复杂度和空间复杂度决定。时间复杂度衡量算法执行所需的时间,而空间复杂度衡量算法执行所需的内存。

**时间复杂度分析**

* **常数复杂度(O(1)):**算法执行时间与输入数据大小无关,始终为常数。

* **线性复杂度(O(n)):**算法执行时间与输入数据大小成正比,数据量增加一倍,执行时间也增加一倍。

* **对数复杂度(O(log n)):**算法执行时间与输入数据大小的对数成正比。

* **平方复杂度(O(n^2)):**算法执行时间与输入数据大小的平方成正比。

* **指数复杂度(O(2^n)):**算法执行时间与输入数据大小的指数成正比。

**空间复杂度分析**

* **常数复杂度(O(1)):**算法执行所需的内存与输入数据大小无关,始终为常数。

* **线性复杂度(O(n)):**算法执行所需的内存与输入数据大小成正比。

* **平方复杂度(O(n^2)):**算法执行所需的内存与输入数据大小的平方成正比。

**3.1.2 数据结构和算法选择**

选择合适的算法和数据结构对于优化算法性能至关重要。

**数据结构**

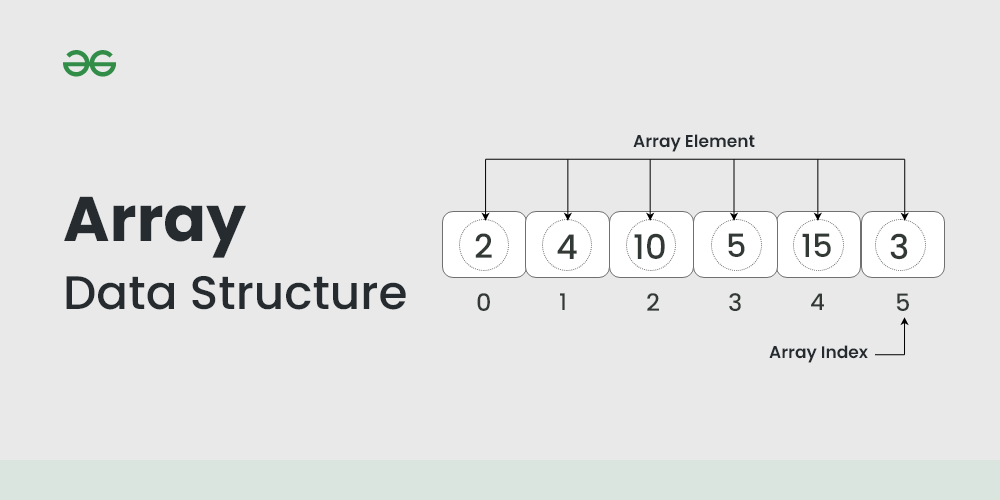

* **数组:**有序的元素集合,通过索引访问。

* **链表:**元素通过指针连接,提供高效的插入和删除操作。

* **栈:**后进先出(LIFO)数据结构,用于函数调用和递归。

* **队列:**先进先出(FIFO)数据结构,用于消息传递和任务调度。

* **树:**分层数据结构,用于排序、搜索和数据组织。

* **哈希表:**基于键值对的数据结构,用于快速查找和插入。

**算法**

* **排序:**对数据进行排序的算法,如快速排序、归并排序和堆排序。

* **搜索:**在数据中查找特定元素的算法,如二分查找、线性查找和哈希查找。

* **图算法:**处理图数据的算法,如深度优先搜索、广度优先搜索和最小生成树算法。

* **字符串匹配算法:**在字符串中查找模式的算法,如KMP算法、BM算法和Rabin-Karp算法。

* **动态规划算法:**解决复杂问题的一种算法,将问题分解成较小的子问题并重复利用已解决的子问题。

### 3.2 大数据处理平台的优化

**3.2.1 Hadoop生态系统**

Hadoop是一个开源的大数据处理平台,提供了一系列工具和框架,包括:

* **HDFS:**分布式文件系统,用于存储海量数据。

* **MapReduce:**分布式计算框架,用于并行处理大数据。

* **Hive:**数据仓库系统,用于查询和分析大数据。

* **HBase:**NoSQL数据库,用于存储和检索大规模非结构化数据。

**优化Hadoop性能**

* **调优HDFS:**优化块大小、副本因子和数据放置策略。

* **优化MapReduce:**调优任务大小、分区数和数据本地化。

* **优化Hive:**优化表格式、查询优化器和数据压缩。

* **优化HBase:**优化表设计、数据分片和内存管理。

**3.2.2 Spark优化技术**

Spark是一个开源的分布式计算框架,提供了一种更快的替代MapReduce。

* **内存计算:**Spark将数据存储在内存中,而不是磁盘上,从而提高了处理速度。

* **弹性分布式数据集(RDD):**RDD是Spark中不可变的数据集合,支持并行操作。

* **转换和操作:**Spark提供了一系列转换和操作,用于处理和分析数据。

**优化Spark性能**

* **调优内存管理:**优化内存分配和垃圾回收。

* **调优任务调度:**优化任务大小、分区数和数据本地化。

* **调优数据持久化:**优化数据缓存和持久化策略。

* **调优广播变量:**优化广播变量的使用,以减少数据传输。

# 4. 第四章 Java算法在海量数据处理中的实践案例

### 4.1 推荐系统

#### 4.1.1 协同过滤算法

协同过滤算法是一种基于用户行为数据进行推荐的算法。其基本思想是:如果两个用户在过去对同一组物品表现出相似的偏好,那么他们很可能在未来对其他物品也表现出相似的偏好。

**协同过滤算法的步骤:**

1. **收集用户行为数据:**收集用户对物品的评分、购买记录或其他行为数据。

2. **计算用户相似度:**使用余弦相似度、皮尔逊相关系数等方法计算用户之间的相似度。

3. **预测用户对物品的评分:**根据用户相似度和物品评分,预测用户对未评分物品的评分。

4. **推荐物品:**根据预测的评分,向用户推荐评分最高的物品。

**协同过滤算法的优点:**

* 不需要人工干预,可以自动生成个性化推荐。

* 可以发现用户潜在的兴趣和需求。

* 随着用户行为数据的积累,推荐结果会不断改进。

**协同过滤算法的缺点:**

* 冷启动问题:对于新用户或新物品,没有足够的评分数据来计算相似度。

* 过拟合问题:当用户行为数据过于稀疏时,推荐结果可能会过于个性化,无法泛化到其他用户。

#### 4.1.2 内容推荐算法

内容推荐算法是一种基于物品属性进行推荐的算法。其基本思想是:如果两个物品在属性上相似,那么它们很可能受到同一组用户的喜爱。

**内容推荐算法的步骤:**

1. **提取物品属性:**提取物品的文本、图像、音频等属性。

2. **计算物品相似度:**使用余弦相似度、Jaccard相似系数等方法计算物品之间的相似度。

3. **推荐物品:**根据物品相似度和用户历史行为,向用户推荐相似度最高的物品。

**内容推荐算法的优点:**

* 可以解决协同过滤算法的冷启动问题。

* 可以提供可解释的推荐结果,用户可以了解推荐的原因。

* 可以发现用户对新物品的潜在兴趣。

**内容推荐算法的缺点:**

* 推荐结果可能过于单一,无法满足用户的多样化需求。

* 对于属性稀疏的物品,推荐结果可能会不准确。

### 4.2 图像处理

#### 4.2.1 图像分割算法

图像分割算法是一种将图像分割成不同区域的算法。其基本思想是:将图像中的像素点根据其颜色、纹理、形状等特征聚类,形成不同的区域。

**图像分割算法的步骤:**

1. **图像预处理:**对图像进行降噪、增强等预处理操作。

2. **像素聚类:**使用K-Means、Mean-Shift等聚类算法将像素点聚类成不同的区域。

3. **边缘检测:**使用Canny、Sobel等边缘检测算法检测图像中的边缘。

4. **区域合并:**将相邻的区域合并成更大的区域,形成最终的分割结果。

**图像分割算法的优点:**

* 可以提取图像中的感兴趣区域。

* 可以用于目标识别、图像编辑等应用。

* 可以提高图像处理的效率。

**图像分割算法的缺点:**

* 对于复杂图像,分割结果可能不准确。

* 不同的分割算法对不同的图像类型有不同的效果。

#### 4.2.2 图像识别算法

图像识别算法是一种识别图像中物体或场景的算法。其基本思想是:将图像中的像素点提取特征,并使用机器学习算法对这些特征进行分类。

**图像识别算法的步骤:**

1. **图像预处理:**对图像进行缩放、旋转等预处理操作。

2. **特征提取:**使用HOG、SIFT等特征提取算法提取图像中的特征。

3. **特征分类:**使用SVM、神经网络等机器学习算法对特征进行分类。

4. **识别结果:**根据分类结果识别图像中的物体或场景。

**图像识别算法的优点:**

* 可以识别图像中的复杂物体和场景。

* 可以用于人脸识别、物体检测等应用。

* 可以提高图像处理的自动化程度。

**图像识别算法的缺点:**

* 对于光照、遮挡等因素敏感,识别结果可能不准确。

* 训练图像识别算法需要大量的标注数据。

* 算法的复杂度较高,实时性较差。

# 5. Java算法在海量数据处理中的未来发展

### 5.1 算法创新趋势

随着大数据时代的到来,传统算法已经无法满足海量数据处理的需求,算法创新成为大数据处理领域的重要发展方向。

#### 5.1.1 深度学习和机器学习

深度学习和机器学习是近年来人工智能领域发展最快的两个方向。深度学习通过构建深度神经网络,可以从海量数据中自动学习特征,从而解决复杂的数据分析问题。机器学习则通过训练模型,让计算机从数据中学习知识,从而实现预测、分类等任务。

#### 5.1.2 分布式算法和并行计算

海量数据处理往往需要在分布式环境中进行,因此分布式算法和并行计算技术成为算法创新的重要方向。分布式算法将计算任务分配到多个节点上并行执行,从而提高计算效率。并行计算技术则利用多核处理器或GPU等并行硬件,进一步提升算法性能。

### 5.2 大数据处理平台的发展

大数据处理平台的发展也对算法创新提出了新的要求。

#### 5.2.1 云计算和边缘计算

云计算和边缘计算为大数据处理提供了灵活、可扩展的计算资源。云计算将计算任务转移到云端,可以按需分配资源,降低成本。边缘计算则将计算任务部署到靠近数据源的边缘设备上,可以减少数据传输延迟,提高实时性。

#### 5.2.2 数据湖和数据仓库

数据湖和数据仓库是两种不同的数据存储和管理技术。数据湖将所有数据存储在一个中央存储库中,而数据仓库则将数据结构化并组织成特定模式。随着大数据处理需求的多样化,数据湖和数据仓库需要不断发展,以满足不同的数据分析需求。

0

0