A190L音视频通话优化秘籍:提升通话质量的高级技巧

发布时间: 2025-01-04 00:45:37 阅读量: 8 订阅数: 5

Gigaset集怡嘉A190L中文说明书.pdf

# 摘要

音视频通话技术在现代社会通信中扮演着关键角色,其通话质量直接影响用户体验和满意度。本文从音视频通话的基础优化理论出发,探讨了音频信号处理、视频编码技术、网络环境、硬件性能、软件编码解码效率对通话质量的影响,并介绍通话质量评估标准。随后,本文重点讨论了通过网络带宽和延迟优化、编解码器选择调整、硬件加速与资源管理来提升通话质量的实践技术。特别地,针对特定的A190L音视频系统,本文提出了高级优化技巧,并探讨了实时音视频处理的算法优化。最后,本文通过案例研究分析优化成果,并展望了音视频通话技术的未来发展趋势,强调了新兴技术的应用潜力。

# 关键字

音视频通话质量;信号处理;编码技术;网络优化;硬件加速;编解码器;实时监控;未来趋势

参考资源链接:[Gigaset A190L 数字无绳电话使用指南](https://wenku.csdn.net/doc/2ocnzybwcc?spm=1055.2635.3001.10343)

# 1. 音视频通话质量的重要性

在当今的通信技术中,音视频通话已成为日常生活中不可或缺的一部分,尤其在商务会议、远程教育、在线娱乐等场合。高质量的音视频通话能够保证通信双方无障碍地进行有效沟通,提升用户体验,并对业务流程的顺利进行起到至关重要的作用。通话质量的优劣直接影响到用户对服务提供商的信任度和满意度,因此对音视频通话质量的追求是技术发展的永恒主题。接下来,我们将从技术原理、关键因素和评估标准等多个维度深入探讨音视频通话质量的重要性。

# 2. 音视频通话基础优化理论

音视频通话作为现代通讯技术的核心组成部分,在企业协作、远程教育、在线娱乐等多个领域发挥着不可替代的作用。为了保证通话的质量,深入理解音视频通话的基础理论至关重要。本章将从技术原理、关键影响因素,以及评估标准三个方面,对音视频通话进行基础性解析。

### 2.1 音视频通话的技术原理

音视频通话的技术原理涉及音频信号和视频信号的处理与传输,它们是实现高质量通话体验的基石。

#### 2.1.1 音频信号的处理和传输

音频信号在被捕捉之后,首先要进行采样、量化和编码。这一过程需要考虑到人耳的听觉范围以及采样定理。以44.1kHz的采样率为例,它能够覆盖人耳20kHz的听觉范围,符合尼奎斯特采样定理。量化过程中通常使用线性PCM(脉冲编码调制)格式来保持信号的完整性。

```python

# 示例:使用Python的pydub库进行音频的采样率转换

from pydub import AudioSegment

# 加载音频文件

audio = AudioSegment.from_file("path_to_audio_file.wav")

# 转换采样率到44.1kHz

audio = audio.set_frame_rate(44100)

# 保存处理后的音频文件

audio.export("converted_audio.wav", format="wav")

```

上述代码段简单演示了如何使用`pydub`库来更改音频文件的采样率。这是音频处理的一个基础操作,但对于保证通话质量来说至关重要。

#### 2.1.2 视频信号的编码和传输

视频信号的编码过程通常涉及编码器(如H.264, H.265)将原始图像压缩成较小的文件大小。这一过程需要权衡压缩率和视频质量。传输时,由于网络带宽的限制,可能需要动态地调整视频的分辨率和帧率以适配网络条件。

```mermaid

graph LR

A[原始视频] --> B[编码器]

B --> C[压缩视频流]

C --> D[网络传输]

D --> E[解码器]

E --> F[播放视频]

```

上述的mermaid流程图展示了视频信号编码和传输的基本流程,从编码器输出压缩视频流,经过网络传输后由解码器进行解码以播放视频。

### 2.2 影响通话质量的关键因素

音视频通话质量受到多种因素的影响,其中网络环境、硬件性能以及软件编解码效率是最为关键的。

#### 2.2.1 网络环境的影响分析

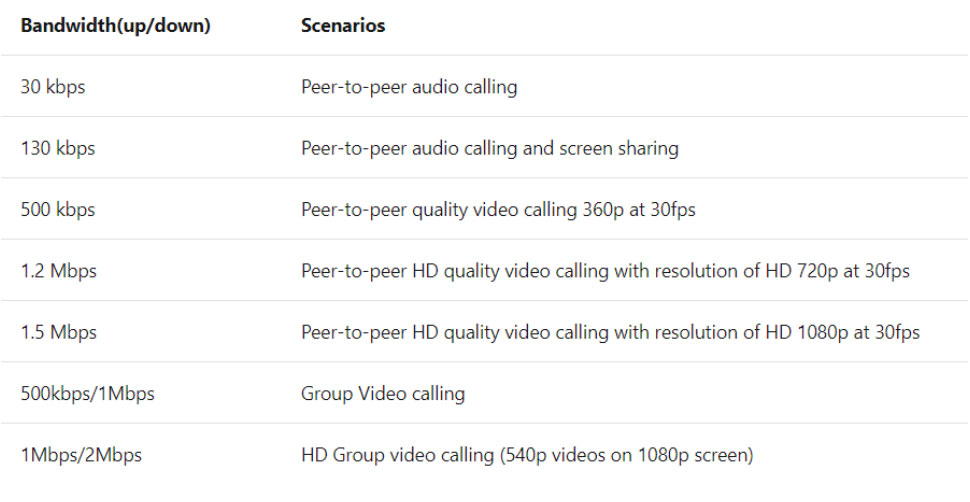

网络带宽和延迟是影响通话质量的两个主要网络因素。高质量的通话需要足够的上行和下行带宽来保证音频和视频数据的顺畅传输。此外,网络延迟和抖动的控制对于减少通话中的卡顿和断续现象也至关重要。

```markdown

网络带宽要求表:

| 视频分辨率 | 音频质量 | 推荐最小上行带宽 |

|-------------|----------|------------------|

| VGA (640x480) | 高质量音频 | 1 Mbps |

| HD (1280x720) | 高质量音频 | 2 Mbps |

| FHD (1920x1080) | 高质量音频 | 3 Mbps |

```

在上表中,我们可以看到不同分辨率和音质标准下,对于网络带宽的基本需求。

#### 2.2.2 硬件性能的优化点

硬件性能对通话质量有直接影响。CPU处理能力决定了软件编解码的速度,而GPU和DSP则在视频处理中起着重要作用。对于音视频通话系统来说,优化硬件使用,例如减少CPU资源占用和利用GPU进行视频编码,可以提升系统的整体效率。

```markdown

| 硬件组件 | 功能 | 优化方向 |

|----------|------|-----------|

| CPU | 软件编解码 | 选择高效的编解码算法,使用多线程提高处理速度 |

| GPU | 视频渲染 | 利用硬件加速进行视频编码和渲染 |

| DSP | 音频处理 | 专门的音频处理硬件可提供低延迟的音频处理能力 |

```

#### 2.2.3 软件编码与解码的效率问题

软件编解码效率对于通话质量同样至关重要。软件编解码需要消耗大量的CPU资源,因此编码和解码效率直接关系到通话是否流畅。选择高效且低资源占用的编解码器和合适的参数,对通话质量有显著提升作用。

```markdown

常用编解码器参数对比:

| 编解码器 | 延迟 | 资源占用 | 压缩率 |

|----------|------|----------|--------|

| G.711 | 低 | 高 | 低 |

| G.722 | 中 | 中 | 中 |

| Opus | 中 | 低 | 高 |

```

通过对比表中的不同编解码器参数,我们可以根据实际需要选择最合适的编解码策略。

### 2.3 通话质量评估标准

对于音视频通话质量的评估,通常需要结合客观指标和主观体验进行综合判断。客观指标可以从技术参数角度提供量化的数据,而主观体验则是对通话质量的直接感受。

#### 2.3.1 客观指标与主观体验的对比

客观指标,如丢包率、抖动和延迟,是评估通话质量的科学依据。它们直接影响通话的流畅性和清晰度。主观体验则依赖于用户的反馈,如对音质和画质的满意度,以及通话过程中是否存在打扰感等。

```markdown

音视频通话质量主观评估表:

| 评价维度 | 评价指标 | 分值范围 |

|----------|----------|----------|

| 音质 | 清晰度 | 1-5 |

| | 噪声干扰 | 1-5 |

| 视频 | 清晰度 | 1-5 |

| | 卡顿程度 | 1-5 |

| 综合体验 | 连接稳定性 | 1-5 |

| | 使用便捷性 | 1-5 |

```

#### 2.3.2 常用的音视频质量评估工具

为了客观评估音视频通话质量,一些工具和方法被广泛应用于工业界。例如PESQ(Perceptual Evaluation of Speech Quality)是一种常见的语音质量评估方法,而PSNR(Peak Signal-to-Noise Ratio)和SSIM(Structural Similarity Index)等标准被用于评估视频质量。

```markdown

常见音视频质量评估工具:

| 工具名称 | 评估内容 | 特点 |

|----------|----------|------|

| PESQ | 语音质量 | 客观测量,反映用户感知 |

| PSNR | 视频质量 | 易于计算,高值表示高质量 |

| SSIM | 视频质量 | 结构信息相似性,更贴近人眼感知 |

```

以上章节对音视频通话基础优化理论进行了详细解读,从技术原理到影响因素,再到评估标准,为理解音视频通话质量提供了全面的视角。在接下来的章节中,我们将探讨实际的音视频通话实践优化技术。

# 3. 音视频通话实践优化技术

音视频通话的质量直接关系到用户沟通体验的优劣。尽管目前市面上有很多音视频通话的应用,但由于各种技术瓶颈的存在,用户仍然经常遇到通话延迟高、视频卡顿、声音断断续续等问题。本章将详细探讨如何通过实践技术来优化音视频通话质量。

## 网络带宽和延迟优化

网络带宽和延迟是影响音视频通话质量的两个重要方面。优化它们可以显著提高通话体验。

### 带宽管理与分配策略

带宽是数据传输的通道宽度,带宽越大,理论上可以传输的数据量也就越大。在音视频通话中,带宽管理主要是保证足够的数据传输速率,以避免画面和声音的卡顿。

#### 代码示例与分析

在VoIP(Voice over Internet Protocol)系统中,可以使用实时传输协议(RTP)来管理数据包的传输。以下是一个简化的RTP数据包封装和发送的例子。

```python

import socket

import struct

def send_rtp_packet(sequence_number, timestamp, payload):

# RTP Header, 12 bytes

version = 2

padding = 0

extension = 0

csrc_count = 0

marker = 1

payload_type = 0 # 例如0代表PCM音频

header = struct.pack('!BBH', (version << 6) + (padding << 5) + (extension << 4) + (csrc_count),

(marker << 7) + (payload_type), sequence_number)

header += struct.pack('!I', timestamp)

header += struct.pack('!H', len(payload))

# Send RTP Packet

sock = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

sock.sendto(header + payload, ('<目的IP>', <目的端口>))

sequence_number = 0

timestamp = 0

while True:

# 假设我们有一个音频帧payload

payload = get_next_audio_frame()

send_rtp_packet(sequence_number, timestamp, payload)

sequence_number += 1

timestamp += 采样率 # 通常1秒的音频样本数

```

在上面的代码中,RTP头部信息被正确打包,数据包可以被发送到网络上。`send_rtp_packet`函数封装了RTP数据包并发送到指定的目的地。

为了进一步优化带宽使用,可以采用以下策略:

- **动态带宽调整**:根据网络条件动态调整音视频的比特率。

- **码率控制**:根据网络拥塞情况和丢包率,动态调整发送的码率。

### 延迟降低与抖动控制技术

延迟通常定义为数据从发送端到接收端所需的时间。在音视频通话中,延迟超过200ms会明显影响通话质量。抖动是指网络延迟的不一致性,表现为通话中的断断续续。

#### 技术措施

- **Jitter Buffer**:使用抖动缓冲区平滑掉延迟的波动,但增加缓冲会增加延迟。

- **适时重传**:对于丢失的数据包,通过RTCP(Real-time Control Protocol)进行适时的重传。

- **网络适应算法**:如Google的QUIC协议,可减少TCP三次握手时间,减少延迟。

## 音视频编解码器的选择与调整

编解码器(CODEC)是音视频通话中的另一个关键组件。合适的编解码器及其参数调整可以大幅改善通话质量。

### 现有编解码器的性能对比

在音视频通话中,常见的音频编解码器有G.711、G.722、Opus等;视频编解码器包括H.264、VP8、HEVC等。

- **音频编解码器性能**:

- G.711(PCMA/PCMU):广泛支持,适用于高质量音频,但数据量较大。

- Opus:自适应码率,可在低带宽下提供良好的音频质量,同时适用于宽带传输。

- **视频编解码器性能**:

- H.264(AVC):高效压缩比,低带宽下的视频质量较好,但编码速度较慢。

- HEVC(H.265):新一代视频编码标准,相比H.264,具有更优的压缩率,但编解码复杂度更高。

### 编解码参数的调优方法

调优编解码器参数需要根据实际使用场景和网络条件。例如,可以调整以下参数以适应不同的通话环境:

- **帧率**:视频的帧率决定了每秒显示的图像数量。过高会导致带宽需求增加,过低则会导致画面不流畅。

- **分辨率**:视频通话的分辨率越高,所需带宽越大。

- **比特率**:音频和视频的比特率决定了其数据传输速率。比特率越高,音视频质量通常越好,但所需带宽也越高。

#### 代码示例与分析

假设使用FFmpeg库来调整视频通话的编解码参数。以下是一个FFmpeg命令行示例,它展示了如何调整视频的帧率和分辨率。

```shell

ffmpeg -i input.mp4 -vf "fps=30,scale=1280x720" -b:v 1M -b:a 128k output.mp4

```

在这个例子中:

- `-vf` 选项允许我们对视频帧应用过滤器。`fps=30`设置视频的目标帧率为30帧每秒,`scale=1280x720`调整视频的分辨率为1280x720像素。

- `-b:v` 设置视频比特率为1 Mbps,`-b:a` 设置音频比特率为128 Kbps。

## 硬件加速与资源管理

硬件加速和资源管理在音视频通话系统中起到至关重要的作用,可以有效提升处理效率和通话质量。

### GPU和DSP在音视频处理中的应用

- **GPU**:图形处理单元通常用于视频的渲染和编码,其并行处理能力可以大幅提高视频处理的速度。

- **DSP**:数字信号处理器用于音频信号的处理,包括回声消除、噪声抑制等。

#### 代码示例与分析

以GPU编码为例,我们通常会调用GPU加速API,如NVIDIA的NVENC或AMD的AMF来利用GPU进行视频编码。以下是一个使用NVIDIA NVENC API进行视频编码的简化过程。

```c++

NVENCSTATUS status = NVEncOpenEncodeSession(&apiVersion, NVENCAPI NVEncodeAPI, device, encodingConfiguration, &nvEncDevice);

```

在这个代码块中,我们首先调用`NVEncOpenEncodeSession`函数来创建一个编码会话。这个过程涉及到多个参数,如API版本、编码API类型、使用的设备等。

- **资源调度优化**:在操作系统级别,可以采用CPU亲和性(CPU Affinity)和实时优先级设置,来确保音视频处理任务可以优先使用CPU资源。

### 操作系统级别的资源调度优化

操作系统级别资源调度优化可以通过以下步骤实现:

- **设置CPU亲和性**:通过`taskset`命令或其他工具,将进程绑定到特定的CPU核心上运行。

- **设置实时优先级**:在Linux中可以使用`chrt`命令改变进程的调度策略和优先级。例如,设置FIFO策略和最高优先级。

```shell

sudo chrt -f -p 95 <进程ID>

```

在上述命令中,`-f`表示FIFO调度策略,`-p`后跟进程ID,`95`是设置的实时优先级。

## 结语

本章深入探讨了音视频通话实践优化技术,包括网络带宽和延迟优化、编解码器的选择与调整,以及硬件加速与资源管理。下一章,我们将深入讨论针对特定硬件平台A190L的高级优化技巧。

# 4. A190L音视频系统高级优化技巧

在音视频通话系统中,A190L这样的专用硬件平台提供了众多的优化空间。为了深入探讨这些优化技巧,本章节将从定制化优化、实时处理算法优化和智能监控自适应机制三个方面进行详细分析。

## 4.1 针对A190L系统的定制化优化

A190L作为一个典型的硬件平台,其独特的硬件特性为音视频通话优化提供了基础保障。因此,深入了解该平台的硬件特性,并在软件层面进行深度定制优化,对于提升通话质量至关重要。

### 4.1.1 A190L硬件特性分析

A190L可能拥有专为音视频处理优化的硬件加速器、专用的DSP(数字信号处理器)和GPU(图形处理单元)。这些硬件资源使得A190L在执行复杂的音视频编解码任务时能提高效率。例如,A190L可能包含专有的视频编码硬件加速器,可以显著降低CPU的负载,提高编码效率。

为了实现定制化优化,开发者需要对硬件资源进行详细的评估和测试,以了解每个组件在处理音视频数据时的性能瓶颈。这通常涉及以下步骤:

- **资源评估**:利用硬件性能监控工具,对A190L平台的CPU、内存、DSP和GPU进行压力测试。

- **瓶颈分析**:分析测试结果,找出处理音视频数据时的性能瓶颈。

- **优化设计**:根据瓶颈分析结果,设计定制化优化方案,比如在硬件加速器支持的范围内调整音视频编解码参数。

### 4.1.2 软件层面的深度定制优化

软件优化是提升A190L音视频通话质量不可或缺的部分。软件层面的优化不仅包括对现有编解码器的调优,还包括对操作系统资源调度的优化。

- **编解码器调优**:选择与A190L硬件兼容且优化良好的编解码器,例如可以考虑使用支持硬件加速的H.264或VP9编解码器。在软件层面上,可以通过调整编解码参数来优化性能,如设置合理的帧率、分辨率和比特率。

- **资源调度优化**:操作系统内核通常负责管理CPU和内存资源,但在音视频通话场景中,需要保证关键处理任务可以获得优先资源。例如,通过调整任务优先级,确保音频和视频数据处理任务的实时性。

### 4.1.3 代码示例与逻辑分析

假设我们使用A190L的专有硬件加速器来处理视频数据,下面是一个简化的代码示例:

```c

#include <accelerator.h>

VideoFrame* process_frame(VideoFrame* frame) {

// 利用硬件加速器进行视频帧处理

VideoFrame* processed_frame = hardware_accelerator_process(frame);

return processed_frame;

}

```

在这个简化的例子中,`hardware_accelerator_process`函数代表了使用A190L硬件加速器进行视频帧处理的操作。实际上,这个过程可能涉及多个步骤,包括图像格式转换、颜色空间转换、图像滤波和缩放等。开发者需要根据硬件加速器的API文档进行详细编程。

通过本节的介绍,我们了解了A190L音视频系统定制化优化的基础知识,并从硬件特性分析和软件层面优化两个角度对优化过程进行了深入探讨。

## 4.2 实时音视频处理的算法优化

实时音视频处理是音视频通话系统中的核心技术之一,A190L平台提供了强大的计算能力来实现这些算法。本小节重点讨论在A190L平台上,如何优化声音降噪与回声消除技术,以及视频图像增强与稳定算法。

### 4.2.1 声音降噪与回声消除技术

声音降噪和回声消除对于提升通话体验至关重要,尤其是在有背景噪音和回声的环境中。

- **降噪算法优化**:常见的降噪算法包括频谱减法、Wiener滤波等。在A190L平台上,可以通过并行处理和专用的DSP来加速这些算法的执行。优化降噪算法时,重点在于算法的实时性和效果的平衡。

- **回声消除技术**:回声消除通常依赖于自适应滤波器,比如经典的最小均方误差(LMS)算法。在A190L平台上,可以利用其硬件加速特性来提高自适应滤波器的计算效率,从而减小回声。

### 4.2.2 视频图像的增强与稳定算法

视频质量的提升可以通过图像增强和稳定算法来实现,这在移动和网络条件较差的环境中尤为重要。

- **图像增强算法**:包括图像锐化、亮度和对比度调整、去噪等技术,可以显著提升视频质量。A190L的DSP和GPU可以用来加速这些算法的执行。

- **视频稳定算法**:如光流法、帧间预测等算法可以用来实现视频稳定。这些算法在A190L平台上实现时需要考虑实时性和算法复杂度之间的平衡。

### 4.2.3 代码示例与逻辑分析

以图像锐化算法为例,下面是一个使用A190L平台的图像处理库进行视频帧锐化的代码示例:

```c

#include <image_processing.h>

VideoFrame* sharpen_frame(VideoFrame* frame) {

VideoFrame* sharpened = allocate_frame_like(frame);

for (int y = 0; y < frame->height; y++) {

for (int x = 0; x < frame->width; x++) {

sharpened->data[y][x] = sharpness_factor * frame->data[y][x]

- neighborhood_factor * (frame->data[y-1][x] + frame->data[y+1][x]

+ frame->data[y][x-1] + frame->data[y][x+1]);

}

}

return sharpened;

}

```

在上述代码中,`sharpness_factor`和`neighborhood_factor`是算法参数,需要根据实际情况进行调整。此代码仅展示了算法的核心部分,实际使用中还需要考虑图像的边界处理和内存分配等问题。

## 4.3 智能通话质量监控与自适应机制

为了进一步提升通话质量,A190L平台可以集成智能监控和自适应机制,以实时监测通话质量并根据监控结果动态调整通话参数。

### 4.3.1 实时监控通话质量的方法

- **使用性能指标监控**:可以通过监控CPU、内存、网络带宽等硬件资源的使用情况来评估通话质量。

- **主观体验监控**:通过收集用户反馈或使用特定算法分析音频和视频数据来评估用户的主观体验。

### 4.3.2 根据监控结果自动调节策略

- **动态调整带宽**:如果监控到网络带宽紧张,可动态降低音视频的比特率或分辨率来减少带宽占用。

- **智能音视频编码**:依据实时监控到的网络和硬件状态,动态选择最优的编解码器和编解码参数。

### 4.3.3 代码示例与逻辑分析

假设我们有一个监控系统,能够实时收集到网络延迟和丢包率等指标,下面是一个简化的代码示例:

```c

#include <monitoring.h>

void adjust_stream_settings(StreamSettings* settings, NetworkMetrics* metrics) {

if (metrics->loss_rate > 0.1) {

// 如果丢包率大于10%,降低比特率以减少丢包影响

settings->bitrate -= 100000;

}

if (metrics->latency > 200) {

// 如果延迟超过200ms,降低帧率以减少卡顿

settings->frame_rate -= 5;

}

}

```

该函数`adjust_stream_settings`根据监控到的网络状态调整流媒体的比特率和帧率设置。通过这种方式,通话过程可以根据实时条件自动调整,以维持尽可能好的通话质量。

通过本章节的介绍,我们深入理解了A190L音视频系统的高级优化技巧,包括硬件特性分析、软件层面的定制化优化、实时处理算法优化以及智能监控与自适应机制。这些优化技巧对于提高特定硬件平台上的音视频通话体验至关重要。

# 5. 案例研究与未来展望

## 5.1 成功案例分析

### 5.1.1 国内外音视频通话优化案例分享

在音视频通话领域,多家科技公司已经采取了有效的优化策略来提升通话质量,以下是几个有代表性的案例:

1. **Google Meet**: 为了应对疫情带来的远程办公潮,Google Meet通过引入WebRTC技术,优化了其网络架构,减少了30%的带宽需求,同时保持了高质量的通话体验。

2. **Zoom**: Zoom通过智能音视频优化技术,如自动降噪、背景模糊、带宽自适应等,使得用户即便在弱网环境下也能获得较好的通话体验。

3. **腾讯会议**: 采用了基于AI的动态码率调整和自适应丢包补偿机制,保证了在不同网络条件下,都能实现高清晰度的视频通话。

在这些案例中,我们可以看到,优化策略通常包括网络优化、编解码器的调整、以及智能算法的应用等多个方面。

### 5.1.2 优化成果的数据统计与分析

通过对这些优化案例的数据分析,我们可以得到以下关键指标:

- **会议时长和参与人数**: 对比优化前后的会议平均时长及参与人数,显示了优化后用户的留存度和满意度的提升。

- **网络适应性**: 对比优化前后在网络环境变化时通话质量的稳定性,体现优化的成效。

- **软硬件资源消耗**: 分析优化前后系统资源的占用情况,如CPU和内存的使用率,来评估优化对设备性能的影响。

例如,根据Zoom的公开报告,通过他们的优化措施,用户在会议中平均减少了13%的网络带宽消耗,并且在丢包率为10%的情况下,视频质量的主观评分提高了20%。

## 5.2 音视频通话技术的未来趋势

### 5.2.1 新兴技术在音视频通话中的应用

未来音视频通话技术的发展趋势将融合更多新兴技术,比如:

- **5G和Wi-Fi 6**: 更快的网络速度和更低的延迟将进一步改善通话体验。

- **AI优化算法**: AI算法可以实时优化音视频质量,如智能降噪、语音识别、自动字幕生成等。

- **边缘计算**: 将数据处理更靠近数据源,从而降低延迟和带宽需求。

### 5.2.2 行业发展趋势与市场预测

根据市场分析,音视频通话市场将呈现以下趋势:

- **企业级市场的增长**: 随着远程办公的普及,企业对音视频通话解决方案的需求将持续增长。

- **合规性与安全性**: 随着数据保护法规的强化,通信服务商需要提供更加安全和合规的通信服务。

- **云服务集成**: 云服务将与音视频通话技术更加紧密集成,为用户提供无缝的跨平台体验。

通过这些预测,我们可以预见到,音视频通话技术将在未来继续作为沟通方式的核心技术之一,不断地通过技术创新来满足用户日益增长的需求。

0

0