深入了解Guava Hashing:构建Java高效缓存系统的7大关键策略

发布时间: 2024-09-26 13:39:52 阅读量: 68 订阅数: 36

如何使用bloomfilter构建大型Java缓存系统Ja

# 1. Guava Hashing简介

Google的Guava库是Java开发人员工具箱中的一个强大工具,其中的Hashing类提供了高效和便捷的散列功能。散列在许多数据处理场景中都很重要,特别是在实现Java集合类型如HashMap和HashSet时。Guava Hashing模块通过提供一系列预定义的散列函数简化了开发者的任务,同时也允许自定义散列策略,这对于构建高效缓存系统尤为重要。

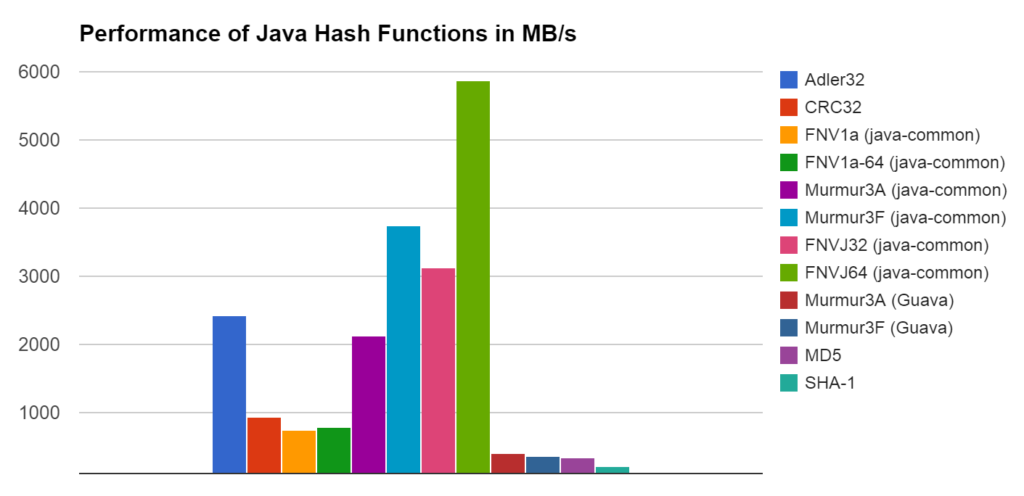

Guava Hashing的特色在于其易于使用的API和对不同散列函数的广泛支持,包括但不限于MD5、SHA-1和Adler32等。此外,它还提供了对CyclicBufferHashingStrategy的支持,这对于需要周期性处理的数据类型特别有用。总之,Guava Hashing不仅为Java应用提供了强大的散列能力,还为其构建高效缓存系统奠定了坚实的基础。接下来的章节将深入探讨散列的基础知识及其在Java中的应用,以及如何利用Guava Hashing优化Java缓存系统。

# 2. 理解散列及其在缓存中的作用

## 2.1 散列基础:从理论到实践

### 2.1.1 散列函数的工作原理

散列函数是一种将输入数据(称为“键”)转换为固定大小输出的过程,输出通常称为“散列值”或“哈希值”。它工作的基本原理如下:

1. **输入键的转换**:散列函数接受任意大小的数据作为输入,然后通过特定的算法将这些数据转换为固定大小的值。

2. **生成哈希值**:经过转换后,每个输入键都会映射到一个唯一的哈希值,这个值通常是一个整数。

3. **索引计算**:生成的哈希值随后用于确定输入键在散列结构中的位置,通常用于快速查找。例如,在Java中的HashMap里,哈希值被用来计算数组索引,以便快速定位键值对。

4. **冲突解决**:由于可能存在多个键映射到同一个哈希值的情况(称为冲突),散列函数通常需要配合冲突解决策略一起工作。

### 2.1.2 散列冲突解决方法

处理散列冲突的常见方法有以下几种:

1. **开放寻址法**:所有元素都存储在散列表中,当发生冲突时,按照某种规则探测下一个空槽位。

2. **链地址法**:将散列到同一个槽位的所有元素存储在一个链表中,该链表与槽位关联。

3. **双重散列**:使用另一个散列函数处理冲突键,直到找到空槽位。

4. **再散列**:当表满时,使用另一个散列函数来重新计算哈希值,并分配到新的槽位。

散列函数和冲突解决方法的效率直接影响着散列表的性能。在实际应用中,选择合适的散列策略对缓存系统的优化至关重要。

## 2.2 散列在Java中的应用

### 2.2.1 Java中的HashMap和HashSet

在Java中,HashMap和HashSet是散列应用的经典例子。

- **HashMap** 使用哈希表来存储键值对,每个键都有一个对应的值。当插入新的键值对时,HashMap会使用键的hashCode方法来计算哈希值,然后根据这个值将键值对存储在合适的位置。

- **HashSet** 实际上是一个通过HashMap实现的集合,它不允许有重复的元素。当你向HashSet添加元素时,它实际上是在内部的HashMap中添加键,而值则统一设为一个静态的虚拟对象。

### 2.2.2 散列性能对Java集合的影响

散列函数的质量和冲突解决策略直接影响Java集合类的性能:

- **查找效率**:好的散列函数可以减少冲突,提高查找效率。如果散列函数设计不佳或冲突过多,则查找效率会大大降低。

- **内存使用**:Java集合通过散列算法为存储的数据分配空间,合理设计的散列函数可以有效利用内存。

- **数据动态性**:在插入、删除操作时,散列函数需要能高效地处理这些变化,保证数据结构的一致性。

在Java中,hashCode和equals方法的设计对散列集合的性能至关重要,设计良好的hashCode方法可以帮助减少冲突,从而提升集合的操作性能。

# 3. 构建高效的Java缓存系统

## 3.1 缓存系统的基本原则

### 3.1.1 缓存的必要性与优势

在软件系统中,缓存是一种常见的技术手段,用于加速数据访问和减少系统负载。缓存通过存储频繁使用的数据副本来减少数据检索所需的时间,从而提高应用程序的响应速度和效率。随着数据访问频率的增加,缓存的必要性和优势也愈发明显。

使用缓存的好处包括但不限于:

- **提高性能**:缓存将数据加载到内存中,相较于数据库或其他存储介质,内存的读写速度要快得多,从而显著提升了数据检索速度。

- **减轻后端存储压力**:通过减少对数据库的直接访问,缓存能够有效降低后端存储系统的负载。

- **减少网络延迟**:在分布式系统中,缓存减少了服务之间的远程调用次数,从而降低了网络延迟对系统性能的影响。

- **保护数据安全性**:对敏感数据进行缓存,可以减少数据的直接访问,提高数据安全性。

### 3.1.2 缓存的失效策略

尽管缓存为系统带来了诸多优势,但也需要合理的缓存失效策略来确保数据的正确性和系统的稳定性。缓存失效策略决定了何时将缓存中的数据标记为过时,并将其清除或更新。

常见的缓存失效策略包括:

- **时间过期**:设置缓存项在特定时间后自动失效,适用于不经常变化的数据。

- **空间过期**:当缓存达到其最大容量时,根据一定的规则(如最近最少使用LRU)清除旧数据,为新数据腾出空间。

- **被动失效**:当基础数据源发生变化时(例如数据库更新),相关的缓存项需要被标记为失效。

- **主动更新**:在缓存项使用前,先检查其有效性,如果过期则重新加载数据。

## 3.2 利用Guava Hashing优化缓存键

### 3.2.1 哈希码的生成与计算

在Java中,对象的哈希码是存储在哈希表中的关键,如`HashMap`和`HashSet`。正确地生成哈希码对于提高缓存键的效率和性能至关重要。Guava库中的`Hashing`类提供了多种哈希函数的实现,可以帮助开发者高效地生成哈希码。

使用Guava `Hashing`类生成哈希码的基本步骤如下:

```***

***mon.hash.HashFunction;

***mon.hash.Hashing;

import java.nio.charset.StandardCharsets;

public class HashingExample {

public static void main(String[] args) {

String key = "cacheKey";

HashFunction hf = Hashing.md5(); // 使用MD5哈希函数

long hashcode = hf.newHasher()

.putString(key, StandardCharsets.UTF_8)

.hash()

.asLong();

System.out.println("Hash code: " + hashcode);

}

}

```

在这段代码中,我们首先导入了Guava库的`Hashing`类,选择了MD5哈希函数。然后我们创建了一个`Hasher`实例,使用`putString`方法添加了字符串数据,并最终调用`hash().asLong()`生成了一个64位的哈希码。为了提高性能,通常会选择较高效率的哈希函数如`murmur3_32`或`good_FAST_hash_128`。

### 3.2.2 自定义对象的哈希策略

在Java中,许多对象类如`String`和基本数据类型包装类已经重写了`hashCode()`方法,但对自定义对象,开发者需要自行实现合理的哈希策略以确保对象的哈希码具有一致性和高效性。

```***

***mon.hash.HashCode;

***mon.hash.Hashing;

import java.nio.charset.StandardCharsets;

public class CustomObjectHashingExample {

public static void main(String[] args) {

MyObject obj = new MyObject("value");

HashCode hashCode = Hashing.sha256()

.newHasher()

.putObject(obj, MyObject_HASHER)

.hash();

System.out.println("Custom Object Hash Code: " + hashCode);

}

}

class MyObject {

private String value;

MyObject(String value) {

this.value = value;

}

// Define a strategy for hashing MyObject instances

static final HasherProvider<MyObject> MyObject_HASHER =

new HasherProvider<MyObject>() {

@Override

public Hasher newHasher() {

return Hashing.sha256().newHasher();

}

@Override

public void put(MyObject obj, Hasher hasher) {

hasher.putString(obj.value, StandardCharsets.UTF_8);

}

@Override

public HashCode hashObject(MyObject obj) {

return MyObject_HASHER.putObject(obj, newHasher()).hash();

}

};

}

```

在上面的代码中,我们为自定义对象`MyObject`实现了一个自定义的哈希策略。通过实现`HasherProvider`接口,我们能够定义如何为`MyObject`实例生成哈希码。我们在`MyObject_HASHER`实例中使用了SHA-256哈希函数,将对象的状态转换为一个唯一的哈希码。

需要注意的是,当你使用自定义对象作为缓存键时,对象类需要实现`equals`和`hashCode`方法,以保证在比较对象时的一致性。这包括对象属性的递归比较,以确保相同的对象状态产生相同的哈希码。

# 4. Guava Cache的高级特性与应用

Guava Cache是Google Guava库中提供的一个内存缓存实现,它提供了丰富的API来简化缓存的实现。在构建高效缓存系统时,它提供了一系列的高级特性,包括自动的线程安全管理、缓存回收策略以及可选的缓存监听器等。本章将深入探讨Guava Cache的核心特性和如何在实际应用中使用这些特性。

## 4.1 Guava Cache的配置与使用

### 4.1.1 CacheBuilder的配置选项

Guava Cache的灵活性很大一部分来自于其`CacheBuilder`类,通过这个构建器,我们可以对缓存进行各种配置。下面是一些核心的配置选项,它们都可以在创建`LoadingCache`实例时使用。

```java

LoadingCache<Key, Graph> graphs = CacheBuilder.newBuilder()

.maximumSize(1000)

.expireAfterWrite(10, TimeUnit.MINUTES)

.removalListener(notification -> System.out.println(notification.getKey() + " was removed, cause: " + notification.getCause()))

.build(

new CacheLoader<Key, Graph>() {

public Graph load(Key key) throws AnyException {

return createExpensiveGraph(key);

}

}

);

```

- `maximumSize(1000)`:设置缓存的最大容量为1000个元素,超过这个限制后,缓存可能会根据不同的回收策略进行元素回收。

- `expireAfterWrite(10, TimeUnit.MINUTES)`:设置缓存项在写入缓存后存活10分钟后自动过期。

- `removalListener`:为缓存设置移除监听器,监听器会在缓存项被移除时触发,无论移除原因是什么。

### 4.1.2 缓存实例的创建和使用

一旦配置完成,我们可以创建一个`LoadingCache`实例,并使用它来缓存和检索数据。由于`LoadingCache`实现了`Cache`接口,它继承了各种与缓存相关的操作。

```java

// 尝试检索键对应的值,如果缓存中不存在,则会使用CacheLoader的load方法加载值

try {

Graph graph = graphs.get(key);

} catch (ExecutionException e) {

throw new UncheckedExecutionException(e.getCause());

}

// 使用refreshAfterWrite使得缓存项在一定时间后自动刷新

***s.refresh(key);

```

- `get(key)`方法会检索给定键对应的值,如果缓存中不存在对应的值,`CacheLoader`的`load`方法会被调用,缓存加载后的值。

- `refresh(key)`方法用于强制刷新缓存项,即使它还没有过期。

## 4.2 缓存策略的深度实践

### 4.2.1 移除监听器和缓存预加载

在Guava Cache中,我们可以为缓存配置移除监听器,以便对缓存项被移除的事件进行响应。这对于监控和管理缓存行为非常有用。

```java

graphs.asMap().forEach((key, value) -> System.out.println("Key: " + key + " Value: " + value));

graphs.cleanUp();

```

- `asMap()`方法将缓存映射为一个普通的`Map`,方便进行迭代和遍历操作。

- `cleanUp()`方法在主动清理缓存时调用,以移除任何空闲的或过期的缓存项。

### 4.2.2 缓存大小和数据回收机制

在处理有限容量的缓存时,我们需要对缓存项进行回收,以确保内存不被耗尽。Guava Cache提供了多种回收策略。

```java

graphs.invalidateAll();

graphs.cleanUp();

```

- `invalidateAll()`方法可以清除缓存中的所有键值对,对于需要在某些条件下重新加载所有数据的场景很有用。

- 在调用`invalidateAll()`后,`cleanUp()`方法通常被用来执行清除操作。

### 4.2.3 缓存与数据库交互的策略

在许多应用场景中,缓存不仅用来存放计算结果,还要和数据库进行交互。Guava Cache提供的`CacheLoader`使得这种交互变得简单。

```java

LoadingCache<String, User> users = CacheBuilder.newBuilder()

.maximumSize(100)

.build(new CacheLoader<String, User>() {

public User load(String key) throws Exception {

return findAndLoadFromDatabase(key);

}

});

```

- `load`方法中,可以直接与数据库交互,加载用户信息并返回。

### 4.2.4 数据失效策略

Guava Cache允许我们指定缓存项在各种不同条件下失效的策略,例如:

```java

graphs.expireAfterAccess(30, TimeUnit.MINUTES);

```

- `expireAfterAccess(30, TimeUnit.MINUTES)`方法设置了缓存项在最后一次被访问后存活30分钟,之后会被自动移除。

### 4.2.5 性能优化

在使用Guava Cache时,性能优化是一个重要考虑因素。缓存的配置和数据回收策略直接影响到缓存性能。

```java

graphs.recordStats();

```

- `recordStats()`方法开启性能统计,这对于分析缓存性能非常有帮助。

### 4.2.6 缓存预热

缓存预热是指在缓存系统启动后,预先加载常用的缓存数据到缓存实例中,以减少系统首次响应用户请求时的延迟。

```java

graphs.putAll(getInitialCacheData());

```

- `putAll`方法可以将一组键值对预加载到缓存中。

### 4.2.7 缓存的并发问题

由于Guava Cache是线程安全的,它使用了多种同步机制确保数据的一致性和安全性。开发者无需过多担心并发导致的数据不一致问题。

```java

graphs.asMap().put(key, newValue);

```

- 尽管`asMap()`方法提供了对缓存的访问,但直接修改`Map`的行为可能会绕过Guava Cache的同步机制。因此,在修改缓存项时需要小心。

通过以上策略和配置,我们可以构建一个既高效又灵活的缓存系统,同时确保它在高并发环境下仍能稳定运行。

# 5. 案例研究:构建高性能缓存系统

在前几章中,我们了解了Guava Hashing的基本概念、散列的作用、以及如何构建一个高效的Java缓存系统。本章,我们将深入探讨实际应用中如何构建高性能缓存系统,同时引入Guava Cache来解决高并发环境下的挑战,并展示其在真实项目中的应用。

## 5.1 实际应用场景分析

### 5.1.1 高并发环境下的缓存挑战

高并发环境下,缓存系统需要面对的主要挑战有数据一致性、缓存失效、缓存穿透以及缓存雪崩等问题。对于这些问题,我们需要制定相应的策略:

- **数据一致性问题**:使用消息队列等中间件保证数据的最终一致性。

- **缓存失效问题**:采用合适的缓存失效策略,如LRU(Least Recently Used),FIFO(First In First Out)等,确保常用数据始终在缓存中。

- **缓存穿透问题**:通过预先查询空值缓存、设置空值缓存时间来减少对数据库的直接请求。

- **缓存雪崩问题**:通过随机缓存时间或者使用不同缓存过期时间的策略来避免大量缓存同时失效。

### 5.1.2 缓存与数据库交互的策略

缓存与数据库的交互策略主要包括:

- **缓存写入策略**:可以采取写入时更新(write-through)或写入后更新(write-back)的策略。

- **缓存读取策略**:可以是读取时加载(read-through)或者缓存缺失后再加载(cache-aside)。

接下来,我们将通过一个项目案例来具体分析Guava Cache的应用。

## 5.2 Guava Cache在真实项目中的应用

### 5.2.1 项目案例展示

假设我们有一个社交媒体项目,用户信息频繁被访问,需要通过缓存来减少数据库访问的压力。在项目中,我们使用Guava Cache来缓存用户的个人信息。

首先,我们需要配置Guava Cache:

```java

LoadingCache<Long, User> userCache = CacheBuilder.newBuilder()

.maximumSize(10000)

.expireAfterAccess(30, TimeUnit.MINUTES)

.removalListener(notification -> System.out.println("Removed " + notification))

.build(new CacheLoader<Long, User>() {

@Override

public User load(Long userId) throws Exception {

return getUserFromDatabase(userId);

}

});

```

通过以上代码,我们配置了一个最大容量为10000的缓存,并设置用户信息在最后一次访问后30分钟过期。

接下来,我们展示如何通过缓存获取用户信息:

```java

try {

User user = userCache.get(userId);

// 处理用户信息...

} catch (ExecutionException e) {

// 处理异常

}

```

通过上述代码,我们成功地从缓存中获取了用户信息,如果缓存不存在,则会自动从数据库加载并缓存。

### 5.2.2 性能优化和问题解决

在使用Guava Cache时,我们可能会遇到数据一致性问题。例如,当用户信息在数据库中更新时,我们需要及时同步到缓存中。为了处理这种问题,我们可以在更新数据库后,手动使缓存失效:

```java

userCache.invalidate(userId);

```

另外,性能监控也是优化过程中的一个重要环节。我们可以通过日志或者监控工具跟踪缓存的命中率、加载失败次数等指标,以此来分析缓存的效果,并进行相应的调整。

本节,我们通过一个实际项目案例,展示了如何在真实环境中应用Guava Cache来构建高性能的缓存系统,并讨论了性能优化和问题解决的方法。在下一章中,我们将深入研究缓存系统的监控与维护,保证缓存系统的稳定和高效运行。

0

0