RNN与强化学习:构建智能对话系统的终极手册

发布时间: 2024-11-20 17:45:05 阅读量: 2 订阅数: 4

# 1. RNN与强化学习基础概念

## 1.1 RNN的基本原理与架构

RNN,全称Recurrent Neural Networks,中文名为循环神经网络,是一种用于处理序列数据的深度学习模型。与传统的全连接神经网络或卷积神经网络不同,RNN的核心在于其循环结构,允许信息在网络中循环流动。这种特性使得RNN能够处理变长的输入序列,并捕捉序列中的时间动态特征。

一个RNN单元在每个时间步接收当前的输入以及上一时间步的隐藏状态,通过内部的权重矩阵运算后,产生当前时间步的输出和新的隐藏状态。这使得每个时间步的输出都能够依赖于之前所有的输入,非常适合诸如语音识别、文本生成、智能对话系统等需要理解上下文的应用场景。

## 1.2 强化学习的核心概念

强化学习(Reinforcement Learning, RL)是机器学习的一个分支,涉及到如何通过试错来优化决策。在强化学习中,一个智能体(agent)通过与环境(environment)交互来学习如何执行特定任务,以获取最大的累积奖励。它的核心包括状态(state)、动作(action)、奖励(reward)三个要素。

强化学习中的策略(policy)是指智能体如何根据当前状态来选择动作,目的是最大化期望的长期奖励。而值函数(value function)则是用来评估状态或者动作的预期回报。强化学习通过探索(exploration)和利用(exploitation)的平衡来不断学习改善策略,从而在复杂环境和任务中获得优良表现。强化学习技术在智能对话系统中可用于优化对话策略,提高对话系统的智能性和用户体验。

# 2. 智能对话系统的理论基础

在第二章中,我们将深入探讨智能对话系统的理论基础。首先,我们会了解循环神经网络(RNN)的基本原理及其在对话系统中的应用。随后,我们会探讨强化学习的核心概念及其在智能对话系统中的作用。

## 2.1 RNN的基本原理与架构

### 2.1.1 RNN的工作机制

RNN是一类用于处理序列数据的神经网络。与传统的前馈神经网络不同,RNN能够处理不同长度的序列输入,这让它们在语言模型、语音识别和智能对话系统中具有独特的优势。在RNN中,信息流不是单向传播的,而是在神经元之间形成循环,从而可以保留之前的信息。

RNN在处理序列数据时会使用时间步的概念,每个时间步都会对当前输入和之前的状态进行处理,产生输出和更新状态。这种设计允许RNN在保持记忆的同时,逐个时间步处理序列。

```

# 示例:一个简单的RNN的伪代码

import torch

import torch.nn as nn

# 定义一个简单的RNN模型

class SimpleRNN(nn.Module):

def __init__(self, input_size, hidden_size):

super(SimpleRNN, self).__init__()

self.rnn = nn.RNN(input_size, hidden_size)

def forward(self, x):

# x: [seq_len, batch_size, input_size]

output, hidden = self.rnn(x)

return output, hidden

# 初始化模型和输入

model = SimpleRNN(input_size=10, hidden_size=20)

input_seq = torch.randn(5, 1, 10) # 假设序列长度为5,批量大小为1,输入维度为10

# 前向传播

output, hidden = model(input_seq)

```

### 2.1.2 RNN在对话系统中的应用

在智能对话系统中,RNN被广泛用于理解用户输入和生成自然回复。RNN能够学习到输入文本序列中的时间依赖性,从而可以更好地处理对话中的上下文关系。这使得RNN能够生成连贯、相关的回复。

为了使用RNN进行对话回复,通常需要一个编码器-解码器(Encoder-Decoder)架构,也称为Seq2Seq模型。在编码器中,RNN将用户的话语编码成一个固定长度的向量;在解码器中,RNN根据编码的向量生成回复。

## 2.2 强化学习的核心概念

### 2.2.1 强化学习的定义和类型

强化学习是机器学习的一个分支,它关注如何让智能体(agent)在环境中通过与环境的交互来学习策略。智能体通过执行动作并根据环境的反馈获得奖励来学习。这种反馈是其动作好坏的评价标准,帮助智能体调整其策略以获得更多的奖励。

强化学习主要有以下几种类型:

- 基于模型的方法:智能体利用模型来预测环境的未来状态。

- 无模型的方法:智能体不使用任何模型来预测环境,直接从经验中学习。

```

# 示例:一个简单的强化学习伪代码

import gymnasium as gym

# 创建环境

env = gym.make('CartPole-v1')

# 简单的智能体策略:随机选择动作

def agent(state):

return env.action_space.sample()

# 交互一个回合

state, info = env.reset()

for _ in range(1000):

action = agent(state)

state, reward, terminated, truncated, info = env.step(action)

if terminated or truncated:

break

env.close()

```

### 2.2.2 强化学习在对话系统中的作用

在对话系统中,强化学习可以用于优化回复策略,以期得到更正面的用户反馈。通过奖励系统的设计,可以引导智能体学习到何时给出何种类型的回复,以便维持对话流畅,提高用户满意度。

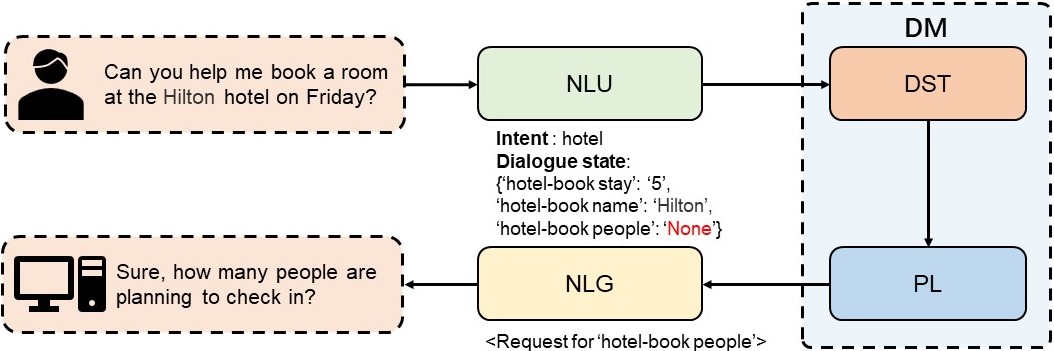

强化学习在智能对话系统中的关键应用之一是对话策略的学习。智能体通过与用户的互动,根据对话结果的好坏不断优化自身的回复策略,这可能包括如何引导对话,何时询问问题,以及如何根据上下文给出恰当的回复。

# 3. 构建智能对话系统的实践步骤

## 3.1 数据准备与预处理

### 3.1.1 数据收集和清洗

构建一个智能对话系统首先需要一个庞大的数据集,用于训练RNN模型和强化学习算法。数据收集的来源可以是多种多样的,如社交媒体、公开论坛、客服对话记录等。收集到的数据往往包含大量的噪声,如拼写错误、非标准语言用法、无关信息等,因此数据清洗是训练高质量模型的关键一步。

在数据清洗过程中,主要关注以下几点:

1. 去除重复项:相同或极为相似的对话记录会干扰模型的学习。

2. 噪声处理:包括纠正拼写错误、替换网络用语或口语化表达为标准形式等。

3. 过滤无用信息:例如对话中可能夹杂的无关链接、广告内容等。

4. 标准化:确保数据集的一致性,如日期、时间等信息的格式统一化。

这一过程可以使用Python等编程语言辅助完成,常见的库包括Pandas进行数据处理、NLTK进行文本清洗等。

```python

import pandas as pd

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

# 假设df是一个包含对话数据的DataFrame

# 过滤重复项

df.drop_duplicates(inplace=True)

# 定义清洗文本的函数

def clean_text(text):

# 分词

tokens = text.split()

# 去除停用词和词干化

lemmatizer = WordNetLemmatizer()

clean_tokens = [lemmatizer.lemmatize(token.lo

```

0

0