YOLOv5集群式训练自动化秘籍:简化训练流程,提升开发效率

发布时间: 2024-08-17 00:34:26 阅读量: 31 订阅数: 23

# 1. YOLOv5集群式训练概述**

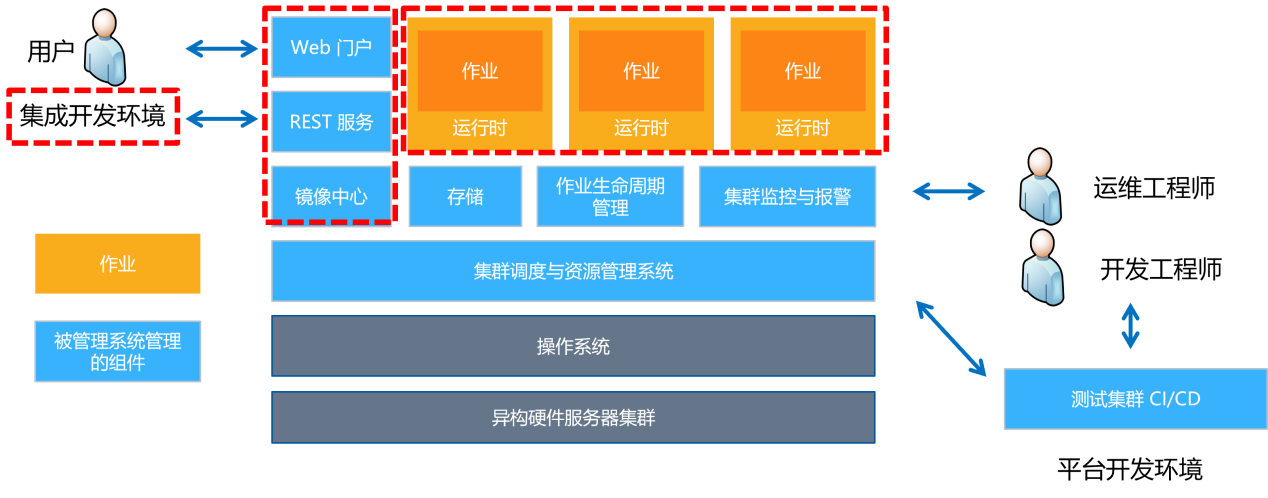

集群式训练是一种并行计算技术,它将训练任务分配到多个计算节点上,从而显著提高训练速度和效率。YOLOv5集群式训练架构采用数据并行策略,将训练数据分发到不同的计算节点,每个节点负责训练模型的不同部分。这种并行化方法可以充分利用集群资源,加快模型训练过程。

# 2. YOLOv5集群式训练理论基础

### 分布式训练原理

分布式训练是一种利用多个计算节点协同训练模型的技术,旨在解决大型数据集和复杂模型训练时遇到的计算和内存瓶颈。其核心原理在于将训练任务分解为多个子任务,并将其分配给不同的计算节点并行执行。

**数据并行**

数据并行是一种分布式训练策略,其中每个计算节点都持有数据集的副本。在训练过程中,每个节点负责训练数据集的不同子集。训练完成后,各个节点的模型参数进行汇总,得到最终的模型。

**模型并行**

模型并行是一种分布式训练策略,其中模型被分解为多个子模型,并分配给不同的计算节点。每个节点负责训练模型的不同部分,训练完成后,各个节点的子模型进行合并,得到最终的模型。

### YOLOv5集群式训练算法

YOLOv5集群式训练算法基于数据并行策略,利用Horovod通信库实现多节点训练。Horovod是一个高性能的分布式训练框架,支持多种并行通信模式,包括环形通信、全归约和广播。

YOLOv5集群式训练算法的流程如下:

1. **数据分发:**将训练数据集划分为多个子集,并将其分配给不同的计算节点。

2. **模型初始化:**每个计算节点初始化一个相同的模型副本。

3. **训练迭代:**每个计算节点在自己的数据集子集上训练模型,并通过Horovod通信库交换梯度和模型参数。

4. **模型更新:**每个计算节点根据接收到的梯度和模型参数更新自己的模型副本。

5. **模型同步:**训练完成后,各个计算节点的模型参数进行汇总,得到最终的模型。

**代码块:**

```python

import horovod.torch as hvd

# 初始化Horovod

hvd.init()

# 训练模型

for epoch in range(num_epochs):

for batch in range(num_batches):

# 计算损失函数

loss = ...

# 反向传播

loss.backward()

# 通过Horovod交换梯度

hvd.allreduce(loss.grad)

# 更新模型参数

optimizer.step()

```

0

0