MATLAB集成学习方法:工具箱中的强大工具,提升挖掘模型性能

发布时间: 2024-12-10 05:09:59 阅读量: 11 订阅数: 12

MATLAB 高光谱工具箱:包含各种高光谱开发算法的 Matlab 工具箱。-matlab开发

# 1. MATLAB集成学习方法概述

集成学习是机器学习中的一个重要分支,通过构建并结合多个学习器来完成预测任务。MATLAB作为一种强大的工程计算和算法开发平台,提供了一系列集成学习相关的工具和函数,使得从数据预处理到模型评估的整个工作流程变得更为高效。

集成学习的核心在于整合多个弱学习器以获得强学习器,从而提高模型的稳定性和准确性。在MATLAB中,这一过程不仅涵盖了传统的集成算法,如Bagging、Boosting和Stacking,还能够结合特定的问题,提供定制化的集成方案。

集成学习方法在各种应用领域中均有显著表现,尤其在处理高维数据、不平衡数据以及复杂预测任务时显示出其优越性。本文旨在为读者提供一个关于MATLAB集成学习方法的全面概述,并逐步深入介绍其背后的理论基础和实践应用。

# 2. 集成学习的理论基础

## 2.1 集成学习的定义和优势

### 2.1.1 集成学习的原理

集成学习(Ensemble Learning)是一种机器学习范式,它通过构建并结合多个学习器来完成学习任务。这种思想的出发点在于,通过组合多个模型来提升整体模型的泛化能力,即对未知数据的预测能力。基本原理可以概括为以下几个方面:

1. **个体差异**:集成中的每个模型被称为基学习器,它们是独立训练的,且它们之间的差异性越大越好。这些差异性通常来源于训练集的子集(Bagging)或者模型的权重(Boosting)等。

2. **投票机制**:当处理分类任务时,通常采用多数投票的方式来决定最终的预测结果。如果每个模型对每个样本都有一个预测输出,最终的输出是获得多数模型支持的类别。

3. **平均机制**:在回归任务中,通常采用平均预测值的方式。每个模型对目标变量做出预测,然后将所有模型的预测值进行平均,得到最终预测。

集成学习的核心思想是将弱学习器(weak learners)通过某种策略组合起来,以获得比单个学习器更好的性能。弱学习器指的是性能略优于随机猜测的学习器,而强学习器(strong learners)则是性能显著优于随机猜测的学习器。

### 2.1.2 提升模型性能的理论基础

提升模型性能的理论基础可以从以下几个方面加以理解:

- **过拟合减少**:多个模型比单个模型更容易避免过拟合。因为即使某些模型在训练数据上过拟合,其他模型可能不会,当这些模型组合在一起时,过拟合的影响往往会被平滑掉。

- **误差降低**:根据大数定律,多个模型的平均误差会趋向于期望误差(在某些条件下)。这意味着,只要基学习器的误差不是完全相关,集成学习的误差就有可能比单个学习器的误差低。

- **方差和偏差权衡**:集成学习通过对多个模型的预测进行集成,可以在不显著增加模型复杂度的前提下,有效地降低模型的方差。但是,集成学习并不总是能降低偏差,特别是当基学习器已经很强大时,集成可能无法显著提高模型性能。

## 2.2 集成学习的主要方法

### 2.2.1 Bagging方法

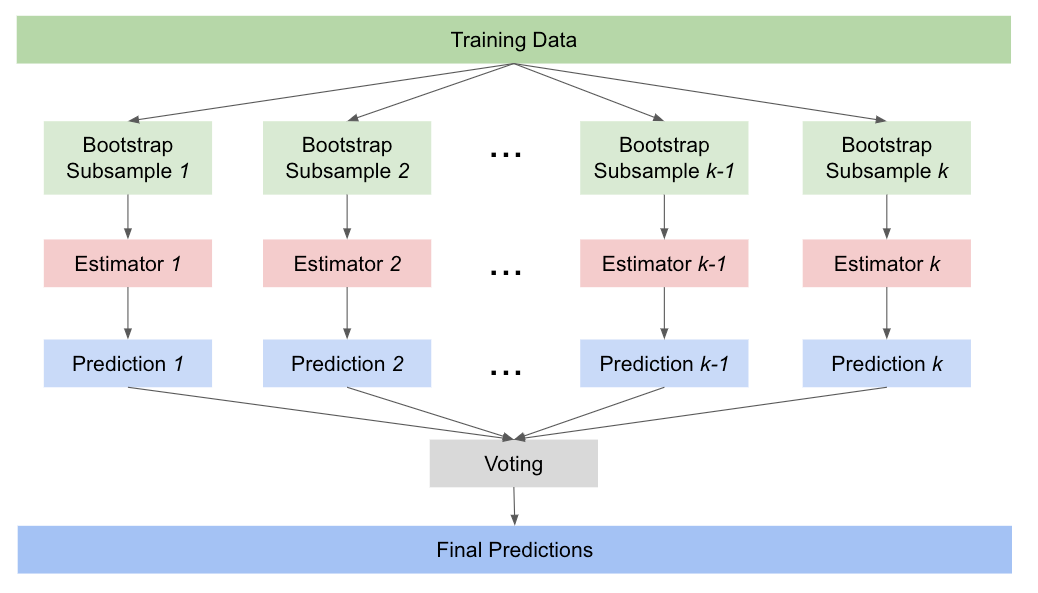

Bagging(Bootstrap Aggregating)是一种通过自助采样(bootstrap sampling)产生多个训练集,每个训练集训练一个基学习器,然后对所有基学习器的预测结果进行平均或投票来得到最终结果的方法。典型的Bagging方法有随机森林(Random Forest)。

Bagging的关键在于自助采样。对于一个有N个样本的原始训练集,每次随机有放回地抽取N个样本,形成新的训练集。因为是有放回的抽取,所以新训练集中某些样本可能会被重复选取,而某些样本可能一次都不会被选中。

以下是使用随机森林算法的一个简单示例代码:

```python

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 生成模拟数据

X, y = make_classification(n_samples=1000, n_features=20, n_informative=15, n_redundant=5, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 构建随机森林分类器

rf_clf = RandomForestClassifier(n_estimators=100, random_state=42)

# 训练模型

rf_clf.fit(X_train, y_train)

# 进行预测

predictions = rf_clf.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, predictions)

print(f"Model Accuracy: {accuracy}")

```

在上述代码中,我们使用了`RandomForestClassifier`来实现一个分类器,并在模拟数据集上训练和测试它。模型的准确度使用`accuracy_score`函数来衡量。

### 2.2.2 Boosting方法

Boosting方法是一种迭代算法,它顺序地训练一系列基学习器,每一个学习器都试图纠正前一个学习器的错误。Boosting算法的关键在于赋予每个训练样本一个权重,并且在每一轮迭代中,根据前面模型的性能调整样本的权重。典型的Boosting方法有AdaBoost和Gradient Boosting。

在AdaBoost中,模型会重点关注那些被前一个模型错误分类的样本。在Gradient Boosting中,模型会尝试减小前一个模型预测的残差。Boosting方法通过逐步改善的策略,最终得到一个强学习器。

以下是使用AdaBoost算法的一个简单示例代码:

```python

from sklearn.ensemble import AdaBoostClassifier

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 生成模拟数据

X, y = make_classification(n_samples=1000, n_features=20, n_informative=15, n_redundant=5, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 构建AdaBoost分类器

ada_clf = AdaBoostClassifier(n_estimators=50, random_state=42)

# 训练模型

ada_clf.fit(X_train, y_train)

# 进行预测

predictions = ada_clf.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, predictions)

print(f"Model Accuracy: {accuracy}")

```

在上述代码中,我们使用了`AdaBoostClassifier`来实现一个分类器,并在模拟数据集上训练和测试它。模型的准确度使用`accuracy_score`函数来衡量。

### 2.2.3 Stacking方法

Stacking(Stacked Generalization)是一种将不同类型的模型结合的方法。在Stacking中,第一层是多个基学习器,它们的预测结果作为输入传递给第二层的元学习器(meta-learner),最终的输出由元学习器给出。

Stacking的关键在于元学习器的选择,因

0

0