企业级视频监控方案:iOS与FFmpeg的完美融合

发布时间: 2024-12-16 04:01:48 阅读量: 7 订阅数: 6

iOS rtsp ffmpeg 视频监控 直播

参考资源链接:[iOS平台视频监控软件设计与实现——基于rtsp ffmpeg](https://wenku.csdn.net/doc/4tm4tt24ck?spm=1055.2635.3001.10343)

# 1. 视频监控方案概述

在这一章节中,我们将对视频监控方案进行一个整体的概览,以搭建读者对于后续内容的背景知识框架。首先,视频监控不仅仅是技术的堆砌,更是安防体系中的关键环节,其在企业和公共场所的应用越来越广泛。然后我们会简述视频监控方案的基本组成部分,例如摄像头硬件、传输网络、中央处理单元和存储解决方案等。最后,我们会讨论当前视频监控所面临的挑战和机遇,以及如何通过技术创新来提高监控系统的效率和可靠性。

## 1.1 视频监控技术的重要性

视频监控技术的重要性不仅仅体现在它的直接应用,如安全防护和行为分析上,还体现在它如何帮助组织进行有效的资源管理和决策支持。例如,在零售行业,视频监控能够帮助商家了解顾客流量和购买行为,优化销售策略。

## 1.2 视频监控方案的组成要素

一个典型的视频监控方案包括多个组件:视频捕获装置(如IP摄像头)、传输介质(有线或无线网络)、中央处理设备(视频管理服务器)、以及存储设备(本地存储或云服务)。这些组件相互协作,共同确保视频数据的捕获、处理、传输和存储。

## 1.3 监控技术面临的挑战和机遇

随着视频分辨率的提高和数据量的激增,传统监控系统遇到了存储和分析方面的瓶颈。此外,隐私保护法的普及也对监控系统提出了更高要求。然而,云计算、人工智能和大数据技术的兴起,为提升视频监控系统的效率和智能化水平提供了新的机遇。

# 2. iOS平台视频流处理基础

## 2.1 iOS视频采集技术

### 2.1.1 相机捕获框架AVFoundation介绍

iOS开发者在处理视频采集时,经常会使用到AVFoundation这个框架。AVFoundation提供了丰富的API,可以实现音频和视频的捕获、播放、编辑以及编码等功能。该框架采用现代的Objective-C编程接口,旨在为开发者提供简洁直观的接口和高效的性能。

AVFoundation的核心类是AVCaptureSession。它类似于一个指挥中心,负责管理所有的音频和视频输入输出。开发者可以将AVCaptureDevice(输入设备,如摄像头和麦克风)、AVCaptureInput(输入流)和AVCaptureOutput(输出流)添加到一个AVCaptureSession实例中,并设置相应的参数,如分辨率、帧率等。这样,就可以从摄像头捕获到视频流,并且显示或者处理这些视频流。

### 2.1.2 实时视频流获取与展示

获取实时视频流并将其展示在屏幕上,是视频监控应用中的一个基础功能。首先需要创建一个AVCaptureSession实例,并添加一个AVCaptureVideoPreviewLayer,用于实时显示视频流。

```objective-c

AVCaptureSession *session = [[AVCaptureSession alloc] init];

AVCaptureDevice *device = [AVCaptureDevice defaultDeviceWithMediaType:AVMediaTypeVideo];

AVCaptureDeviceInput *input = [AVCaptureDeviceInput deviceInputWithDevice:device error:nil];

[session addInput:input];

AVCaptureVideoPreviewLayer *previewLayer = [AVCaptureVideoPreviewLayer layerWithSession:session];

previewLayer.frame = self.previewView.bounds;

[self.previewView.layer addSublayer:previewLayer];

[session startRunning];

```

在上述代码中,`AVCaptureSession` 被初始化后,我们获取默认的摄像头设备,并通过 `AVCaptureDeviceInput` 将其加入到会话中。接着,创建了一个 `AVCaptureVideoPreviewLayer` 实例,并将其设置到预览视图上。最后,调用 `startRunning` 方法开始捕获视频流。

展示实时视频流的同时,我们也可以将视频流进行编码,进一步实现传输和存储。在iOS中,通常会使用 `AVCaptureVideoDataOutput` 来处理视频数据,并通过 `AVCaptureFileOutputRecordingDelegate` 协议来保存录制的视频。

## 2.2 iOS音视频编解码原理

### 2.2.1 音视频数据格式和编解码器选择

在iOS平台上,音视频数据格式和编解码器的选择对于视频流的质量和性能有着重要的影响。音视频数据可以通过不同的格式进行存储,常见的有:H.264、AAC等。而编解码器(Codec)则是实现编码(压缩)和解码(解压)的工具,其选择通常基于兼容性和性能要求。

在iOS系统中,H.264是广泛使用的视频编解码格式,它的兼容性好,压缩效率高,同时支持硬件加速,能够有效降低CPU的负担。对于音频,AAC是当前主流的编解码格式,它能够提供较高的音质,并且在相同的音质条件下,相对于MP3格式,占用更小的存储空间。

### 2.2.2 音视频同步处理技术

音视频同步是视频处理中的一个重要环节,特别是在视频监控领域,音视频的同步直接关系到用户体验和信息的准确性。在iOS平台上实现音视频同步,通常涉及到时间戳的匹配和处理。

为了实现音视频同步,开发者需要使用AVFoundation框架中的 `AVCaptureAudioDataOutput` 和 `AVCaptureVideoDataOutput` 类。通过监听数据输出对象的代理方法,我们可以获得音频和视频的样本。由于iOS设备上的音频和视频处理是异步进行的,因此需要为捕获到的音频和视频样本匹配合适的时间戳,确保播放时的同步性。

```objective-c

- (void)captureOutput:(AVCaptureOutput *)output didOutputSampleBuffer:(CMSampleBufferRef)sampleBuffer fromConnection:(AVCaptureConnection *)connection {

if (connection.isVideo) {

// 处理视频样本

// ...

} else if (connection.isAudio) {

// 处理音频样本

// ...

}

}

```

在这个代理方法中,我们通过 `AVCaptureConnection` 的 `isVideo` 和 `isAudio` 属性判断当前处理的是音频样本还是视频样本。然后,通过时间戳同步管理音频和视频数据。

## 2.3 iOS网络传输技术

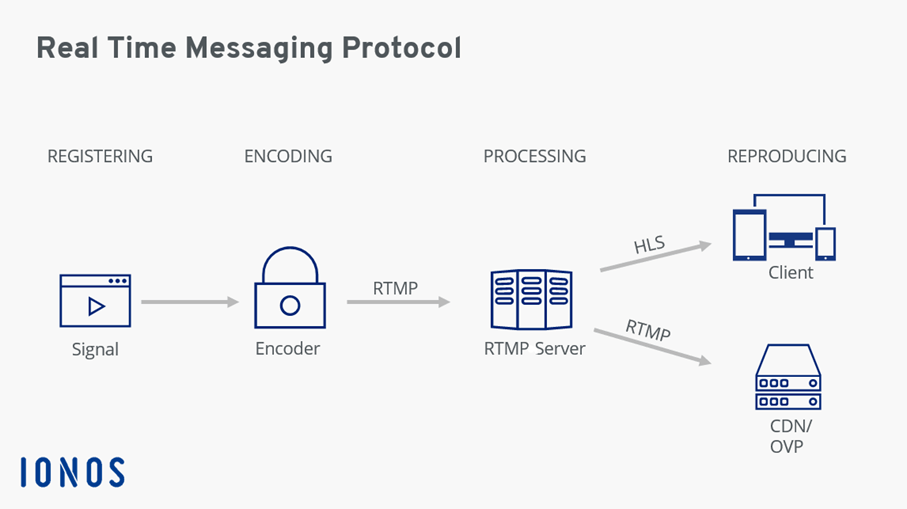

### 2.3.1 RTSP/RTP协议解析

在网络视频监控中,实时流传输协议(Real-Time Streaming Protocol,RTSP)和实时传输协议(Real-Time Transport Protocol,RTP)是两个核心的网络协议。RTSP被设计用于控制媒体流的传输,而RTP则用于媒体数据的传输。

RTSP运行在TCP或UDP上,可以完成如播放、暂停、快进和倒退等媒体控制命令。RTP协议则负责在UDP上实际传输媒体流数据,它通常与RTCP(实时控制协议)一起使用来提供流量控制和拥塞控制功能。

在iOS中,可以使用AVFoundation框架提供的RTSP客户端API来实现RTSP协议相关的功能,但是需要注意,由于安全等因素,某些功能可能会受到限制,特别是在iOS新版本中。

### 2.3.2 基于HTTP的流媒体传输技术

随着互联网的发展和视频监控需求的提升,基于HTTP的流媒体传输技术变得日益流行,尤其是HLS(HTTP Live Streaming)技术。HLS允许通过HTTP协议将媒体内容分段传输给客户端,并在客户端进行顺序播放,适用于各种网络带宽环境,能够提供较好的自适应播放能力。

在iOS平台上,开发者可以利用AVFoundation框架中的AVPlayer和AVPlayerLayer来实现HLS流媒体的播放。开发者只需要设置流媒体的URL到AVPlayer对象,然后将AVPlayerLayer添加到视图层次结构中,即可完成流媒体的播放。

```swift

let player = AVPlayer(url: URL(string: "http://example.com/stream.m3u8")!)

let playerLayer = AVPlayerLayer(player: player)

playerLayer.frame = self.view.bounds

self.view.layer.addSublayer(playerLayer)

player.play()

```

上述代码展示了如何在Swift中使用AVPlayer和AVPlayerLayer类来播放一个HLS视频流。当视频流的URL设置到AVPlaye

0

0