【数据处理高手】:掌握这7种特征提取与降维技巧,优化你的数据预处理流程

发布时间: 2024-11-22 21:14:27 阅读量: 21 订阅数: 29

pca.zip_PCA数据处理_PCA数据降维_PCA特征提取_pca提取特征_降维

# 1. 数据处理的基本概念和重要性

数据处理是数据分析的基石,涉及对原始数据的收集、清洗、转换和建模等一系列操作,目的是揭示数据中隐藏的有价值的信息和规律。理解数据处理的基本概念至关重要,它为后续的数据分析和模型构建奠定基础。

首先,数据处理包括数据清洗,例如去除重复值、填补缺失值、异常值处理等,确保数据质量。其次,数据转换,比如规范化、归一化等方法,将数据转换成适合分析的格式。在这些处理过程中,特征提取尤为关键,它涉及到从原始数据中抽取有意义的属性,这些属性可以是直接观测得到的,也可以是通过计算、变换得到的。

数据处理的重要性体现在多个层面。它直接影响数据的可用性和准确性,从而影响数据分析的可靠性和有效性。正确的数据处理可以显著提升数据模型的性能,对于预测分析、决策支持和策略制定具有重要意义。

在后续章节中,我们将详细探讨数据预处理中的特征提取技巧,深入挖掘降维技术的原理与应用,以及在实际应用中遇到的挑战与优化。这将为我们提供一个全面理解数据处理在数据科学中角色和价值的框架。

# 2. 数据预处理中的特征提取技巧

## 2.1 特征选择方法

### 2.1.1 过滤法(Filter Methods)

过滤法依赖于数据的统计测试来选择特征,它的优点在于简单快捷,对数据规模的适应性强。常见的方法有卡方检验、互信息、方差分析等。以卡方检验为例,它用于分类变量之间关系的强度测试。

#### 卡方检验(Chi-Square Test)

卡方检验在特征选择中的应用主要通过计算特征和目标变量之间的独立性来筛选特征。以下是一个简单的Python代码示例,使用`scikit-learn`库来执行卡方检验:

```python

from sklearn.feature_selection import SelectKBest, chi2

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

# 加载数据

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 使用卡方检验选择前两个最好的特征

select = SelectKBest(score_func=chi2, k=2)

X_train_new = select.fit_transform(X_train, y_train)

X_test_new = select.transform(X_test)

# 输出被选择的特征的索引

selected_features = select.get_support(indices=True)

print("被选择的特征的索引:", selected_features)

```

在此代码中,`SelectKBest`类用于选择特征,`chi2`函数用于计算特征与目标变量之间的卡方分数。`k=2`表示我们选择两个最好的特征。

### 2.1.2 包裹法(Wrapper Methods)

包裹法根据机器学习算法的性能来选择特征。这种方法往往更准确,但计算成本高,因为需要多次训练模型。包裹法中最常用的算法是递归特征消除(Recursive Feature Elimination, RFE)。

#### 递归特征消除(RFE)

RFE通过递归地构建模型,并在每次迭代中选择对模型性能影响最大的特征。以下是一个使用RFE的示例:

```python

from sklearn.feature_selection import RFE

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

import numpy as np

# 加载数据

iris = load_iris()

X, y = iris.data, iris.target

# 创建随机森林分类器

clf = RandomForestClassifier()

# RFE模型选择

rfe = RFE(estimator=clf, n_features_to_select=2)

fit = rfe.fit(X, y)

# 输出被选择的特征的索引

selected_features = np.where(fit.support_)[0]

print("被选择的特征的索引:", selected_features)

```

在此代码中,`RandomForestClassifier`作为基分类器,`RFE`用于选择特征。最终,通过`fit.support_`属性来确定哪些特征被选中。

### 2.1.3 嵌入法(Embedded Methods)

嵌入法结合了过滤法和包裹法的优点,在模型训练过程中进行特征选择。最著名的嵌入法是基于惩罚项的特征选择,如岭回归(L1正则化)。

#### 基于惩罚项的特征选择

L1正则化可以通过将一些特征的权重压缩至零来实现特征选择。以下是一个使用线性回归模型的L1正则化作为特征选择的示例:

```python

from sklearn.linear_model import LassoCV

from sklearn.datasets import load_diabetes

import pandas as pd

# 加载数据

diabetes = load_diabetes()

X, y = diabetes.data, diabetes.target

# 使用L1正则化的线性回归进行特征选择

lasso = LassoCV(cv=5, random_state=0).fit(X, y)

# 输出被选择的特征的索引

selected_features = np.where(lasso.coef_ != 0)[0]

print("被选择的特征的索引:", selected_features)

```

在此代码中,`LassoCV`用于通过交叉验证来选择L1正则化参数,并执行特征选择。

## 2.2 特征构造技术

### 2.2.1 基于统计的方法

基于统计的方法包括统计测试和相关性分析等。这里我们可以使用`scipy`库中的`pearson`相关系数来分析特征间的相关性。

```python

from scipy.stats import pearsonr

import pandas as pd

import numpy as np

# 示例数据集

data = np.random.randn(100, 4)

features = pd.DataFrame(data, columns=["A", "B", "C", "D"])

# 计算特征间的相关性

correlations = features.corr(method='pearson')

# 以矩阵形式展示相关性

print(correlations)

```

### 2.2.2 基于模型的方法

基于模型的特征构造可以通过训练一个机器学习模型并使用其输出作为新的特征。这里以决策树为例,展示如何使用决策树模型生成新特征:

```python

from sklearn.tree import DecisionTreeRegressor

from sklearn.datasets import make_regression

# 创建回归数据集

X, y = make_regression(n_samples=100, n_features=5, noise=0.1, random_state=42)

# 训练决策树模型

model = DecisionTreeRegressor(max_depth=3)

model.fit(X, y)

# 使用模型生成新的特征

new_features = model.predict(X)

print("决策树模型生成的新特征:", new_features)

```

### 2.2.3 基于变换的方法

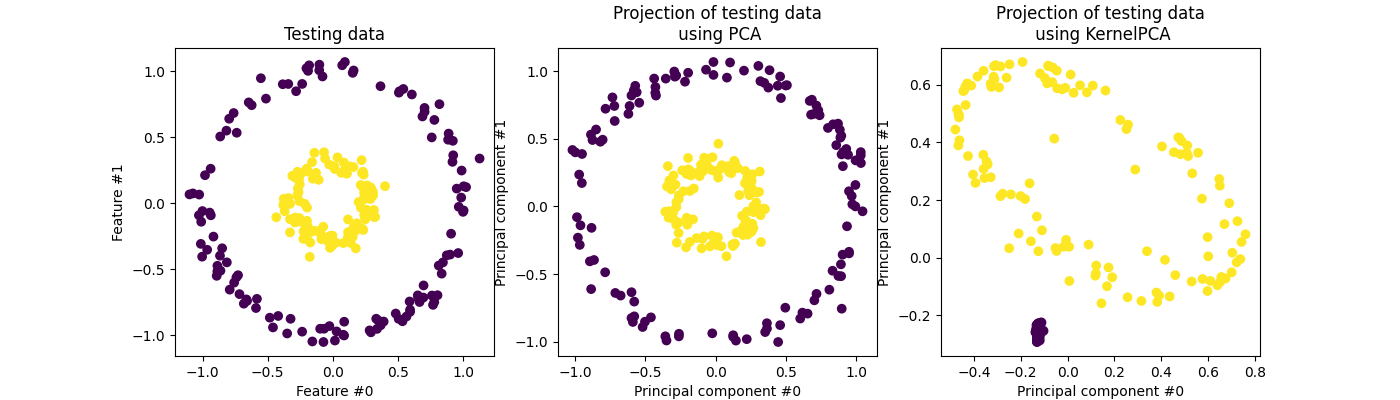

基于变换的方法涉及特征空间的变换,例如主成分分析(PCA)。以下是使用PCA进行特征降维的Python代码示例:

```python

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris

import matplotlib.pyplot as plt

# 加载数据

iris = load_iris()

X = iris.data

y = iris.target

# 初始化PCA并指定主成分数为2

pca = PCA(n_components=2)

X_r = pca.fit_transform(X)

# 绘制散点图

plt.figure()

plt.scatter(X_r[:, 0], X_r[:, 1], c=y, edgecolor='none', alpha=0.7, cmap=plt.cm.get_cmap('tab10', 3))

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.colorbar()

plt.show()

```

在上述代码中,我们使用PCA将数据降维至2个主成分,然后绘制散点图以观察数据在新的特征空间中的分布情况。

## 2.3 特征提取的实践案例

### 2.3.1 实际数据集的特征提取过程

下面是一个实践案例,我们将使用Kaggle上的一个具体数据集,例如"Titanic"数据集,并说明特征提取的详细步骤。首先,需要加载数据集:

```python

import pandas as pd

from sklearn.preprocessing import LabelEncoder, StandardScaler

# 加载数据

train = pd.read_csv('train.csv')

test = pd.rea

```

0

0