负载测试实战:Linux网络服务性能评估与优化

发布时间: 2024-12-10 07:09:04 阅读量: 6 订阅数: 2

linux性能调优.pdf

# 1. 负载测试基础与Linux网络服务概述

## 1.1 负载测试的定义和重要性

负载测试是一种通过模拟实际使用场景下用户的访问压力,来评估软件系统在高负荷下的表现和性能的测试方法。对于Linux网络服务而言,负载测试尤为重要,因为它可以帮助我们了解网络服务在高并发、高数据流量环境下的稳定性和可靠性。

## 1.2 Linux网络服务的基本概念

Linux网络服务是指在Linux操作系统上运行的各种网络服务,包括但不限于Web服务、文件传输服务、邮件服务、数据库服务等。这些服务是现代互联网架构中不可或缺的一部分,它们的性能直接影响到整个系统的运行效率。

## 1.3 负载测试与Linux网络服务的关系

负载测试与Linux网络服务有着密切的关系。通过负载测试,我们可以评估网络服务在实际使用中的性能表现,找出性能瓶颈,从而进行针对性的优化,提高服务的稳定性和用户体验。

# 2. Linux网络服务性能评估

### 2.1 性能评估的关键指标

#### 2.1.1 吞吐量和响应时间

在衡量Linux网络服务性能时,吞吐量和响应时间是两个非常重要的指标。吞吐量通常指单位时间内处理的请求数量,它直接反映了服务的处理能力。而响应时间则指从发出请求到收到响应的时间长度,它决定了用户体验的好坏。

要提高网络服务的吞吐量,需要确保服务器的CPU和网络接口没有成为瓶颈。同时,减少单个请求处理时间,通过优化代码减少不必要的计算,或者使用更高效的数据存储和检索机制。

响应时间的优化则涉及到多个方面,比如网络延迟、服务器处理请求的速度、I/O操作延迟等。具体到网络服务,可以优化代码逻辑以减少处理时间,或者调整线程池大小来提升并发能力。

### 2.1.2 并发连接数和错误率

并发连接数是指网络服务能够同时处理的连接数,是衡量服务并发处理能力的关键指标。错误率则是指在一定时间内发生错误请求的比例,它反映了服务的稳定性和可靠性。

为了提高网络服务的并发连接数,通常需要优化服务器的网络参数,或者使用负载均衡器分散请求。错误率的降低通常需要系统地诊断和修复已知的错误,比如改进应用逻辑、增强系统容错能力等。

### 2.2 性能评估的工具选择

#### 2.2.1 常用的性能评估工具介绍

在Linux环境下,性能评估工具非常丰富,其中包括 `ab`、`wrk`、`httping` 等命令行工具。Apache的 `ab` 是一个简单的HTTP性能测试工具,它可以用来测试网站的最大吞吐量。`wrk` 是一个更为现代的HTTP基准测试工具,它支持多线程,可以更准确地模拟高并发场景。`httping` 类似于 `ping`,但是用于测量HTTP请求的响应时间。

在选择工具时,应考虑测试的准确性、支持的协议、操作的便捷性以及是否能够模拟真实用户行为等因素。

### 2.2.2 工具的使用方法和案例分析

以 `wrk` 为例,该工具使用起来相对简单,但功能强大。下面是一个使用 `wrk` 进行性能测试的示例:

```bash

wrk -t12 -c400 -d30s --latency http://yourserver.com/

```

解释参数:

- `-t12`:使用12个线程模拟并发

- `-c400`:同时建立400个并发连接

- `-d30s`:测试持续时间30秒

- `--latency`:同时记录响应时间的统计信息

在运行测试后,`wrk` 会输出测试结果,包括总的请求数、每秒完成的请求数、平均响应时间、最小响应时间、最大响应时间和总体耗时等关键信息。

### 2.3 性能数据的收集与分析

#### 2.3.1 数据收集的技术和实践

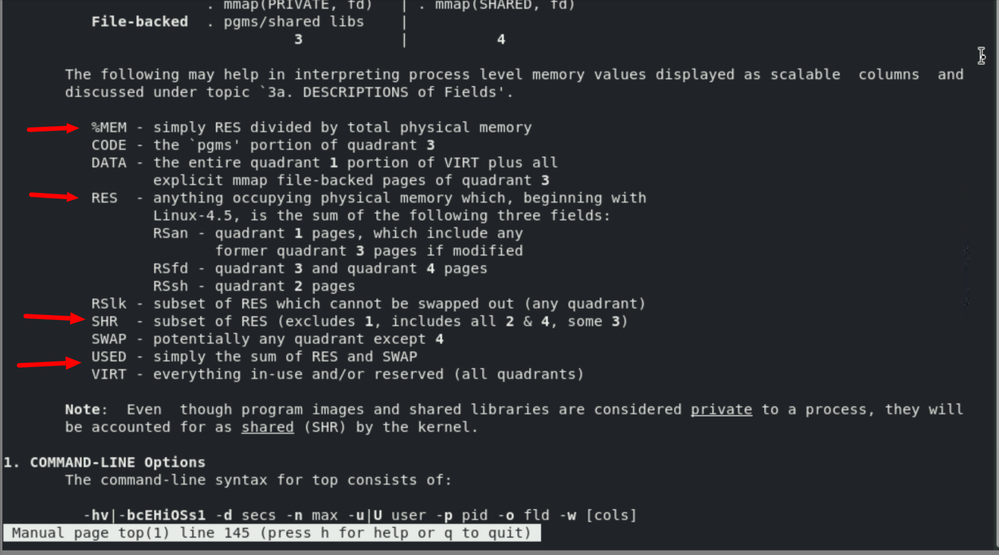

性能数据收集可以使用系统自带的工具,如 `vmstat`、`iostat`、`top`、`htop` 等。这些工具能够提供CPU、内存、I/O和进程等多维度的实时数据。此外,也可以使用专门的性能监控系统,如 `Nagios`、`Zabbix` 等。

数据收集的实践包括确定收集频率、选择合适的工具、确保数据的准确性和完整性。特别是在高负载环境下,数据收集可能会对系统性能产生影响,因此需要优化数据收集策略,避免过度占用系统资源。

#### 2.3.2 性能瓶颈的识别和分析

性能瓶颈的识别通常基于分析收集到的数据。如果系统CPU利用率很高,但响应时间仍然很长,可能是因为I/O瓶颈或内存不足。相反,如果CPU利用率不高,而响应时间仍然不理想,可能是应用层面的逻辑问题。

使用 `vmstat` 查看CPU和I/O的统计信息可能揭示问题所在:

```bash

vmstat 1

```

输出的信息包括:每秒的CPU利用率(us, sy)、系统运行队列长度(r)、以及磁盘I/O等待(wa)等,这些都可以帮助识别瓶颈。

### 性能评估案例

让我们通过一个具体案例来演示性能评估的全过程。假定我们有一个运行在Linux上的Web服务,我们希望评估其在高负载下的性能表现。

1. 首先使用 `ab` 测试工具进行简单的吞吐量测试。

2. 然后使用 `wrk` 进行并发测试,并观察 `wrk` 输出的结果。

3. 接着利用 `vmstat` 和 `iostat` 等工具来收集系统的实时性能数据。

4. 最后分析这些数据,确定是否存在性能瓶颈,并根据瓶颈采取相应的优化措施。

通过上述步骤,我们可以获得网络服务的全面性能评估,并为后续的性能优化提供数据支撑。

# 3. Linux网络服务负载测试实战

## 3.1 负载测试的理论基础

### 3.1.1 负载测试模型和类型

负载测试是一种性能测试,旨在确定系统在预期的工作负载下是否能正常运行。在Linux网络服务中,负载测试的模型和类型通常包括以下几种:

- **恒定负载测试**:在测试过程中,负载保持恒定,以评估系统在特定负载水平下的性能。

- **逐步增加负载测试**:负载逐渐增加,观察系统性能的变化以及在何时出现性能瓶颈。

- **负载压力测试**:通过超过系统预期工作负载的方式来测试,以确定系统能承受的最大负载和恢复能力。

### 3.1.2 负载测试的策略和步骤

负载测试策略的制定对于成功进行测试至关重要。一般来说,负载测试的步骤包括:

- **需求分析**:确定测试目标,包括需要测试的性能指标,如响应时间、吞吐量等。

- **测试环境的搭建**:构建与生产环境相似的测试环境。

- **测试工具的选择**:选择合适的工具来生成负载。

- **测试执行**:根据预定策略执行测试,并收集性能数据。

- **分析和报告**:分析收集到的数据,识别瓶颈,并生成测试报告。

### 3.2 负载测试实践

#### 3.2.1 构建负载测试环境

构建负载测试环境是保证测试准确性的第一步。在Linux系统中,你可能需要考虑以下因素:

- **硬件配置**:服务器的CPU、内存、磁盘IO和网络IO。

- **软件配置**:操作系统、网络服务(如Apache、Nginx)的配置。

- **网络环境**:包括带宽、延迟、丢包率等网络条件模拟。

#### 3.2.2 负载生成工具的选择和使用

选择合适的负载生成工具是实施负载测试的关键。以下是几个广泛使用的工具:

- **Apache JMeter**:一个开源的性能测试工具,支持多种负载测试场景。

- **Locust**:一个现代的开源负载测试工具,支持大规模分布式测试。

- **Gatling**:一个高性能的负载测试工具,特别适合进行复杂场景的测试。

以Apache JMeter为例,下面是一个简单的测试脚本编写步骤:

1. **创建测试计划**:启动JMeter后,先创建一个测试计划。

2. **添加线程组**:线程组代表一组用户的并发访问。

3. **配置HTTP请求**:在相应线程组下添加HTTP请求采样器,并配置URL等参数。

4. **设置监听器**:添加监听器来收集和查看测试结果。

5. **运行测试**:执行测试并观察结果。

代码示例:

```plaintext

# JMeter测试计划配置示例

# 配置文件通常为.jmx格式

<?xml version="1.0" encoding="UTF-8"?>

<jmeterTestPlan version="1.2" properties="5.0" jmeter="5.4.1">

<hashTree>

<TestPlan guiclass="TestPlanGui" testclass="TestPlan" testname="Load Test Plan" enabled="true">

<stringProp name="TestPlan.comments">This is a sample Load Test Plan</stringProp>

<boolProp name="TestPlan.functional_mode">false</boolProp>

<boolProp name="TestPlan.tearDown_on_shutdown">true</boolProp>

<boolProp name="TestPlan.serialize_threadgroups">false</boolProp>

<elementProp name="TestPlan.user_defined_variables" elementType="Arguments" guiclass="ArgumentsPanel" testclass="Arguments" testname="User Defined Variables" enabled="true"/>

<stringProp name="TestPlan.user_define_classpath"></stringProp>

</TestPlan>

<hashTree>

<ThreadGroup guiclass="ThreadGroupGui" testclass="ThreadGroup" testname="Thread Group" enabled="true">

<stringProp name="ThreadGroup.on_sample_error">continue</stringProp>

<elementProp name="ThreadGroup.main_controller" elementType="LoopController" guiclass="LoopControlPanel" testclass="LoopController" testname="Loop Controller" enabled="true">

<boolProp name="LoopController.first_loop">true</boolProp>

<stringProp name="LoopController.loops">1</stringProp>

</elementProp>

<stringProp name="ThreadGroup.num_threads">10</stringProp>

<stringProp name="ThreadGroup.ramp_time">10</stringProp>

<boolProp name="ThreadGroup.scheduler">false</boolProp>

<stringProp name="ThreadGroup.duration"></stringProp>

<stringProp name="ThreadGroup.delay"></stringProp>

</ThreadGroup>

<hashTree/>

</hashTree>

</hashTree>

</jmeterTestPlan>

```

每个配置项的详细解释:

- `TestPlan`节点定义了整个测试计划的全局设置。

- `ThreadGroup`节点用于设置并发用户数和测试的持续时间。

- `LoopController`可定义是否循环执行测试。

- `num_threads`代表同时运行的线程数。

- `ramp_time`表示测试从开始到达到设定线程数所需的时间。

请注意,这是一个JMeter配置文件的文本示例,正常情况下你需要使用JMeter图形界面进行配置。

#### 3.2.3 实际测试案例分析

实际案例分析能够帮助我们理解负载测试在真实场景中的应用。下面将通过一个案例来演示如何使用JMeter进行负载测试。

**案例描述**:我们有一台运行Nginx的Linux服务器,需要测试该服务器在100并发请求下,对静态资源(如图片、CSS文件等)的响应能力。

**实施步骤**:

1. **环境准备**:

- 确保服务器上已安装Nginx。

- 在测试机上安装JMeter。

2. **JMeter测试计划配置**:

- 创建一个测试计划,并添加一个线程组。

- 线程组设置为100个线程,持续时间为300秒,循环次数为1。

3. **HTTP请求配置**:

- 在线程组下添加一个HTTP请求采样器。

- 配置请求的协议、服务器名称或IP、端口以及路径。

4. **监听器配置**:

- 添加监听器,例如聚合报告和图形结果,用于查看测试结果。

5. **运行测试**:

- 启动JMeter,开始测试。

- 观察测试过程和结果。

6. **结果分析**:

- 分析测试数据,包括响应时间、吞吐量、错误率等。

- 根据测试结果,判断系统性能是否满足预期目标。

通过这个案例,我们可以看到负载测试不仅能够帮助我们发现系统在高负载下的表现,还能够为系统优化提供重要数据支持。在实际的生产环境中,测试的复杂性可能会更高,涉及的因素更多,但基本流程和方法是一致的。

# 4. Linux网络服务性能优化策略

## 4.1 优化理论与方法

### 4.1.1 优化的基本原则和思路

性能优化是一个持续的过程,其基本的原则是理解系统瓶颈和限制,然后通过优化调整来克服这些限制。优化思路需要按照以下步骤进行:

- **评估现状**:首先,需要准确评估系统当前的性能状态,包括识别瓶颈和资源利用情况。

- **定位问题**:确定问题的根本原因,是否为硬件资源限制、配置不当还是软件层面的性能问题。

- **制定方案**:基于评估结果,制定具体的优化方案,可以是资源升级、配置调优或代码优化等。

- **执行优化**:实施优化方案,并监控执行过程中的性能变化。

- **验证效果**:优化后,需要重新评估系统性能以验证优化效果。

- **持续监控**:优化不是一次性的任务,需要持续监控系统性能并根据实际情况进行调整。

### 4.1.2 系统资源的优化配置

在Linux系统中,性能优化往往与资源管理密切相关。优化系统资源配置可以从以下几方面进行:

- **内存管理**:优化内存的使用,包括调整内核参数来增加文件系统的缓存大小,减少内存交换(swap)。

- **CPU调度**:根据应用需求调整CPU的亲和性(affinity),确保关键进程优先级被提升。

- **文件系统优化**:选择合适的文件系统,调整其参数(如journaling、read/write cache大小等),以提高I/O性能。

- **网络配置**:优化网络栈参数,如调整TCP缓冲区大小、修改TCP/IP相关内核参数来减少延迟和提高吞吐量。

## 4.2 网络服务性能调优

### 4.2.1 服务配置优化实例

以Apache HTTP服务器为例,性能调优可以通过修改httpd.conf或apache2.conf配置文件实现:

```apache

<IfModule mpm_prefork_module>

StartServers 5

MinSpareServers 5

MaxSpareServers 10

MaxClients 150

MaxRequestsPerChild 0

</IfModule>

```

- **StartServers**:启动时启动的子服务器数量。

- **MinSpareServers**:最小空闲子服务器数量。

- **MaxSpareServers**:最大空闲子服务器数量。

- **MaxClients**:允许同时连接的最大数量。

- **MaxRequestsPerChild**:每个子服务器在其生存期内允许处理的最大请求数。

调整这些参数可以根据负载测试结果,改善服务器对于并发连接的响应速度和处理能力。

### 4.2.2 网络协议和参数调优

网络协议和参数的优化涉及调整网络栈的参数以适应特定的网络环境和负载条件:

```shell

# sysctl命令用于修改内核参数

sysctl -w net.ipv4.tcp_tw_reuse=1

sysctl -w net.ipv4.tcp_fin_timeout=30

```

- **tcp_tw_reuse**:允许重新使用TIME-WAIT套接字。

- **tcp_fin_timeout**:减少TIME-WAIT状态的持续时间。

这些参数的调整有助于减少连接建立和关闭的时间,提高高流量环境下的网络吞吐量。

## 4.3 案例分析:真实环境中的性能优化

### 4.3.1 常见问题和解决方案

在真实的生产环境中,性能问题可能由多种因素引起。常见的性能问题和对应的解决方案包括:

- **高CPU使用率**:可能因为单个或多个进程占用了太多CPU资源。解决方案包括优化进程代码、调整内核调度策略或水平扩展服务。

- **高I/O延迟**:可能由于存储设备性能不足或磁盘空间不足。解决方法包括增加更快的存储设备、优化I/O操作或使用RAID。

- **内存泄露**:应用程序或服务存在内存管理问题。解决方法通常涉及代码审计、内存分析和应用升级。

### 4.3.2 优化效果的验证和评估

验证和评估优化效果需要收集和分析性能数据。通过工具如`ab`、`wrk`进行压力测试,或者使用`netstat`、`iostat`、`vmstat`等命令收集性能指标:

```shell

ab -n 10000 -c 100 http://yourserver.com/

```

在执行优化前后都要进行测试,然后比较测试结果。性能数据收集应该包括响应时间、吞吐量、错误率和系统资源使用情况。通过比较这些指标,可以验证优化措施是否有效。

| 性能指标 | 优化前 | 优化后 |

|----------|---------|---------|

| 平均响应时间 | 250ms | 120ms |

| 吞吐量 | 200 req/s | 300 req/s |

| 错误率 | 1% | 0.1% |

| CPU利用率 | 85% | 65% |

| 内存使用 | 75% | 50% |

| I/O读写 | 500KB/s | 300KB/s |

通过表格可以看出,经过优化后,系统响应时间缩短,吞吐量提高,资源利用率下降,证明优化措施是有效的。

性能优化是一个迭代过程,需要根据实际情况进行调整和再测试。通过不断的优化,可以确保系统在各种负载情况下都能保持良好的性能表现。

# 5. Linux网络服务性能监控与自动化

## 5.1 系统监控工具和策略

随着网络服务的日益复杂化,性能监控已成为保障服务稳定运行的关键环节。监控不仅能及时发现系统异常,还能提供性能优化的数据依据。本节将介绍如何选择合适的系统监控工具,以及如何配置它们以实现有效的监控策略。

### 5.1.1 监控工具的选择与配置

Linux环境下有许多强大的监控工具可供选择,例如Nagios、Zabbix和Prometheus等。每种工具都有其特点和适用场景,用户需要根据自己的需求进行选择。

以Prometheus为例,它是一个开源的监控解决方案,以其易用性和强大的查询语言而受到青睐。它通过拉取(pulling)的方式,从被监控节点收集数据,并支持多种数据存储解决方案。

下面是Prometheus的基本配置步骤:

1. **安装Prometheus**:

使用包管理器安装Prometheus。例如,在基于Debian的系统中,可以使用以下命令:

```bash

sudo apt-get update

sudo apt-get install prometheus

```

2. **配置prometheus.yml文件**:

编辑配置文件`/etc/prometheus/prometheus.yml`,定义监控目标和抓取频率:

```yaml

global:

scrape_interval: 15s # 每15秒抓取一次数据

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

```

3. **启动Prometheus服务**:

```bash

sudo systemctl start prometheus

```

4. **访问Prometheus UI**:

通过浏览器访问 http://localhost:9090 ,在UI界面中可以对数据进行查询和分析。

### 5.1.2 实时监控和告警机制

实时监控可以快速响应异常状况,及时通知运维人员。大多数监控系统都支持告警功能,能够通过邮件、短信或者即时通讯工具推送告警信息。

以Prometheus为例,它可以通过配置告警规则文件`alert.rules.yml`来实现告警机制:

```yaml

groups:

- name: example

rules:

- alert: HighRequestLatency

expr: job:request_latency_seconds:mean5m{job="myjob"} > 0.5

for: 10m

labels:

severity: page

annotations:

summary: High request latency

```

上述规则定义了一个名为`HighRequestLatency`的告警,当`myjob`作业的平均请求延迟超过0.5秒持续10分钟时,触发告警。

配置完成后,需要将告警规则文件加载到Prometheus中:

```bash

sudo systemctl reload prometheus

```

现在,Prometheus将根据定义的规则文件进行实时监控,并在满足条件时触发告警。

## 5.2 自动化测试框架的应用

自动化测试框架通过脚本控制测试的执行,减少了重复劳动,提高了测试效率。本节将介绍自动化测试框架的种类和如何编写自动化测试脚本。

### 5.2.1 自动化测试框架介绍

自动化测试框架大致可以分为三大类:

- **记录/回放**:如Selenium IDE,可以记录用户操作并回放,但往往缺乏灵活性。

- **关键字驱动**:如Robot Framework,提供了一系列可复用的测试关键字来执行测试。

- **数据驱动**:重点在于使用数据驱动测试,即测试逻辑与测试数据分离,如JUnit配合TestNG。

选择适合的自动化测试框架非常重要,它需要根据项目需求、团队习惯和技术栈进行选择。

### 5.2.2 脚本编写和测试流程自动化

以Python语言的Selenium库为例,演示如何编写一个简单的自动化测试脚本。首先需要安装Selenium:

```bash

pip install selenium

```

然后,编写一个测试脚本来自动化Web应用的登录过程:

```python

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

driver = webdriver.Firefox()

driver.get("http://example.com/login")

username = driver.find_element_by_name('username')

password = driver.find_element_by_name('password')

username.send_keys('testuser')

password.send_keys('testpass')

login_button = driver.find_element_by_name('login')

login_button.click()

assert "登录成功" in driver.page_source

```

上述代码通过Selenium打开浏览器,访问登录页面,输入用户名和密码,然后点击登录按钮,并验证页面是否包含“登录成功”字样。

为了实现测试流程的自动化,可以通过Jenkins、Travis CI等持续集成工具,将测试脚本集成到开发流程中,实现每次代码提交都自动执行测试。

## 5.3 持续集成与性能优化

将性能测试纳入持续集成流程,可以确保每次代码变更都经过性能审查,从而持续优化应用性能。

### 5.3.1 持续集成流程中的性能测试

在持续集成流程中,性能测试通常遵循以下步骤:

1. **开发人员提交代码变更**:

开发人员提交代码到版本控制系统。

2. **构建触发**:

通过钩子(hook)或者触发器(trigger)自动触发构建过程。

3. **执行单元测试和功能测试**:

首先执行单元测试和功能测试来确保代码变更未破坏现有功能。

4. **执行性能测试**:

使用JMeter或Locust等工具进行性能测试。

5. **结果分析与反馈**:

分析性能测试结果,如果性能不达标,将反馈给开发团队进行优化。

### 5.3.2 持续性能优化的方法和实践

持续性能优化不仅仅是测试,还包括性能调优、监控和响应等多个环节。

- **性能调优**:定期对系统进行性能分析,找出瓶颈进行优化,这可能包括代码优化、数据库查询优化、硬件升级等。

- **性能监控**:实时监控系统性能指标,如CPU、内存、I/O、网络使用情况等。

- **性能问题响应**:当监控系统发现性能问题时,及时响应并采取措施,例如自动扩容、负载均衡调整或进行紧急修复。

通过上述步骤,可以将性能优化融入日常开发工作流中,持续提升应用性能和用户体验。

通过本章节的介绍,我们了解了系统监控工具的选择与配置、自动化测试框架的应用以及如何将性能测试和优化融入持续集成流程。这些策略和实践对于确保Linux网络服务的稳定性和性能至关重要。在下一章中,我们将探讨负载测试技术的发展和Linux网络服务的未来展望。

# 6. 展望与未来趋势

随着技术的快速发展和业务需求的不断变化,负载测试技术和Linux网络服务都在面临新的挑战和机遇。在这一章节中,我们将深入探讨这些领域未来的发展方向和可能的趋势。

## 6.1 负载测试技术的发展

### 6.1.1 新兴技术和工具的概述

随着云计算、大数据、物联网和人工智能等技术的兴起,负载测试领域也在不断创新。新兴技术为负载测试带来了新的维度和复杂性,同时也带来了新的工具和方法。

**云计算环境下的负载测试工具**:在云计算环境下,资源的动态分配和按需使用特性要求负载测试工具能够模拟这种灵活性。工具如CloudTest、LoadImpact等已经提供了在云环境下进行压力测试的功能。

**容器化与微服务架构的测试工具**:随着Docker和Kubernetes的普及,容器化和微服务架构正在成为新的标准。JMeter、Gatling等负载测试工具都支持对基于容器的服务进行测试,同时也在增加对服务网格(如Istio)的支持。

**人工智能在负载测试中的应用**:人工智能技术正在被引入负载测试,以提高测试的智能性和自适应性。例如,通过机器学习算法,测试工具可以预测系统的性能瓶颈和自动调整测试场景,优化测试过程。

### 6.1.2 负载测试未来的发展方向

随着新兴技术的不断涌现,负载测试的未来发展将趋于自动化、智能化和集成化。

**自动化**:自动化测试将减少人工干预,提高测试效率和覆盖率。随着持续集成/持续部署(CI/CD)流程的普及,负载测试将被更好地集成到软件开发周期中。

**智能化**:AI技术的融合将使负载测试更加智能,例如自动识别性能瓶颈、生成测试用例、调整负载模型等。

**集成化**:负载测试将与应用性能管理(APM)、监控系统等其他系统更加紧密地集成,为用户提供一个完整的性能分析和优化平台。

## 6.2 Linux网络服务的未来展望

### 6.2.1 网络技术的革新对性能的影响

网络技术的进步,如5G、IPv6、网络功能虚拟化(NFV)和软件定义网络(SDN),将对Linux网络服务的性能产生深远的影响。

**5G网络**:5G网络的高速率、低延迟特性将推动网络服务在边缘计算等领域的应用。Linux服务器需要支持更高密度的网络连接和更快的数据处理速度,以满足实时服务的需求。

**IPv6的全面部署**:随着IPv6的普及,网络服务将面临更多新的挑战,如地址管理、安全性和兼容性问题。Linux内核和服务需要不断更新以应对这些新挑战。

### 6.2.2 云原生环境下的性能挑战与机遇

云原生环境,特别是Kubernetes等容器编排工具的广泛应用,为Linux网络服务的部署和管理带来了新的机遇和挑战。

**性能挑战**:容器化的应用需要能够快速地进行扩展和缩减,这要求网络服务能够灵活地适应动态变化的环境。同时,服务的隔离和安全性也需要在新的架构下重新考虑。

**性能机遇**:在云原生环境下,可以通过服务网格等技术实现精细化的流量管理和故障恢复,这些都有助于提高网络服务的整体性能和可靠性。

通过不断演进的负载测试技术,以及对Linux网络服务架构的持续优化,我们可以期待一个更加灵活、高效和智能的未来网络环境。而对从业者来说,这意味着需要不断学习和适应新技术,以迎接未来的挑战。

0

0