【线性回归变种对比】:岭回归与套索回归的深入分析及选择指南

发布时间: 2024-11-22 14:05:19 阅读量: 9 订阅数: 7

# 1. 线性回归基础概述

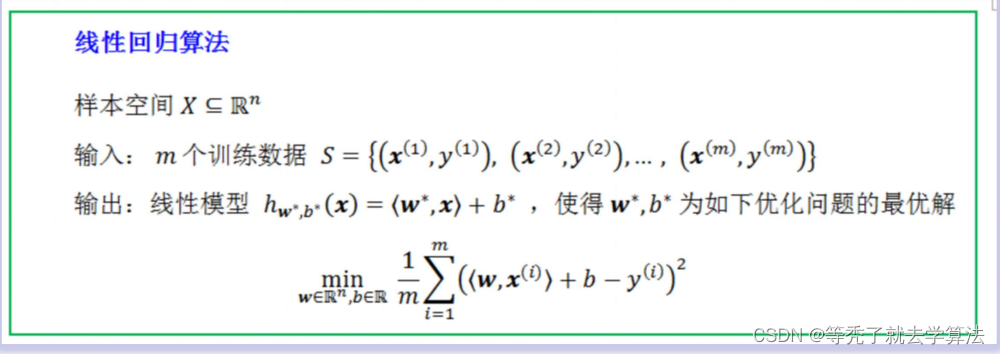

线性回归是最基础且广泛使用的统计和机器学习技术之一。它旨在通过建立一个线性模型来研究两个或多个变量间的关系。本章将简要介绍线性回归的核心概念,为读者理解更高级的回归技术打下坚实基础。

## 1.1 线性回归的基本原理

线性回归模型试图找到一条直线,这条直线能够最好地描述数据集中各个样本点。通常,我们会有一个因变量(或称为响应变量)和一个或多个自变量(或称为解释变量)。通过最小化误差项,即预测值与实际值之间的差异,线性回归模型能够拟合出一条最佳拟合线。

## 1.2 线性回归模型的数学表达

在数学上,一个简单的线性回归模型可以表示为:

y = β0 + β1x1 + ε

其中,y是因变量,x1是自变量,β0是截距项,β1是斜率参数,ε是误差项。在多元线性回归中,模型将包含更多的自变量和相应的参数。

## 1.3 线性回归的应用

线性回归广泛应用于经济学、金融分析、生物统计学、市场研究等领域。它帮助研究者和从业者理解不同变量之间的关系,并进行预测。在机器学习中,线性回归常用于初步的数据探索和模型构建。

理解线性回归的基础是进行更复杂数据分析的基石。随着本章的结束,我们将步入一个更加丰富的统计世界,开始探索如何通过各种技术改进传统的线性回归模型。

# 2. 岭回归的理论与实践

### 2.1 岭回归的数学原理

#### 2.1.1 岭回归的目标函数与损失函数

岭回归(Ridge Regression)是一种处理具有多重共线性数据的线性回归方法,通过在损失函数中引入L2正则化项来避免过拟合。具体地,岭回归的目标函数可以表示为:

\[ \text{minimize} \quad \frac{1}{2n} ||Xw - y||_2^2 + \alpha \frac{1}{2} ||w||_2^2 \]

其中,\( X \) 是特征矩阵,\( y \) 是目标变量向量,\( w \) 是系数向量,\( n \) 是样本数量,\( \alpha \) 是正则化强度参数(也称为岭回归参数λ),\( ||\cdot||_2 \) 表示L2范数,即向量的欧几里得长度。

在这个目标函数中,第一项是均方误差项(MSE),代表了模型对于训练数据的预测误差;第二项是L2正则化项,它对模型的系数大小进行惩罚,以此减少模型复杂度,增强模型的泛化能力。

#### 2.1.2 正则化参数λ的作用

在岭回归中,参数λ(正则化项系数)是一个超参数,需要在模型训练之前设定。λ的值越大,对模型系数的惩罚越重,因此模型的复杂度会降低,从而可以减少过拟合的风险,但过大的λ也会导致欠拟合。反之,如果λ设置得太小,岭回归就会接近普通的线性回归,可能无法有效防止过拟合。

为了找到合适的λ值,可以采用交叉验证的方法,即在训练集中留出一部分数据作为验证集,通过验证集上的性能来选择最佳的λ值。

### 2.2 岭回归的实现步骤

#### 2.2.1 数据预处理与模型初始化

数据预处理是构建任何机器学习模型的重要环节。对于岭回归而言,数据预处理包括特征缩放、缺失值处理和独热编码等步骤。由于岭回归对特征的缩放比较敏感,通常需要对特征进行标准化或归一化处理。

在数据预处理后,我们需要初始化模型参数。这包括设置初始的λ值和选择一个优化算法,如随机梯度下降(SGD)或批量梯度下降。

```python

import numpy as np

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import Ridge

from sklearn.model_selection import train_test_split

# 假设我们已经有了特征矩阵X和目标变量向量y

# 数据预处理:标准化特征

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.2, random_state=42)

# 初始化岭回归模型

ridge_reg = Ridge(alpha=1.0)

```

#### 2.2.2 使用梯度下降法求解模型参数

梯度下降法是一种通过迭代的方式求解损失函数最小值的方法。对于岭回归,我们可以通过求解偏导数来得到更新模型参数的梯度公式。然后通过迭代更新模型参数,直到收敛。

```python

# 以批量梯度下降为例,手动实现参数更新过程

learning_rate = 0.01

n_iterations = 1000

m = len(X_train)

ridge_reg = Ridge(alpha=1.0)

# 梯度下降法参数更新

for iteration in range(n_iterations):

gradients = 2/m * X_train.T.dot(X_train.dot(ridge_reg.coef_) - y_train) + ridge_reg.alpha * ridge_reg.coef_

ridge_reg.coef_ -= learning_rate * gradients

# 输出训练完成后的模型参数

print("模型系数:", ridge_reg.coef_)

```

#### 2.2.3 模型评估与验证

在模型训练完成后,需要使用验证集或测试集来评估模型的性能。常用的方法包括计算R²分数、均方误差(MSE)和均方根误差(RMSE)等。

```python

from sklearn.metrics import mean_squared_error, r2_score

# 使用测试集评估模型性能

y_pred = ridge_reg.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

rmse = np.sqrt(mse)

r2 = r2_score(y_test, y_pred)

print("测试集上的均方误差:", mse)

print("测试集上的均方根误差:", rmse)

print("测试集上的R²分数:", r2)

```

### 2.3 岭回归的实践案例分析

#### 2.3.1 数据集描述与预处理

在此部分,我们会描述所使用数据

0

0