自然语言处理:2小时掌握NLP基础与应用

发布时间: 2024-09-01 11:12:40 阅读量: 276 订阅数: 75

探索Python中的NLTK:自然语言处理的应用与实践

# 1. 自然语言处理简介

在本章中,我们将踏入自然语言处理(NLP)的领域,为理解其基本概念与应用奠定基础。自然语言处理是计算机科学和语言学领域中的一门交叉学科,旨在使计算机能够理解和生成人类语言。它涉及从语言学、计算机科学到数学等多个领域的知识,已经成为人工智能技术的重要分支。

我们将从NLP的定义和它在现代社会中的应用入手,了解如何让机器理解人类的语言,以及它如何帮助我们更好地处理海量的语言数据。在此过程中,读者将接触到一系列NLP技术,例如文本挖掘、机器翻译以及语音识别等。

通过本章,你将获得对自然语言处理这一广阔领域一个宏观的认识,并为深入学习NLP的理论与实践奠定坚实的基础。接下来的章节将围绕NLP的基础理论、实践工具、核心应用以及高级主题等展开详细介绍,引导你深入探索NLP的奥秘。

```mermaid

graph TD

A[开始] --> B[自然语言处理简介]

B --> C[定义和应用]

B --> D[理解语言处理]

B --> E[探索NLP技术]

C --> F[为后续章节打基础]

```

# 2. NLP基础理论

## 2.1 语言学基础知识

### 2.1.1 语义学与语法学

语言学是自然语言处理的基石,它提供了理解人类语言的理论基础。在NLP中,我们经常涉及两个重要的分支:语义学和语法学。语义学关注的是语言中词汇和短语的意义,以及它们是如何组合来表达更复杂的概念。例如,不同的词序和上下文可以影响词义,从而产生不同的句子意义。

语法学则是研究单词和短语如何构成句子的规则体系。它涉及词类(如名词、动词、形容词等)的分类,句子的结构,以及如何通过语法结构来表达意图和意义。理解语法对于NLP尤其重要,因为计算机程序需要通过这些结构来解析和理解复杂的语言信息。

### 2.1.2 词汇、句法和语篇分析

词汇分析是识别文本中单词和短语的过程。这是NLP中比较基础的一步,但它对于许多后续处理至关重要。例如,在文本挖掘和搜索引擎优化(SEO)中,正确地识别和理解关键词是核心。句法分析则涉及理解句子的结构和语法,例如主谓宾结构,以及各种修饰成分的排列方式。

语篇分析关注的是跨越单个句子的连贯性和意义。在处理文档或对话时,了解句子之间的关系,如因果关系、转折关系等,对于理解整个语篇的意图和重点至关重要。通过这种分析,机器可以更好地捕捉语言的语境和细微差别。

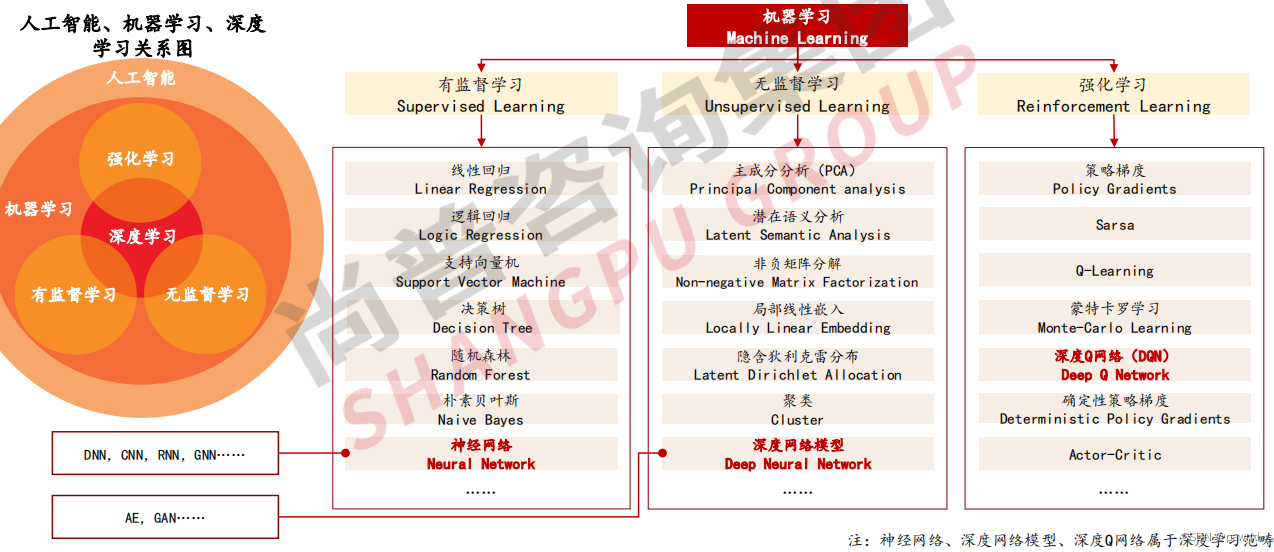

## 2.2 机器学习与深度学习基础

### 2.2.1 基本的机器学习概念

机器学习是NLP的一个核心组成部分,它提供了一种方式,让机器可以自动从数据中学习规律和模式。在基础的机器学习概念中,我们通常需要理解模型、特征、标签以及训练和测试过程。

- 模型是对真实世界数据关系的数学描述。

- 特征是从原始数据中提取出来的信息,是模型学习的基础。

- 标签是目标值或结果,是模型预测的对象。

- 训练过程是模型通过数据学习参数的过程。

- 测试过程是模型使用学习到的参数对新数据进行预测的过程。

### 2.2.2 深度学习架构简介

深度学习是机器学习的一个子领域,它使用深度神经网络来模拟人脑处理信息的方式。深度学习架构通常包括输入层、隐藏层和输出层。输入层接收原始数据,隐藏层由多层神经元组成,每一层都可以学习到数据的不同特征。

深度学习在NLP中特别有用,因为它可以处理大量的非结构化文本数据,并从中学习复杂的模式。卷积神经网络(CNNs)和循环神经网络(RNNs)是处理序列数据(如文本)的两种常用架构。CNNs擅长捕捉局部特征,而RNNs则因其记忆机制而善于处理时间序列数据。

## 2.3 NLP中的预处理技术

### 2.3.1 文本清洗和标准化

文本清洗是NLP中至关重要的预处理步骤之一。它包括去除无关字符、纠正拼写错误、转换大小写、删除停用词(如“the”, “is”, “at”等常用但通常对分析没有帮助的词)等。文本标准化通常涉及文本规范化的过程,比如词干提取(stemming)和词形还原(lemmatization)。

词干提取是将词还原到最原始的形态,如将“running”还原为“run”。而词形还原更进一步,将词还原到词典中的基本形式,即词根(lemma),例如将“better”还原为“good”。

### 2.3.2 分词和词性标注

分词是将连续的文本切分成词或词素。对于英语等西方语言而言,分词相对简单,因为单词之间通常有空格作为分隔。但对于中文、日语等没有明显空格分隔的语言,分词是一个挑战。

词性标注(POS tagging)则涉及识别每个单词的语法类别,如名词、动词、形容词等。这有助于后续的文本分析,例如句法分析,因为在自然语言中,不同的词性可能会有不同的作用。

接下来,我们将深入探讨NLP的实践工具与环境搭建,继续在NLP的征途中前行。

# 3. NLP实践工具与环境搭建

在第三章中,我们将深入探讨如何搭建自然语言处理(NLP)的实践环境。这一章是实践性很强的章节,不仅需要理解NLP工具和库的安装配置,还要掌握如何设置开发环境以及构建项目的初步框架。本章节将从选择合适的编程语言和库开始,逐步深入到实践工具的选择与配置,最后讨论NLP项目的结构设计和开发环境的搭建与测试。

## 3.1 Python环境与NLP库

### 3.1.1 Python基础与安装

Python之所以成为NLP领域首选的编程语言,原因在于它的简洁性和强大的社区支持。Python拥有丰富的库和框架,特别是对于数据科学和机器学习,有着诸如NumPy、Pandas、Scikit-learn和TensorFlow等成熟的工具。NLP领域的许多核心库如NLTK(Natural Language Toolkit)、spaCy和AllenNLP等也都是基于Python开发的。

安装Python相对简单。你可以从Python官方网站下载适合你操作系统的安装包。安装完成后,打开命令行工具,运行以下命令以确认Python安装成功:

```bash

python --version

```

此外,Python包管理工具pip是安装其他第三方库的关键。通过以下命令,你可以安装任何Python库:

```bash

pip install package_name

```

### 3.1.2 常用NLP库介绍与安装

在NLP项目中,我们会用到多种库来处理不同的任务。以下是一些常用的NLP库以及它们的主要功能:

- **NLTK**:提供了一个全面的NLP解决方案,包括分词、标注、解析等工具,适合初学者学习和理解NLP。

- **spaCy**:一个工业级的NLP库,具有更快的处理速度和多种语言的支持,是生产环境中的理想选择。

- **AllenNLP**:基于PyTorch构建,支持实验研究,提供了深度学习模型的预训练和训练功能。

对于这些库的安装,可以使用pip命令直接安装:

```bash

pip install nltk

pip install spacy

pip install allennlp

```

安装完成后,我们可以通过简单的示例代码来验证安装是否成功:

```python

import nltk

nltk.download('punkt')

import spacy

nlp = spacy.load('en_core_web_sm')

from allennlp.predictors.predictor import Predictor

predictor = Predictor.from_path("***")

```

通过上述代码,我们已经可以感受到NLP库的威力,这些操作将在后续章节中得到深入应用。

## 3.2 实践工具的选择与配置

### 3.2.1 IDE选择与配置

集成开发环境(IDE)是提高开发效率的重要工具。对于Python开发,有几款流行的IDE,包括PyCharm、Visual Studio Code(VS Code)、Jupyter Notebook等。这些IDE都有各自的优点,比如PyCharm拥有强大的调试和代码管理功能,VS Code则以轻量和插件丰富而著称。

选择IDE时,需考虑以下因素:

- **调试支持**:能够快速定位和修复代码中的错误。

- **扩展性**:插件和扩展能够提升开发的便利性。

- **版本控制**:集成了Git等版本控制工具。

- **社区支持**:拥有活跃的社区提供帮助和插件更新。

安装IDE之后,你可能需要安装一些针对NLP开发的插件。例如,在VS Code中,可以安装Python扩展来提供代码提示和运行Python脚本的功能。

### 3.2.2 数据集的获取与预处理

NLP项目的成功很大程度上取决于数据集的质量。数据集的获取途径有很多,可以是公开的NLP数据集,如UCI语料库、Google的开源数据集等。此外,也可以通过网页抓取、API获取等方式自行构建数据集。

获取数据后,需要进行数据清洗和预处理。这通常包括去除无效数据、去除停用词、文本规范化(比如大小写转换、标点处理)等。这一步骤需要根据项目的具体需求来定制。

举个简单的预处理流程的例子,使用Python进行文本清洗:

```python

import re

def clean_text(text):

# 移除非字母字符

text = re.sub(r'[^a-zA-Z\s]', '', text)

# 转换为小写

text = text.lower()

return text

# 示例

dirty_text = "This is a sample! It includes #hashtags, @mentions, and URLs."

cleaned_text = clean_text(dirty_text)

print(cleaned_text) # 输出: this is a sample it includes hashtags mentions and urls

```

通过这样的文本清洗,我们可以为后续的NLP任务打下良好的基础。

## 3.3 构建NLP项目的基本框架

### 3.3.1 项目结构设计

一个清晰的项目结构有助于团队成员理解项目的全局视图。对于NLP项目来说,一个典型的项目结构可能包括以下几个部分:

- `data`:存储数据集文件。

- `models`:存储训练好的模型文件。

- `src`:存放源代码文件。

- `notebooks`:存放Jupyter Notebook等交互式分析文件。

- `tests`:存放自动化测试代码。

- `docs`:存放项目的文档说明。

这样设计项目结构,可以帮助我们快速定位代码和数据,同时便于进行版本控制和团队协作。

### 3.3.2 开发环境的搭建与测试

搭建开发环境主要包括安装项目依赖和配置项目运行环境。通常,我们会将所有依赖写入一个`requirements.txt`文件中,列出所有需要的库及其版本。例如:

```

nltk==3.5

spacy==2.3.2

allennlp==1.0.0

```

安装依赖的命令如下:

```bash

pip install -r requirements.txt

```

测试开发环境是否搭建成功,我们可以运行一些基本的代码来检查库是否正常工作。例如,检查spaCy是否能正确加载英文模型:

```python

import spacy

try:

nlp = spacy.load('en_core_web_sm')

print("spaCy英文模型加载成功!")

except Exception as e:

print("加载spaCy英文模型失败:", e)

```

以上步骤完成后,我们就可以开始NLP项目的具体开发工作了。在下一章中,我们将深入探讨NLP的核心应用实例。

# 4. NLP核心应用实例分析

## 4.1 文本分类与情感分析

### 4.1.1 文本分类的基本方法

文本分类是将文本数据分配到一个或多个类别中的任务。在NLP中,文本分类是一种基础应用,可广泛应用于垃圾邮件过滤、新闻文章分类、情感倾向判断等。其基本方法主要包括传统机器学习和深度学习。

传统的机器学习方法通常依赖于人工设计的特征,如TF-IDF(Term Frequency-Inverse Document Frequency)权重,作为特征向量。然后,使用这些特征向量训练分类器,例如支持向量机(SVM)、朴素贝叶斯(Naive Bayes)分类器等。

深度学习方法则通过构建神经网络模型,自动从原始文本中学习特征表示。卷积神经网络(CNN)在文本分类任务中取得了良好的效果,而循环神经网络(RNN)及其变体,如长短期记忆网络(LSTM)和门控循环单元(GRU),则因其在序列数据上的优势而广泛应用于文本分类。

在Python中,可以使用`scikit-learn`库来实现传统的机器学习方法,而`TensorFlow`和`PyTorch`则更适合深度学习方法。

### 4.1.2 情感分析的实现

情感分析,又称为意见挖掘,是识别和提取文本中情感倾向的过程。情感分析主要分为基于词典的方法、基于机器学习的方法和基于深度学习的方法。

基于词典的方法依赖于预定义的情感词典,通过匹配文本中的词汇来判断整体的情感倾向。这种方法简单直接,但缺乏上下文的理解。

基于机器学习的方法则通常需要一个带有标签的情感分析数据集来训练分类器。文本特征提取后,可以训练一个分类模型进行情感倾向的预测。

基于深度学习的方法,特别是预训练语言模型(如BERT、GPT等),在情感分析任务上展现出了优异的性能。这些模型能够捕捉复杂的语言特征和语境信息。

下面是一个使用Python和`Transformers`库实现基于BERT的情感分析的代码示例:

```python

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

# 预处理文本

def get_prediction(text):

inputs = tokenizer(text, return_tensors="pt", padding=True, truncation=True, max_length=512)

outputs = model(**inputs)

probs = outputs[0].softmax(1)

return probs

# 示例文本

text = "I love the new iPhone! It's fantastic."

prediction = get_prediction(text)

# 输出预测结果

print("Probability of being positive:", prediction[0][1].item())

print("Probability of being negative:", prediction[0][0].item())

```

在上述代码中,我们首先加载了BERT的分词器和预训练模型。然后定义了一个函数`get_prediction`,它接受一个文本字符串作为输入,并返回一个概率分布,表示文本属于每个类别(例如正面或负面情感)的概率。

## 4.2 命名实体识别与关系抽取

### 4.2.1 命名实体识别技术

命名实体识别(Named Entity Recognition,简称NER)是NLP中的一个基本任务,旨在识别文本中的具有特定意义的实体,如人名、地名、组织名等。随着深度学习的发展,基于BERT的预训练模型在NER任务中表现出色。

传统的NER方法依赖于手工设计的特征和规则,例如使用词性标注(POS tagging)的结果作为特征。这些方法容易受到规则和特征设计的限制。

现代的深度学习方法利用上下文信息,能够更准确地识别实体。基于双向LSTM和CRF(条件随机场)的模型被广泛应用于NER任务中。最近,Transformer架构的预训练模型,如BERT、RoBERTa等,在NER任务上取得了突破性的成果。

一个典型的基于BERT的NER模型可以这样实现:

```python

from transformers import BertTokenizer, BertForTokenClassification

import torch

# 加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForTokenClassification.from_pretrained('dbmdz/bert-large-cased-finetuned-conll03-english')

# 示例文本

text = "Barack Obama was born in Hawaii."

inputs = tokenizer(text, return_tensors="pt", padding=True, truncation=True, max_length=512)

outputs = model(**inputs)

# 解析结果

predictions = torch.argmax(outputs.logits, dim=2)

tags = [model.config.id2label[prediction.item()] for prediction in predictions[0]]

print(tags)

```

在上述代码中,我们加载了BERT的分词器和一个针对命名实体识别任务预训练的模型。之后,我们对示例文本进行处理,得到每个标记对应的实体类型。

### 4.2.2 关系抽取与知识图谱

关系抽取旨在从非结构化的文本中识别实体之间的关系,这通常用于构建知识图谱。知识图谱由实体、关系和属性组成,它能够表示现实世界中的复杂结构信息。

关系抽取的挑战在于需要识别文本中的隐含关系,而这些关系可能受到上下文的影响。传统的关系抽取方法依靠复杂的规则和特征工程,通常需要大量的领域专家知识。

深度学习的方法能够自动学习文本中实体和关系的表示。基于Transformer的模型,如BERT,通过掩码语言模型预训练任务学习了丰富的文本表示,可以被用于下游的实体对抽取任务。

一个简单的基于BERT的关系抽取示例代码如下:

```python

from transformers import BertTokenizer, BertModel

import torch

# 加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained('bert-base-uncased')

# 处理文本

text = "Barack Obama was born in Hawaii."

inputs = tokenizer(text, return_tensors="pt", padding=True, truncation=True, max_length=512)

outputs = model(**inputs)

# 抽取实体向量表示

last_hidden_states = outputs.last_hidden_state

print(last_hidden_states.size()) # 输出向量维度

```

在这个例子中,我们使用BERT模型提取了文本中每个词的向量表示。在实际的关系抽取任务中,会利用这些向量表示来确定文本中实体之间的关系。

## 4.3 机器翻译与对话系统

### 4.3.1 机器翻译的原理与实践

机器翻译(Machine Translation,简称MT)是将一种语言的文本自动翻译成另一种语言的技术。神经机器翻译(Neural Machine Translation,简称NMT)是当前最先进的翻译技术,它通常基于一个端到端的序列到序列(Seq2Seq)的模型,这个模型包含编码器(Encoder)和解码器(Decoder)。

编码器负责将输入文本编码成一个上下文向量,而解码器则从这个向量中生成翻译后的文本。注意力机制(Attention Mechanism)的引入进一步提升了翻译的质量,因为它允许模型在翻译过程中关注输入文本的不同部分。

下面是一个使用`transformers`库中的Transformer模型进行机器翻译的简单示例:

```python

from transformers import MarianMTModel, MarianTokenizer

# 加载预训练的机器翻译模型和分词器

tokenizer = MarianTokenizer.from_pretrained('Helsinki-NLP/opus-mt-en-fr')

model = MarianMTModel.from_pretrained('Helsinki-NLP/opus-mt-en-fr')

# 示例文本

text = "Hello, how are you?"

inputs = tokenizer(text, return_tensors="pt")

outputs = model.generate(**inputs)

# 翻译文本

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

```

在这个例子中,我们使用了一个预训练的英法翻译模型。通过输入英语文本,我们得到了翻译后的法语文本。

### 4.3.2 对话系统的设计与开发

对话系统(也称为聊天机器人)能够与用户进行交流,为用户解答问题或提供服务。对话系统的设计通常包括自然语言理解(NLU)、对话管理和自然语言生成(NLG)三个主要部分。

自然语言理解负责理解用户输入的意图和实体;对话管理则负责对话的流程控制,决定下一步的策略;自然语言生成负责构建对用户的回应。

基于深度学习的对话系统能够处理复杂的对话场景,如基于上下文的回复、情感的识别和回应。利用预训练语言模型,如GPT-2、BERT等,可以极大地提升对话系统的性能。

一个简单的基于Transformer模型构建的对话系统示例代码如下:

```python

from transformers import BartForConditionalGeneration, BartTokenizer

# 加载预训练的对话生成模型和分词器

tokenizer = BartTokenizer.from_pretrained('facebook/bart-large-cnn')

model = BartForConditionalGeneration.from_pretrained('facebook/bart-large-cnn')

# 示例对话

dialogue = [

{'role': 'system', 'content': 'Hello! How can I help you today?'},

{'role': 'user', 'content': 'Could you tell me the weather?'}

]

# 构建对话输入

dialogue_history = ""

for utterance in dialogue:

text = utterance['content']

if utterance['role'] == 'user':

text = "<usr> " + text

else:

text = "<sys> " + text

dialogue_history += text + tokenizer.eos_token

# 生成回复

input_ids = tokenizer.encode(dialogue_history, return_tensors='pt')

output_ids = model.generate(input_ids, max_length=1000, no_repeat_ngram_size=2)

response = tokenizer.decode(output_ids[:, input_ids.shape[-1]:][0], skip_special_tokens=True)

print("Response:", response)

```

在这个例子中,我们使用了Facebook的BART模型来生成对话系统中的回复。通过构建一个对话历史,我们得到模型生成的回复。

综上所述,文本分类与情感分析、命名实体识别与关系抽取、机器翻译与对话系统是NLP的几个核心应用实例。随着深度学习技术的不断进步,这些NLP应用正变得越来越高效和精准,为人类的语言理解与处理开辟了新的可能性。

# 5. NLP高级主题与前沿研究

## 5.1 深度学习在NLP中的应用

### 5.1.1 循环神经网络(RNN)

循环神经网络(Recurrent Neural Network, RNN)是专门处理序列数据的神经网络,它能够处理长度不定的序列输入,并且在序列的每一个时间步能够依赖于之前的计算结果。RNN在NLP领域的许多任务中起到了关键的作用,例如在机器翻译、文本生成和语音识别中。

#### *.*.*.* RNN的结构与工作原理

RNN的核心思想在于其隐藏状态能够在序列的不同时刻之间传递信息。具体来说,RNN通过一个循环单元来进行运算,该循环单元将当前输入和前一时刻的状态作为输入来更新当前状态,并产生当前时刻的输出。

```python

# RNN在Keras中的简单示例代码

from keras.models import Sequential

from keras.layers import SimpleRNN

model = Sequential()

model.add(SimpleRNN(50, return_sequences=True, input_shape=(timesteps, input_dim)))

model.add(SimpleRNN(50, return_sequences=False))

model.add(Dense(1, activation='sigmoid'))

# 编译模型

***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

```

代码解释:

- 这段代码首先创建了一个Sequential模型。

- 使用`SimpleRNN`层构建了两层RNN,其中`return_sequences`参数决定是否返回全序列或者仅返回每个序列的最后一个输出。

- 最后一层使用了一个全连接层(`Dense`)来生成最终的输出。

- 编译时指定了损失函数、优化器和评估指标。

RNN 的参数说明:

- `timesteps`:序列长度。

- `input_dim`:输入特征的维度。

- `50`:隐藏单元的数量。

- `return_sequences`:是否返回整个序列的输出或仅返回最后一步的输出。

#### *.*.*.* RNN的局限性

虽然RNN在理论上具有处理序列数据的能力,但它在实践中存在着几个问题:

- 梯度消失与梯度爆炸:RNN的长序列训练中,梯度可能迅速衰减到消失,或者爆炸,导致难以学习长依赖关系。

- 计算效率低下:RNN由于其循环结构,无法利用现代GPU并行计算的优势。

### 5.1.2 Transformer模型与BERT

为了克服RNN的局限性,Google在2017年提出了Transformer模型,它完全基于注意力机制,摒弃了传统的循环结构,使得处理长序列时更为高效,并且能更好地捕捉长距离依赖。BERT(Bidirectional Encoder Representations from Transformers)基于Transformer模型,并进一步使用掩码语言模型(Masked Language Model, MLM)来预训练模型,预训练完成后,BERT可以用于各种下游NLP任务。

#### *.*.*.* Transformer模型的架构

Transformer模型主要由编码器(Encoder)和解码器(Decoder)组成,每个编码器和解码器都由若干个相同的层构成。每个层包含两个子层:一个多头自注意力机制(Multi-Head Attention)和一个简单的全连接前馈网络(Feed-Forward Neural Network)。

#### *.*.*.* BERT模型的结构与应用

BERT模型预训练时使用了两种策略:

- 掩码语言模型(MLM):随机遮蔽输入序列中的部分词汇,然后让模型预测这些遮蔽的词。

- 下一句预测(NSP):判断两个句子是否在原始文档中相邻。

预训练完成的BERT模型可直接用于下游任务,如情感分析、问答系统等,通过少量的监督数据和微调(Fine-tuning)即可取得非常好的效果。

```python

# BERT的简单使用示例代码

from transformers import BertTokenizer, TFBertForSequenceClassification

import tensorflow as tf

# 加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = TFBertForSequenceClassification.from_pretrained('bert-base-uncased')

# 编码输入文本

inputs = tokenizer.encode_plus(

'Here is some text to encode',

add_special_tokens=True,

return_tensors='tf',

return_token_type_ids=True,

return_attention_mask=True,

max_length=32,

pad_to_max_length=True,

truncation=True

)

# 基于输入进行预测

outputs = model(inputs)

```

代码解读:

- 首先,使用`BertTokenizer`对输入文本进行编码。

- 然后,加载预训练的`TFBertForSequenceClassification`模型。

- 将编码后的输入数据传递给BERT模型以获取输出结果。

BERT模型的参数说明:

- `bert-base-uncased`:指的是基础版本的BERT模型,不含区分大小写。

- `TFBertForSequenceClassification`:这是一个用于序列分类任务的BERT版本,例如情感分析。

### 5.1.3 代码块与逻辑分析

BERT模型的代码块展示了如何使用预训练模型进行文本分类任务。首先,通过BERT的分词器对文本进行编码,包括添加特殊标记、创建张量、填充到最大长度等步骤,以符合模型输入的要求。接着,将编码后的数据输入BERT模型进行处理。该代码块演示了BERT模型在实际NLP任务中的应用方式,简单、高效。

# 6. NLP项目的实战演练

## 6.1 实战项目规划与需求分析

在开始实战演练之前,我们需要清晰地定义项目的目标和范围,并进行详尽的需求分析,最终选择合适的技术方案来实现目标。这一过程是整个NLP项目成功的关键所在。

### 6.1.1 项目目标与范围定义

首先,我们需要明确项目的业务目标,例如,是否要构建一个能够自动回答客户查询的聊天机器人,或者是要开发一个新闻文章情感分析的系统。一旦确定了业务目标,接下来就要划定项目的范围,包括功能需求、数据范围、性能指标等。

举个例子,一个情感分析项目的范围可能包括:

- 输入:用户评论文本

- 处理:自动分析文本的情感倾向(正面或负面)

- 输出:情感分析结果,并赋予一定的置信度分数

### 6.1.2 需求分析与技术选型

在明确了项目目标和范围后,我们需要进行需求分析,确定项目需要哪些功能。如对于文本分类的需求,可能需要以下功能:

- 文本预处理,如清洗、分词等

- 特征提取,如TF-IDF、Word2Vec等

- 模型训练,如SVM、神经网络等

接下来是技术选型,根据需求分析选择合适的技术栈。对于Python环境,可以选择支持NLP的库如NLTK、Spacy、Transformers等。深度学习框架可以选择TensorFlow或PyTorch。

## 6.2 数据处理与模型训练

在定义了项目的目标和范围,并完成了技术选型后,接下来是具体的数据处理和模型训练。

### 6.2.1 数据增强与特征工程

数据是NLP项目成功的关键。在实战中,原始数据往往需要经过数据增强和特征工程来提高模型的准确性和鲁棒性。数据增强可以通过回译、同义词替换等手段来实现,特征工程则可能包括词嵌入的生成和特征选择。

### 6.2.2 模型选择与超参数调优

在模型选择上,除了传统的机器学习模型,深度学习模型如CNN、RNN、LSTM、Transformer和BERT等提供了更丰富的选项。模型的选择需要基于项目需求和数据集的特性来定。

超参数调优是优化模型性能的重要步骤。通过网格搜索(Grid Search)、随机搜索(Random Search)或贝叶斯优化方法,可以找到最佳的超参数组合。调优过程通常需要多次实验,并使用交叉验证来评估模型性能。

## 6.3 项目部署与持续优化

NLP项目一旦完成开发和测试,就需要部署到生产环境中。同时,为了保持模型性能和适应数据的变化,项目还需要持续的优化。

### 6.3.1 模型部署的方法

模型部署的方法多种多样,可以使用云服务如AWS Sagemaker、Azure Machine Learning,或者自建服务器使用Docker容器化部署。此外,还有轻量级的部署方式,如将模型转换为ONNX格式,使用ONNX Runtime进行部署。

### 6.3.2 持续学习与模型迭代

模型上线后,需要对模型进行持续的监控和评估。可以通过收集反馈数据,定期重新训练模型以适应新的数据分布。此外,使用在线学习方法可以在不影响在线服务的情况下,逐步更新模型参数。

## 实例分析

假设我们要构建一个产品评论的情感分析系统,我们的步骤可能如下:

1. **项目规划**:目标是自动化地分析产品评论并判断情感倾向(正面或负面)。

2. **需求分析**:需要实现文本预处理、特征提取、模型训练与评估。

3. **技术选型**:采用Spacy进行文本预处理,使用BERT进行特征提取和模型训练。

4. **数据处理**:使用回译增强数据集,采用BERT生成词嵌入。

5. **模型训练**:选择合适的数据集进行训练,并通过交叉验证调优超参数。

6. **部署与优化**:将训练好的模型部署到服务器,并通过收集新数据持续优化模型。

实战演练的过程中,我们可能遇到各种挑战,如数据质量控制、模型训练效率、实时性能优化等。这些都需要根据具体情况进行具体分析,并采取相应的策略来解决。

0

0