Apache Spark快速入门:从原理到实践的完整路径

发布时间: 2024-09-08 02:06:18 阅读量: 27 订阅数: 24

# 1. Apache Spark的简介与核心概念

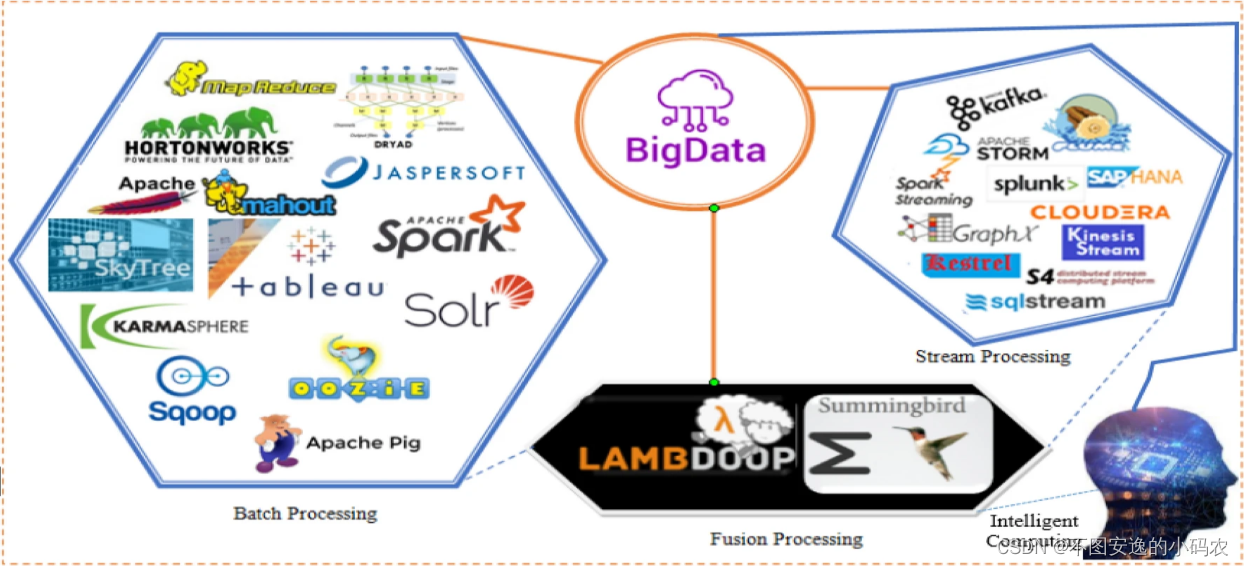

Apache Spark是一个开源的分布式计算系统,它提供了一个快速、通用、可扩展的计算平台。与传统的基于磁盘的处理系统不同,Spark以内存计算为主,这使得它在处理大规模数据集时,能够提供比Hadoop MapReduce快100倍的性能。Spark的核心概念之一是弹性分布式数据集(RDD),它是一个容错的、并行操作的数据集合,可以在集群中分布执行。

在这一章中,我们将介绍Spark的基本概念,包括它的工作原理,以及为什么它在处理大数据任务时,比传统的处理模型有更明显的优势。此外,我们将探讨Spark的主要功能,如何在不同场景下使用Spark,以及如何利用其高级API来简化数据处理任务。通过对Spark核心概念的深入了解,读者将能够掌握如何利用这个强大的框架来应对复杂的计算挑战。

## 1.1 Spark的背景与优势

Spark自2009年诞生于加州大学伯克利分校的AMPLab,是为了解决MapReduce在迭代算法和交互式数据挖掘方面的局限性而开发的。它的优势主要体现在以下几个方面:

- **内存计算**:Spark存储数据在内存中,减少磁盘I/O,从而加速数据处理。

- **易用性**:Spark提供了DataFrame和Dataset API,让数据处理更加直观和容易。

- **多语言支持**:支持Scala、Java、Python和R等多种编程语言。

- **扩展性**:Spark可以运行在单个节点上,也可以无缝扩展到大规模的集群上。

- **丰富的API**:除了基础的RDD API外,还提供了SQL、MLlib(机器学习)和Streaming等高级API。

## 1.2 Spark的应用场景

Apache Spark广泛应用于大数据处理的各种场景,包括但不限于:

- **ETL处理**:批处理大量数据,转换数据格式,以适应不同的数据仓库或数据库系统。

- **数据挖掘与分析**:对大规模数据集进行复杂的数据分析。

- **机器学习**:运行复杂的算法,例如协同过滤、聚类分析等。

- **流数据处理**:处理实时数据流,例如网站监控、日志分析等。

了解了Spark的背景、优势及应用场景后,下一章我们将深入探讨Spark的架构和主要组件,以及如何在数据处理模型中使用这些组件。

# 2. Apache Spark的架构和组件解析

### 2.1 Spark的基本架构

#### 2.1.1 Spark运行时环境的角色

Apache Spark运行时环境是由多个组件组成的复杂系统。在Spark的核心运行时环境中,主要包含的角色有:Driver程序、Executor进程以及Cluster Manager。

Driver程序是运行Spark应用程序的main()函数,并创建SparkContext。它负责向集群管理器请求资源,并进行作业的调度,将应用程序转换为一系列的阶段,然后分配给Executor执行。驱动程序还处理用户提交的代码和运算,并将任务分配给集群执行。

Executor则是实际运行应用程序的任务,运行在工作节点上。每个应用都有自己的Executors,它们在应用程序运行期间一直运行,并负责执行任务并返回结果给驱动程序。它们也负责将数据存储在内存或磁盘上,通过它们的线程池来提供并行性。

Cluster Manager,顾名思义,是集群资源的管理者。它可以是Standalone,YARN,Mesos或者Kubernetes等,负责资源的分配和管理。它负责在集群的工作节点上启动Executor,并在应用程序运行期间持续地监控这些资源。

#### 2.1.2 核心组件介绍:Driver, Executor, Cluster Manager

- **Driver**: Spark中的Driver是运行用户程序的main()函数的地方,负责作业的生命周期管理。Driver会将用户程序转换为一系列的阶段(Stages)和任务(Tasks),并且根据这些阶段和任务去请求Cluster Manager分配资源。

- **Executor**: 执行应用程序的任务,保存应用的数据。每个Executor负责在一个独立的进程中运行任务,并且提供多线程执行环境。它会通过内存和磁盘来存储数据,这可以显著加速任务的执行。

- **Cluster Manager**: Spark的运行时环境需要集群管理器来管理资源。它负责启动和终止各个节点上的Executor进程,并根据应用的需求动态地分配资源。不同的Cluster Manager有不同的调度策略和资源分配算法。

在不同的部署模式下,Driver和Executor在集群中的运行位置可能会有所不同,但它们的基本职责是一致的。理解这些组件的职责和相互作用对于优化Spark应用程序的执行至关重要。

### 2.2 Spark的数据处理模型

#### 2.2.1 RDD的定义与特性

弹性分布式数据集(RDD)是Spark中用于处理并行操作的基本抽象。一个RDD是一个分布式对象集合,它允许用户在大数据集上执行并行操作。以下是RDD的主要特性:

- **不可变性**:一旦创建,RDD的状态不能改变。所有的转换操作都会返回一个新的RDD。

- **分区**:RDD被划分为多个分区,每个分区可以并行计算。

- **依赖关系**:RDD之间的转换形成了一种依赖关系图,Spark可以据此构建出计算的执行计划。

- **分区策略**:每个分区可以分布在集群的不同节点上,Spark会根据数据的位置和集群的资源来确定分区策略。

- **血统**:RDD具有一个“血统”,记录了创建这个RDD的转换操作序列。如果数据丢失,可以通过血统重新计算,而不是进行恢复。

#### 2.2.2 RDD的转换与行动操作

RDD支持两种类型的操作:转换(Transformations)和行动(Actions)。

- **转换**:这类操作基于现有的RDD创建一个新的RDD。转换是延迟执行的,也就是说,它们不会立即执行,只有在行动操作被调用时,Spark才会开始计算。常见的转换操作包括map(), filter(), reduceByKey()等。

- **行动**:这类操作会触发计算并返回结果。行动操作立即执行,并且通常会返回一个值或者将结果写入外部存储系统。常见的行动操作包括collect(), reduce(), take()等。

转换和行动的配合使用,使得Spark的数据处理模型既有弹性又能实现高效的并行计算。在编程实践中,用户可以基于这些基础操作构建复杂的数据处理流程。

### 2.3 Spark的内存计算机制

#### 2.3.1 基于内存计算的优势与挑战

Apache Spark的主要优势之一是其内存计算能力,这意味着数据处理和分析过程大部分在内存中进行,这显著提高了速度和效率。内存计算的优势包括:

- **加速数据处理速度**:由于访问内存的速度远高于磁盘,所以通过内存计算,可以显著提高数据处理的速度。

- **减少磁盘I/O**:将数据保存在内存中可以减少对磁盘的访问次数,降低了磁盘I/O的消耗。

- **提高系统的吞吐量**:内存计算可以处理更大的数据集,并行处理能力进一步提升了系统的整体吞吐量。

当然,基于内存计算也带来了一些挑战:

- **内存管理**:需要合理地管理内存资源,避免内存溢出,这包括对内存使用进行预测和监控,以及采用数据序列化等技术。

- **数据容错**:需要考虑数据备份和恢复机制,以防止节点故障导致的数据丢失。

- **硬件成本**:相比于磁盘存储,内存的成本更高,因此需要权衡成本和性能。

#### 2.3.2 内存管理与持久化策略

为了有效管理内存并优化性能,Spark提供了内存管理和持久化机制。以下是内存管理中的一些关键概念:

- **持久化(也称为缓存)**:将RDD保存在内存中,以便后续操作可以重用。持久化可以通过调用RDD的cache()或persist()方法来实现。

- **存储级别**:Spark提供了多种存储级别,允许用户根据需要选择不同的内存和磁盘策略。例如,仅内存、内存和磁盘、磁盘、内存中序列化等。

- **内存回收**:当集群中的内存不足时,Spark会自动回收那些最少使用过的数据块,释放内存。

持久化策略的选择对Spark作业性能至关重要。例如,如果某个任务需要多次遍历相同的数据集,那么将该RDD持久化在内存中将大有益处。但是,如果数据集非常大而内存资源有限,则需要选择合适的存储级别,平衡内存使用和性能。

### 2.3.3 小结

本节深入介绍了Spark的基本架构和核心组件,从运行时环境中的Driver、Executor和Cluster Manager角色,到数据处理模型中RDD的定义、特性、转换和行动操作,最后探讨了内存计算机制的优势与挑战以及内存管理与持久化策略。

了解这些组件和机制对于掌握Apache Spark的运行原理至关重要。它们是理解和优化Spark应用程序性能的基础,无论是对于新入门的开发者,还是对于经验丰富的IT从业者,这些知识都是不可或缺的。随着后续章节的深入,我们会探讨如何在Spark编程实践中应用这些知识,并且进一步深入了解性能调优和故障排除方法。

# 3. ```

# 第三章:Apache Spark

```

0

0