【网络拥塞控制】

发布时间: 2025-01-05 04:33:47 阅读量: 12 订阅数: 4

网络拥塞控制方法与理论

# 摘要

网络拥塞控制是确保数据传输效率和网络稳定性的重要技术,本文对拥塞控制进行了全面概述,并从理论和协议两个角度进行深入探讨。首先概述了拥塞控制的基本概念,包括拥塞发生的条件及与流量控制的区别。其次,详细分析了几种著名的拥塞避免算法,如慢开始、拥塞避免、快重传和快恢复算法,并探讨了相关数学模型。在协议方面,本文详解了TCP拥塞控制协议及其它协议的拥塞控制机制,包括UDP、QUIC以及无线网络策略。接着,分析了拥塞控制在企业和云服务领域的应用,并讨论了策略优化与当前面临的挑战。最后,展望了人工智能在网络拥塞控制中的应用前景以及未来的研究方向。本研究旨在为网络拥塞控制的优化提供参考,为相关技术的创新提供理论支撑。

# 关键字

拥塞控制;网络拥塞;TCP;流量控制;AI;网络模型

参考资源链接:[计算机网络课后答案解析:分组交换与通信方式对比](https://wenku.csdn.net/doc/4ks8wos7xh?spm=1055.2635.3001.10343)

# 1. 网络拥塞控制概述

随着互联网技术的飞速发展,网络拥塞成为影响网络性能的关键问题之一。网络拥塞控制,作为确保网络高效、稳定运行的关键技术,不仅涉及到理论研究,更是网络工程师们在实际工作中必须面对和解决的挑战。

## 1.1 网络拥塞的现状与挑战

网络拥塞通常发生在网络中数据传输量超过网络承载能力时,表现为数据包的丢失和延迟的增加,严重时会导致网络服务质量下降,影响用户体验。因此,如何有效地管理和控制网络拥塞成为了每个网络工程师必须考虑的问题。

## 1.2 拥塞控制的必要性

拥塞控制的目的在于优化网络资源的使用,保证数据传输的公平性和效率。它能够帮助网络系统在面对网络负载不断增加的情况下,依然维持良好的性能,这对于构建高效可靠的通信网络至关重要。

接下来的章节,我们将深入探讨拥塞控制的理论基础,并分析其在不同网络协议中的具体应用,以及面临的新挑战和未来发展方向。

# 2. 拥塞控制的理论基础

## 2.1 拥塞发生的条件

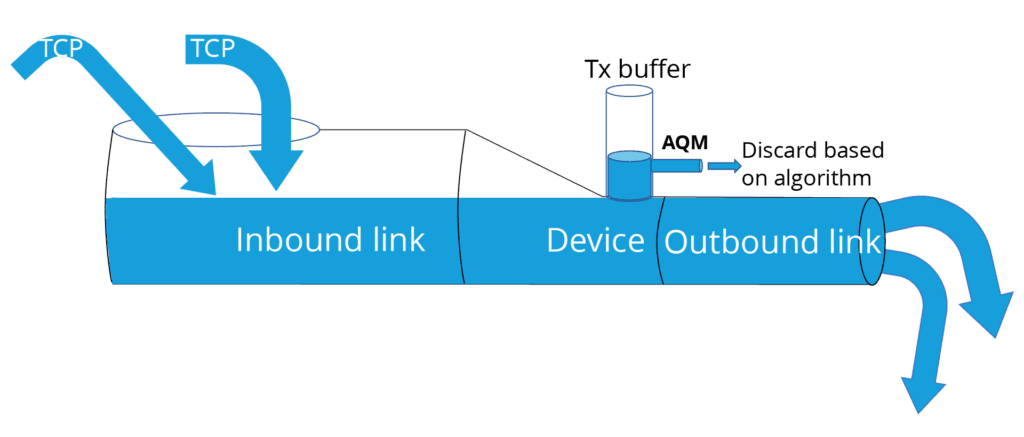

拥塞是计算机网络中非常常见的问题,它发生在网络资源不足以处理当前的网络流量时。当网络中的节点(如路由器、交换机)或链路的负载超过其处理能力时,就可能发生拥塞。拥塞可能导致数据包的延迟增加、丢包、服务质量降低,甚至导致网络的完全瘫痪。

拥塞发生的条件通常涉及以下几个方面:

- 高流量负载:网络中流动的数据量超过网络设备或链路的处理和转发能力。

- 队列溢出:路由器和交换机中的缓冲区不足以存储等待处理的数据包。

- 不良的路由选择:由于错误的路由选择或路径选择导致的网络拥塞。

- 协议交互问题:网络协议交互不当,例如,不合适的重传机制和窗口调整策略。

为了更好地理解拥塞,可以类比现实生活中交通堵塞的情况。一条道路如果车流量过大,超过了道路的最大承载量,那么就会发生交通堵塞。网络中的拥塞也是如此,当数据包的传输量超过了网络设备或者链路的最大处理能力时,就会出现拥塞。

## 2.2 拥塞避免算法原理

### 2.2.1 慢开始算法

慢开始算法是TCP拥塞控制中的一个重要组成部分,它是一种避免在开始传输时就发生拥塞的策略。其基本思想是在网络传输的初始阶段,先以较小的拥塞窗口发送数据,然后根据网络的响应情况逐渐增加窗口大小,即指数性增长。

慢开始算法的核心步骤如下:

1. 连接建立时,将拥塞窗口(cwnd)初始化为一个最大报文段的 MSS(Maximum Segment Size)。

2. 每收到一个 ACK,cwnd 就加一 MSS,即指数增长。

3. 当 cwnd 达到慢开始门限(ssthresh)时,将进入拥塞避免阶段。

### 2.2.2 拥塞避免算法

拥塞避免算法的目的是控制网络拥塞的持续增长,确保网络的稳定运行。其基本思想是当拥塞窗口达到一个阈值后,不再以指数方式增长,而是线性增加。

拥塞避免算法的关键步骤包括:

1. 当 cwnd 达到慢开始门限(ssthresh)时,转变为线性增长,即每经过一个 RTT,cwnd 增加一个 MSS。

2. 如果出现丢包事件,ssthresh 将被设置为发生丢包时 cwnd 的一半,然后进入慢开始阶段。

### 2.2.3 快重传和快恢复算法

快重传和快恢复算法是对慢开始和拥塞避免算法的优化,它们能够在检测到丢包事件后尽快恢复正常的传输速率,减少网络拥塞带来的影响。

快重传算法的工作机制为:

1. 当发送端连续收到三个重复的ACK时,认为该数据包已经被对方接收,但存在丢包情况。

2. 立即重传丢失的数据包,而不用等待重传计时器超时。

快恢复算法的步骤则包括:

1. 当触发快重传时,ssthresh 设置为发生丢包时 cwnd 的一半,cwnd 设置为 ssthresh 的值。

2. 进入快速恢复阶段,在此阶段,每收到一个重复的ACK,cwnd 增加一个 MSS。

3. 当收到新的ACK时,退出快速恢复,将cwnd 设置为 ssthresh 的值,并进入拥塞避免阶段。

## 2.3 拥塞控制模型

### 2.3.1 网络模型与拥塞窗口

拥塞窗口(Congestion Window,cwnd)是TCP拥塞控制中的一个核心概念,它规定了发送方在未收到确认之前可以发送多少数据。拥塞窗口的变化反映了网络中拥塞状态的变化,是拥塞控制机制调整发送速率的依据。

拥塞窗口的管理依赖于网络模型,这个模型假定网络中的拥塞是由数据包的丢失所指示的。当发生丢包时,网络就被认为进入了拥塞状态,拥塞窗口需要减小以减轻网络压力。而当网络处于空闲状态时,拥塞窗口则可以逐渐增加,以提高传输效率。

### 2.3.2 拥塞控制的数学模型和分析

在数学模型中,拥塞控制算法通常通过一系列的方程来描述。例如,可以使用差分方程来模拟拥塞窗口的变化:

```

cwnd_{n+1} = cwnd_n + α * MSS / cwnd_n

```

当发生丢包时:

```

cwnd = β * MSS

ssthresh = γ * cwnd

```

这里的 α、β 和 γ 是算法参数,控制着拥塞窗口的变化速率。α 控制增加的速率,β 和 γ 则是减小的系数。拥塞控制的数学模型通常考虑网络的延迟带宽积,RTT(往返时间),以及丢包率等多种因素。

为了更深入地理解拥塞控制的数学模型,我们可以构造一个简单的场景。假设在一条网络中,其延迟带宽积是100KB,那么我们设定 MSS 为10KB,初始的拥塞窗口可以设为1个MSS。

若使用慢开始算法,在没有丢包的情况下,每经过一个 RTT,cwnd 将变为之前的两倍。经过5个 RTT 后,cwnd 将达到 320KB,此时若发生丢包,则触发快重传和快恢复,ssthresh 会设为 160KB,然后拥塞窗口逐步回到 160KB,并重新开始线性增长。

通过上述模型分析,我们可以看到,在拥塞控制中,如何准确地估计和调整拥塞窗口至关重要,这直接影响到网络的传输效率和稳定性。

以上章节内容,我们详细介绍了拥塞控制的基本概念、拥塞避免算法的原理以及拥塞控制的数学模型分析。这些理论基础对于理解后续章节中的拥塞控制协议和实际应用具有重要的意义。

# 3. 拥塞控制协议详解

在这一章节中,我们将深入探讨不同协议所采用的拥塞控制机制。了解这些协议背后的原理和方法,对于设计和优化网络通信是至关重要的。我们将从TCP拥塞控制协议开始,逐步讨论其他协议的拥塞控制机制,以及它们如何适应不同的网络环境和需求。

## 3.1 TCP拥塞控制协议

TCP(传输控制协议)是最广泛使用的传输层协议之一,其拥塞控制机制是网络拥塞管理的核心。在TCP协议中,拥塞控制是通过一系列算法来实现的,这些算法共同工作以确保网络资源的合理使用。

### 3.1.1 TCP Reno

TCP Reno是TCP拥塞控制的经典算法,它通过四个主要阶段实现对网络拥塞的控制:慢开始(Slow Start)、拥塞避免(Congestion Avoidance)、快重传(Fast Retransmit)和快恢复(Fast Recovery)。

在慢开始阶段,TCP连接刚建立时,发送方会从一个较小的拥塞窗口(cwnd)开始,随着每个传输轮次(RTT)的成功,cwnd成倍增长。这种指数增长方式可以快速探测网络的可用带宽。

当cwnd达到慢开始阈值(ssthresh)时,进入拥塞避免阶段,此时cwnd线性增长,而不是指数增长,以避免网络拥塞。

快重传算法用于快速响应网络中的丢包事件,它允许接收方在收到足够多重复ACK时立即告知发送方重传丢失的包,而不是等待超时。

快恢复阶段在快重传之后触发,它允许发送方在经历部分丢包后快速恢复到较高的发送速率,而不需要重新从慢开始阶段开始。

### 3.1.2 TCP NewReno

TCP NewReno是对Reno算法的一个改进,它解决了Reno在遇到多个数据包丢失时的性能问题。在NewReno中,发送方可以区分是单个还是多个数据包丢失,并且在快重传后只对那些未确认的数据包进行重传。

### 3.1.3 TCP Vegas和TCP BBR

TCP Vegas是一个早期的拥塞控制算法,它使用RTT来预测网络的拥塞情况,并据此调整拥塞窗口。Vegas试图维持网络中的基线传输速率,当RTT增加时减小cwnd,当RTT减少时增加cwnd。

更现代的拥塞控制算法如TCP BBR(Bottleneck Bandwidth and RTT)考虑了网络的实际容量和传输延迟。BBR不仅仅基于丢包来判断拥塞,而是试图充分利用带宽同时控制延迟。BBR在现代网络环境中表现出了比传统算法更好的性能。

## 3.2 其他协议的拥塞控制机制

除了TCP之外,还有许多其他的协议和机制在不同的网络场景中使用,它们的拥塞控制方法往往是为了适应特定的需求或优化性能。

### 3.2.1 UDP的拥塞控制

与TCP不同,UDP(用户数据报协议)是一个无连接的协议,本身不提供拥塞控制机制。然而,在某些特定的应用场合,例如实时视频传输,需要实现拥塞控制。因此,一些应用层协议如RTP(实时传输协议)在应用层实现了拥塞控制机制。

### 3.2.2 QUIC协议的拥塞控制

QUIC(快速互联网连接)是一个基于UDP的多路复用和安全传输协议,最初由谷歌提出,旨在提供更快的连接建立时间和更低的延迟。QUIC的拥塞控制机制类似于TCP BBR,但也在持续改进以适应其多路复用的特点。

### 3.2.3 常见的无线网络拥塞控制策略

无线网络由于其高丢包率和变化无常的带宽,需要特别的拥塞控制策略。例如,无线自组织网络(MANETs)和蜂窝网络都采用了诸如跨层设计和基于速率的拥塞控制等方法来应对这种挑战。

#### 表格:常见无线网络拥塞控制策略比较

| 策略 | 描述 | 优点 | 缺点 |

| --- | --- | --- | --- |

| 跨层设计 | 在不同网络层之间共享信息来优化拥塞控制 | 提高网络性能 | 实现复杂度高 |

| 基于速率 | 调整发送速率来适应网络条件 | 反应迅速 | 可能导致带宽浪费 |

| 基于距离 | 根据节点间距离调整传输策略 | 减少干扰 | 距离估算可能不准确 |

| 能量感知 | 考虑节点的剩余能量来避免拥塞 | 延长网络寿命 | 能量估算可能不精确 |

为了更好地理解这些拥塞控制机制如何在实际场景中应用,我们接下来将分析拥塞控制在企业网络和云服务中的具体应用,并探讨拥塞控制策略的优化与面临的挑战。

# 4. 拥塞控制的实际应用

在深入探讨拥塞控制的理论基础和协议机制后,本章节将重点关注拥塞控制的实际应用场景。具体而言,它将分析企业网络、云服务以及拥塞控制策略优化与挑战。

## 拥塞控制在企业网络中的应用

企业网络是信息流动的密集场所,网络拥塞可能会对业务连续性造成严重影响。因此,在企业环境中有效地应用拥塞控制至关重要。

### 企业网络拥塞检测与预防

企业网络拥塞的检测和预防要求具备快速准确地识别网络状况的能力。拥塞检测机制通常包括基于阈值的检测和基于统计的检测两种方式。

1. **基于阈值的检测**:通过预设网络负载的上界和下界,一旦实际负载超过上限或低于下限,就会触发拥塞控制措施。

- 阈值的设定应当依据实际网络容量和业务需求灵活调整。

- 对于有实时性需求的业务,可以设定更高的阈值以避免误触发。

2. **基于统计的检测**:利用算法对网络流量的长期统计行为进行分析,预测和识别潜在的拥塞状况。

- 此类方法如TCP Vegas使用了测量往返时间(RTT)的变化来评估网络状态。

- 需要注意的是,统计方法可能对网络的瞬时波动不敏感,适用于缓慢变化的拥塞状况。

拥塞预防则需要综合运用各种资源调度和流量控制手段:

- **资源调度**:合理分配带宽资源,采用优先级调度确保关键业务的流量优先传输。

- **流量控制**:在不同网络层面上实施流量整形和流量规约,例如在边界路由器实施WRED(Weighted Random Early Detection)减少拥塞。

### 负载均衡与拥塞控制

负载均衡是企业网络拥塞控制的一个重要环节。通过合理的负载分配,可以有效分散流量负载,减少单点压力。

- **网络层负载均衡**:通过将流量分散到多个物理或虚拟服务器上,减少单台服务器的处理负担。

- **应用层负载均衡**:根据应用需求,将请求分散到不同的服务实例上。

在实施负载均衡时,通常会面临以下挑战:

- **状态同步问题**:在多服务器环境中,确保所有服务器具有相同的应用状态视图是困难的。

- **分布式协调问题**:在负载均衡决策时,需要高效的协调机制,以避免资源竞争和冲突。

为解决这些问题,需要采用先进的协调机制,例如基于消息队列或分布式锁的解决方案。

## 拥塞控制在云服务中的应用

云计算环境中,大量租户共享基础设施,导致网络拥塞控制面临新的挑战。如何保证多租户环境下的网络服务质量和公平性是一个重要课题。

### 云服务中的流量管理策略

流量管理策略的目的是确保在多租户共享的网络环境中,各租户的服务质量得到满足。

- **服务等级协议(SLA)**:云服务提供商根据SLA协议,为不同租户提供不同级别的网络服务。

- **网络功能虚拟化(NFV)**:通过软件定义网络(SDN)和网络功能虚拟化技术,实现网络资源的灵活分配和高效利用。

### 拥塞控制在多租户环境下的实施

在多租户环境中实施拥塞控制,需要考虑租户之间的资源隔离和公平性问题。

- **资源隔离**:确保不同租户的流量不会相互干扰,可以使用虚拟局域网(VLAN)或者隧道技术实现。

- **公平性保障**:在资源有限的情况下,确保租户流量按照约定的比例分配,可以采取如权重公平队列(WFQ)等技术。

多租户环境下的拥塞控制还需要适应动态变化的网络环境:

- **弹性网络资源调整**:根据实时流量情况动态调整资源分配,采用如自动伸缩组(Auto Scaling)等技术。

- **基于策略的控制**:预先定义拥塞处理策略,根据不同的业务需求和网络状况,自动触发拥塞控制措施。

## 拥塞控制策略的优化与挑战

随着网络技术的发展和业务需求的变化,拥塞控制策略也在不断地优化。然而,新的技术和服务模式带来了新的挑战。

### 现有策略的性能优化

现有拥塞控制策略的性能优化,主要关注在以下几个方面:

- **算法优化**:调整拥塞避免和检测算法参数,提高算法反应速度和准确率。

- **流量调度优化**:优化调度算法,提升流量分配的效率和公平性。

- **网络虚拟化技术**:利用网络虚拟化技术实现资源的更细粒度管理和分配,提高资源利用率。

### 面临的新兴挑战与解决方案

随着网络规模的扩大和业务需求的多样化,拥塞控制面临如下新兴挑战:

- **大规模网络拥塞控制**:如何在大规模网络中快速准确地识别和处理拥塞成为问题。

- **新型业务的适应性**:新型业务如IoT、边缘计算等对实时性和可靠性有更高要求,传统的拥塞控制策略可能不适用。

针对这些挑战,解决方案包括:

- **分布式拥塞控制**:通过分布式算法,将拥塞控制分散到网络的各个节点,提高控制效率。

- **机器学习辅助的拥塞预测**:采用机器学习方法,对网络流量进行预测,提前做出拥塞控制决策。

## 代码块和mermaid流程图展示

为了更好地说明拥塞控制的优化策略,以下展示一段使用机器学习方法进行流量预测的伪代码示例,它反映了新兴挑战的解决方案之一:

```python

import numpy as np

from sklearn.linear_model import LinearRegression

# 假设有一组流量历史数据

traffic_data = np.array([

[1, 10], [2, 20], [3, 30], [4, 40], [5, 50], # 时间点和流量值

# ...

])

# 使用时间点作为特征,流量值作为目标变量进行训练

model = LinearRegression()

model.fit(traffic_data[:, 0].reshape(-1, 1), traffic_data[:, 1])

# 对未来时间点的流量进行预测

future_time = np.array([[6], [7], [8]])

predicted_traffic = model.predict(future_time)

print(predicted_traffic)

```

以上代码展示了如何使用线性回归模型预测未来流量。参数说明和执行逻辑已在代码注释中给出。

## 表格展示

为了更好地说明多租户环境下的拥塞控制实施,以下为一个示例表格,描述了不同租户的网络服务和拥塞控制策略的对应关系:

| 租户名称 | 所需带宽 | 服务优先级 | 拥塞控制策略 |

|---------|---------|------------|--------------|

| 租户A | 1Gbps | 高 | AQM(自适应队列管理) |

| 租户B | 500Mbps | 中 | WFQ(权重公平队列) |

| 租户C | 250Mbps | 低 | RED(随机早期检测) |

通过表格可以清晰看到各租户对网络资源的需求和适用的拥塞控制策略。

## 优化措施的逻辑分析

实际应用中,拥塞控制的优化措施需要结合特定场景进行分析。例如,在企业网络中,拥塞控制策略可能需要与安全策略同步,防止恶意流量造成的网络拥塞。优化措施通常包括:

- **应用层限速**:通过控制应用程序的请求频率,从源头避免流量激增。

- **队列管理改进**:采用先进的队列管理算法,如CoDel(控制延迟的队列)或PIE(比例积分控制器增强型队列),减少排队延迟。

- **路由优化**:动态调整路由决策,避开拥塞点,均衡网络负载。

在云服务环境中,优化措施可能更侧重于网络资源的虚拟化和动态调整,例如通过SDN技术实现灵活的流量管理和快速响应。

拥塞控制的实际应用是网络技术发展的重要组成部分,随着技术进步和业务演进,拥塞控制策略也必将不断发展和优化。本章节通过分析企业网络和云服务中的应用,以及优化策略的实施,展示了拥塞控制在实际中的丰富应用和面临的挑战,为后续的研究和实践提供了一个参考框架。

# 5. 未来网络拥塞控制的方向

随着人工智能技术的迅速发展,其在许多领域的应用已经变得越来越广泛。在拥塞控制这一领域,人工智能的引入正开启一场全新的技术革新。在本章节中,我们将探索人工智能在拥塞控制中的应用前景,同时也会探讨网络拥塞控制当前的研究动向和未来可能的发展趋势。

## 5.1 人工智能在拥塞控制中的应用前景

人工智能技术,特别是机器学习和深度学习,在模式识别、预测分析等领域显示出了强大的能力。在拥塞控制方面,人工智能的应用前景主要体现在以下几个方面。

### 5.1.1 基于AI的拥塞预测模型

传统拥塞控制模型依赖于预设的规则和算法,往往难以准确预测网络状态的变化,尤其在复杂和动态变化的网络环境中。基于AI的拥塞预测模型能够处理大量历史数据,通过学习网络行为的模式,实时预测和判断网络状态,从而提前做出反应。

例如,通过使用深度学习中的循环神经网络(RNN)或长短期记忆网络(LSTM),可以对网络流量进行时间序列分析,从而对网络拥塞进行预测。这些模型可以训练并优化以适应特定网络环境的行为,并能实时更新以反映最新的网络状况。

```python

# 示例代码:使用LSTM进行网络流量预测

from keras.models import Sequential

from keras.layers import LSTM, Dense

# 假设已经有了预处理好的网络流量数据,格式为samples和targets

samples, targets = ...

# 构建LSTM模型

model = Sequential()

model.add(LSTM(50, activation='relu', input_shape=(samples.shape[1], samples.shape[2])))

model.add(Dense(1))

model.compile(optimizer='adam', loss='mse')

# 训练模型

model.fit(samples, targets, epochs=200, batch_size=10)

# 使用模型进行预测

predictions = model.predict(samples)

```

### 5.1.2 自适应拥塞控制策略

自适应拥塞控制策略是指拥塞控制机制能够根据当前网络状况自动调整参数或行为。利用AI技术,可以根据实时网络状况生成最优的控制策略。例如,可以训练一个深度强化学习模型,该模型通过与环境(网络)的交互来学习如何调整拥塞控制参数,以最大化吞吐量的同时最小化延迟和丢包率。

```mermaid

graph LR

A[环境状态] -->|观察| B[AI控制器]

B -->|决策| C[拥塞控制参数]

C -->|应用| D[网络]

D --> A

```

## 5.2 网络拥塞控制的研究动向

网络拥塞控制的研究动向不仅聚焦于现有协议的优化,还包括对新协议的探索,以及跨层设计的研究等。

### 5.2.1 新协议的探索与实验

随着新型网络技术(如5G、IoT和边缘计算)的发展,现有的拥塞控制协议可能无法满足新网络环境的需求。因此,研究人员正在探索新的拥塞控制协议,这些协议旨在提供更好的性能、可扩展性和自适应性。

例如,基于SDN(软件定义网络)的拥塞控制方案允许在控制层对网络流量进行集中管理,从而更有效地处理拥塞问题。

### 5.2.2 跨层设计与拥塞控制

传统的网络协议栈设计中,每一层都独立工作,各层之间的信息交换有限。跨层设计思想旨在打破这种隔离,使得不同层次的协议能够相互通信和协作。在拥塞控制方面,跨层设计可以实现更灵活、更全面的拥塞管理策略。

例如,可以通过将网络层和传输层的信息进行整合,设计出一种能够同时考虑链路状态和端到端流量特性的拥塞控制算法。

以上讨论展示了拥塞控制领域的未来发展方向,从人工智能的深入应用到新协议的探索以及跨层设计的研究,这些动向预示着网络拥塞控制正朝着更为智能、高效和鲁棒的方向迈进。

0

0