哈工大人工智能实验报告:掌握数据预处理,优化你的机器学习模型

发布时间: 2024-12-25 10:16:46 阅读量: 36 订阅数: 18

哈工大机器学习实验资料.7z

# 摘要

数据预处理作为机器学习流程中的核心步骤,对提高模型性能具有决定性影响。本文首先讨论了数据预处理的重要性,并概述了其在增强模型准确性和泛化能力方面的作用。接着,详细探讨了数据清洗的关键技术,包括缺失值、异常值以及数据一致性的处理方法。进一步,本文介绍了数据标准化和归一化的理论基础,并讨论了其在模型训练中的实际应用。第三章聚焦于数据转换和特征工程,阐述了离散化、二值化、多项式特征和交叉特征的技巧,并提供了特征选择和维度缩减技术如PCA、LDA和t-SNE的方法和实践案例。第四章涵盖了数据集划分与模型评估,包括不同数据集的定义、划分策略、模型评估指标,以及交叉验证和超参数优化的策略。最后一章通过实际应用案例,展示了数据预处理和机器学习模型训练、优化与部署的全流程。通过综合分析,本文提供了全面的指导和最佳实践,以促进数据科学家和工程师在实际应用中更有效地使用数据预处理技术,提升机器学习项目的成功率。

# 关键字

数据预处理;机器学习模型;特征工程;数据清洗;模型评估;超参数优化

参考资源链接:[哈工大人工智能导论实验报告](https://wenku.csdn.net/doc/3b6obtgum1?spm=1055.2635.3001.10343)

# 1. 数据预处理的重要性与机器学习模型性能

在当今的大数据时代,数据预处理在机器学习项目中扮演了至关重要的角色。数据预处理旨在清洗、转换和缩减原始数据集,以形成适合模型训练的高质量输入。为什么数据预处理对机器学习模型的性能如此重要呢?简单来说,机器学习算法需要从数据中学习模式,如果数据存在噪声、偏差、不一致性或者维度过多等问题,将直接影响模型的准确性和泛化能力。

未经过预处理的数据就像未经磨练的钻石,虽然本质优秀但表现不出应有的光芒。预处理步骤确保数据质量和一致性,有助于模型更好地捕捉数据中的关键特征和模式。在这一章节中,我们将详细探讨数据预处理如何影响机器学习模型的性能,并在后续章节深入解析预处理的理论基础和实用技术。让我们开始数据科学之旅,挖掘预处理数据的秘密和力量。

# 2. 数据预处理的理论基础

数据预处理是机器学习项目中不可或缺的步骤,它位于数据收集与模型训练之间,其目的是确保输入模型的数据质量,从而提升最终模型的预测性能。本章将深入探讨数据预处理的基本理论,包括其定义、目的,数据清洗的关键技术,以及标准化与归一化的实用方法。

### 数据预处理的含义

数据预处理是一个涉及多个步骤的复杂过程,旨在将原始数据转换为适合模型训练的格式。在这一过程中,数据的质量和特性将直接影响到机器学习模型的性能和准确性。数据预处理通常包括以下几个核心步骤:

- 数据清洗:识别并处理数据中的错误、缺失值、异常值和不一致问题。

- 数据转换:采用某种特定的数学变换,比如标准化、归一化或离散化,改变原始数据的分布。

- 特征工程:通过创建新特征、选择重要特征和降维等技术,提升数据对模型的表达能力。

- 数据集划分:将数据分为训练集、验证集和测试集,用于模型训练、参数调整和性能评估。

数据预处理在保证数据质量方面发挥了关键作用,因为大多数机器学习算法都对输入数据有着明确的要求,比如需要均值为0和标准差为1的数据分布。

### 数据预处理与模型性能的关系

良好的数据预处理工作对于机器学习模型的成功至关重要。未经处理或处理不当的数据可能导致模型出现各种问题,比如过拟合、欠拟合或收敛速度慢等问题。例如:

- **过拟合**:如果数据中包含噪声或不相关特征,模型可能会学习这些特征,而不是数据的真实分布,从而导致模型在训练集上的表现优于在测试集上。

- **欠拟合**:如果数据经过不当的简化处理,可能会移除对预测任务至关重要的信息,导致模型无法捕捉数据中的复杂关系。

- **收敛速度**:不适当的数据缩放可能影响算法的收敛速度,从而增加训练时间,有时甚至导致算法无法收敛到最优解。

通过有效的数据预处理,我们可以确保数据的质量和一致性,减少噪声,增强模型对数据的理解能力,进而提高预测的准确性。

### 数据清洗的关键技术

在机器学习项目中,数据清洗占据了大量的时间和精力。有效识别和处理数据集中的缺失值、异常值和重复值,对于提升模型性能至关重要。

#### 缺失值处理方法

缺失值是数据集中常见的问题之一,它可能会造成信息损失,影响模型的训练。处理缺失值的方法有很多,包括:

- **删除含有缺失值的记录**:这是一种简单粗暴的方法,适用于数据量巨大且缺失值占比很小的情况。

- **填充缺失值**:使用均值、中位数、众数等统计量填充缺失值。如果数据是时间序列,则可以使用前一个值或后一个值填充。

- **使用模型预测缺失值**:可以使用回归模型等机器学习算法预测缺失值。

选择合适的缺失值处理方法需要根据数据的特性和项目需求决定。下面是使用Python中的pandas库来填充缺失值的示例代码:

```python

import pandas as pd

import numpy as np

# 创建一个示例DataFrame

data = pd.DataFrame({

'A': [1, 2, np.nan, 4],

'B': [5, np.nan, np.nan, 8],

'C': [9, 10, 11, 12]

})

# 使用列均值填充缺失值

data_filled = data.fillna(data.mean())

print(data_filled)

```

以上代码块首先导入了`pandas`库和`numpy`库,然后创建了一个包含缺失值的DataFrame。接下来使用`fillna`函数以列的均值填充了缺失值。

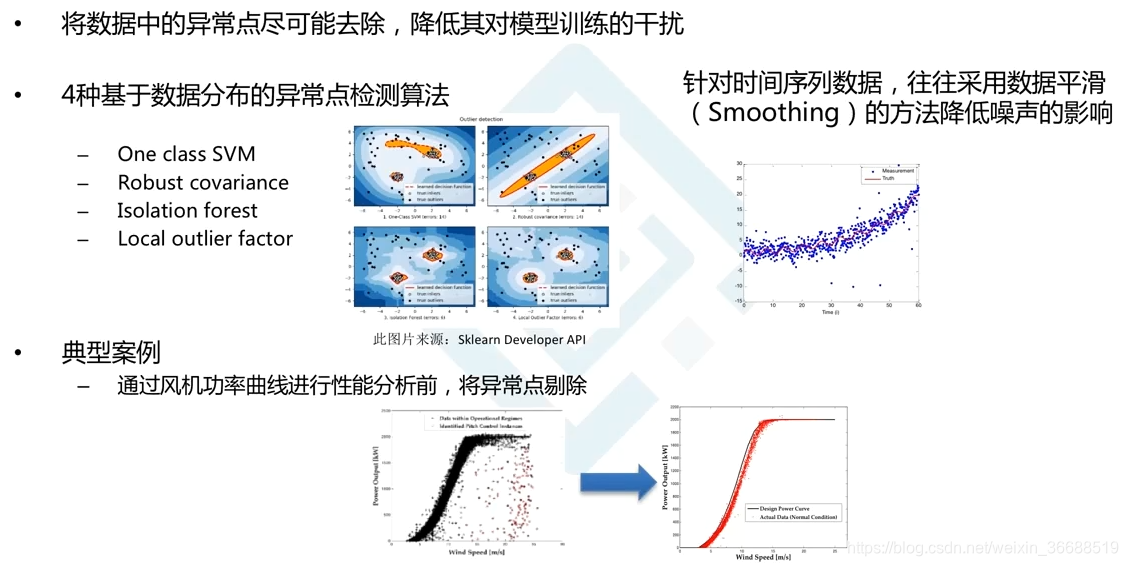

#### 异常值检测与处理

异常值是数据集中与大多数数据点显著不同的数据点。它们可能是由错误或极端情况引起的,对模型训练可能产生负面影响。异常值的检测与处理方法包括:

- **箱形图(Box Plot)**:根据四分位数确定异常值范围,一般超出范围的点视为异常值。

- **Z分数(Z-Score)**:根据数据点的均值和标准差确定异常值,通常情况下,若Z分数绝对值大于3,则认为是异常值。

- **基于模型的方法**:使用聚类分析、孤立森林等无监督学习方法识别异常值。

处理异常值时,可以考虑将其删除或替换为更合适的值,如均值或中位数。删除异常值可能会导致信息损失,而替换则是一种折中方案。

#### 数据一致性与重复值处理

数据一致性指的是数据集中的数据在逻辑上保持一致。重复值会增加数据集的冗余度,影响模型训练的效率和准确性。处理重复值通常包括:

- **删除重复的记录**:通过`drop_duplicates`函数直接删除数据集中的重复记录。

```python

# 删除重复记录

data_deduplicated = data.drop_duplicates()

print(data_deduplicated)

```

### 数据标准化与归一化

数据标准化和归一化是数据预处理中调整数据分布的重要手段,它们可以提高模型训练的稳定性和效率。

#### 标准化与归一化的定义和区别

- **标准化(Standardization)**:通过减去数据的均值并除以标准差,使得处理后的数据分布的均值为0,标准差为1。

- **归一化(Normalization)**:将数据缩放到一个特定的范围,通常是[0, 1],通过减去最小值并除以最大值和最小值的差来实现。

标准化和归一化的主要区别在于标准化不改变数据的原始范围,而归一化会改变数据的取值范围。

#### 标准化和归一化在模型训练中的作用

- **加快收敛速度**:标准化或归一化后的数据有助于梯度下降算法更快地收敛。

- **提高数值稳定性**:特别是在使用基于距离的算法(如k-最近邻算法)时,标准化可以避免某些特征因为数值过大而主导距离计算。

- **提高模型性能**:确保所有特征在相同的尺度上参与模型训练,这有助于优化算法更好地识别特征间的模式。

#### 实践中的参数选择与注意事项

在选择标准化或归一化时,需要考虑数据的特性和模型的需求。例如,对于支持向量机(SVM)这类对数据缩放敏感的算法,通常推荐进行标准化处理。而对于神经网络,归一化经常用于输入层,以帮助激活函数避免梯度消失或爆炸的问题。

在进行数据缩放时,需要注意以下几点:

- **对训练集和测试集使用相同的参数**:为避免数据分布不一致问题,训练集和测试集应使用相同的缩放参数。

- **异常值的处理**:标准化对异常值较为敏感,因为异常值会显著影响均值和标准差。归一化在这种情况下可能表现更好。

- **算法的敏感性**:了解所使用的模型对特征尺度的敏感度,选择适当的缩放方法。

数据预处理是机器学习流程中的重要一环,通过理解并掌握数据预处理的理论基础和关键方法,可以为后续的模型构建和训练打下坚实的基础。接下来的章节将进一步深入探讨数据转换和特征工程的技巧,以实现更高级的数据处理和模型优化。

# 3. 数据转换与特征工程

在机器学习项目中,原始数据通常需要经过一系列转换才能转化为适合模型训练的格式。特征工程是数据转换中至关重要的环节,它包括数据转换技巧和特征选择方法,以及维度缩减技术,这些技术能够提升模型的准确性和效率。本章将详细探讨这些主题。

## 3.1 数据转换的技巧

数据转换技巧用于改善数据分布、减少模型复杂度和提高模型性能。

### 3.1.1 离散化与二值化

离散化是将连续变量划分成若干个离散区间,而二值化则是将连续变量转换为二值变量,通常用于二分类问题。

#### 离散化

代码展示:

```python

import numpy as np

import pandas as pd

# 创建一个连续变量的示例数据集

data = np.random.normal(0, 1, 1000)

df = pd.DataFrame(data, columns=['Continuous'])

```

逻辑分析与参数说明:

上述代码创建了一个包含1000个样本的连续变量数据集。在实际应用中,连续数据可能需要根据业务需求或统计方法进行离散化处理。例如,可以使用箱型图(Boxplot)来帮助确定离散区间,或者使用聚类方法如K-means来进行自动离散化。

#### 二值化

代码展示:

```python

from sklearn.preprocessing import Binarizer

# 设置二值化的阈值

binarizer = Binarizer(threshold=0)

binary_data = binarizer.fit_transform(df)

# 将二维数组转换回DataFrame,并添加列名

binary_df = pd.DataFrame(binary_data, columns=['Binary'])

```

逻辑分析与参数说明:

在此示例中,使用了`sklearn.preprocessing`中的`Binarizer`类进行二值化处理。我们设定阈值为0,这意味着任何大于0的值都会被编码为1,否则为0。二值化后的数据更适合于某些类型的模型,比如逻辑回归。

### 3.1.2 多项式特征与交叉特征

多项式特征和交叉特征可以增加模型的复杂度,同时捕捉特征之间的非线性关系。

#### 多项式特征

代码展示:

```python

from sklearn.preprocessing import PolynomialFeatures

# 创建一个多项式特征转换器实例,阶数设置为2

poly = PolynomialFeatures(degree=2)

poly_features = poly.fit_transform(df)

# 将结果转换为DataFrame格式

poly_df = pd.DataFrame(poly_features, columns=poly.get_feature_names_out(df.columns))

```

逻辑分析与参数说明:

在该代码块中,使用了`sklearn.preprocessing`模块下的`PolynomialFeatures`类来生成多项式特征。这个转换器可以生成原特征的高阶组合,比如二阶多项式会生成原始特征的平方项以及特征间的乘积项。

#### 交叉特征

交叉特征是特征工程中的一种技术,它将两个或多个特征进行组合,形成新的特征。

代码展示:

```python

# 假设df1和df2是两个不同的特征列

df1 = pd.DataFrame(np.random.normal(0, 1, 1000), columns=['Feature1'])

df2 = pd.DataFrame(np.random.normal(0, 1, 1000), columns=['Feature2'])

# 创建交叉特征

cross_feature = df1['Feature1'] * df2['Feature2']

```

逻辑分析与参数说明:

在上述示例中,我们通过简单乘法操作创建了两个特征的交叉特征。在机器学习中,这种操作可以提供额外的信号,有助于模型学习特征间更复杂的相互作用。

## 3.2 特征选择方法

特征选择是去除不相关、冗余特征,保留有预测力特征的过程。

### 3.2.1 过滤法、包裹法和嵌入法概述

- **过滤法(Filter Method)**:基于统计测试对特征进行评分,然后选择评分最高的特征。

- **包裹法(Wrapper Method)**:基于模型的性能来评估特征子集的有效性。

- **嵌入法(Embedded Method)**:在模型训练过程中,进行特征选择。

### 3.2.2 常见特征选择算法实践

**基于模型的特征选择:**

代码展示:

```python

from sklearn.feature_selection import SelectFromModel

from sklearn.ensemble import RandomForestClassifier

# 假设X是特征矩阵,y是目标变量

X = df.drop(['Binary'], axis=1) # 移除二值化后的列

y = ... # 目标变量数据

# 使用基于森林的特征选择

selector = SelectFromModel(RandomForestClassifier())

X_new = selector.fit_transform(X, y)

```

逻辑分析与参数说明:

在这个例子中,我们使用了`sklearn.feature_selection`模块下的`SelectFromModel`类,并通过`RandomForestClassifier`作为子模型来选择特征。这种方法是嵌入法的一种应用,其中特征选择是在训练过程中内置进行的。

## 3.3 维度缩减技术

维度缩减技术能够减少数据中的特征数量,有助于提高模型训练速度和性能。

### 3.3.1 主成分分析(PCA)

代码展示:

```python

from sklearn.decomposition import PCA

# 初始化PCA,并指定主成分的数量

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

# 将降维后的数据转换为DataFrame格式

pca_df = pd.DataFrame(data=X_pca, columns=['PC1', 'PC2'])

```

逻辑分析与参数说明:

此段代码使用了`PCA`降维算法,其中`n_components`参数定义了我们想要保留的主成分数量。PCA是无监督学习的线性降维方法,它通过线性变换将数据投影到低维空间中,并尽可能保持数据在高维空间中的方差。

### 3.3.2 线性判别分析(LDA)

代码展示:

```python

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis as LDA

# 初始化LDA,并指定目标类别的数量

lda = LDA(n_components=1)

X_lda = lda.fit_transform(X, y)

# 将降维后的数据转换为DataFrame格式

lda_df = pd.DataFrame(data=X_lda, columns=['LD1'])

```

逻辑分析与参数说明:

LDA是一种监督学习的线性降维技术,用于多分类问题。在此代码段中,`n_components`定义了要降到的维度数量。LDA的目标是最大化类间差异,最小化类内差异,有助于提高分类问题的性能。

### 3.3.3 t-分布随机邻域嵌入(t-SNE)

代码展示:

```python

from sklearn.manifold import TSNE

# 使用t-SNE算法降维,设置perplexity和n_components参数

tsne = TSNE(perplexity=30, n_components=2, random_state=42)

X_tsne = tsne.fit_transform(X)

# 将降维后的数据转换为DataFrame格式

tsne_df = pd.DataFrame(data=X_tsne, columns=['t-SNE1', 't-SNE2'])

```

逻辑分析与参数说明:

t-SNE是一种非线性降维方法,特别适合用于将高维数据映射到二维或三维空间,以便于可视化。它保留了数据的局部结构,并将距离近的点映射到接近的位置。在该代码中,`perplexity`参数用于控制布局的复杂度,而`n_components`定义了输出的维度数量。

以上内容详细介绍了数据转换和特征工程的基本概念和实践方法,为理解和实施机器学习项目中的关键数据处理步骤奠定了坚实的基础。

# 4. 数据集的划分与模型评估

## 4.1 训练集、验证集与测试集

### 4.1.1 数据集划分的概念

在机器学习项目中,原始数据集的划分是一个重要的环节,其目的在于从原始数据中创建多个独立的子集,这些子集分别用于训练模型、调优模型参数以及最终评估模型的泛化能力。数据集通常分为训练集、验证集和测试集。训练集用于模型的学习过程;验证集用于调整模型的超参数,防止过拟合;测试集则用于评估模型的最终性能,它是在模型开发过程结束后,唯一没有接触过的数据子集。

划分数据集有助于我们验证模型在未知数据上的表现,因此是一种重要的模型评估方法。一个好的数据集划分可以帮助模型更好地推广到新的数据上,而不是仅仅记忆训练数据,即过拟合。

### 4.1.2 划分策略与方法

划分策略需要根据数据集的大小和特性来决定。最常用的方法有以下几种:

1. **简单随机划分**:这是最直接的方法,简单地随机地将数据分为训练集、验证集和测试集。通常情况下,可以设置60%-80%为训练集,10%-20%为验证集,剩余的10%-20%为测试集。

2. **分层随机划分**:在分类问题中,如果各类别的样本数差异较大,可以使用分层随机划分,确保每个子集中各类别的比例与原始数据集中的比例相同,从而使得每个子集的数据分布均匀。

3. **时间序列划分**:对于时间序列数据,通常按照时间顺序来进行数据划分。例如,可以按照先训练集、后测试集的顺序划分,这样可以避免时间上的信息泄漏,更准确地评估模型的预测能力。

### 4.1.3 划分过程的代码实现

在Python中,可以使用`sklearn.model_selection`模块中的`train_test_split`函数来快速划分数据集。以下是一个简单的示例代码:

```python

from sklearn.model_selection import train_test_split

# 假设X为特征集,y为标签

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.2, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)

# 训练集:验证集:测试集 = 60% : 20% : 20%

```

该函数中,`test_size`参数可以控制测试集和验证集的比例,而`random_state`参数用于确保结果的可重复性。

## 4.2 模型评估指标

### 4.2.1 回归问题的评估指标

对于回归问题,常用的评估指标包括均方误差(MSE)、均方根误差(RMSE)、平均绝对误差(MAE)和决定系数(R²)等。

- **均方误差(MSE)**:计算真实值和预测值差值的平方的平均数,MSE值越小,表示预测的误差越小。

```python

from sklearn.metrics import mean_squared_error

mse = mean_squared_error(y_true, y_pred)

```

- **均方根误差(RMSE)**:MSE的平方根,与MSE类似,RMSE值越小,模型性能越好。

- **平均绝对误差(MAE)**:计算真实值和预测值差值的绝对值的平均数,MAE对异常值不如MSE敏感。

- **决定系数(R²)**:衡量模型解释的变异性与总变异性的比例,R²值越接近1,模型拟合效果越好。

### 4.2.2 分类问题的评估指标

分类问题常用的评估指标有准确率、精确率、召回率、F1分数、ROC曲线下面积(AUC)等。

- **准确率(Accuracy)**:正确分类的样本数占总样本数的比例。

```python

from sklearn.metrics import accuracy_score

accuracy = accuracy_score(y_true, y_pred)

```

- **精确率(Precision)**:预测为正的样本中,实际为正的比例。

- **召回率(Recall)**:实际为正的样本中,被正确预测为正的比例。

- **F1分数(F1 Score)**:精确率和召回率的调和平均数,综合考虑了模型的精确性和召回性。

```python

from sklearn.metrics import f1_score

f1 = f1_score(y_true, y_pred)

```

- **ROC曲线下面积(AUC)**:ROC曲线是描述不同分类阈值下真正例率和假正例率关系的曲线。AUC值越接近1,表示模型的分类性能越好。

### 4.2.3 模型评估的实践案例

对于一个二分类问题,使用逻辑回归模型进行预测,并采用上述指标进行评估。假设数据集已经划分好了训练集、验证集和测试集。

```python

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, roc_auc_score

# 创建逻辑回归模型

model = LogisticRegression()

# 训练模型

model.fit(X_train, y_train)

# 进行预测

y_pred_train = model.predict(X_train)

y_pred_val = model.predict(X_val)

# 计算各项指标

train_accuracy = accuracy_score(y_train, y_pred_train)

val_accuracy = accuracy_score(y_val, y_pred_val)

train_precision = precision_score(y_train, y_pred_train)

val_precision = precision_score(y_val, y_pred_val)

train_recall = recall_score(y_train, y_pred_train)

val_recall = recall_score(y_val, y_pred_val)

train_f1 = f1_score(y_train, y_pred_train)

val_f1 = f1_score(y_val, y_pred_val)

train_auc = roc_auc_score(y_train, model.predict_proba(X_train)[:, 1])

val_auc = roc_auc_score(y_val, model.predict_proba(X_val)[:, 1])

# 输出评估结果

print(f"Training set accuracy: {train_accuracy}")

print(f"Validation set accuracy: {val_accuracy}")

print(f"Training set precision: {train_precision}")

print(f"Validation set precision: {val_precision}")

print(f"Training set recall: {train_recall}")

print(f"Validation set recall: {val_recall}")

print(f"Training set F1 score: {train_f1}")

print(f"Validation set F1 score: {val_f1}")

print(f"Training set AUC: {train_auc}")

print(f"Validation set AUC: {val_auc}")

```

通过上述的评估指标,我们可以全面了解模型在不同方面的表现,进而对模型进行调整,以达到更好的性能。

## 4.3 交叉验证与超参数优化

### 4.3.1 K折交叉验证的方法与原理

在机器学习中,K折交叉验证是一种评估模型泛化能力的方法。它将数据集分为K个大小相同的子集,每次取K-1个子集作为训练集,剩下的一个子集作为测试集。这样可以确保每个子集都被用作一次测试集,同时使用剩余的数据进行模型训练。

K折交叉验证的步骤包括:

1. 划分K个等大小的子集。

2. 选择一个子集作为验证集,其余K-1个子集用于训练。

3. 训练模型并评估模型性能。

4. 重复步骤2和3,直到每个子集都被用作一次验证集。

5. 计算所有K次迭代的评估结果的平均值。

### 4.3.2 超参数优化策略与实现

超参数优化是指在模型训练前,通过一定的搜索策略找到最优超参数组合的过程。常用的优化策略有网格搜索(Grid Search)、随机搜索(Random Search)和贝叶斯优化(Bayesian Optimization)等。

#### 网格搜索

网格搜索是一种穷举搜索策略,它会遍历由用户指定的超参数的所有可能值,并评估每一种参数组合的模型性能。

```python

from sklearn.model_selection import GridSearchCV

# 假设已经定义了模型model和参数网格param_grid

grid_search = GridSearchCV(estimator=model, param_grid=param_grid, cv=5, scoring='accuracy')

# 训练模型

grid_search.fit(X, y)

# 输出最佳参数和最佳分数

print(f"Best parameters: {grid_search.best_params_}")

print(f"Best score: {grid_search.best_score_}")

```

在这个例子中,`cv=5`指定了使用5折交叉验证,`scoring='accuracy'`指定了以准确率作为评估指标。

### 4.3.3 超参数优化的代码实现

下面是一个使用网格搜索对逻辑回归模型进行超参数优化的完整例子:

```python

from sklearn.model_selection import GridSearchCV

from sklearn.linear_model import LogisticRegression

# 定义模型

model = LogisticRegression()

# 设置超参数网格

param_grid = {

'C': [0.01, 0.1, 1, 10, 100],

'penalty': ['l1', 'l2'],

'solver': ['liblinear']

}

# 创建GridSearchCV对象

grid_search = GridSearchCV(estimator=model, param_grid=param_grid, cv=5, scoring='accuracy')

# 训练模型

grid_search.fit(X, y)

# 输出最佳参数和最佳分数

print(f"Best parameters: {grid_search.best_params_}")

print(f"Best score: {grid_search.best_score_}")

# 使用最佳参数重新训练模型

best_model = grid_search.best_estimator_

```

通过超参数优化,我们可以寻找到更好的参数组合,提升模型的性能。需要注意的是,网格搜索是一种计算密集型的方法,当参数网格较大或者数据集很大时,计算资源的消耗会非常巨大。在实践中,根据情况可能需要考虑更高效的搜索策略。

# 5. 实际应用案例分析

## 5.1 实际数据集的预处理流程

在机器学习项目中,面对实际的数据集,预处理是一个不可或缺的步骤。一个良好的预处理流程能够显著提高模型的训练效率和预测准确性。

### 5.1.1 数据探索性分析

在开始任何数据预处理之前,进行数据探索性分析(Exploratory Data Analysis, EDA)是至关重要的。这一步骤能够帮助我们理解数据的结构、分布情况、潜在的关系以及异常值等。数据探索可以通过各种统计图表和描述性分析来完成。例如,使用Python中的Pandas和Matplotlib库,我们可以快速地得到数据的基本信息和分布情况。

```python

import pandas as pd

import matplotlib.pyplot as plt

# 加载数据集

data = pd.read_csv('data.csv')

# 数据集的基本信息

print(data.info())

# 数据分布情况

data.describe()

# 绘制直方图

data.hist(bins=50, figsize=(20, 15))

plt.show()

```

通过上述的代码块,我们可以查看数据集中的特征及其数据类型,并通过描述性统计和直方图来初步了解数据分布。

### 5.1.2 应用数据预处理技术

数据预处理技术的应用,是根据EDA的结果进行的。例如,如果发现数据集存在缺失值,我们可能需要使用均值、中位数或众数来填充它们;如果存在异常值,可能需要进行裁剪或用模型预测值替代;对于连续数据,可能需要执行标准化或归一化处理。

```python

# 缺失值处理

data.fillna(data.mean(), inplace=True)

# 异常值处理

# 例如,这里我们简单地使用Z-score方法检测异常值

from scipy import stats

import numpy as np

z_scores = np.abs(stats.zscore(data.select_dtypes(include=[np.number])))

data = data[(z_scores < 3).all(axis=1)]

# 数据标准化

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data.select_dtypes(include=[np.number]))

```

通过应用这些基本的数据预处理技术,我们可以使得数据集更适合后续的模型训练。

## 5.2 机器学习模型训练与优化

在数据预处理之后,我们便可以着手进行机器学习模型的构建。

### 5.2.1 构建机器学习模型

构建模型的第一步是选择一个或多个模型作为基础。模型的选择依赖于具体问题的类型,例如分类问题可以选择逻辑回归、决策树或支持向量机等。

```python

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

# 假设y是目标列

X = data.drop('target', axis=1)

y = data['target']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 构建随机森林模型

model = RandomForestClassifier(n_estimators=100, random_state=42)

model.fit(X_train, y_train)

```

### 5.2.2 特征工程对模型性能的影响

特征工程是提高模型性能的关键步骤。通过特征选择、特征转换等方法,我们可以从原始数据中提取出最有价值的信息。

```python

from sklearn.feature_selection import SelectKBest, f_classif

# 使用SelectKBest进行特征选择

select = SelectKBest(f_classif, k=5)

X_train_new = select.fit_transform(X_train, y_train)

X_test_new = select.transform(X_test)

# 使用新的特征集训练模型

model_new = RandomForestClassifier(n_estimators=100, random_state=42)

model_new.fit(X_train_new, y_train)

# 评估模型

from sklearn.metrics import accuracy_score

y_pred = model_new.predict(X_test_new)

print(accuracy_score(y_test, y_pred))

```

在上面的代码中,我们使用SelectKBest方法选择最重要的五个特征,并构建了一个新的随机森林模型。通过评估新模型的准确性,我们可以直观地看出特征工程的影响。

## 5.3 结果分析与模型部署

在模型训练和优化之后,我们接下来需要分析模型的输出结果,并考虑如何将模型部署到生产环境中。

### 5.3.1 模型评估结果

模型评估是机器学习流程中不可或缺的一部分。它帮助我们理解模型的表现,并指导我们是否需要进一步优化。

```python

from sklearn.metrics import classification_report, confusion_matrix

# 生成详细的分类报告

report = classification_report(y_test, y_pred)

print(report)

# 生成混淆矩阵

conf_matrix = confusion_matrix(y_test, y_pred)

print(conf_matrix)

```

### 5.3.2 模型部署策略

一旦模型经过充分评估并确定可用,就需要部署到生产环境中。根据实际情况,可能会有不同的部署策略,例如使用API接口、集成到现有系统等。

### 5.3.3 模型维护与更新

模型在生产环境中可能会遇到与训练时不同的数据分布,所以定期监控模型表现、收集反馈、重新训练模型是非常重要的。

通过以上的实际应用案例分析,我们可以清楚地看到数据预处理、模型训练、评估和部署的整个流程。在这一系列步骤中,每一个环节都需要认真对待,以确保最终模型的有效性和鲁棒性。

0

0