实时监控P400系统:性能与资源使用分析的终极指南

发布时间: 2025-01-10 12:47:08 阅读量: 3 订阅数: 3

P400和P900数据手册_数据手册_p400_P900_

# 摘要

本文对P400实时监控系统的性能监控理论和实践进行了全面分析。首先介绍了实时监控系统的基本概念及其性能监控的重要性,然后详细阐述了P400系统的架构特点、性能监控的理论模型以及性能监控指标的选择和数据分析方法。接着,文章对P400系统中的CPU、内存、磁盘和网络I/O资源的使用情况进行了深入分析,并探讨了资源使用中的常见问题及其预防措施。第四章展示了实时监控工具的选择与配置,以及监控实施策略和案例分析。最后,文章探讨了性能优化与故障排除的方法,并预测了监控与优化技术的未来趋势,包括人工智能的运用和预测性维护技术的发展。

# 关键字

实时监控系统;性能监控;资源分析;故障诊断;优化策略;人工智能;预测性维护

参考资源链接:[MicroHard P400/P840 无线数据通信模块用户手册](https://wenku.csdn.net/doc/1rg90pwryh?spm=1055.2635.3001.10343)

# 1. 实时监控系统概述

在当今IT领域,实时监控系统已成为保障企业业务连续性和系统稳定性的核心组成部分。随着技术的演进,监控系统不再仅仅是记录日志和简单的告警通知,它已经演变成为一种能够实时分析、预测问题和自动响应的复杂系统。一个有效的实时监控系统可以帮助工程师们快速定位问题源头,及时进行性能调优,最终实现业务流程的优化和资源的高效利用。

本章将带您入门实时监控系统的基本概念,包括监控系统的主要功能、构建实时监控系统的必要性以及其在现代企业IT架构中的作用。我们将探讨如何通过实时监控系统提高系统的稳定性和安全性,以及如何在面临故障和性能瓶颈时快速响应和解决。

接下来,我们将深入探讨P400系统的性能监控理论,解析其架构特点,监控理论模型,并对资源使用情况展开详细分析。这一章节是您了解实时监控系统并掌握其核心要点的基础。

# 2. P400系统性能监控理论

### 2.1 性能监控的重要性

#### 2.1.1 系统性能的基本概念

系统性能是指计算机系统完成任务的能力,包括处理速度、响应时间、吞吐量、资源利用率、稳定性和可靠性等多个方面。良好的系统性能对于保证业务的连续性和用户体验至关重要。为了有效地维护和提升系统性能,必须依赖于一套完善的性能监控体系,它能够实时跟踪系统状态,分析性能瓶颈,并提供优化建议。

系统性能监控是一项持续的任务,它涉及对关键性能指标(KPIs)的定期或实时检查,以评估系统是否在最佳状态下运行。当监控数据显示系统性能下降时,相关人员可以通过深入分析问题所在,并采取相应的优化措施来解决问题。

#### 2.1.2 性能监控的目标和意义

性能监控的主要目标包括确保系统稳定性、识别性能瓶颈、预防潜在故障和优化资源分配。通过监控系统性能,我们能够:

- 确保系统服务水平协议(SLA)的履行。

- 实现资源利用的优化,减少运营成本。

- 为系统容量规划提供准确的数据支持。

- 提升用户体验,保证应用的快速响应。

此外,性能监控对于IT团队来说,是确保服务质量和业务连续性的关键。没有有效的性能监控,系统可能在用户察觉之前就已经开始变慢甚至崩溃,导致服务中断和客户不满。

### 2.2 P400系统的架构特点

#### 2.2.1 P400硬件架构解析

P400系统是一个高度可扩展的企业级服务器平台,它以模块化设计和高性能计算能力著称。它的硬件架构包括多种关键组件,如CPU、内存、存储和网络接口,每一个组件都对系统的整体性能有着直接的影响。

- **CPU**:采用多核处理器,支持高频率和多线程执行,是处理任务的核心组件。

- **内存**:拥有高容量和高速度的内存子系统,为CPU提供快速的数据访问。

- **存储**:结合了固态硬盘(SSD)和传统硬盘(HDD),以平衡性能和成本。

- **网络接口**:提供高速以太网或光纤通道连接,确保低延迟的数据传输。

每一种组件的设计都旨在实现高效的数据处理和传输能力,为了达到最佳性能,这些组件必须协同工作,实现性能的最优化。

#### 2.2.2 软件层面的系统交互

P400系统的软件层面同样重要,它包括操作系统、中间件和应用层。这些软件组件之间的交互需要经过精心设计,以确保数据流的高效和连续性。

- **操作系统**:负责管理硬件资源,提供进程调度、内存管理等基础服务。

- **中间件**:如数据库管理系统(DBMS)、消息队列等,它们在应用与硬件之间起到桥梁作用。

- **应用层**:直接与用户交互的业务逻辑实现,是用户最终体验的提供者。

性能监控不仅需要关注硬件层面,软件层面同样重要。例如,通过监控数据库的查询响应时间,可以帮助识别是否存在SQL优化空间,或者磁盘I/O是否成为瓶颈。

### 2.3 性能监控的理论模型

#### 2.3.1 监控指标的选择

在构建性能监控系统时,选择合适的监控指标是至关重要的。关键的性能指标包括:

- **CPU使用率**:反映处理器资源的利用率。

- **内存利用率**:指示内存资源的占用情况。

- **磁盘I/O**:衡量磁盘读写速度和频率。

- **网络I/O**:评估网络传输的数据量和响应时间。

- **应用响应时间**:测量请求到响应的时间间隔。

这些指标能够提供关于系统健康状况的直接信息,帮助系统管理员和技术支持团队快速定位问题。

#### 2.3.2 监控数据的收集和分析

监控数据的收集通常需要使用专门的软件工具,这些工具能够从各个组件收集性能数据,如操作系统、网络设备、数据库和其他中间件。这些数据可以是:

- **系统日志**:记录系统发生的事件和状态变更。

- **性能计数器**:提供实时的性能指标值。

- **事件追踪**:记录影响性能的具体事件或操作。

收集到的数据需要通过分析来识别模式、趋势和异常。性能分析可以采用多种方法,例如对比不同时间点的性能指标,或者使用基准测试来评估系统在负载下的表现。使用高级分析技术,如机器学习,可以进一步提高分析的准确性和效率。

#### 2.3.3 性能数据的可视化与报告

为了方便监控和分析,性能数据需要被可视化展示。数据可视化是通过图表、图形和仪表盘来展示性能指标和趋势,使得监控人员能够直观地理解数据,并快速作出决策。

- **实时监控仪表盘**:提供关键性能指标的实时视图。

- **历史趋势图表**:帮助监控人员观察指标随时间的变化。

- **报告和警报系统**:发送异常事件的警报,并生成性能报告供定期审查。

通过数据可视化工具,可以将复杂的数据转化为易懂的视觉信息,从而帮助技术人员更好地理解系统性能的全貌,并采取相应的行动。

# 3. P400系统资源使用分析

## 3.1 CPU资源的使用情况分析

### 3.1.1 CPU负载与性能影响

在P400系统中,CPU作为执行计算任务的核心部件,其负载情况直接关系到系统的整体性能。CPU负载指的是CPU在一定时间内所处理的线程数,它与性能影响的关系是指数级增长的。负载的增加意味着CPU需要处理更多的任务,当达到或超过其处理能力时,系统性能会显著下降。

一个高负载的CPU可能会导致系统反应迟缓,甚至出现任务排队等待执行的情况。这种状态不仅影响用户体验,还可能导致服务级别的下降,尤其是在高并发的环境中,如服务器、数据库和高流量的Web应用。因此,对CPU负载的有效监控可以帮助我们及时发现性能瓶颈并进行优化。

### 3.1.2 CPU使用率的趋势分析

对CPU使用率进行趋势分析是监控CPU性能的关键。CPU使用率的趋势分析可以帮助我们了解系统在过去一段时间内的性能变化,预测潜在问题,并进行资源的优化分配。

我们可以使用工具如`mpstat`(在sysstat包中)来监控CPU的使用率。以下是一个`mpstat`的示例输出,并附带分析:

```sh

mpstat -P ALL 2 3

```

该命令将输出每个可用CPU核心的使用情况,2表示每隔2秒刷新一次,3表示刷新三次。输出结果类似于:

```

Linux 4.15.0-1069-aws (ip-172-31-1-204) 05/23/2021 _x86_64_ (16 CPU)

12:00:00 PM CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

12:00:01 PM all 11.01 0.00 2.01 0.00 0.00 0.00 0.00 0.00 0.00 86.98

12:00:01 PM 0 12.00 0.00 4.00 0.00 0.00 0.00 0.00 0.00 0.00 84.00

12:00:01 PM 1 8.00 0.00 2.00 0.00 0.00 0.00 0.00 0.00 0.00 90.00

```

在趋势分析中,如果`%idle`列持续处于低位,而`%usr`或`%sys`列持续处于高位,这可能表明系统正在经历高CPU使用率,需要进一步分析是否是由于某些进程或服务引起的。

为了深入分析CPU使用情况,我们可以结合`top`或`htop`命令来查看哪个进程占用了最多的CPU资源,并据此进行优化。通过这些数据,我们可以判断是否需要增加CPU资源,或者优化那些占用CPU过多的进程。

## 3.2 内存资源的使用情况分析

### 3.2.1 内存分配与回收机制

内存管理是操作系统的重要组成部分,对P400系统的性能至关重要。内存分配与回收机制决定了系统如何高效地使用有限的内存资源。在Linux系统中,内存的分配通常通过`malloc()`和`free()`函数在用户空间进行,而在内核空间,内核负责管理内存页的分配和回收。

内核使用了一系列技术,如页交换(swapping)和页面回收算法(如最近最少使用算法,LRU)来管理内存。当物理内存不足时,系统会将一些不常用的数据移动到交换空间(硬盘上的一部分区域),从而释放物理内存供其他进程使用。但是,频繁的页交换会显著降低系统性能,因为硬盘的读写速度远低于内存。

以下是一个查看内存使用情况的示例输出,使用`free -m`命令:

```sh

free -m

total used free shared buff/cache available

Mem: 15919 1104 12291 76 2521 14608

Swap: 4095 0 4095

```

这个输出显示了系统的总内存、已用内存、空闲内存、共享内存、缓冲/缓存内存和可用于新应用程序的内存。`buff/cache`列表示被内核用于缓冲和缓存的内存量,这部分内存在需要时可以被回收供其他用途。

### 3.2.2 内存泄漏的检测与预防

内存泄漏是软件开发中常见的问题,指的是程序在申请内存后未释放或无法释放的情况。随着时间的推移,内存泄漏会导致系统可用内存逐渐减少,影响系统性能,甚至导致系统崩溃。

为了检测内存泄漏,我们可以使用如`valgrind`这类工具。使用`valgrind`时,需要对需要检测的程序进行编译并运行。以下是一个简单的例子,使用`valgrind`来检测一个简单的C程序的内存泄漏:

```sh

valgrind --leak-check=full ./your_program

```

如果程序存在内存泄漏,`valgrind`会输出泄漏的详细信息,包括内存泄漏的位置和大小。对于预防内存泄漏,通常的做法包括:

- 仔细设计内存管理策略,例如使用智能指针来管理C++中的动态内存。

- 在代码审查和测试阶段使用静态和动态分析工具检测潜在的内存泄漏。

- 运行压力测试和长时间运行的测试来观察程序在实际使用过程中的内存使用情况。

通过这些策略和工具,我们可以有效地减少和预防内存泄漏问题,确保系统的稳定性和性能。

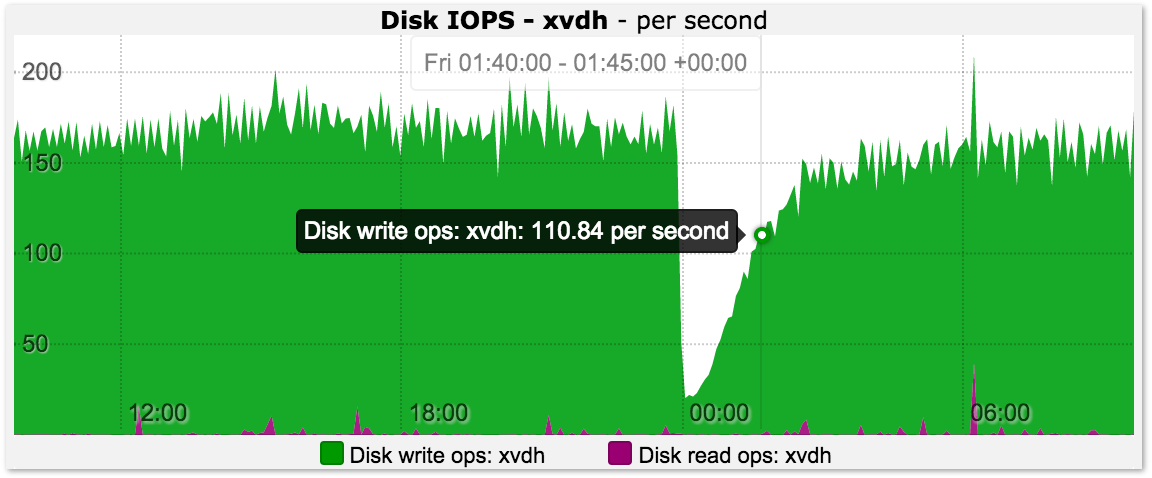

## 3.3 磁盘和网络I/O监控

### 3.3.1 磁盘I/O性能评估

磁盘I/O操作对于需要频繁读写数据的系统来说是性能的关键。例如,在数据库服务器或者存储服务器中,磁盘的读写速度直接影响到服务的响应速度和吞吐量。

评估磁盘I/O性能通常涉及到监控磁盘读写的次数和速度。Linux系统中,可以通过`iostat`工具来观察磁盘I/O的实时性能数据。以下是一个`iostat`的使用例子:

```sh

iostat -dxk 2 3

```

这个命令每隔2秒刷新一次,共刷新3次。输出结果会包含磁盘的读写次数、速率和时间等信息,例如:

```

Linux 4.15.0-1069-aws (ip-172-31-1-204) 05/23/2021 _x86_64_ (16 CPU)

Device: rrqm/s wrqm/s r/s w/s rkB/s wkB/s avgrq-sz avgqu-sz await r_await w_await svctm %util

sda 0.00 3.00 1.00 11.00 24.00 108.00 18.40 0.00 6.36 1.00 6.59 3.18 3.80

```

在这个输出中,`r/s`和`w/s`分别表示每秒读写次数,`rkB/s`和`wkB/s`表示每秒读写的KB数,`await`表示平均等待时间,`%util`表示磁盘使用率。

通过这些数据,我们可以了解到磁盘I/O的性能瓶颈是否出现,并采取相应措施,例如升级到更快的SSD硬盘、优化I/O密集型应用的使用方式或配置I/O调度器。

### 3.3.2 网络流量监控与分析

网络流量监控是确保网络服务质量和性能的关键。在网络监控中,需要关注的关键指标包括网络接口的带宽使用情况、数据包的收发速度、以及连接的建立和断开情况。

在Linux系统中,可以使用`iftop`或`nethogs`这类工具来监控实时网络流量。以下是一个`iftop`的使用例子:

```sh

iftop -n -N -i eth0

```

该命令将显示名为`eth0`的网络接口上的实时流量情况。输出结果将包括:

- 每个连接的数据流大小和速率。

- 数据包数量和字节数。

- 排名靠前的通信量连接。

输出示例:

```

RX: cum: 1.86MB peak: 230.00kb rates: 1.00kb 0.00b 2.00k

TX: cum: 1.74MB peak: 136.00kb rates: 0.00b 0.00b 0.50k

INTERFACES RX/IP TX/IP RX/NET TX/NET TX/RX flg

eth0 56.47Kb/s 54.84Kb/s 56.47Kb/s 54.84Kb/s 0.96 B

eth1 10.80Mb/s 24.55Mb/s 10.80Mb/s 24.55Mb/s 2.27 B

```

通过`iftop`的输出,我们可以监控到各个网络连接的使用情况,从而分析出是否某些连接占用了过多的带宽资源。对于网络I/O的监控和分析,可以帮助我们识别网络中的瓶颈,优化网络配置,或者发现可能的网络攻击行为。

综上所述,通过深入分析P400系统的CPU、内存、磁盘和网络I/O资源使用情况,可以更加精确地诊断性能问题,采取针对性的优化措施,保障系统的稳定和高效运行。

# 4. 实时监控工具与实践

## 4.1 开源监控工具的对比与选择

在IT领域,选择合适的实时监控工具对于系统稳定性和性能优化至关重要。开源监控工具因其灵活、成本低以及社区支持广泛而受到青睐。本节将从不同维度比较常见的开源监控工具,并提供选择和配置这些工具的指导。

### 4.1.1 比较不同监控工具的特点

- **Prometheus**

Prometheus是一个开源的监控解决方案,以其强大的查询语言PromQL和时间序列数据收集著称。它的架构允许水平扩展,非常适合大型环境。此外,Prometheus具有出色的警报管理机制,用户可定义自定义警报规则并集成到多种通知渠道。

- **Nagios**

Nagios是监控工具领域的老牌成员,以其稳定性和可靠性而闻名。它能够监控网络服务、服务器、应用程序等,并具有警报通知功能。Nagios的配置和扩展可能需要更多的技术知识,因此对于初学者来说学习曲线可能较陡。

- **Zabbix**

Zabbix集成了监控、警报和可视化功能,支持自动发现网络设备,并能够处理大量数据。它的图形用户界面(GUI)直观易用,适合各种规模的监控任务。

### 4.1.2 工具的安装和配置指南

- **Prometheus配置示例**

```yaml

global:

scrape_interval: 15s

evaluation_interval: 15s

rule_files:

- "alert.rules"

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

alerting:

alertmanagers:

- static_configs:

- targets:

- localhost:9093

```

上述Prometheus配置文件包含了关键配置,如抓取间隔、评估间隔、警报规则文件路径和目标抓取配置。安装Prometheus后,通常需要创建相应的警报规则文件以定义监控警报的触发条件。

- **Nagios配置解析**

```cfg

define host{

host_name server1

alias Web Server

address 192.168.1.1

max_check_attempts 5

check_interval 5

retry_check_interval 1

}

define service{

host_name server1

service_description HTTP

check_command check_http

max_check_attempts 5

check_interval 5

}

```

在Nagios配置中,定义了监控目标(主机)和服务(服务)。每个定义都包括了监控的细节,如服务检查命令、检查间隔和尝试次数等。这些配置使得Nagios能够对监控目标进行精确的控制。

- **Zabbix模板配置**

```xml

<zabbix_export>

<template name="Template Web Server">

<description>Template for monitoring Apache and other web servers</description>

<items>

<item key="net.tcp.service[tcp/80]" name="HTTP service">

<description>Service on port 80</description>

<type>0</type> <!-- Zabbix agent -->

<snmp_community/>

<snmp OID/>

<value_type>0</value_type> <!-- numeric -->

<interface_type>1</interface_type> <!-- IP -->

<interface_num>1</interface_num>

<status>0</status> <!-- enabled -->

<applications>

<application>

<name>Web server</name>

</application>

</applications>

</item>

</items>

<triggers>

<trigger>

<expression>{Template Web Server:net.tcp.service[tcp/80].last()}<1</expression>

<name>HTTP service is down</name>

<description>Trigger if HTTP service is down</description>

<priority>3</priority> <!-- Warning -->

</trigger>

</triggers>

</template>

</zabbix_export>

```

这里展示的是Zabbix模板的配置,它定义了监控项、触发器和应用。模板化可以大大简化大规模监控任务的管理,使得监控设置更容易扩展。

通过以上配置,我们可以看到每个工具都有其优势和特点,选择合适的工具需基于实际需求和团队技术栈。接下来,我们将探讨实时监控实施策略。

## 4.2 实时监控实施策略

实时监控的目的是确保系统稳定运行,并在问题出现时及时响应。一个有效的监控实施策略包括监控数据的实时获取和监控告警机制的建立。

### 4.2.1 监控数据的实时获取

实时监控数据的获取是确保系统性能的关键。它包括系统资源使用情况的持续跟踪,例如CPU、内存和磁盘I/O等。这些数据不仅应记录下来,还应能够实时分析以发现潜在问题。

```bash

# 使用Prometheus抓取数据示例

prometheus --config.file=prometheus.yml

```

上述命令启动Prometheus进程,使用配置文件`prometheus.yml`来抓取数据。这些数据随后可用于生成图表、警报和报告。

### 4.2.2 监控告警机制的建立

监控告警机制是实时监控的重要组成部分,它能够及时通知运维团队问题的出现。

```yaml

alert_rules.yml

groups:

- name: example

rules:

- alert: HighCPUUsage

expr: avg by (instance) (rate(node_cpu_seconds_total{mode="idle"}[5m])) < 0.2

for: 2m

labels:

severity: warning

annotations:

summary: High CPU usage on instance {{ $labels.instance }}

```

在此YAML配置文件中,我们定义了一个告警规则`HighCPUUsage`。如果CPU的空闲时间少于20%超过两分钟,将触发此告警,并通知到监控团队。

## 4.3 案例分析:P400系统监控实操

### 4.3.1 实施监控前的准备

在监控P400系统之前,需要确定监控的目标和范围,设计监控的架构,并为监控工具准备好运行环境。

- **确定监控目标**

- 确定需要监控的关键指标,例如系统延迟、吞吐量、错误率等。

- **设计监控架构**

- 架构设计需要考虑到数据的收集、存储、分析和告警等功能的实现,确保监控的全面性。

- **环境准备**

- 确保监控工具能够在目标系统上运行,例如部署相应的代理和服务。

### 4.3.2 实际监控数据解读与应用

成功实施监控后,接下来是对监控数据的解读和应用。这包括对监控数据的分析,找到性能瓶颈,以及对潜在问题的预防。

- **数据解读**

- 使用图表和报表工具对监控数据进行可视化,快速识别趋势和异常。

- **性能瓶颈定位**

- 对于发现的性能瓶颈,利用监控数据进行深入分析,找到可能的原因。

- **预防措施**

- 根据监控数据预测可能出现的问题,并提前采取措施避免问题发生。

通过本节内容,读者应能够理解如何选择和配置实时监控工具,如何实施监控策略,以及如何在实际环境中应用监控数据。接下来章节将深入讨论性能优化与故障排除的方法与实践。

# 5. 性能优化与故障排除

性能优化与故障排除是确保系统稳定运行、提高服务质量的关键环节。随着业务的扩展和技术的更新换代,IT系统会遇到各种性能瓶颈和故障,这就需要系统管理员或运维工程师不断地进行性能监控、优化和故障排查。本章节将详细介绍性能瓶颈的识别与优化方法,以及故障诊断与解决的策略。

## 5.1 性能瓶颈的识别与优化

性能瓶颈是影响系统响应速度和服务质量的关键因素,及时地识别和解决性能瓶颈对于保证系统稳定运行至关重要。

### 5.1.1 瓶颈问题的分析方法

要有效地找到性能瓶颈,首先需要了解常见的瓶颈类型,比如CPU瓶颈、内存瓶颈、I/O瓶颈以及网络瓶颈等。一旦确定了瓶颈的类型,就可以通过各种性能分析工具来进行进一步的深入分析。

**CPU瓶颈**:通常表现为CPU使用率长时间保持在较高水平,可以通过系统监控工具来观察CPU的使用情况。使用 `top` 或 `htop` 命令可以实时查看CPU的使用情况,而 `sar` 命令则可以查看历史数据。

```bash

# 使用top命令查看实时CPU使用率

top

# 使用sar命令查看过去5分钟的CPU使用率

sar -u 5 1

```

CPU瓶颈的分析需要结合应用程序的具体运行情况,分析是否有特定的进程占用了过多的CPU资源,或者系统中是否存在死循环等问题。

**内存瓶颈**:当系统的物理内存不足时,系统会频繁使用交换分区(swap),这会导致系统响应变慢。可以使用 `free` 和 `vmstat` 命令来检测内存使用情况。

```bash

# 查看内存使用情况

free -m

# 检测交换分区的使用情况

vmstat 1

```

**I/O瓶颈**:磁盘I/O瓶颈是系统性能瓶颈的常见原因,可以通过 `iostat` 命令来监测磁盘I/O性能。

```bash

# 使用iostat命令检测磁盘I/O情况

iostat -xz 1

```

**网络瓶颈**:网络I/O瓶颈可以通过 `iftop` 或 `nethogs` 等工具来检测网络使用情况。

```bash

# 使用iftop命令监控网络流量

iftop

```

瓶颈的分析不仅要考虑硬件资源,还需要考虑软件层面的优化,比如代码优化、算法改进、数据库查询优化等。

### 5.1.2 系统优化的实践经验

系统优化是一个持续的过程,它涉及对系统配置的调整、软件的更新以及硬件的升级。以下是几个常见的系统优化实践经验:

- **调整系统参数**:根据系统负载和业务需求调整系统参数,比如调整Linux的内核参数,以优化网络栈性能。

```conf

# 修改内核参数,例如调整TCP的最大缓冲区大小

net.core.rmem_max = 16777216

net.core.wmem_max = 16777216

```

- **数据库优化**:数据库的优化包括SQL查询优化、索引优化、数据库配置优化等。例如,通过执行 `EXPLAIN` 语句来分析查询计划,并据此优化。

```sql

-- 分析查询计划

EXPLAIN SELECT * FROM table_name WHERE condition;

```

- **负载均衡**:通过部署负载均衡器来分散请求到多个服务器,减少单个服务器的压力。常用负载均衡软件包括Nginx和HAProxy。

- **缓存机制**:合理使用缓存可以减少数据库和磁盘I/O的压力。在Web应用中,可以使用Redis、Memcached等工具来缓存频繁访问的数据。

```python

# Python中使用Redis作为缓存的例子

import redis

cache = redis.Redis(host='localhost', port=6379, db=0)

# 尝试从缓存中获取数据

data = cache.get('my_data')

if data is None:

# 如果缓存中没有数据,从数据库获取后存入缓存

data = fetch_data_from_database('my_data')

cache.set('my_data', data)

```

- **异步处理**:对于耗时的操作采用异步处理机制,可以提高系统的响应速度。例如,使用消息队列(如RabbitMQ、Kafka)来处理耗时的后台任务。

## 5.2 常见故障诊断与解决

在系统运行过程中,故障是不可避免的,因此快速准确地诊断并解决故障是至关重要的。故障诊断通常包括几个步骤:收集故障信息、分析故障现象、定位问题源头、制定解决方案和验证修复效果。

### 5.2.1 故障排查的步骤和技巧

故障排查的第一步是收集足够的故障信息,这包括查看系统日志、应用程序日志、监控告警信息等。接下来是分析故障现象,明确是哪部分功能或组件出现问题。

**使用日志文件定位问题**:通过查看日志文件可以获取到应用程序和系统运行的关键信息。

```bash

# 查看系统日志

tail -f /var/log/syslog

# 查看应用程序日志

tail -f /path/to/app.log

```

**利用诊断工具进行故障排查**:使用如 `strace`、`lsof` 和 `netstat` 等工具可以帮助诊断系统问题。

```bash

# 使用strace跟踪系统调用和信号

strace -p <PID>

# 使用lsof查看打开的文件和网络连接

lsof

# 使用netstat查看网络连接状态

netstat -tulnp

```

**分析资源使用情况**:资源使用情况是故障排查中不可忽视的部分,尤其是CPU、内存和I/O的使用情况。

**模拟问题复现**:如果可能,尝试模拟问题发生的情况,这样更容易定位到问题。

### 5.2.2 紧急情况下的快速应对策略

在系统出现严重故障时,管理员需要快速采取行动,尽可能减少故障造成的影响。

**启用备份系统**:如果可能,立即切换到备份系统,以保持业务的连续性。

**控制故障扩散**:通过限制系统功能或流量,避免故障影响到更多的用户。

```bash

# 例如,可以临时关闭网站入口

iptables -A INPUT -p tcp --dport 80 -j DROP

```

**及时通知相关人员**:在紧急情况下,及时通知团队成员和利益相关者,协同合作解决故障。

**故障恢复后的系统检查**:在故障得到解决后,系统管理员需要对系统进行全面检查,确保系统完全稳定。

```bash

# 检查磁盘空间

df -h

# 检查网络连通性

ping -c 4 <destination>

```

**进行故障复盘**:故障解决之后,总结经验和教训,完善故障应对预案,提高未来应对故障的能力。

故障诊断与解决是一个需要经验积累的过程,随着技术的发展,新的工具和方法也在不断出现,管理员需要不断学习和适应这些变化。

以上内容展示了一部分章节内容,包括性能瓶颈识别与优化、故障诊断与解决的实践方法。在真实应用中,每个子章节都需要进一步扩展以满足字数要求,并且要通过具体的操作案例、代码示例、图表以及逻辑分析来丰富章节内容。

# 6. 监控与优化的未来趋势

在信息技术飞速发展的今天,监控和优化技术也在不断地进化,以适应更为复杂多变的IT环境。本章将探讨监控与优化领域的新兴技术和未来趋势,以及它们如何帮助企业和组织保持竞争力。

## 6.1 新兴监控技术的展望

随着技术的不断发展,新兴监控技术正逐渐崭露头角,为系统监控带来新的可能性。

### 6.1.1 人工智能在监控中的应用

人工智能(AI)技术的加入,使得监控系统不仅仅是数据的收集者,更是智能的分析者。通过机器学习算法,监控系统可以对历史数据进行学习,从而发现潜在的问题并提出预防性的解决方案。

例如,通过分析大量的日志文件和性能指标,AI可以预测系统组件的潜在故障,或在出现性能退化时及时发出警报。这不仅节省了人力资源,也极大地提高了系统的稳定性和可靠性。

### 6.1.2 预测性维护技术的发展

预测性维护是一种基于模型的维护策略,它结合了实时数据分析和预测算法来评估设备或系统的健康状态,并预测未来的性能。这种技术能够大幅减少突发故障的发生,确保业务的连续性。

通过预测性维护,IT团队可以在问题实际发生之前采取行动,进行必要的维护或升级,从而避免潜在的业务中断。

## 6.2 持续性能优化的策略

在监控和优化的过程中,持续性是非常关键的一环。企业和组织需要建立一套持续集成与持续部署(CI/CD)的策略,以及利用自动化工具来实现性能优化的持续性。

### 6.2.1 持续集成与持续部署(CI/CD)的结合

持续集成和持续部署(CI/CD)已经成为了现代软件开发和运维的行业标准。通过将CI/CD与性能监控相结合,可以确保代码变更不会对现有系统造成负面影响,并且能够在问题出现时快速回滚。

此外,监控数据可以作为反馈输入,帮助持续改进软件交付过程,使得每次迭代都能够带来性能上的提升。

### 6.2.2 自动化工具在性能优化中的作用

自动化工具可以简化许多重复性的任务,比如定期的性能测试、监控数据的收集分析以及优化措施的实施。这些工具可以显著提高效率,减少人为错误,并确保性能优化措施能够及时、准确地执行。

例如,使用自动化性能测试工具可以模拟实际用户负载,检查系统的响应时间和资源使用情况,从而找到性能瓶颈并进行优化。

随着技术的不断进步,监控与优化的未来趋势将更加智能化和自动化。企业和组织需要不断适应这些变化,才能在竞争激烈的市场中保持领先地位。通过整合新技术和策略,IT团队将能更好地应对挑战,确保业务的持续增长和优化。

0

0