编译原理词法分析性能优化:揭秘高效的秘诀

发布时间: 2024-12-27 02:27:37 阅读量: 5 订阅数: 7

编译原理词法分析器_编译原理_词法分析_

# 摘要

词法分析作为编译原理中的基础环节,对于整个编译过程的效率和准确性起着至关重要的作用。本文首先探讨了词法分析的作用和面临的挑战,并介绍了词法分析的基础理论,包括词法单元的生成、有限自动机(FA)的使用,以及正则表达式与NFA的对应关系和DFA的构造与优化。接着,本文研究了性能优化的理论基础,包括算法的时间和空间复杂度分析、分而治之策略、动态规划与记忆化搜索。在实践层面,文章分析了优化词法分析器算法实现的方法,实用工具和库的应用,以及性能测试与评估。高级词法分析技术如多模式匹配算法和流式处理也在第五章中进行了探讨。最后,文章展望了词法分析技术的未来趋势,包括人工智能的应用、持续集成的优化策略以及在教育和研究中的潜在应用。

# 关键字

词法分析;编译原理;有限自动机;性能优化;复杂度分析;人工智能;自动优化

参考资源链接:[《编译原理》词法分析器实验报告](https://wenku.csdn.net/doc/fequ7ayoco?spm=1055.2635.3001.10343)

# 1. 词法分析在编译原理中的作用与挑战

## 简介

词法分析是编译过程的第一个阶段,负责将源代码文本转换成一系列的词法单元(tokens)。这一过程是编译器不可或缺的部分,因为编译器后续的语法分析、语义分析和优化阶段都依赖于这些经过组织的词法单元。

## 词法分析的主要作用

词法分析的核心任务包括去除源代码中的空白字符、注释以及将代码分割为有意义的最小单元。这些单元通常由词法分析器(lexer)识别并创建,是后续编译步骤的基础。

## 面临的挑战

尽管词法分析看似简单,但处理各种编程语言、宏定义以及字符编码等问题时,它会遇到一系列挑战。例如,不同的编程语言有着不同的语法和关键字集合,且这些集合随版本更新而不断变化,这就要求词法分析器必须具备一定的灵活性和可扩展性。

在接下来的章节中,我们将深入探讨词法分析的基础理论,包括它的角色与任务,以及如何使用有限自动机来解决这些问题。同时,我们也会了解正则表达式和NFA、DFA的构造及其优化,这些都是实现高效词法分析器的关键技术。

# 2. 词法分析基础理论

## 2.1 词法分析器的角色与任务

### 2.1.1 从源代码到词法单元

词法分析是编译过程中的第一步,其主要任务是从源代码中识别出有意义的词法单元,也称为Token。这些Token是程序语言的最小语义单位,例如关键字、标识符、字面量、运算符和标点符号等。词法分析器通过扫描源代码文件,逐字符分析并生成相应的Token序列。

解析源代码通常涉及以下几个步骤:

1. **去除空白和注释**:在源代码中,空白字符和注释对于程序的语法结构并不重要,但它们会影响词法单元的边界定位。词法分析器首先将这些无意义的部分忽略。

2. **识别Token**:词法分析器通过特定的规则来识别Token。这些规则被定义在词法分析器的规则集中,通常这些规则包括了正则表达式。

3. **分类Token**:每识别出一个Token,词法分析器就将其归类,并赋予一个Token类型,如`INT`表示整数,`ID`表示标识符等。

4. **记录Token位置**:词法分析器还会记录每个Token的位置信息,便于后续的语法分析阶段使用。

下面是一个简单的词法分析器的伪代码,用于理解其基础工作流程:

```pseudo

function lexical_analysis(source_code):

tokens = []

position = 0

while position < len(source_code):

if source_code[position] is whitespace or comment:

position += 1

continue

token, new_position = scan_token(source_code, position)

tokens.append(token)

position = new_position

return tokens

```

该伪代码简单展示了从源代码中扫描和提取Token的过程,实际的词法分析器会更加复杂,需要处理更多边缘情况和语言特定的规则。

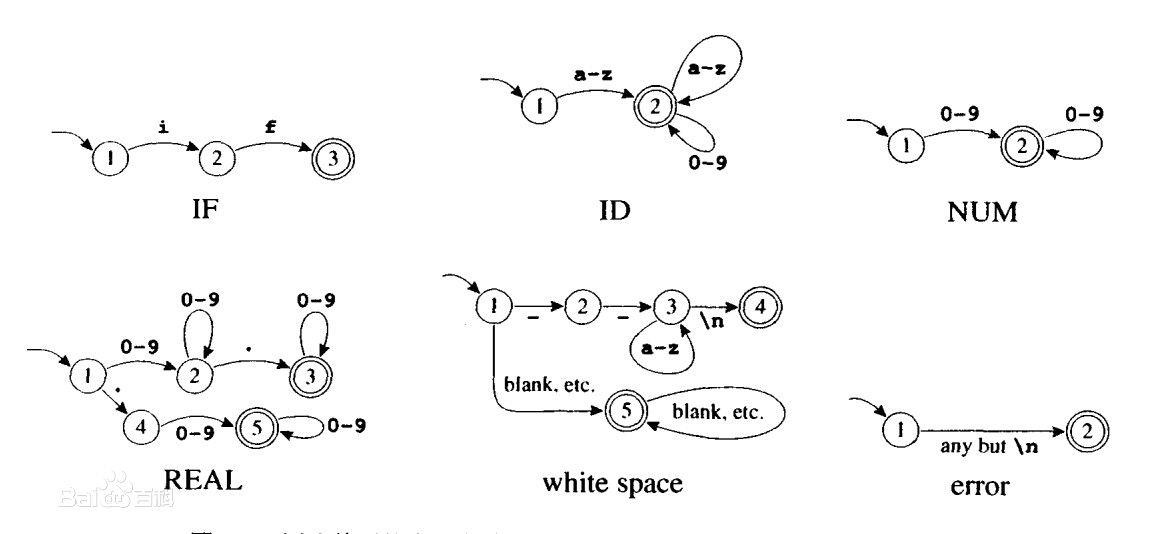

### 2.1.2 有限自动机(FA)的引入

有限自动机(Finite Automata, FA)是理论计算机科学中的一个概念,它在词法分析领域扮演着核心角色。FA由一系列状态组成,其中包含一个初始状态和一组接受状态,状态之间通过转移函数相连接。FA通过读取输入流(源代码字符)从一个状态跳转到另一个状态。

在词法分析中,FA用来识别Token类型,其中每种Token类型都与一个特定的状态转换路径相关联。当FA在识别过程中达到某个接受状态时,意味着找到了一个有效的Token。有限自动机的引入极大地简化了词法分析过程,使其实现方式更加规范和高效。

FA可以分为确定性有限自动机(Deterministic Finite Automaton, DFA)和非确定性有限自动机(Nondeterministic Finite Automaton, NFA)。其中,NFA是一种可以有多个可能的下一个状态的FA。DFA则在任意时刻对于每个可能的输入字符都有且仅有一个转移状态。

词法分析器通常会将NFA转换为等效的DFA,因为DFA在识别过程中状态唯一确定,便于计算机实现。

## 2.2 正则表达式与NFA

### 2.2.1 正则表达式的转换过程

正则表达式是描述字符序列模式的一种方式,它被广泛应用于编程语言和文本处理领域。在词法分析中,正则表达式用于定义Token的模式。例如,一个标识符可以由字母、数字和下划线组成,且首字符不能是数字。

将正则表达式转换为NFA的过程是词法分析的关键步骤,这一过程通常通过Thompson算法来实现。Thompson算法通过递归构造出一个与正则表达式对应的NFA,该算法的基本思想是:

1. 将每个正则表达式操作符(如`*`、`+`、`?`)和操作数(如字符、字符集)转换为一个或多个NFA的状态。

2. 根据正则表达式操作符的语义将这些状态通过`ε`(空)转换连接起来。例如,`a*b`中的`*`会使得`b`的状态可以接受任意个`a`。

3. 构造完成的NFA应该从一个初始状态出发,接受状态则是对应于操作符后的状态。

通过这种方式,正则表达式被转化为了NFA,词法分析器可以利用这个NFA来识别和匹配相应的Token。

### 2.2.2 NFA与正则表达式的对应关系

NFA和正则表达式之间存在明确的对应关系。在NFA中,每个状态代表了正则表达式中的一部分,例如:

- **单一字符匹配**:每个NFA状态对应正则表达式中的一个字符。

- **选择(或)操作**:NFA中的`ε`转换允许从一个状态“跳转”到另一个状态,这可以表示正则表达式中的“|”操作。

- **连接操作**:如果NFA的两个状态都是接受状态,则这两个状态可以代表一个由两个字符组成的模式。

- **重复操作**:例如,对于`*`(零个或多个)操作,可以通过一个环形的`ε`转换表示,该环连接着模式中的重复部分。

理解NFA与正则表达式之间的对应关系对于构造和优化词法分析器至关重要。程序员需要能够根据正则表达式推导出相应的NFA结构,这有助于手动优化Token的识别过程,特别是在需要精确控制词法分析器行为时。

## 2.3 DFA的构造与优化

### 2.3.1 NFA到DFA的转换

从NFA到DFA的转换是词法分析中非常关键的步骤。通过这个转换,我们可以得到一个更易于计算机处理的模型。转换通常使用子集构造法(也称为幂集构造法)进行,具体步骤如下:

1. 创建一个初始DFA状态,该状态是NFA初始状态的ε闭包。ε闭包是指从一个状态出发,通过所有可能的`ε`转移可以到达的所有状态集合。

2. 对于DFA中的每个状态和输入符号,找到下一个可能的状态。这可以通过从当前DFA状态开始,查看在输入符号作用下NFA可能达到的所有状态来完成。

3. 创建新的DFA状态,只要它们还不存在于DFA中。这样,通过重复步骤2,我们就可以获得完整的DFA。

DFA在每个状态对于每个可能的输入字符都有唯一的转移状态,这使得它在实际应用中效率更高。词法分析器可以快速地根据当前状态和输入字符确定下一个状态,而无需回溯或进行复杂的搜索。

```pseudo

function subset_construction(NFA):

DFA_states = []

start_state = ε-closure(NFA.start_state)

DFA_states.add(start_state)

queue = new Queue()

queue.enqueue(start_state)

while not queue.empty():

current_state = queue.dequeue()

for char in input_alphabet:

next_state = ε-closure(move(current_state, char))

if next_state not in DFA_states:

DFA_states.add(next_state)

queue.enqueue(next_state)

return DFA_states

```

该伪代码描述了NFA到DFA的转换过程。为了提高效率,通常会采用表驱动的方法,将转换表存储在内存中,以便快速访问。

### 2.3.2 DFA的最小化处理

在构造出DFA之后,其状态数量可能会比NFA转换出的状态数量更多,这会导致效率问题。为了提高词法分析器的性能,通常会采用DFA最小化技术。DFA最小化的目标是找到一个等价的、状态数最少的DFA。

DFA最小化的过程基于等价状态的合并,具体步骤如下:

1. **消除死状态**:首先识别并消除DFA中任何无法到达接受状态的状态。

2. **区分状态**:创建一个表,列出所有状态对,并标记哪些状态对在任何输入下都有相同的行为。

3. **合并等价状态**:在表中找到可以合并的状态,将它们合并为一个状态。重复这个过程直到无法再合并为止。

4. **构建新的DFA**:根据合并后的状态,重建一个状态更少的DFA。

通过最小化DFA,我们可以确保词法分析器只使用必要的状态进行处理,从而减少其内存消耗和加快处理速度。

```pseudo

function minimize_dfa(DFA):

live_states = find_live_states(DFA)

equivalent_table = build_equivalence_table(DFA, live_states)

while not equivalent_table.is_stable():

for state_pair in equivalent_table:

if state_pair.can_be_merged():

merge_states(state_pair, DFA)

return DFA

```

该伪代码简化地展示了DFA最小化的过程。在实际应用中,最小化算法可能会更复杂,以处理各种特殊情况和提高效率。

0

0