【自适应算法】:宽带信号DOA估计研究的新进展

摘要

宽带信号的方向到达(DOA)估计在无线通信、雷达定位和声纳系统中发挥着关键作用。本文首先回顾了DOA估计的理论基础,然后分析了传统DOA估计算法,指出了它们的局限性,包括分辨率和计算复杂度问题。接着,我们探讨了自适应算法在DOA估计中的应用,从基本原理、具体实现到性能评估,并介绍了优化策略和混合算法的协同优化。最后,我们展望了深度学习与自适应算法结合的可能性和自适应算法在未来宽带信号处理中的应用潜力,尤其是在5G/6G通信技术中的融合前景。

关键字

宽带信号;DOA估计;传统算法;自适应算法;深度学习;协同优化

参考资源链接:宽带阵列信号处理:ISM与CSM算法对比分析

1. 宽带信号DOA估计的理论基础

1.1 DOA估计概述

方向性到达(Direction of Arrival,DOA)估计是信号处理领域的一个核心问题,其主要目标是准确地确定信号源的方向。在宽带信号处理中,DOA估计不仅涉及信号的时延,还需考虑到信号带宽内的频率变化,这使得问题变得复杂化。

1.2 数学模型与信号表达

在数学模型中,多个信号源到达接收阵列时,可以通过线性代数来描述信号的传播和接收过程。利用阵列信号处理技术,可以建立信号源、阵元位置和接收信号之间的关系。信号在阵列上产生的信号模型通常可以表示为接收信号向量与信号源方向向量的线性组合。

1.3 DOA估计的重要性和应用

DOA估计技术广泛应用于雷达、声纳、移动通信、无线定位等多个领域。精确估计信号的到达方向对于提高通信系统性能、增加频谱利用效率、提供高质量服务具有决定性作用。随着无线通信技术的发展,对DOA估计的精度和实时性的要求越来越高,这促使研究者不断探索更高效、更准确的算法。

2. 传统DOA估计算法分析

2.1 空间谱估计方法概述

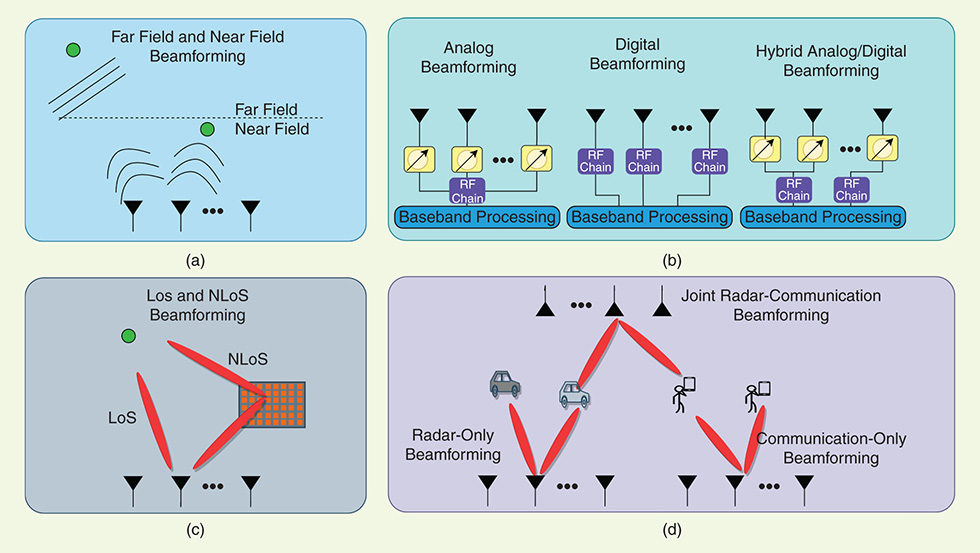

2.1.1 波束形成技术

波束形成是传统方向估计中的一种常见技术,主要利用阵列天线接收信号的空间特性,通过适当加权和合成各个阵元的信号,形成特定方向上的信号增强或抑制效果。

通过设置不同的权重系数,可以实现对特定方向信号的增强,从而使得阵列对准该方向形成波束。相反,若要抑制某个方向的信号,则相应方向的权重系数会被设为零或负值。

波束形成技术的一个关键优点是它的实时性和灵活性,可以通过调整权重系数以适应不断变化的环境。然而,它也存在一些局限性,例如对于近场源和非相干信号源的处理能力有限。

2.1.2 常见的空间谱估计算法

空间谱估计中,最为经典的算法包括:MUSIC(Multiple Signal Classification)、ESPRIT(Estimation of Signal Parameters via Rotational Invariance Techniques)和Root-MUSIC。这些算法基于信号的自相关矩阵,估计出信号的到达角度。

- MUSIC算法:利用信号子空间和噪声子空间的正交性质,估计信号到达角。

- ESPRIT算法:不需要信号自相关矩阵的特征值分解,减少了计算量。

- Root-MUSIC算法:是MUSIC算法的变种,通过多项式根寻找信号源的方向。

上述算法各有优势和不足,通常需要根据实际的信号环境和处理需求选择最合适的算法。

2.2 传统DOA估计算法的局限性

2.2.1 分辨率限制

分辨率是DOA估计算法能够区分的最小角度间隔。传统的算法在分辨率上通常受限于信号的波长、阵列的物理尺寸和阵元数量。

波长越短,理论上可以实现更高的角度分辨率。然而,在实际应用中,分辨率的提升也受限于阵列天线的最小间距,过小的间距会导致信号波前的畸变和测量误差。

2.2.2 计算复杂度问题

传统算法在计算复杂度方面存在一定的挑战。尤其是在处理大规模阵列或是实时应用场景时,算法的计算量和存储需求迅速增加。

计算复杂度问题不仅影响算法的实时性,也对硬件性能提出了更高要求。因此,在设计传统DOA估计算法时,需要在估计精度和计算效率之间寻求平衡。

在本章节中,我们已经分析了传统DOA估计算法的基础知识,包括波束形成技术、空间谱估计方法以及它们的局限性。接下来,我们将深入探讨自适应算法在DOA估计中的应用,并对其性能进行评估。

3. 自适应算法在DOA估计中的应用

3.1 自适应算法的基本原理

3.1.1 自适应信号处理简介

自适应信号处理是一种基于信号环境自动调整其参数的信号处理方法。它与传统的信号处理方法不同,不需要预先了解信号特性和环境信息。自适应算法能够根据接收到的信号和期望的性能目标,实时地调整滤波器的参数,从而达到最佳的信号处理效果。

自适应算法的核心在于其能够根据信号的统计特性进行自我调整和学习。这在多径和干扰环境中的通信系统中尤为重要,因为在这样的环境下,信号特性的变化是动态的。自适应算法的这些特性使其非常适合应用于DOA估计中,能够提高估计的准确性和鲁棒性。

3.1.2 最小均方误差(LMS)和递归最小二乘(RLS)算法

最小均方误差(LMS)算法是自适应信号处理中最简单的算法之一。它通过迭代过程最小化误差信号的均方值,以确定最佳滤波器的权重。LMS算法的一个关键优点是其算法简单,计算复杂度低。然而,它也存在着收敛速度慢和对输入信号的自相关矩阵特征值分布敏感的缺点。

递归最小二乘(RLS)算法则提供了更快的收敛速度和更好的跟踪性能。RLS算法是通过递归更新估计误差的二阶统计量来实现的,从而能够更快速地适应信号环境的变化。但是,RLS算法也有其不足,如较高的计算复杂度和数值稳定性问题。

- # LMS算法的简单实现

- def lms_filter(x, d, mu, N):

- """

- x: 输入信号

- d: 期望信号

- mu: 步长因子

- N: 滤波器权重的数量

- """

- h = np.zeros(N) # 初始化权重向量

- y = np.zeros(len(d)) # 初始化输出信号

- for n in range(N, len(x)):

- x_n = x[n-N:n] # 获取最新样本块

- y[n] = np.dot(h, x_n) # 计算输出

- e = d[n] - y[n] # 计算误差