【高级数据处理】:特征选择与正则化技术的巧妙结合

发布时间: 2024-11-22 20:25:12 阅读量: 34 订阅数: 32

前端面试攻略(前端面试题、react、vue、webpack、git等工具使用方法)

# 1. 数据预处理的重要性与方法

在机器学习与数据科学领域,数据预处理是任何项目成功的基石。未经处理的原始数据常常包含噪声、缺失值以及不一致性,这些因素都会对模型的性能产生负面影响。因此,数据预处理不仅确保了数据质量,也为后续特征工程和模型训练打下了坚实的基础。

## 1.1 数据清洗

数据清洗是预处理的首要任务,包括处理缺失值、异常值、重复数据和数据类型转换。对于缺失值,常见的处理方法有删除含有缺失值的记录、填充缺失值(使用均值、中位数或众数)或插值。异常值的检测可以通过统计测试(如Z-score)或可视化方法(如箱型图)来进行。

## 1.2 数据规范化与归一化

数据规范化和归一化是将数据缩放到某一特定范围内的过程,常见的方法有最小-最大规范化(Min-Max Scaling)、z得分标准化(Z-Score Normalization)。例如,最小-最大规范化通常使用公式 (x - min) / (max - min) 将数据缩放到[0, 1]区间。

## 1.3 特征编码

在处理非数值型数据时,特征编码是不可或缺的步骤。常见的编码方法包括独热编码(One-Hot Encoding)和标签编码(Label Encoding)。独热编码适用于类别互斥的情况,而标签编码则适用于类别之间存在顺序关系的场景。

通过以上步骤,我们可以确保数据集的质量,为后续的建模工作提供更为准确和可靠的输入数据。这不仅能够提高模型训练的效率,还能增强模型预测的准确性和鲁棒性。

# 2. 特征选择的理论基础与实践技巧

## 2.1 特征选择的基本概念

### 2.1.1 特征选择的定义与目标

特征选择是机器学习领域的一个重要步骤,它涉及从原始特征集中挑选出一组最优特征,以便提高模型的预测性能、减少模型复杂度、缩短训练时间并防止过拟合。定义上,特征选择是一种降低数据维数的方法,通过剔除不相关或冗余的特征,保留最能代表数据本质的特征子集。

在目标上,特征选择的目的是为了实现以下几点:

- **提高准确性**:去掉噪声和不相关特征,使模型专注于有效信息。

- **减少计算成本**:通过降低特征数量减少模型训练和预测的时间复杂度。

- **提升可解释性**:特征较少的模型更容易解释和理解。

- **防止过拟合**:通过选择最相关的特征降低模型复杂度,提高泛化能力。

### 2.1.2 特征选择的方法分类

特征选择方法可以被大致分为三类:过滤法(Filter Methods)、包裹法(Wrapper Methods)和嵌入法(Embedded Methods)。

- **过滤法**通过统计测试来评估每个特征与目标变量之间的独立关系,不依赖于任何特定的机器学习算法。它是一个快速且相对无偏差的方法。

- **包裹法**把特征选择看作一个搜索问题,尝试所有可能的特征子集,并使用某个学习算法来评估每个子集的性能。这种方法通常比过滤法更准确,但是计算成本高。

- **嵌入法**在学习算法的训练过程中进行特征选择。特征被挑选的方式是算法的一部分,例如在决策树或正则化模型中。它通常比前两种方法更快,并且通常比包裹法更准确。

## 2.2 特征选择的算法详解

### 2.2.1 过滤法(Filter Methods)

过滤法是基于数据的统计特性来评估特征重要性的方法。例如,卡方检验(Chi-squared test)、信息增益(Information Gain)、相关系数(Correlation Coefficient)等都是常见的过滤法。

以卡方检验为例,它假设特征与目标变量相互独立,使用卡方统计量来量化两者之间的关系强度。特征与目标变量越不独立,卡方值越高,特征越有可能是重要的。过滤法的计算成本相对较低,但可能不考虑特征与模型之间的交互作用。

### 2.2.2 包裹法(Wrapper Methods)

包裹法考虑了特征子集与模型之间的关系。最著名的包裹法是递归特征消除(Recursive Feature Elimination, RFE),它使用一个学习器来评估特征的重要性,然后逐步剔除不重要的特征。

RFE的工作原理是:训练一个模型,评估各个特征的重要性,移除最不重要的特征,然后重复上述过程。RFE对特征进行多次排列组合,直到达到预设的数量为止。尽管包裹法通常提供最佳的特征集,但因为需要多次训练模型,所以其计算开销较大。

### 2.2.3 嵌入法(Embedded Methods)

嵌入法通过结合模型的构建和特征选择来工作。例如,岭回归(Ridge Regression)和Lasso回归就是两种具有内置特征选择功能的回归技术。嵌入法在训练数据上运行时对数据进行特征选择。

以岭回归为例,它通过引入L2范数正则化项来对特征权重施加惩罚,从而导致一些特征权重趋近于零,从统计上将其排除。尽管这种方法在模型构建过程中考虑了特征选择,但它不适用于所有模型,并且在某些情况下,特征选择的能力可能有限。

## 2.3 特征选择实践案例分析

### 2.3.1 实际数据集的选择与准备

假设我们有一个用于信用评分的金融数据集。它包含了多种类型的特征,比如贷款金额、还款期限、收入水平、已有的信用历史等。为了进行特征选择,我们首先需要准备数据,包括数据清洗(去除缺失值、异常值处理)和数据转换(比如将非数值型数据编码为数值型)。

### 2.3.2 特征选择算法的对比实验

我们将使用上述提到的过滤法、包裹法和嵌入法进行特征选择,并对选定的特征子集训练几个不同类型的模型(如决策树、随机森林、支持向量机等),然后对它们的性能进行比较。

### 2.3.3 结果评估与分析

利用交叉验证和各种性能指标(如准确度、精确度、召回率和F1分数)对结果进行评估。通过对比不同算法的模型性能和特征重要性评分,我们可以得出最优的特征选择策略。通常,实验表明,嵌入法在保持较低计算成本的同时,可以得到较为理想的性能指标,而包裹法则提供了最好的性能,但计算成本较高。过滤法的性能介于两者之间。

在实际应用中,应根据问题的具体情况和模型需求,选择合适的特征选择方法。例如,在资源受限的情况下,过滤法可能是最佳选择,而在需要最大限度提高模型性能时,则应考虑使用包裹法。

在这一章节中,我们深入了解了特征选择的理论基础,探讨了过滤法、包裹法、嵌入法这三种主要方法,并通过实验分析了它们在具体案例中的应用效果。这为我们后续的模型优化和正则化技术的应用奠定了基础。

# 3. 正则化技术的理论与应用

## 3.1 正则化技术概述

### 3.1.1 正则化的定义与作用

在机器学习模型训练过程中,为了防止模型过度拟合训练数据而丢失泛化能力,引入了正则化技术。正则化通过增加一个额外的惩罚项到模型的损失函数中,强制模型权重向量的某种特性,例如稀疏性或平滑性,以此来限制模型的复杂度。简而言之,正则化是一种在模型学习过程中约束模型复杂度的方法,使得模型对新样本具有更好的泛化能力。

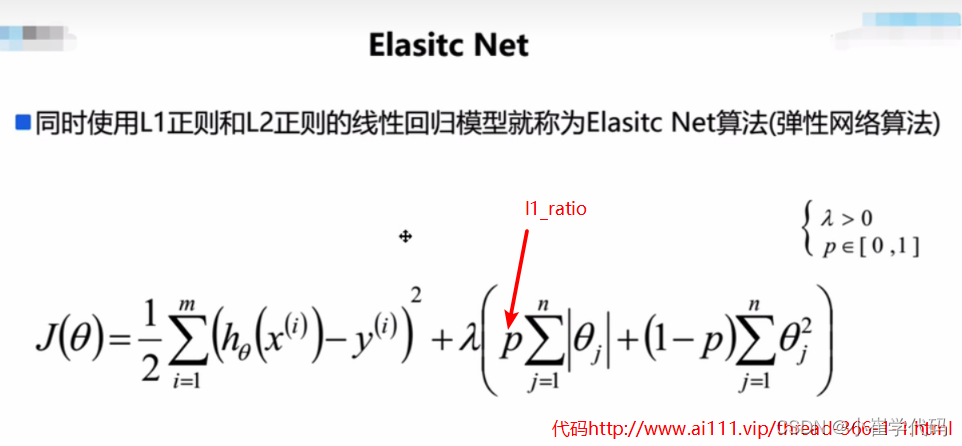

正则化项通常与模型的参数成比例,常用的正则化项包括L1和L2范数。L1正则化倾向于生成稀疏的模型权重,而L2正则化则倾向于限制参数的大小,使参数值更加平滑。通过在损失函数中添加正则化项,可以有效避免模型过拟合,从而提升模型对未知数据的预测准确性。

### 3.1.2 正则化与过拟合的关联

过拟合是机器学习中一个常见的问题,它发生在模型对训练数据学习得太好,以至于它学习到了训练数据中的噪声和异常值,而这些并不适用于新的、未见过的数据。正则化技术通过限制模型复杂度,有效地减少了过拟合的风险。

在实际应用

0

0