【硬件加速器解读】:揭秘CPU、GPU与TPU,选择最适合的深度学习硬件

发布时间: 2024-12-14 19:48:05 阅读量: 10 订阅数: 10

加速深度学习任务:TensorFlow GPU 教程

参考资源链接:[DBCLOUD Lab环境配置:从Anaconda安装到终端连接](https://wenku.csdn.net/doc/7sj58h50z2?spm=1055.2635.3001.10343)

# 1. 深度学习硬件概述

随着深度学习的快速发展,其背后的硬件支持变得至关重要。硬件是深度学习模型训练和推理的基石,不同的硬件架构决定了它们在处理复杂计算任务时的效能和效率。在本章中,我们将介绍深度学习中常用的硬件类型,包括CPU、GPU和TPU,以及它们如何通过各种机制来优化深度学习工作负载。本章旨在为读者提供一个关于深度学习硬件发展的概览,为深入探讨各种硬件的特点和应用打下基础。

# 2. CPU在深度学习中的角色

## 2.1 CPU的架构与工作原理

### 2.1.1 CPU的基本组成

CPU(中央处理器)是计算机的核心部件,负责执行指令和处理数据。它主要由几个关键部分组成:算术逻辑单元(ALU),控制单元(CU),寄存器和高速缓存(Cache)。算术逻辑单元执行所有的算术和逻辑操作。控制单元负责从内存中获取指令,解码这些指令,并控制数据流向,以确保指令的正确执行。寄存器是CPU内部的临时存储区域,提供快速的数据存取。高速缓存则由高速RAM组成,它存储着频繁访问的数据和指令,减少了CPU访问主存的需求,加快了处理速度。

### 2.1.2 CPU并行处理的机制

CPU的并行处理能力主要通过其内部的多核架构来实现。每个核心可以独立处理任务,这意味着CPU可以在同一时间内运行多个线程,从而实现多任务并行。此外,超线程技术(Hyper-Threading)允许每个核心同时运行多个线程。虽然物理上只有一套计算资源,但逻辑上每个核心能够模拟出两套资源,提高了资源利用率。这种设计显著提高了CPU的并发处理能力,使其在需要高度优化的串行算法上表现出色。

## 2.2 CPU的深度学习性能分析

### 2.2.1 CPU的适用场景

尽管GPU在处理深度学习任务方面非常流行,但CPU在某些情况下仍然具有其独特的优势。对于数据量不是非常大的简单模型,或者对模型训练速度要求不是特别高的场景,CPU可以提供足够的性能。此外,CPU在处理结构化数据和执行复杂的逻辑控制任务方面性能优良,适合用作深度学习模型的前期数据预处理和后处理。另外,CPU擅长执行复杂的串行计算任务,因此在深度学习中,它可以处理如模型优化、超参数调优等环节。

### 2.2.2 CPU优化策略

为了提升CPU在深度学习任务中的性能,开发者可以采取一些优化策略。首先,优化代码的串行部分,以减少不必要的计算和数据移动。其次,利用多线程或并行计算库(如OpenMP、Intel TBB等)来提升CPU的并行计算能力。此外,深度学习框架(如TensorFlow、PyTorch等)中的算子优化和内存管理也对性能提升至关重要。最后,合理使用CPU的高速缓存,例如通过数据预取(prefetching)技术减少内存访问延迟,对提高整体性能有着显著影响。

```mermaid

graph LR

A[深度学习任务] -->|数据预处理| B(CPU)

B --> C[模型训练]

C -->|模型优化与调优| B

B --> D[模型部署]

```

### 表格:CPU与GPU深度学习性能对比

| 性能指标 | CPU | GPU |

| --- | --- | --- |

| 并行处理能力 | 低 | 高 |

| 适用数据规模 | 较小 | 较大 |

| 结构化数据处理 | 优 | 良 |

| 复杂逻辑控制 | 优 | 良 |

| 算子优化 | 良 | 优 |

| 内存管理 | 良 | 优 |

在上表中,我们可以看到CPU在处理结构化数据和执行复杂逻辑控制任务方面有其优势,但在并行处理能力和内存管理方面,GPU显然更胜一筹。

在优化CPU性能时,合理的代码设计和使用专业库是至关重要的,通过编写高效的并行代码和利用缓存机制,可以在一定程度上缓解CPU在处理大规模深度学习任务时可能遇到的瓶颈。

# 3. GPU与深度学习的契合度

GPU的崛起与深度学习的普及息息相关。在这一章,我们将详细探讨GPU的架构与工作原理,同时分析在深度学习领域中GPU所展现的优势以及所面临的挑战。

## 3.1 GPU的架构与工作原理

### 3.1.1 GPU的核心设计

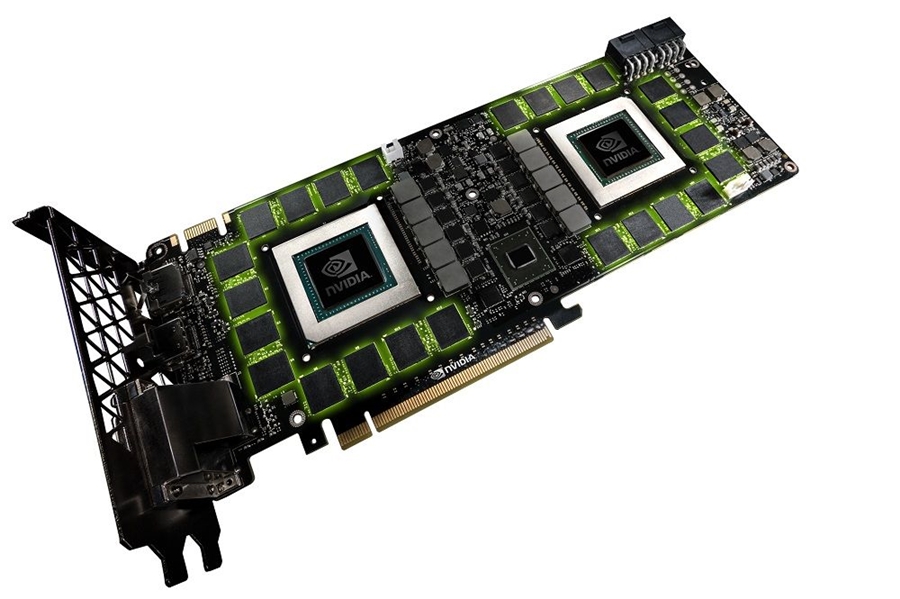

GPU(图形处理单元)最初是为图形渲染而设计,但随着技术的发展,GPU逐渐被发现拥有强大的并行计算能力,使其在深度学习领域大放异彩。其核心设计理念强调高吞吐量,这意味着GPU擅长于执行大量的简单指令,而深度学习正是一个高度并行和重复的数据处理过程。

GPU拥有多达数百甚至数千个小核心(称为流处理器或CUDA核心),这些核心可以同时运行相同的程序,但对不同的数据进行操作。这种设计允许GPU在进行大量矩阵运算和数据处理时,比传统CPU更

0

0