QEMU-KVM优化基础:5个步骤降低虚拟机CPU占用

发布时间: 2024-12-20 03:01:10 阅读量: 6 订阅数: 4

# 摘要

随着云计算和数据中心的发展,虚拟化技术成为优化资源管理和提升服务效率的关键工具。本文首先探讨了虚拟化技术和CPU占用的关系,然后详细介绍了QEMU-KVM的配置、优化理论和性能监控。通过对QEMU-KVM架构的剖析,本文提供了CPU和内存资源优化的策略,并且通过性能监控工具来识别和分析系统的性能瓶颈。在此基础上,进一步提出了高级CPU特性应用、虚拟机配置文件优化以及负载平衡和动态迁移等深入优化方法。文章最后通过案例分析,提供了实际性能瓶颈的诊断和优化经验,强调了性能优化工具和脚本在自动化优化过程中的重要性,旨在为系统管理员和虚拟化工程师提供实用的性能调优指导。

# 关键字

虚拟化;QEMU-KVM;CPU占用;性能监控;资源优化;动态迁移

参考资源链接:[QEMU-KVM CPU高占用问题分析与解决](https://wenku.csdn.net/doc/6czan78r1o?spm=1055.2635.3001.10343)

# 1. 理解虚拟化与CPU占用

## 1.1 虚拟化技术简述

虚拟化技术通过创建虚拟机(VM)抽象硬件资源,使得多个操作系统可以同时在一个物理服务器上运行。这种方式极大提高了硬件资源的利用率,同时实现了系统的灵活性和隔离性。

## 1.2 CPU占用的重要性

在虚拟化环境中,CPU资源尤为关键,因为它直接决定了系统的性能和响应速度。合理地管理CPU资源,优化虚拟机的CPU占用,可以提升整体的计算效率和用户体验。

## 1.3 CPU占用与虚拟机性能的关系

CPU占用过高会导致虚拟机响应缓慢,甚至出现故障。掌握虚拟机的CPU占用情况,对于维护系统稳定和优化性能至关重要。本章节将详细解读CPU占用与虚拟机性能之间的关联,并提供相应的分析和调优方法。

# 2. QEMU-KVM的基本配置和优化理论

### 2.1 QEMU-KVM架构概述

#### 2.1.1 KVM的工作原理

KVM(Kernel-based Virtual Machine)是Linux内核的一个模块,它利用硬件虚拟化技术扩展(如Intel VT或AMD-V),允许Linux内核直接作为虚拟机监控器(Hypervisor)运行。KVM通过将客户机操作系统运行在内核空间的虚拟处理器(vCPU)上,使客户机与物理硬件隔离,实现了虚拟化。KVM本身并不进行任何模拟,它依赖于宿主机的硬件支持以及QEMU提供的设备模拟和虚拟化辅助功能。

在KVM架构中,虚拟机管理程序创建并管理虚拟机实例,每个实例对应一个或多个vCPU以及必要的设备模拟。当客户机执行需要硬件支持的操作时,它通过特殊的硬件中断通知KVM,这时KVM会将控制权转交给宿主机的操作系统处理。因此,KVM的性能接近裸机运行,但需要保证宿主机支持硬件虚拟化。

#### 2.1.2 QEMU的作用和虚拟化类型

QEMU是一个开源的机器模拟器和虚拟化器,能够模拟多种CPU架构,包括x86、ARM、MIPS等。QEMU通过软件来模拟硬件设备,包括CPU、内存、硬盘、网络等,以实现虚拟化的功能。

QEMU提供了两种虚拟化类型:

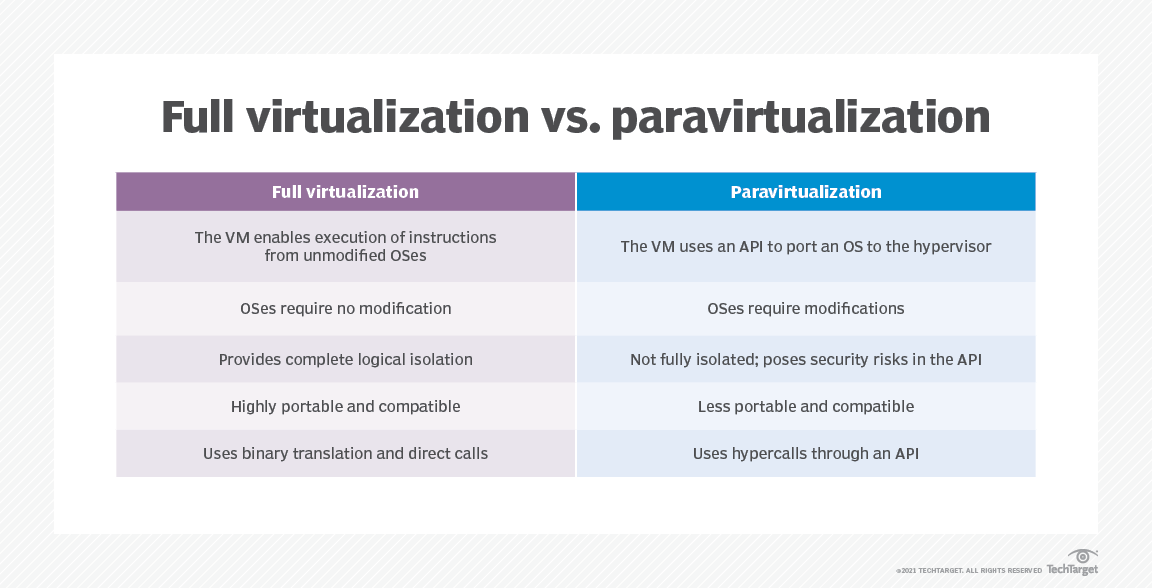

- 全虚拟化(Full Virtualization):QEMU可以模拟完整的硬件环境,使客户机操作系统无需任何修改就可以运行在虚拟机中。这通常涉及到模拟硬件设备,因此性能会有所下降。

- 半虚拟化(Para-Virtualization,PV):在这种模式下,QEMU不完全模拟硬件设备,而是让客户机操作系统使用特殊版本的内核,这些内核经过优化以适应虚拟化环境。半虚拟化通常提供更好的性能,因为客户机操作系统可以与QEMU直接交互,而不必模拟完整的硬件接口。

### 2.2 CPU资源分配基础

#### 2.2.1 CPU亲和性和虚拟CPU调度

在虚拟化环境中,CPU亲和性(Affinity)指的是虚拟CPU(vCPU)与物理CPU(pCPU)之间的绑定关系。合理设置CPU亲和性可以减少上下文切换,提升性能。CPU亲和性可以通过设置QEMU命令行参数或者编辑虚拟机配置文件来实现。例如,使用`taskset`命令在Linux中对进程进行CPU亲和性设置。

虚拟CPU调度关注的是如何高效地在物理CPU上分配虚拟机的vCPU。KVM和QEMU组合使用了Linux内核的调度器来管理这些vCPU。调度器会周期性地在宿主机的CPU上分配和运行vCPU。例如,使用`nice`和`cpuset`命令来设置进程优先级和亲和性,影响调度器的行为。

#### 2.2.2 CPU共享与隔离的权衡

在虚拟化环境中,CPU共享与隔离是两个相互竞争的需求。CPU隔离确保虚拟机获得确定的资源,而CPU共享则允许多个虚拟机共享同一组物理CPU资源,以提高资源利用率。

在理想情况下,我们希望在不牺牲隔离性的情况下实现CPU资源的高效共享。为了达到这种平衡,可以使用cgroups(控制组)来限制、记录和隔离宿主机的物理CPU资源使用。通过cgroups,管理员可以定义一组进程并指定它们可以使用的CPU数量和百分比,从而在虚拟机之间分配CPU资源。

### 2.3 内存资源优化

#### 2.3.1 内存分配策略

内存是虚拟化中的另一个关键资源。QEMU-KVM允许管理员通过多种策略来分配内存给虚拟机:

- 静态分配(Static):内存被预分配给虚拟机,并且在虚拟机运行期间不会改变。这种方式确保了虚拟机的性能,但可能导致物理内存的浪费。

- 动态分配(Balloon):使用动态内存技术,如KVM的balloon驱动,虚拟机会根据实际需要,通过宿主机内核的内存分配器来获得或释放内存。这种方式可以提高物理内存的使用效率,但可能会增加虚拟机的启动和停止时间。

- 自动过量分配:QEMU-KVM还允许管理员设置内存过量分配,这样多个虚拟机可以使用比物理内存更多的内存,只要这些虚拟机不会同时要求使用所有分配的内存。

#### 2.3.2 内存页大小和透明大页

内存页大小对于虚拟机的性能有着显著的影响。较大的内存页可以减少页表的深度和大小,从而减少地址转换的开销。但是,大的内存页也可能导致内存碎片化问题,使得内存利用率下降。

Linux系统中的透明大页(Transparent Huge Pages, THP)是一种内核特性,它可以自动将小的内存页合并成大的内存页。在虚拟化环境中使用THP可以提升I/O性能,因为虚拟机的I/O设备通常需要大量内存进行DMA(直接内存访问)操作。然而,自动管理内存页也会带来管理上的复杂性,并且在某些情况下可能会导致性能下降。因此,管理员需要根据实际场景仔细权衡是否开启透明大页特性。

```markdown

| 内存分配策略 | 描述 | 优点 | 缺点 |

| ------------ | --- | ---- | ---- |

| 静态分配 | 预先分配固定大小的内存给虚拟机 | 性能稳定,没有页表管理开销 | 可能会造成内存的浪费 |

| 动态分配 | 虚拟机根据实际需求动态请求或释放内存 | 提高物理内存的使用效率 | 启动和停止虚拟机的响应时间会增加 |

| 自动过量分配 | 允许虚拟机请求的内存总和超过宿主机物理内存的总量 | 允许多个虚拟机使用更多内存,提高资源利用率 | 需要精心配置以避免内存不足时的竞争 |

```

```mermaid

graph LR

A[开始内存分配优化] --> B[评估虚拟机工作负载]

B --> C[选择内存分配策略]

C --> D[静态分配]

C --> E[动态分配]

C --> F[自动过量分配]

D --> G[设置固定内存大小]

E --> H[使用内存分配器调整内存]

F --> I[配置内存过量分配参数]

G --> J[监控性能]

H --> J

I --> J

J --> K{是否满足性能要求?}

K -->|是| L[优化完成]

K -->|否| M[重新评估并调整内存分配策略]

```

```bash

# 示例:通过命令行为虚拟机分配内存

# 为名为"testvm"的虚拟机分配静态1GB内存

virsh setmem testvm --size 1048576 --live

```

以上命令中的`--size`参数指定了虚拟机的内存大小(单位为KB),而`--live`表示在虚拟机运行时进行内存调整。

```bash

# 示例:开启透明大页

# 编辑/etc/default/grub文件并添加以下行

GRUB_CMDLINE_LINUX="transparent_hugepage=always"

# 更新GRUB配置并重启系统

update-grub

reboot

```

开启透明大页后,内核会尝试创建尽可能多的大页,但请注意,这可能需要根据应用负载进行调整以达到最佳性能。

# 3. QEMU-KVM的性能监控与调优实践

在上一章中,我们了解了QEMU-KVM架构的原理及CPU资源分配基础。现在我们将深入探讨性能监控工具的使用和调优技巧。通过实际案例分析,我们将展示如何在虚拟环境中实现性能监控与调优的实践操作,以及如何利用这些工具来提升虚拟机的整体性能。

## 3.1 性能监控工具的使用

性能监控是任何性能调优过程的第一步。通过性能监控,我们可以获得系统和虚拟机的运行状态,以数据为基础来判断哪些方面需要优化。

### 3.1.1 使用vmstat监控CPU使用情况

vmstat是一个非常有用的工具,用于监视系统的内存、进程、I/O和CPU的使用情况。

```bash

vmstat 2 10

```

该命令每2秒刷新一次数据,总共刷新10次。输出结果将包括以下几个部分:

- Procs:进程相关信息,包括运行的任务数(r)和睡眠的任务数(b)。

- Memory:内存使用情况,包括总内存(total)、空闲内存(free)、使用中的内存 used)、缓冲区(buffer)以及缓存(cache)。

- Swap:交换区使用情况,包括交换分区的总量(total)、空闲量(free)和使用量 used)。

- IO:输入输出设备的使用情况,包括每秒读取的块数(bi)和每秒写入的块数(bo)。

- System:系统相关信息,包括中断次数(in)和上下文切换次数 cs)。

- CPU:CPU使用情况,包括用户态(user)、系统态 sys)、空闲(idle)、等待 I/O的时间(iowait)、处理硬中断的时间(irq)和处理软中断的时间(softirq)。

### 3.1.2 使用htop和pidstat工具深入了解

htop是一个互动的进程查看器,相比于top,htop提供了更丰富的视图和信息。

```bash

htop

```

通过htop,我们可以实时地看到各个进程的CPU使用情况,并且能够进行进程管理,如结束进程、调整进程优先级等。htop将进程按照CPU使用率进行排序,这对于识别消耗CPU资源最多的进程非常有用。

另一方面,pidstat是sysstat包中的一个工具,它可以显示每个进程的CPU使用情况。

```bash

pidstat 2 5

```

该命令每隔2秒输出一次进程的CPU使用情况,并且总共输出5次。这有助于我们了解进程的CPU使用趋势。

## 3.2 调优技巧与案例分析

调优是根据监控到的性能指标来进行的。以下是一些关键的调优技巧和使用案例进行深入分析。

### 3.2.1 预留CPU核心与调整虚拟机优先级

在分配CPU资源时,我们可以通过KVM的命令行选项来预留CPU核心。这样可以确保重要的进程或虚拟机有足够的资源运行。

```bash

kvm -smp 4,cores=2,threads=2 -cpu host -enable-kvm

```

此命令配置了4个虚拟CPU,其中每个虚拟CPU由两个核心和两个线程组成,并保留了主机CPU的特性。

同时,我们还可以通过调整虚拟机的优先级来改善其运行。在Linux中,可以通过renice命令来改变进程的优先级。

```bash

renice -n -10 -p <PID>

```

这里,我们把指定的PID进程的优先级提高到最高级别。

### 3.2.2 CPU绑定与pinning实践

CPU绑定(也称为CPU pinning)是将特定的虚拟CPU绑定到特定的物理CPU。这样可以减少虚拟CPU在物理CPU之间切换的开销,提高性能。

```bash

virsh vcpupin <VM_NAME> <VCPUs> <CPUs>

```

例如,如果我们有一个名为"testvm"的虚拟机,并且我们想要把它的虚拟CPU 0绑定到物理CPU 2,我们会运行:

```bash

virsh vcpupin testvm 0 2

```

### 3.3 虚拟机CPU优化的具体操作

在这一部分,我们将探讨如何根据虚拟机的负载情况调整CPU数量以及使用任务set亲和性来优化CPU使用。

### 3.3.1 根据负载调整CPU数量

虚拟机的CPU数量可以根据负载动态调整。如果虚拟机经常处于高负载状态,我们可能需要为其分配更多的CPU。相反,如果CPU使用率很低,可以减少分配的CPU数量以节省资源。

```bash

virsh setvcpus <VM_NAME> <NUMBER_OF_VCPUS>

```

### 3.3.2 使用任务set亲和性来优化CPU使用

任务set亲和性允许我们指定进程应当运行在哪些CPU上。这有助于减少缓存的失效和提高缓存利用率,从而提升性能。

```bash

taskset -cp <CPU_LIST> <PID>

```

例如,如果我们想要让PID为1234的进程仅在CPU 0和CPU 1上运行,我们可以使用以下命令:

```bash

taskset -cp 0,1 1234

```

通过上述章节的介绍,我们了解了QEMU-KVM性能监控与调优实践的基本方法。接下来,我们将深入探讨如何通过高级CPU特性使用和虚拟机配置文件优化来进一步提升性能。

# 4. 深入优化QEMU-KVM虚拟机CPU性能

## 4.1 高级CPU特性使用

### 4.1.1 开启硬件辅助虚拟化支持

在当今的虚拟化环境中,硬件辅助虚拟化技术已经成为一个不可或缺的部分。它通过提供专门的虚拟机管理硬件支持,来优化虚拟机的执行效率。硬件辅助虚拟化技术通常依赖于CPU的特定扩展,如Intel的VT-x和AMD的AMD-V。

开启硬件辅助虚拟化支持,可以使得虚拟机运行更加高效,减少虚拟化软件层的性能损耗。以Intel VT-x为例,它包括对虚拟化进行直接控制的特定硬件指令集,允许虚拟机监控程序直接运行虚拟机,从而减少了频繁的模式切换的开销。

对于QEMU-KVM而言,硬件辅助虚拟化通常默认开启。但为了确认是否启用,并查看其详细信息,可以通过如下命令进行检查:

```bash

$ lscpu | grep Virtualization

```

该命令会列出当前CPU是否支持硬件虚拟化技术,并显示该特性是否被激活。

### 4.1.2 利用虚拟化扩展特性如Intel VT-x和AMD-V

在确认硬件支持后,应确保BIOS或UEFI固件设置中,硬件虚拟化支持(例如VT-x或AMD-V)是启用状态。不同的主板和处理器可能有不同的设置方式,但通常在启动时按特定键(如F2、Del或Esc)进入设置界面,然后找到相应的CPU或系统配置菜单即可进行设置。

启用这些硬件扩展后,可以在操作系统级别确认它们是否被启用。在Linux系统中,可以通过查看文件`/sys/module/kvm_intel/parameters/`下的`arat`参数确认:

```bash

$ cat /sys/module/kvm_intel/parameters/arat

```

这个命令输出为1表示自动重启辅助技术(Advanced Register Allocation Table)已经启用,可以进一步提高虚拟机的性能。

## 4.2 虚拟机配置文件优化

### 4.2.1 优化虚拟机的XML配置文件

QEMU-KVM使用XML文件来存储虚拟机的配置信息,对这些配置文件进行优化可以提高虚拟机的运行效率。例如,通过优化CPU拓扑结构和内存分配,可以减少虚拟机的启动时间和提高运行时的性能。

配置文件通常位于`/etc/libvirt/qemu/`目录下,文件名通常与虚拟机名称相对应。使用`virsh edit`命令可以编辑虚拟机的XML配置文件:

```bash

$ sudo virsh edit vm_name

```

其中`vm_name`是虚拟机的名称。

一个优化的XML配置示例可能包含设置最佳的CPU模型:

```xml

<cpu mode="host-passthrough" check="none"/>

```

这行代码使得虚拟机的CPU模型与宿主机完全一致,允许虚拟机访问宿主机的CPU所有特性。

### 4.2.2 使用cgroups进行资源限制和隔离

控制组(cgroups)是Linux内核的一个功能,它可以限制、记录和隔离进程组所使用的物理资源(如CPU、内存、磁盘I/O等)。在虚拟化环境中,使用cgroups可以为虚拟机提供资源控制和隔离,优化CPU的使用。

通过cgroups,可以对虚拟机或虚拟机内的进程进行以下操作:

- 限制CPU使用率,如设置CPU使用上限。

- 设置CPU亲和性,将虚拟机的虚拟CPU绑定到特定的物理CPU上。

- 实现CPU的公平调度和控制。

例如,可以通过修改cgroup配置文件来设置虚拟机的CPU份额:

```bash

$ echo 1024 > /sys/fs/cgroup/cpu/kvmgroup/cpu.shares

```

该命令将名为`kvmgroup`的控制组的CPU份额设置为1024。需要注意的是,虚拟机需要先被添加到相应的cgroup中,这些操作通常在虚拟机启动前通过脚本进行配置。

## 4.3 负载平衡与动态迁移

### 4.3.1 虚拟机迁移策略和CPU负载平衡

虚拟机的动态迁移是一种在不停机的情况下将虚拟机从一台物理服务器转移到另一台物理服务器的技术。实现该功能需要确保两台服务器间网络连通,且具备共享存储或使用无共享存储的迁移技术。

CPU负载平衡则是动态迁移过程中的一项关键优化措施,它涉及到实时监控虚拟机的负载,并将虚拟机迁移到当前负载较低的服务器上。这样可以确保资源得到最有效的利用,并避免因服务器过载而导致的性能下降。

QEMU-KVM支持多种动态迁移方式,如冷迁移(将虚拟机从一台主机迁移到另一台主机时,虚拟机处于关闭状态)、热迁移(虚拟机在迁移过程中保持运行状态)等。通过如下命令可以执行热迁移:

```bash

$ virsh migrate --live --unsafe vm_name qemu+tcp://destination_host/system

```

此命令中`vm_name`是虚拟机的名称,`destination_host`是目标主机地址。

### 4.3.2 在QEMU-KVM中实现无停机迁移

QEMU-KVM支持无停机迁移,它允许在迁移过程中,虚拟机继续对外提供服务。无停机迁移需要一个共享存储系统,虚拟机的所有数据都在共享存储上。迁移过程涉及到暂停虚拟机在源主机的执行,将内存内容、设备状态等复制到目标主机,并在那里恢复执行。

在进行无停机迁移之前,确保宿主机通过网络连接到共享存储,并且在目标主机上配置了相同的虚拟机XML配置文件。此外,为了保证数据的一致性和迁移的可靠性,还需要对网络和共享存储进行相应的优化。

无停机迁移的一个关键因素是迁移的网络带宽和速度,因为迁移时间的长短直接影响服务的可用性。以下是使用`virsh`命令进行无停机迁移的一个示例:

```bash

$ virsh migrate --live --copy-storage-all --undefinesource vm_name qemu+tcp://destination_host/system

```

通过这个命令,虚拟机`vm_name`会在不停机的情况下,连同存储一起迁移到`destination_host`上。此处`--copy-storage-all`参数保证存储也一起迁移,而`--undefinesource`参数则在成功迁移后在源主机上清除虚拟机定义。

实现无停机迁移可以大幅提升虚拟化环境的可用性和灵活性,尤其是在需要维护或升级物理主机时,可以保证业务连续性不受影响。

在本章节中,我们探讨了如何通过使用高级CPU特性、优化虚拟机配置文件、以及应用负载平衡与动态迁移技术来深入优化QEMU-KVM虚拟机的CPU性能。通过这些策略的实施,可以显著提升虚拟化环境的整体性能和资源利用率。接下来,我们将进一步探讨通过案例分析和使用性能优化工具与脚本来进一步提升虚拟化环境的性能。

# 5. 案例分析与进一步提升性能

## 5.1 实际案例研究

### 5.1.1 分析典型的虚拟化性能瓶颈案例

在进行虚拟化性能优化时,首先需要识别瓶颈所在。一个典型的案例是,当一个虚拟机(VM)承载数据库服务,用户报告数据库访问延迟很高,这通常是由于CPU资源竞争导致。通过监控工具(如前面章节中提到的`vmstat`,`htop`和`pidstat`)可以发现,虚拟机的CPU使用率接近100%,且大量时间花费在等待(wa)状态,表明可能存在CPU资源的过度争用。

在这种情况下,采取的优化措施通常包括:

- **优化虚拟机CPU资源分配**:将CPU核心与虚拟机的工作负载进行合理匹配,减少争用。

- **增加物理CPU资源**:如果物理CPU还有空闲,可以尝试增加分配给该虚拟机的CPU数量。

- **CPU亲和性设置**:将数据库进程绑定到特定的虚拟CPU,减少上下文切换,提高效率。

### 5.1.2 从案例中提取优化经验和教训

对于上述案例,我们可以提取到以下优化经验和教训:

- **监控先行**:性能优化前,需要建立完善的监控机制,确保有实时数据支持决策。

- **合理配置**:虚拟机的配置应根据实际负载进行调整,避免资源浪费或不足。

- **隔离优先**:为关键应用设置资源隔离策略,减少其他应用对关键业务的影响。

- **动态调整**:持续监控资源使用情况,并根据业务需求动态调整资源分配。

## 5.2 性能优化工具和脚本

### 5.2.1 使用自动化脚本进行QEMU-KVM调优

自动化脚本可以提高调优效率,减少人工干预。例如,我们可以编写一个简单的bash脚本来监控CPU使用率,并根据使用情况自动调整虚拟机的CPU数量:

```bash

#!/bin/bash

VM_NAME="your_vm_name"

CPU_USAGE_THRESHOLD=80

ADJUSTMENT_STEP=1

while true; do

usage=$(vmstat 1 2 | tail -n 1 | awk '{print $15}')

if [ "$usage" -gt "$CPU_USAGE_THRESHOLD" ]; then

# 如果CPU使用率超过阈值,增加虚拟机CPU

virsh setvcpus "$VM_NAME" $((ADJUSTMENT_STEP))

else

# 如果CPU使用率低于阈值,减少虚拟机CPU

virsh setvcpus "$VM_NAME" $((ADJUSTMENT_STEP * -1))

fi

sleep 30 # 每30秒检查一次

done

```

这个脚本不断检查虚拟机的CPU使用率,当超过设定阈值时增加CPU数量,低于阈值时减少CPU数量,从而实现动态调整。

### 5.2.2 利用开源监控工具实现性能优化自动化

开源监控工具如Prometheus结合Grafana可以提供更高级的监控和自动化优化。以下是实现步骤:

1. **安装Prometheus**:通过Prometheus可以采集QEMU-KVM虚拟机的性能指标。

2. **配置Grafana**:在Grafana中创建面板来可视化监控数据。

3. **设置告警规则**:在Prometheus中配置告警规则,当指标达到阈值时触发。

4. **集成自动化脚本**:利用Prometheus的alertmanager组件,当收到告警时,调用之前编写的脚本自动调整资源。

通过结合使用这些工具,可以实现QEMU-KVM虚拟机性能优化的自动化,从而达到高效和稳定运行。

0

0