深入理解Java并发编程中的锁机制:锁的类型和使用场景

发布时间: 2024-07-25 08:53:10 阅读量: 66 订阅数: 47

深入理解高并发编程-核心技术原理

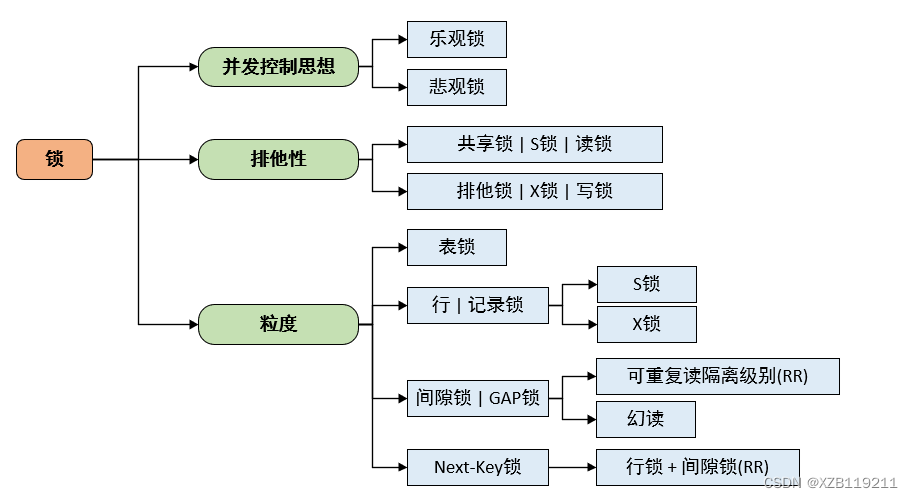

# 1. Java并发编程中的锁机制概述

Java并发编程中,锁是一种用于协调多线程访问共享资源的机制,它可以防止多个线程同时修改共享数据,从而保证数据的完整性和一致性。锁机制是并发编程的基础,了解锁的原理和使用方法对于编写高并发、高性能的Java程序至关重要。

本章将概述Java并发编程中的锁机制,包括锁的概念、分类、使用场景和性能优化等方面。通过对锁机制的深入理解,开发者可以有效地管理并发访问,避免数据竞争和死锁等问题,从而编写出健壮可靠的并发程序。

# 2. 锁的类型

### 2.1 公平锁与非公平锁

**公平锁**:是一种保证线程按请求顺序获取锁的机制。当多个线程同时请求锁时,公平锁会按照先来先服务的原则进行分配,不会出现线程饥饿的情况。

**非公平锁**:则没有这样的保证。当多个线程同时请求锁时,非公平锁可能会优先分配给优先级更高的线程或运气更好的线程,导致某些线程长时间无法获取锁,出现线程饥饿。

**参数说明**:

* **公平性**:布尔值,表示锁是否为公平锁。

**代码示例**:

```java

// 公平锁

Lock fairLock = new ReentrantLock(true);

// 非公平锁

Lock unfairLock = new ReentrantLock(false);

```

**逻辑分析**:

`ReentrantLock`类提供了`fair`参数来指定锁的公平性。当`fair`设置为`true`时,创建公平锁;当`fair`设置为`false`时,创建非公平锁。

### 2.2 可重入锁与不可重入锁

**可重入锁**:允许一个线程多次获取同一把锁。这意味着一个线程可以多次进入同一临界区,而不会造成死锁。

**不可重入锁**:不允许一个线程多次获取同一把锁。如果一个线程已经获取了锁,再次尝试获取同一把锁时会抛出异常或导致死锁。

**参数说明**:

* **可重入性**:布尔值,表示锁是否为可重入锁。

**代码示例**:

```java

// 可重入锁

Lock reentrantLock = new ReentrantLock();

// 不可重入锁

Lock nonReentrantLock = new NonReentrantLock();

```

**逻辑分析**:

`ReentrantLock`类实现了可重入锁,而`NonReentrantLock`类实现了不可重入锁。可重入锁允许一个线程多次获取同一把锁,而不可重入锁不允许。

### 2.3 读写锁与互斥锁

**读写锁**:是一种允许多个线程同时读写共享数据的锁机制。读写锁将锁分为读锁和写锁,读锁可以被多个线程同时获取,而写锁只能被一个线程独占获取。

**互斥锁**:是一种只允许一个线程获取的锁机制。当一个线程获取了互斥锁后,其他线程无法获取同一把锁,直到该线程释放锁。

**参数说明**:

* **读写锁**:`ReadWriteLock`接口,用于创建读写锁。

* **读锁**:`Lock`接口,用于获取读锁。

* **写锁**:`Lock`接口,用于获取写锁。

**代码示例**:

```java

// 创建读写锁

ReadWriteLock readWriteLock = new ReentrantReadWriteLock();

// 获取读锁

Lock r

```

0

0