【编译器原理深度剖析】:C语言编译技术大揭秘,专家级指导让你成为编译器优化专家

发布时间: 2024-10-02 08:53:04 阅读量: 30 订阅数: 30

编译原理-山寨版-简化C语言编译器-简单易学

# 1. C语言编译技术概述

## 1.1 编译过程基本概念

C语言编译技术是计算机科学中的核心内容,负责将高级语言编写的源代码转化为机器能直接执行的机器代码。编译过程大体可分为前端、优化和后端三个阶段。前端主要负责理解程序的语义并将其转换为中间表示,优化阶段对中间代码进行各种变换以提高代码性能,后端则生成目标代码并执行最终的优化。

## 1.2 编译器的功能和结构

一个编译器的主体结构包含几个主要部分:词法分析器、语法分析器、语义分析器、中间代码生成器、代码优化器和目标代码生成器。编译器的这些组成部分紧密协作,依次处理输入的源代码,完成从源代码到可执行文件的全过程。

## 1.3 C语言编译器实例介绍

以GCC为例,它是一个广泛使用的开源C语言编译器。GCC将源代码编译成目标文件,然后链接器将多个目标文件合并为最终的可执行文件。GCC前端将C代码转换为GCC内部使用的中间表示,这个中间表示易于优化,并且与平台无关。后端则负责将这种中间表示转换为目标平台上的机器代码。

# 2. 编译器前端解析

## 2.1 词法分析的原理和实现

词法分析是编译过程中将源程序的字符序列转换成标记(Token)序列的过程。在编译器前端中,词法分析器(Lexer)扮演了将源代码转化为计算机能理解的符号的“翻译官”角色。

### 2.1.1 词法分析器的作用与目标

词法分析器的目标是将源代码文本分解成有意义的元素,如关键字、标识符、常数和运算符等。这些元素通常被称为Token。词法分析器还负责去除空白、注释以及其他对程序意义没有影响的部分,从而为后续的语法分析做准备。

实现词法分析器时,通常会使用正则表达式来定义各种Token的模式。这些模式通过有限自动机(Finite Automata)转换为可执行的代码,可以有效地在源代码文本中匹配相应的模式。

### 2.1.2 正则表达式和有限自动机

正则表达式是一种描述字符串结构的工具,它定义了一种规则,通过这个规则可以匹配或识别出符合特定模式的字符串。在编译器设计中,正则表达式用于定义Token的结构。

有限自动机(FA)是另一种形式化的计算模型,它可以分为确定性有限自动机(DFA)和非确定性有限自动机(NFA)。DFA在任何时刻都只有一个可能的状态转移,而NFA可能有多个。在词法分析中,通常先将正则表达式转换为NFA,然后再转换为DFA以提高识别效率。

例如,定义一个表示标识符的正则表达式为 `[a-zA-Z_][a-zA-Z0-9_]*`,这个表达式可以匹配以字母或下划线开头,后面可以跟任意数量的字母、数字或下划线的字符串。对应的NFA和DFA可以手动构造,或者使用工具(如lex或flex)自动生成。

```mermaid

graph LR

A[NFA] -->|转换| B[DFA]

B --> C[识别Token]

```

## 2.2 语法分析的理论基础

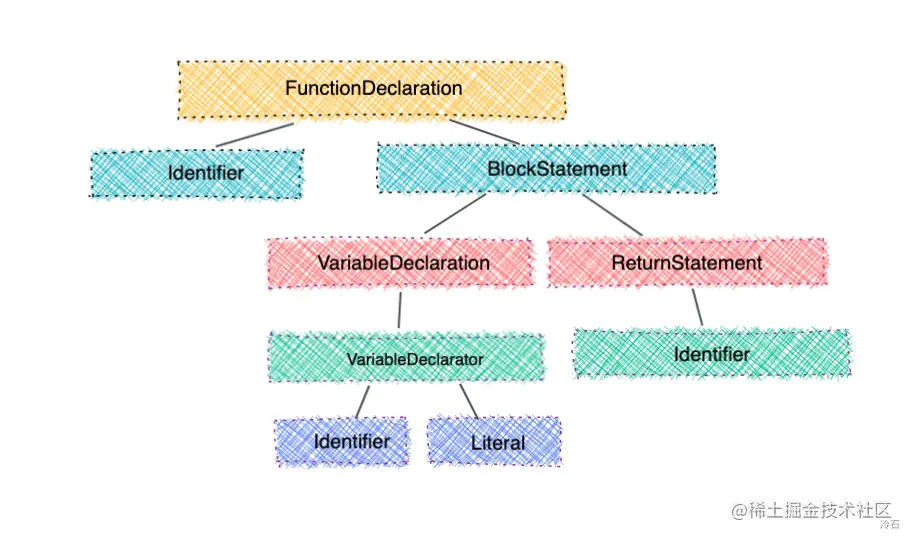

语法分析是编译过程中的第二阶段,其主要任务是根据语言的语法规则将Token序列转换成抽象语法树(AST)。AST是源代码的结构化表示,它能够展示程序的语法结构。

### 2.2.1 上下文无关文法与语法树

上下文无关文法(Context-Free Grammar,CFG)是一种用于定义编程语言语法的形式语言,它由一组规则(产生式)组成。每个规则定义了语言中某一构造的语法结构。例如,一个简单的表达式语法规则可能是 `E -> E + T | T`,表示表达式(E)由一个表达式加上一个项(T)组成,或者只由一个项组成。

抽象语法树(AST)是语法分析的输出,它用树状结构表示程序的语法层次关系。每个节点代表一个构造,如运算符、操作数等。在构建AST时,非终结符在规则展开后会转化为内部节点,终结符则会转化为叶节点。

```mermaid

graph TD

E --> EPlusT

EPlusT --> E

EPlusT --> T

E --> T

```

### 2.2.2 LL和LR分析算法的比较

LL分析和LR分析是两种常见的自顶向下和自底向上的语法分析方法。LL分析需要查看输入符号的左边内容来决定如何进行解析,而LR分析需要查看输入符号的右边内容。

LL分析器通常易于构造,但其能力受限于其递归下降的性质,对左递归的文法支持不好。LL分析器的代表工具包括LL(k)分析器。

相对的,LR分析器是更为强大的工具,它可以处理大多数编程语言的文法,包括左递归文法。LR分析器的k值表示分析过程中向前查看的符号数,常见的LR分析器有SLR、LALR和LR(1)。

## 2.3 语义分析与符号表的构建

语义分析阶段编译器检查源程序是否有意义,即源程序的各个部分是否符合语言定义的语义规则。符号表是语义分析过程中的重要数据结构,它记录了程序中使用的各种标识符的属性信息。

### 2.3.1 语义分析的作用和过程

语义分析主要完成类型检查、变量声明前的引用检查、控制流检查等。这个阶段,编译器检查源程序中的操作是否合法,如操作数类型是否匹配,函数调用是否正确等。

语义分析过程通常会生成中间代码,它是一种与机器语言无关的低级语言。这些中间表示(IR)是后续优化的基础。例如,LLVM IR就是一种广泛使用的中间表示。

### 2.3.2 符号表的设计与实现

符号表用于记录程序中所有标识符的属性信息,如类型、作用域等。它在编译过程中起到“数据库”的作用,编译器在任何时候都可能查询或修改符号表中的信息。

符号表的实现可以是简单的哈希表,也可以是具有层次结构的树或链表,以支持不同的作用域规则。每个作用域通常对应一个符号表的层次,局部作用域中的标识符会覆盖全局作用域中的同名标识符。

```python

# 符号表的简单Python实现示例

class SymbolTableEntry:

def __init__(self, name, type, scope):

self.name = name

self.type = type

self.scope = scope

class SymbolTable:

def __init__(self):

self.table = {}

self.scope = []

def add_entry(self, name, type):

if name in self.table:

raise NameError(f"Identifier '{name}' already defined")

else:

entry = SymbolTableEntry(name, type, self.scope)

self.table[name] = entry

def change_scope(self, scope):

self.scope.append(scope)

```

在本章节中,我们深入了解了编译器前端解析的过程,通过词法分析、语法分析到语义分析,每一步都至关重要。编译器前端为程序的翻译和优化打下了坚实的基础。下一章我们将转向编译器后端,探索代码生成与优化的奥秘。

# 3. 编译器后端优化

## 3.1 中间代码生成和优化

### 3.1.1 中间代码的表示与转换

在现代编译器中,中间代码是编译过程中的一个核心概念,其存在主要为了实现编译器前端与后端的解耦。中间代码可以视为源代码的一个中间表示形式,它在语言特定的前端和机器特定的后端之间架起了一座桥梁。一个良好的中间代码设计应当简单、易于转换为机器代码,并能方便地实现各种优化。

**中间代码的特点:**

- **抽象化**:与具体的硬件结构无关,便于优化操作。

- **独立性**:独立于源语言和目标机器,便于重用。

- **结构化**:通常采用类似于三地址代码的形式。

例如,在LLVM编译器架构中,中间代码采用静态单一赋值(SSA)形式,这使得变量的赋值和使用非常明确,有助于优化过程。转换为SSA形式的中间代码之后,编译器可以执行一系列的优化技术。

### 3.1.2 典型的中间代码优化技术

中间代码的优化旨在改进程序的性能,而不改变程序的语义。优化可以在不同的级别上进行,包括局部优化、循环优化等。下面是一些典型的优化技术:

- **常数传播**:如果一个变量被赋予一个常数值,那么这个值可以被用于计算和条件测试。

- **死代码删除**:移除未被使用的变量和程序段。

- **循环不变式移除**:将循环外的计算移出循环体,减少循环内的操作次数。

**示例代码块:**

```c

// 原始的C语言代码

int add(int a, int b) {

return a + b;

}

int main() {

int c = add(3, 4);

return 0;

}

```

**中间代码(伪代码):**

```

// 函数add的SSA形式中间代码

%1 = addi 3, 4

%2 = ret %1

// main函数的SSA形式中间代码

%3 = call add, 3, 4

%4 = ret 0

```

在这段代码中,`addi` 表示整数加法指令,`ret` 表示返回。这种中间代码形式可以清楚地看到函数如何调用以及返回值,便于进行优化。

## 3.2 目标代码的生成

### 3.2.1 代码生成器的设计

目标代码生成是将中间代码转换成特定硬件架构可以执行的机器代码的过程。这个阶段通常涉及到寄存器分配、指令选择和指令调度等关键步骤。代码生成器的设计需要充分考虑目标平台的特点,比如寄存器的数量、指令的延迟以及内存层次结构等。

**寄存器分配策略**:

- **贪婪算法**:在需要时分配寄存器,可能导致寄存器数量超出硬件限制。

- **图着色算法**:通过将寄存器分配问题建模为图着色问题,以确保变量在需要时都有可用的寄存器。

### 3.2.2 寄存器分配和指令选择

在编译过程中,寄存器是有限的资源,合理地分配寄存器对于提升程序性能至关重要。指令选择则关注如何将中间代码的操作映射到目标机器的指令集上。

**寄存器分配示例:**

假设编译器需要为变量`a`和`b`分配寄存器,如果目标机器只有两个寄存器可用,则必须合理规划使用。

**指令选择示例:**

例如将SSA形式的中间代码转换为x86汇编代码。

**示例代码块(x86汇编):**

```asm

mov eax, 3

mov ebx, 4

add eax, ebx

ret

```

在上述代码中,我们使用了`mov`指令来加载立即数,使用`add`指令来进行加法运算。这些指令的选择取决于目标机器的指令集。

## 3.3 优化算法与技术深度分析

### 3.3.1 循环优化和数据流分析

循环优化是目标代码优化阶段的一个重要组成部分。循环的迭代次数多,对程序性能的影响巨大,因此优化循环至关重要。

**循环优化技术包括:**

- **循环展开**:减少循环控制的开销。

- **循环融合**:合并具有共同迭代空间的循环,减少循环间的依赖。

- **循环分割**:将循环分割为多个循环,增加并行执行的可能。

数据流分析技术分析程序中变量的定义和使用情况,以优化寄存器的使用和删除不必要的计算。

### 3.3.2 高级优化技术介绍

高级优化技术在编译器的设计中通常用于提升代码的性能。这包括向量化技术、并行化处理等。

**向量化技术**:

- 利用现代处理器的SIMD(单指令多数据)能力,将数据打包到寄存器中,在一个操作中处理多个数据元素。

**并行化技术**:

- 自动识别和并行执行可以并行的计算任务,以利用多核处理器的性能。

**示例代码块(伪代码):**

```c

// 向量化优化前的代码

for (int i = 0; i < n; i++) {

a[i] = b[i] + c[i];

}

// 向量化优化后的代码

for (int i = 0; i < n; i+=4) {

a[i] = b[i] + c[i];

a[i+1] = b[i+1] + c[i+1];

a[i+2] = b[i+2] + c[i+2];

a[i+3] = b[i+3] + c[i+3];

}

```

在这个例子中,代码通过循环展开,每次处理四个数组元素,能够充分利用现代处理器的SIMD指令集。

通过本章节的介绍,我们了解到编译器后端优化的重要性,其不仅仅在于提高程序的执行效率,更在于提升程序在各种硬件平台上的兼容性和适应性。在下一章节中,我们将详细探讨如何在实践中构建一个简单的编译器,并实现词法分析器和语法分析器。

# 4. 编译器构造实践

## 4.1 构建一个简单的编译器

### 4.1.1 开发环境与工具选择

构建一个编译器是一个复杂的过程,选择正确的开发环境和工具是成功的第一步。对于初学者来说,推荐使用编译器构造工具如Flex和Bison,它们分别用于生成词法分析器和语法分析器。对于编译器的其他部分,可以使用GCC作为后端进行代码生成和优化的实验。文本编辑器方面,Visual Studio Code和Emacs是不错的选择,它们都支持丰富的插件来辅助编程。

### 4.1.2 简单编译器的框架搭建

首先,我们要理解编译器的基本框架,它通常包括前端、优化器和后端三部分。前端负责解析源代码并生成中间表示(IR),优化器对IR进行各种优化,而后端则负责将优化后的IR转换为目标机器代码。下面是一个简单编译器的基本框架伪代码:

```c

void main() {

// 词法分析

LexicalAnalyzer lexicalAnalyzer = new LexicalAnalyzer(sourceCode);

Token[] tokens = lexicalAnalyzer.analyze();

// 语法分析

Parser parser = new Parser(tokens);

SyntaxTree syntaxTree = parser.parse();

// 语义分析和IR生成

SemanticAnalyzer semanticAnalyzer = new SemanticAnalyzer(syntaxTree);

IR ir = semanticAnalyzer.generateIR();

// IR优化

Optimizer optimizer = new Optimizer(ir);

IR optimizedIR = optimizer.optimize();

// 目标代码生成

CodeGenerator codeGenerator = new CodeGenerator(optimizedIR);

MachineCode machineCode = codeGenerator.generateCode();

// 输出最终的机器代码

machineCode.dump();

}

```

在这个框架中,每个组件都以函数或类的形式表示。在实际编程中,你需要为每个部分编写具体的逻辑。

## 4.2 实现词法分析器和语法分析器

### 4.2.1 使用工具生成词法分析器和语法分析器

使用Flex和Bison这类工具可以帮助我们快速生成词法分析器和语法分析器。首先,定义词法规则和语法规则文件,比如`lex.l`和`bison.y`。然后,使用Bison编译语法文件来生成C/C++源代码。

以下是`bison.y`的一个简单示例,它定义了一个简单的算术表达式语法:

```bison

%{

#include <stdio.h>

%}

%token NUMBER PLUS MINUS TIMES OVER

%left PLUS MINUS

%left TIMES OVER

program:

program expr '\n' { printf("%d\n", $2); }

| program '\n'

;

expr:

NUMBER { $$ = $1; }

| expr PLUS expr { $$ = $1 + $3; }

| expr MINUS expr { $$ = $1 - $3; }

| expr TIMES expr { $$ = $1 * $3; }

| expr OVER expr { $$ = $1 / $3; }

;

```

### 4.2.2 手动实现词法和语法分析的实例

为了深入了解编译器的工作原理,我们可以手动实现一个简单的词法分析器和语法分析器。首先,我们定义一些基本的词法规则和状态机来识别不同的记号(Token):

```c

#include <stdio.h>

#include <ctype.h>

// 词法分析器的状态

typedef enum {

START, NUMBER

} LexerState;

// 词法分析器的结构体

typedef struct {

char* input;

int index;

LexerState state;

int value;

} Lexer;

// 初始化词法分析器

void lexer_init(Lexer* lexer, char* input) {

lexer->input = input;

lexer->index = 0;

lexer->state = START;

lexer->value = 0;

}

// 执行词法分析

int lexer_analyze(Lexer* lexer) {

while (lexer->input[lexer->index] != '\0') {

switch (lexer->state) {

case START:

if (isdigit(lexer->input[lexer->index])) {

lexer->state = NUMBER;

lexer->value = lexer->input[lexer->index] - '0';

} else {

// 非法字符处理

printf("Illegal character: %c\n", lexer->input[lexer->index]);

}

break;

case NUMBER:

if (isdigit(lexer->input[lexer->index])) {

lexer->value = lexer->value * 10 + (lexer->input[lexer->index] - '0');

} else {

// 记号识别完成,输出结果

printf("Number: %d\n", lexer->value);

lexer->state = START;

}

break;

}

lexer->index++;

}

return 0;

}

int main() {

char* input = "123 + 456";

Lexer lexer;

lexer_init(&lexer, input);

lexer_analyze(&lexer);

return 0;

}

```

在语法分析方面,可以手动实现一个递归下降分析器:

```c

#include <stdio.h>

// 递归下降分析器

void expr(); // 前向声明

void term();

void factor();

void expr() {

term();

while (1) {

if (peek() == '+') {

match('+');

term();

} else if (peek() == '-') {

match('-');

term();

} else {

break;

}

}

}

void term() {

factor();

while (1) {

if (peek() == '*') {

match('*');

factor();

} else if (peek() == '/') {

match('/');

factor();

} else {

break;

}

}

}

void factor() {

if (isdigit(peek())) {

// 数字处理逻辑

printf("%c\n", peek());

} else {

printf("Unexpected character.\n");

}

}

// 辅助函数

char peek() {

// 返回下一个字符

}

void match(char expected) {

// 匹配字符

}

int main() {

// 解析输入表达式

expr();

return 0;

}

```

## 4.3 中间代码生成与优化实践

### 4.3.1 实践中间代码的生成

中间代码(IR)是一种用来表示程序的中间形式,它独立于机器语言和源代码语言。实践中间代码生成,我们需要定义一些IR结构,如基本块、指令等。

```c

typedef struct {

int numOperands;

int operands[3];

} Instruction;

typedef struct {

int instructionCount;

Instruction* instructions;

} BasicBlock;

typedef struct {

int basicBlockCount;

BasicBlock* basicBlocks;

} IntermediateCode;

```

然后,我们可以将语法分析器生成的语法树转换为中间代码。例如,将一个简单的表达式树转换为三地址码:

```c

void generateIR(SyntaxTreeNode* node, IntermediateCode* ir) {

if (node == NULL) {

return;

}

// 根据不同的节点类型生成IR代码

switch (node->type) {

case EXPRESSION:

// 递归处理子节点

generateIR(node->left, ir);

generateIR(node->right, ir);

// 假设每个操作都产生一个新的基本块

addBasicBlock(ir);

break;

case OPERATOR:

// 生成操作码

Instruction instr = { .numOperands = 2 };

// 这里简化处理,直接使用操作数的值

instr.operands[0] = node->left->value;

instr.operands[1] = node->right->value;

instr.operands[2] = -1; // 暂时不用

addInstruction(ir, instr);

break;

case NUMBER:

// 处理数字节点,假设数字已经转换为一个值

addInstruction(ir, node->value);

break;

}

}

```

### 4.3.2 实践中间代码的优化技术

中间代码优化是提高程序性能的关键步骤。常见的优化技术包括死代码删除、常数传播、循环不变代码外提等。

这里我们实践一个简单的死代码删除优化。假设我们的IR中包含了一些赋值操作,我们希望能够删除那些对程序结果没有影响的赋值操作。

```c

void optimizeIR(IntermediateCode* ir) {

int deleteCount;

do {

deleteCount = 0;

// 遍历所有基本块

for (int i = 0; i < ir->basicBlockCount; ++i) {

BasicBlock* bb = &ir->basicBlocks[i];

for (int j = 0; j < bb->instructionCount; ++j) {

Instruction* instr = &bb->instructions[j];

// 检查是否有可以删除的指令

if (isDeadCode(bb, instr)) {

deleteInstruction(bb, j);

j--; // 调整索引

deleteCount++;

}

}

}

} while (deleteCount > 0); // 当没有代码删除时停止优化

}

```

以上代码展示了中间代码优化的一个基本概念。实际实现时,你需要定义更多的辅助函数和数据结构来管理IR,并且需要编写复杂的算法来检测和删除死代码。

# 5. 编译器优化技巧与案例分析

## 5.1 常见的编译器优化策略

### 5.1.1 全局优化和局部优化

编译器优化可以分为全局优化和局部优化两大类。局部优化主要关注代码片段或函数内部的优化,而全局优化则关注整个程序的结构和流程,以达到更宏观的性能提升。

局部优化通常包括:

- 常量传播:在编译时计算出表达式中的常数,并将它们的值替换到程序中,减少运行时计算。

- 循环不变代码移出:将循环中不依赖循环变量的计算移出循环外部,减少每次迭代中的计算量。

- 死代码删除:移除程序中永远不可能被执行到的代码,比如永远不会为真的条件语句内部的代码块。

全局优化较为复杂,可能包括:

- 循环展开:减少循环次数,降低循环控制的开销。

- 公共子表达式消除:识别并合并重复的表达式计算。

- 代码移动:将只执行一次的计算移出循环体外。

优化策略需要根据目标平台和特定的性能瓶颈进行选择和调整。编译器通常提供一系列的优化级别,从最基础的优化到非常激进的优化。在某些情况下,一些高级优化技术可能因为增加编译时间而不被推荐,尤其是在开发阶段需要快速迭代的场合。

### 5.1.2 循环优化和常量优化

循环优化是编译器优化的重要组成部分,常见的循环优化手段包括:

- 循环不变式移动:将循环内不变的计算移至循环外部,减少每次迭代的开销。

- 循环分割:将复杂的循环逻辑拆分成若干个简单的循环,便于编译器更好地进行其他优化。

- 循环融合:合并多个循环中相同的迭代计算,减少重复计算。

常量优化关注于使用常量值替换变量,这包括常量传播和常量折叠。常量折叠是指在编译时计算出常量的表达式值,并将其替换。这不仅减少了运行时的计算量,还有助于进一步的优化,如死代码消除。

## 5.2 高级优化技术的应用

### 5.2.1 内联扩展和循环展开

内联扩展(Inline Expansion)和循环展开(Loop Unrolling)是两种常用的高级优化技术。

内联扩展是一种提高执行效率的方法。编译器将函数调用替换为函数体本身,减少函数调用的开销。不过,内联可能会导致代码体积增加,编译器需要在两者之间做出平衡。现代编译器通常有启发式方法决定何时进行内联扩展。

循环展开技术可以减少循环迭代次数,降低循环控制开销,使得循环内部的指令序列更加高效。举一个简单的例子:

```c

// 原始代码

for (int i = 0; i < 100; ++i) {

// 循环体

}

// 展开后代码(展开因子为4)

for (int i = 0; i < 100; i += 4) {

// 循环体的前4份拷贝

// 循环体的第5份拷贝

// 循环体的第6份拷贝

// 循环体的第7份拷贝

// 更新迭代变量i

}

```

这种方法通过减少迭代次数,可以减少循环控制指令的数量,并且有助于循环体内部指令的进一步优化,如寄存器分配和指令级并行处理。

### 5.2.2 并行化和向量化技术

并行化和向量化是利用现代多核处理器提高程序性能的有效手段。

并行化是指编译器识别可以并行执行的代码段,并利用多核处理器并行执行以加速程序运行。向量化则是利用SIMD(单指令多数据)指令集,将数据打包在向量寄存器中,并在一个操作中处理多个数据。

向量化技术的一个例子是使用Intel AVX指令集。例如,以下代码在未向量化和向量化后:

```c

// 未向量化的代码

for (int i = 0; i < N; ++i) {

C[i] = A[i] + B[i];

}

// 向量化的代码示例 (伪代码)

for (int i = 0; i < N; i += 8) {

VLOAD (V1, A[i+0], A[i+1], A[i+2], A[i+3], A[i+4], A[i+5], A[i+6], A[i+7]);

VLOAD (V2, B[i+0], B[i+1], B[i+2], B[i+3], B[i+4], B[i+5], B[i+6], B[i+7]);

VADD (V3, V1, V2);

VSTORE(C[i+0], C[i+1], C[i+2], C[i+3], C[i+4], C[i+5], C[i+6], C[i+7], V3);

}

```

向量化不仅缩短了执行时间,也减少了处理器核心需要处理的指令数量,提高了内存利用率。

## 5.3 真实世界中的编译器优化案例

### 5.3.1 GCC和Clang的优化实例分析

GCC(GNU Compiler Collection)和Clang是广泛使用的两种编译器。它们都提供了丰富的编译优化选项,支持从基本到高级的各种优化策略。

GCC的-O3优化级别是性能优化的常用选项,它包括了广泛的代码优化技术,如内联扩展、循环展开、公共子表达式消除等。GCC的优化器还支持针对特定处理器架构的指令集优化,以充分利用硬件特性。

Clang作为另一个流行的编译器,它使用了LLVM优化框架。LLVM是一个高度模块化的编译器基础设施,它支持从源代码到机器码的整个编译过程,其优化选项也十分丰富。例如,Clang提供了如`-flto`(链接时优化)的选项来提升最终程序的性能。

### 5.3.2 针对特定架构的优化案例研究

针对特定架构的优化需要对目标硬件有深入的理解。例如,ARM架构和x86架构在指令集、缓存结构、执行模式等方面存在较大差异,因此针对这两种架构的优化策略也会有所不同。

以ARM为例,现代ARM处理器通常拥有复杂的执行管道和多种执行模式。编译器可能需要优化循环以更好地利用指令缓存,以及通过特定的编译器指令帮助处理器预测分支和提高指令发射效率。

一个具体的案例是,编译器可能会在编译阶段选择特定的指令来开启或关闭处理器的NEON向量单元,从而在不同的性能和功耗场景中获得平衡。NEON是ARM架构中的SIMD指令集,能够在单个操作中处理多组数据。

编译器优化技术不断演进,随着硬件技术的发展,未来的优化策略会更加依赖于目标硬件的特性,以及程序运行时的性能数据,实现更加动态和智能的优化。

# 6. 编译器前沿技术探讨

## 6.1 新兴编程语言的编译技术

随着技术的发展,新的编程语言如Rust和Go不断涌现,并开始在特定领域占据重要地位。这些新兴编程语言引入了新的编译技术,以解决传统语言中的某些问题。

### 6.1.1 Rust和Go的编译技术比较

Rust和Go在编译技术上的选择各有侧重点,体现了不同设计哲学下的编译优化策略。

- **Rust的编译技术**:

Rust编译器注重安全性和性能,采用了复杂的借用检查器来确保内存安全。它采用了LLVM作为后端,能够生成优化的本地代码。Rust的编译器还利用了模块系统和强大的宏系统来支持高级的代码抽象和重用。

- **Go的编译技术**:

Go语言则倾向于简洁性和开发效率,其编译器使用了快速的单遍编译策略,这使得它能够快速进行编译。Go的编译器同样集成了强大的依赖管理和内置的并发特性支持,这些都是为了提高开发效率和程序运行效率。

### 6.1.2 静态类型语言与动态类型语言编译差异

静态类型语言和动态类型语言在编译技术上有着根本的不同,这影响了编译器的设计和优化。

- **静态类型语言**:

静态类型语言如C++和Rust,在编译时就能确定变量类型,因此可以进行更多的编译时优化,如类型推断和模板元编程等。

- **动态类型语言**:

动态类型语言如Python和JavaScript,在运行时才确定类型,因此编译器需要做更多的运行时检查,编译成中间字节码,并且依赖于即时编译(JIT)技术来优化性能。

## 6.2 量子计算与编译器的未来

量子计算是目前计算领域中的一个前沿热点,其编译器设计挑战与传统编译器截然不同。

### 6.2.1 量子编程语言与传统语言的对比

量子编程语言如Qiskit和Q#,它们不是直接对硬件进行编程,而是提供了一种能够描述量子算法和操作的方式来编程量子计算机。

- **量子编程语言特性**:

这些语言支持量子比特的表示、量子门操作、量子态的初始化和测量等。量子编程语言编译器不仅需要将高级语言转换为量子计算机能够理解的低级指令,还要进行量子错误校正和优化。

### 6.2.2 量子计算编译器的设计挑战

量子编译器设计面临很多挑战,包括但不限于:

- **量子态的表示**:如何有效表示和操作量子态。

- **编译优化**:在保持量子算法正确性的基础上进行优化。

- **错误校正**:量子计算非常容易受到环境干扰,错误校正算法的集成是编译器设计的重要部分。

- **跨平台支持**:如何支持多种不同的量子硬件平台。

## 6.3 编译器在AI领域的应用

AI技术的快速发展也对编译器技术提出了新的要求,特别是在机器学习模型的编译优化方面。

### 6.3.1 机器学习模型的编译优化

机器学习模型,尤其是深度学习模型,通常需要在特定硬件上进行高效的执行。

- **编译器优化技术**:

编译器可以为深度学习模型进行特定优化,比如利用张量运算的并行性,对权重矩阵和激活函数进行优化。同时,针对神经网络的图优化技术,可以减少内存使用和提高计算效率。

### 6.3.2 编译器技术与深度学习框架的结合

编译器技术与深度学习框架的结合,可以使得模型训练和部署更加高效。

- **框架与编译器的集成**:

深度学习框架如TensorFlow和PyTorch可以集成编译器优化技术,如自动微分和JIT编译,来加速模型的训练和推理过程。这些框架甚至可以使用编译器技术来自动化生成特定硬件平台上的优化代码。

在探讨了Rust与Go的编译技术差异、量子计算的编译挑战以及AI领域的编译优化之后,我们不难发现编译技术的快速发展对整个IT行业具有深远的影响。无论是新兴编程语言的出现、量子计算的崛起,还是人工智能技术的革新,编译器始终在背后扮演着重要的角色,不断推动技术的进步。

0

0