【VAE在PyTorch中的实现】:理论与实践,打造个性化图像生成系统

发布时间: 2024-12-11 18:28:52 阅读量: 6 订阅数: 12

# 1. VAE(变分自编码器)的基础理论

在深度学习的众多模型中,变分自编码器(Variational Autoencoder,简称VAE)已经成为一种重要的生成模型。它结合了自动编码器与概率生成模型的优点,能够学习数据的潜在表示,同时生成高质量的新样本。本章将详细介绍VAE的基本原理和数学基础。

## 1.1 VAE的基本概念

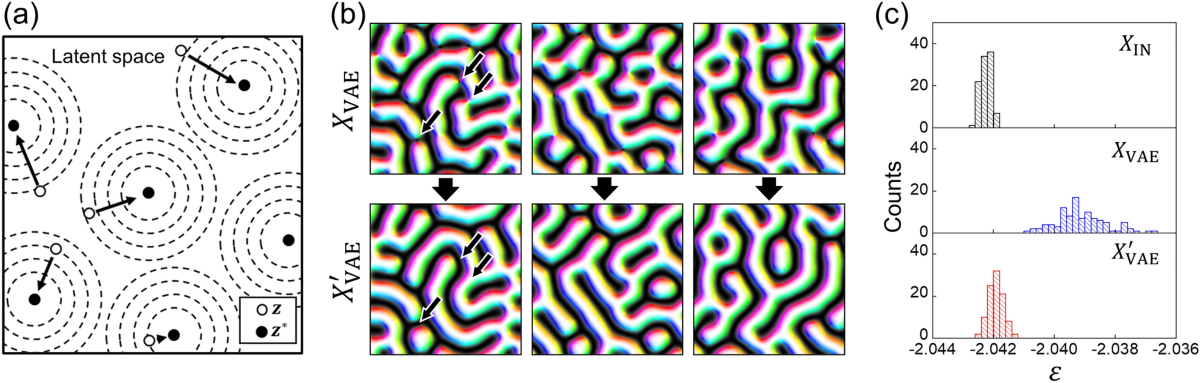

VAE是一种基于变分推断的生成模型,其核心思想是使用一个编码器网络将观测数据映射到潜在空间,然后再通过解码器网络重构出观测数据。这种模型在许多领域如图像生成、文本生成等都显示出了巨大的潜力。

## 1.2 VAE的工作原理

VAE的关键在于它的编码器不是直接映射输入到潜在变量,而是映射到潜在变量的参数,然后通过采样潜在变量来生成观测数据。这种方法使得模型能够捕捉输入数据的多样性,并生成新的、未曾见过的样本。

## 1.3 VAE的优势

与传统的自编码器相比,VAE能够给出潜在空间中样本的分布,这使得它不仅能够进行数据重建,还能进行有效的样本生成。此外,由于引入了概率模型,VAE能够在潜在空间中进行平滑的插值和学习,这对于理解和操作数据表示特别有用。

# 2. PyTorch框架入门

### 2.1 PyTorch简介

#### 2.1.1 PyTorch的历史和特点

PyTorch是由Facebook的人工智能研究团队于2016年推出的开源机器学习库,它主要用于计算机视觉和自然语言处理等应用。PyTorch提供了一个高效的张量计算环境,支持GPU加速,同时具有动态计算图(Dynamic Computational Graphs)特性,这使得研究人员能以更接近Python自然风格的方式快速开发和调试模型。

特点上,PyTorch以其灵活性和易用性著称,尤其是以下几点:

- **动态计算图**:PyTorch构建的计算图是动态的,这意味着图的构建是在运行时完成的,可以实现更复杂和灵活的数据流控制。

- **易用性**:简洁的API设计,使得新手也容易上手。

- **强大的社区支持**:拥有大量的社区贡献和预训练模型,方便开发者学习和使用。

- **良好的性能**:支持多GPU训练,性能优化良好,适合大规模模型训练。

#### 2.1.2 PyTorch的安装和配置

安装PyTorch非常直接,可以访问官方网站获取详细的安装指令,一般有以下几种方式:

- 使用`pip`直接安装:适合大多数用户。

- 使用`conda`安装:适合需要安装预构建二进制包的用户,尤其是GPU版本。

- Docker镜像:适合希望在一个隔离环境中快速运行PyTorch的用户。

以通过`pip`安装CPU版本为例,可以使用以下命令:

```sh

pip install torch torchvision torchaudio

```

对于GPU版本,需要确认你的CUDA版本,并使用以下命令:

```sh

pip install torch torchvision torchaudio -f https://download.pytorch.org/whl/torch_stable.html

```

安装完成后,可以运行以下Python代码检查PyTorch是否安装成功并利用了GPU资源:

```python

import torch

print(f"PyTorch version: {torch.__version__}")

print(f"Is CUDA available: {torch.cuda.is_available()}")

```

### 2.2 PyTorch核心概念

#### 2.2.1 张量(Tensor)和自动微分(autograd)

张量是PyTorch中用于存储数据的基本数据结构,可以看作是一个多维数组。张量的操作和NumPy数组类似,但能够利用GPU进行加速。

```python

import torch

# 创建一个5x3的未初始化的张量

x = torch.empty(5, 3)

print(x)

```

自动微分是深度学习中非常重要的特性,它能够自动计算梯度,减少了手动求导的负担。在PyTorch中,我们可以通过创建一个`requires_grad=True`的张量来启用自动微分。

```python

# 创建一个需要计算梯度的张量

w = torch.tensor([1.0, 2.0, 3.0], requires_grad=True)

# 定义计算图

y = w[0] * w[0] + w[1] * w[1] + w[2] * w[2]

# 反向传播,计算梯度

y.backward()

print(w.grad) # 打印梯度

```

#### 2.2.2 神经网络模块(nn.Module)和优化器(optim)

`nn.Module`是PyTorch中所有神经网络模块的基类,我们可以通过继承这个类来定义自己的网络结构。PyTorch提供了一个包含各种常见层(如卷积层、全连接层等)的模块库。

```python

import torch.nn as nn

import torch.nn.functional as F

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(3, 5)

self.fc2 = nn.Linear(5, 3)

def forward(self, x):

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

net = SimpleNet()

print(net)

```

优化器负责更新网络的权重,常见的优化算法如SGD、Adam等在PyTorch中通过`optim`模块提供。例如:

```python

import torch.optim as optim

optimizer = optim.Adam(net.parameters(), lr=0.001)

```

### 2.3 PyTorch实践基础

#### 2.3.1 模型的构建和训练循环

在PyTorch中,构建模型和训练循环是分开的。首先定义模型,然后通过循环对数据进行前向传播、计算损失、反向传播和参数更新。

```python

# 假设我们有一批数据和对应标签

data = torch.randn(20, 3)

target = torch.randint(0, 3, (20,))

# 设定损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(net.parameters(), lr=0.001)

# 训练循环

for epoch in range(10): # 进行10个训练周期

optimizer.zero_grad() # 清空梯度

output = net(data) # 前向传播

loss = criterion(output, target) # 计算损失

loss.backward() # 反向传播

optimizer.step() # 更新参数

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

```

#### 2.3.2 数据加载和预处理

PyTorch通过`DataLoader`和`Dataset`类支持高效的数据加载。`Dataset`负责存储数据样本,而`DataLoader`负责批量加载数据并提供迭代接口。

```python

from torch.utils.data import DataLoader, Dataset

# 定义自己的数据集

class MyDataset(Dataset):

def __init__(self, data, target):

self.data = data

self.target = target

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

return self.data[idx], self.target[idx]

# 创建数据集和数据加载器

dataset = MyDataset(data, target)

dataloader = DataLoader(dataset, batch_size=2, shuffle=True)

# 使用DataLoader进行数据迭代

for batch_data, batch_target in dataloader:

# 进行模型训练步骤

pass

```

预处理阶段常常包含对数据进行标准化、转换等操作,以确保数据质量满足模型训练的要求。

在本章节中,我们介绍了PyTorch的基础知识,从安装配置到核心概念,再到实际的模型构建和训练,为后面深入探讨VAE模型的实现打下了坚实的基础。通过本章节的学习,读者应该能够理解PyTorch的基本操作,并能够在自己的项目中应用这些技术。

# 3. VAE模型构建与训练

## 3.1 VAE模型的数学原理

### 3.1.1 概率图模型和变分推断

变分自编码器(VAE)是一种深度生成模型,它利用概率图模型和变分推断的原理来生成新的数据样本。概率图模型使用图结构来表示变量之间的条件依赖关系,它由显式变量(可以直接观测到的变量)和隐式变量(需要通过观测数据推断出的变量)组成。在VAE

0

0