【算法比较】CART与ID3:决策树算法的变种深入分析

1. 决策树算法基础与应用背景

1.1 决策树算法简介

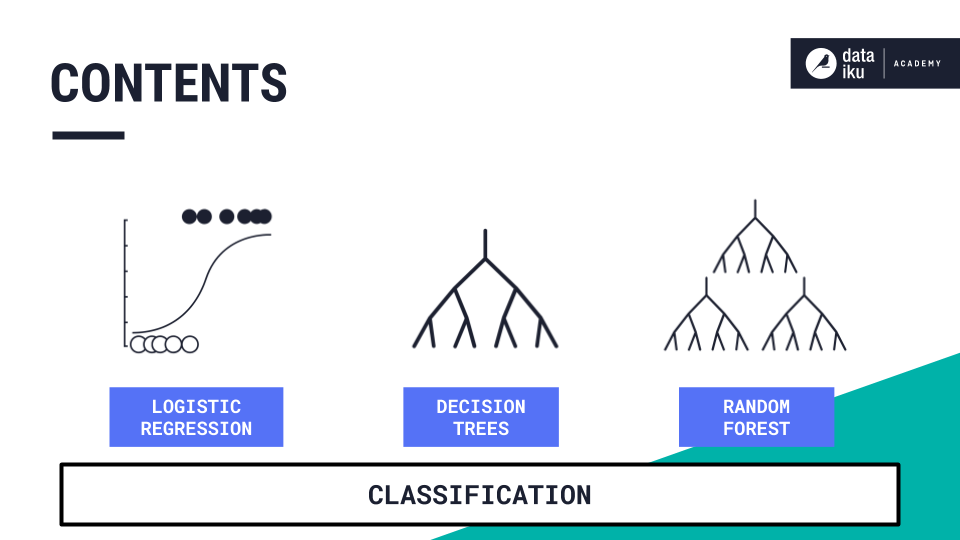

在数据挖掘领域,决策树是一种广泛使用的预测建模方法。它通过一系列的决策规则,将数据集从根节点至叶节点,递归地进行划分,构建出一个树状结构的模型。这种模型易于理解和解释,并且可以处理数值型和类别型数据,因此被广泛应用于分类和回归任务。

1.2 决策树的特点

- 直观性:决策树的结构类似于人类的决策过程,容易理解与解释。

- 效率性:在某些情况下,决策树算法可提供快速的预测结果。

- 灵活性:决策树能够处理各种类型的数据,包括数值型和类别型特征。

1.3 应用背景

决策树算法在现实世界中的应用包括但不限于医疗诊断、信用评分、市场细分、客户细分等。由于其简单直观,决策树常作为其他更复杂算法的基线模型,或者作为数据理解和初步分析的工具。

在后续章节中,我们将详细探讨不同的决策树算法,如CART和ID3,并对它们的原理、实现以及在分类和回归问题中的应用进行深入分析。同时,也会进行算法间的对比,以及对决策树的优化技术进行探讨,以提供对决策树算法更全面的理解。

2. CART算法的原理与实现

2.1 CART算法的基本概念

2.1.1 决策树构建的基本流程

CART(Classification and Regression Trees,分类与回归树)算法是一种在分类问题和回归问题中广泛应用的决策树构建方法。它以二叉树的形式呈现,每个非叶节点代表对数据的一个测试,每个分支代表测试的结果,而每个叶节点代表一种分类结果或一个预测值。CART构建过程大致分为以下几个步骤:

-

选择最佳分割点: 首先,对训练数据集进行扫描,对于每个特征,尝试所有的可能分割点,并计算最佳的分割点,使得分割后数据集的纯度增加最多。

-

建立树模型: 根据第一步找到的最佳分割点,递归地将数据分割,建立二叉树。在每次分割时,都会生成两个子节点,直到满足停止条件,如所有数据都在同一类别或达到预设的树深度等。

-

剪枝处理: 为了避免过拟合,CART算法在树生成后会进行剪枝,移除那些对最终预测结果影响不大的分支。

-

预测新数据: 对于新的数据实例,从根节点开始,根据每个节点的分割规则进行遍历,最终到达叶节点,并将其分类或回归结果作为预测结果。

2.1.2 CART树的特点与优势

CART算法的显著特点是使用二叉树,这使得其在分类时不仅分类界限清晰,而且可以处理多维输入空间。与其他决策树方法相比,CART具有以下优势:

- 模型稳定性: 二叉树结构相比于多叉树,提高了模型的稳定性和抗噪声能力。

- 泛化能力: 通过剪枝策略,CART能够在保证模型复杂度的同时提高泛化能力。

- 适应性广: 既适用于分类问题,又适用于回归问题,具有较高的灵活性。

- 易于实现: 相对简单的算法流程,使得它容易被实现,同时便于理解。

2.2 CART算法的数学原理

2.2.1 分类与回归的区别

在决策树算法中,分类树的目标变量是离散的类别标签,而回归树的目标变量是连续值。CART算法在处理这两种不同类型的预测问题时,其核心思想和构建方法基本相同,但在树的终点处有所不同:

- 分类树: 叶节点中存储的是最可能的分类标签。

- 回归树: 叶节点中存储的是预测的连续值。

2.2.2 二叉树的构造与分割标准

CART算法构建二叉树的核心是找到最佳分割点,分割标准通常是根据数据集的目标变量来确定的。在分类问题中,分割标准通常是基尼指数(Gini Index)的降低;而在回归问题中,则使用均方误差(Mean Squared Error, MSE)作为分割标准。

基尼指数是一种衡量数据集纯度的指标,其计算公式为:

- Gini(p) = 1 - Σ(p_i)^2

其中,p 是单个类别标签的相对频率,p_i 是第 i 个类别在数据集中的比例。分割后的基尼指数为分割前后基尼指数的加权平均。最佳分割点的选择使得分割后的基尼指数最小化。

对于回归问题,MSE通过测量模型预测值与真实值之间的差异来进行计算:

- MSE = Σ(y_i - f(x_i))^2

其中,y_i 是第 i 个数据点的目标值,f(x_i) 是模型对 x_i 的预测值。选择最佳分割点会使得MSE的加权平均值最小化。

2.3 CART算法的实践应用

2.3.1 实例解读:CART在分类问题中的应用

考虑一个简单的信用评分问题,目标是预测一个申请信用卡的客户是否会违约。数据集包含客户的信息如收入、年龄、贷款总额等,以及一个二元目标变量,表示是否违约(是/否)。

使用CART算法,首先需要确定最佳分割点,这通常通过计算每个特征的基尼指数来完成。对于收入特征,可能找到的分割点包括5000元、10000元等,然后根据这些分割点将数据集分为两组,并计算每组的基尼指数。选择基尼指数降低最多的一个分割点用于下一步的分割。

重复这个过程,直至满足停止条件,例如当树达到预设深度,或者数据集中每个分支都属于同一类别。

最终的决策树可以用来评估新的客户是否有可能违约。从根节点开始,根据客户的收入水平进行分割,然后是年龄,等等,直到达到叶节点,预测结果即为叶节点的类别。

2.3.2 实例解读:CART在回归问题中的应用

在房价预测的回归问题中,数据集包含房屋的特征如房间数、面积、位置等,以及一个连续的目标变量,表示房屋的市场价格。

对于这个回归问题,CART算法同样首先寻找最佳分割点,但这次使用MSE作为分割标准。分割点可能是房间数为2.5、3.5等。基于MSE的计算结果,选择一个最佳分割点,并将数据集分割为两部分。

通过递归分割,构建二叉树,直到满足停止条件。最终的决策树可以用来对新的房屋进行价格预测。树的构建过程中需要考虑的是,如何划分数据集才能使得每个子集的MSE最小。

在处理回归问题时,CART算法最终将输出一个连续的值,作为叶节点上的预测结果。该值是落在该叶节点内所有训练样本的平均值,或者其他统计量,如中位数等。

以上为第二章“CART算法的原理与实现”的章节内容,具体实现中会涉及到更多细节,如算法参数的选择和调优、构建过程中的细节处理等。在接下来的章节中,我们将深入了解其他决策树算法,如ID3,并通过对比分析,展现它们在不同场景下的应用优劣。

3. ID3算法的原理与实现

3.1 ID3算法的基本概念

3.1.1 信息增益与决策树的递归构建

ID3算法的核心在于使用信息增益作为划分数据集的标准。在构建决策树时,ID3尝试将数据集按照不同的属性值划分,选择最能提供区分度的属性,即获得最大信息增益的属性来进行分裂。信息增益是通过衡量划分前后的数据集纯度变化来获得的。

信息增益的计算基于熵(Entropy)的概念,熵是衡量数据集纯度的一个指标。熵越低,数据集越纯。熵的计算公式是: [ Entropy(S) = -\sum_{i=1}^{n} p_i \log_2(p_i) ] 其中,(p_i) 是第i个类别在数据集S中的比例。

递归构建决策树的步骤如下:

- 计算当前数据集的熵。

- 对于每个属性,计算分割后的数据集熵,进而计算信息增益。

- 选择信息增益最大的属性进行数据集划分。

- 递归对划分后的子集应用以上步骤,直到满足停止条件(如树的最大深度、节点中样本属于同一类别等)。

3.1.2 ID3算法的局限性与发展

尽管ID3算法因其简单直观而被广泛应用,但它存在一些明显的局限性:

- ID3只适用于离散型数据,因为它使用了熵的概念,而熵是基于离散概率分布定义的。

- ID3对缺失数据敏感,因为信息增益的计算依赖于属性值的完整分布。

- ID3倾向于选择具有更多取值的属性,因为属性取值的增多会增大信息增益,可能会导致过拟合。

为克服这些局限,后续发展出了C4.5算法,它引入了信息增益比以解决偏向选择取值多的属性的问题,并能够处理连续型数据和缺失值。而C5.0算法是商业版本,更加高效。

3.2 ID3算法的数学基础

3.2.1 熵的概念及其在ID3中的应用

在信息论中,熵是衡量一个系统不确定性或混乱程度的度量。在ID3算法中,熵是计算数据集纯度的核心。熵的计算公式已在上一节中给出,我们在这里更深入