【深度学习模型压缩】:移动端应用中的模型压缩技术全解析

发布时间: 2024-12-28 02:34:31 阅读量: 8 订阅数: 9

yolov8剪枝压缩模型源码.zip

# 摘要

随着深度学习技术的迅速发展,模型压缩成为优化移动端和边缘计算等资源受限场景下深度学习模型性能的关键技术。本文首先介绍了深度学习模型压缩的必要性和基本理论,然后深入探讨了参数剪枝、权重量化以及知识蒸馏等核心压缩技术,并通过不同应用场景的实践案例,展示了压缩技术在保持模型性能的同时降低资源消耗的有效性。此外,文章还分析了当前模型压缩工具与框架,探讨了模型压缩实践中的挑战,并对未来的应用前景和技术发展方向进行了展望。

# 关键字

深度学习;模型压缩;参数剪枝;权重量化;知识蒸馏;边缘计算

参考资源链接:[移动端深度学习框架对比:NCNN vs MNN](https://wenku.csdn.net/doc/80n19rznzt?spm=1055.2635.3001.10343)

# 1. 深度学习模型压缩简介

在现代深度学习应用中,模型压缩技术的重要性日益凸显。本章节将为读者提供深度学习模型压缩的基础概览,并引入相关术语和概念。随着深度学习应用的日益广泛,特别是移动设备和边缘计算平台上的应用,模型压缩已经成为优化资源消耗和提高推理速度的关键技术。简而言之,模型压缩旨在通过减少模型大小、提升计算效率等手段,保持或提高模型性能的同时降低资源占用。

## 模型压缩的基本概念

模型压缩指的是对深度学习模型进行优化,使之在硬件资源有限的设备上能高效运行。这种优化可以通过多种方式实现,包括但不限于参数剪枝、权重量化、知识蒸馏等技术。在进行模型压缩时,我们旨在减少模型的存储需求和内存占用,同时减少计算复杂度,最终达成模型的快速部署和实时运行。

## 模型压缩的必要性

深度学习模型通常包含数百万甚至数十亿的参数,导致它们在训练和推理时需要大量计算资源。然而,当这些模型被部署到资源受限的环境(如移动电话、嵌入式系统等)时,高资源消耗就成了实际应用的障碍。因此,模型压缩成为了确保深度学习技术在各类设备上得到广泛应用的关键步骤。

通过本章的介绍,我们为您打下深度学习模型压缩的基础知识,接下来的章节将深入探讨其基础理论和核心技术。

# 2. 深度学习模型压缩的基础理论

### 2.1 模型压缩的必要性

#### 2.1.1 移动端设备的资源限制

随着移动设备如智能手机和嵌入式系统越来越广泛的应用,深度学习模型在这些设备上的部署需求日益增长。然而,与服务器端相比,移动端设备的计算能力和存储资源存在显著的限制。这些限制主要表现在以下几个方面:

1. 计算能力限制:移动设备通常配备的是低功耗处理器,这些处理器的浮点运算能力有限,无法满足复杂深度学习模型的计算需求。

2. 存储空间限制:深度学习模型往往需要存储大量参数,占用较大的存储空间,而移动设备的存储资源相对有限,这限制了大型模型的部署。

3. 能耗限制:移动设备依赖电池供电,而深度学习模型的高计算量会导致能量快速消耗,影响设备的续航能力。

4. 延迟限制:为了提供良好的用户体验,移动设备上的实时应用要求快速响应,这意味着模型推理需要在短时间内完成。

为了克服上述限制,模型压缩技术应运而生,它通过减少模型的大小和计算量来适应资源受限的环境。

#### 2.1.2 模型压缩与性能权衡

在应用模型压缩技术时,通常需要在模型的性能和压缩效果之间做出权衡。一方面,压缩后的模型需要保持足够的精度,以满足实际应用的需求;另一方面,压缩率和推理速度也需要得到优化,以适应资源受限的环境。这一权衡主要体现在以下几个方面:

1. 精度保持:压缩过程中可能会损失模型的部分性能,特别是当压缩率较高时。因此,如何在压缩模型的同时保持输出精度,是模型压缩技术需要解决的核心问题。

2. 推理速度:模型压缩后,其推理时间应当得到显著减少,这对于提高用户体验和节省能源至关重要。

3. 资源消耗:除了压缩率和推理速度之外,模型在部署时的资源消耗也是评估模型压缩效果的重要指标。

通过选择合适的模型压缩技术,可以在保持模型精度的同时,提高模型在移动端的部署能力。

### 2.2 模型压缩技术分类

#### 2.2.1 参数剪枝与稀疏化

参数剪枝与稀疏化是深度学习模型压缩中最早和最常用的策略之一。其核心思想是减少模型中的参数数量,以此来降低模型的复杂度和存储需求。具体方法包括:

- 网络剪枝:通过删除网络中的一些连接或神经元来减少模型参数。

- 权重稀疏化:将网络权重设置为零值,形成稀疏矩阵,减少非零元素的数量。

- 结构化剪枝:保留或移除整个卷积核或神经元,使得剪枝过程更加高效。

参数剪枝后的网络往往需要重新训练或微调以恢复性能,而且稀疏网络的计算效率也依赖于硬件和软件的支持。

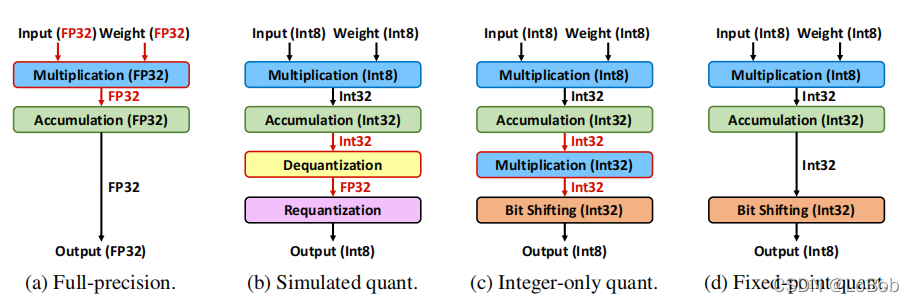

#### 2.2.2 量化与权重量化

量化技术是指将模型参数从高精度(如32位浮点数)转换为低精度(如8位整数)的过程。这一技术能显著减少模型大小和提高推理速度。权重量化包括:

- 权重的离散化:将连续的权重值映射到有限的离散集合中。

- 激活值的量化:降低激活函数输出值的精度。

量化可以分为静态量化和动态量化。静态量化在模型训练之后进行,所有权重和激活值在推理时保持不变;而动态量化则根据输入数据的特性在每次推理时计算量化参数。

#### 2.2.3 知识蒸馏与模型剪枝

知识蒸馏是一种通过训练一个小模型来模仿大模型性能的技术。大模型通常具有更高的准确率,但不适合部署在资源有限的环境中。知识蒸馏通过以下步骤实现:

- 学习一个小模型,使其输出与大模型相似。

- 使用软标签而非硬标签来引导小模型的学习过程。

在模型剪枝中,知识蒸馏可以用来作为后处理步骤,提升压缩模型的性能。

### 2.3 模型压缩的评价指标

#### 2.3.1 精度保持与压缩率

模型压缩的主要目标是减少模型大小和提高推理速度,同时尽可能保持模型的原始精度。模型压缩率和精度保持之间的关系通常如下:

- 压缩率:压缩率是指压缩前后模型大小的比率。较高的压缩率意味着模型占用更少的存储空间。

- 精度保持:在压缩过程中,需要评估模型的输出精度损失。通常,压缩后的模型需要保持在可接受的精度范围内。

通过调整压缩策略,可以在压缩率和精度保持之间找到最佳平衡点。

#### 2.3.2 推理速度与资源消耗

模型压缩后的推理速度和资源消耗是评估模型压缩效果的另一组关键指标:

- 推理速度:压缩后的模型应该能够快速地完成推理任务,以适应实时应用的需求。

- 资源消耗:在保证推理速度的同时,模型的内存和CPU/GPU使用率应该尽可能低。

合理的模型压缩策略能够减少模型的内存占用,提高计算资源的利用率,降低功耗,进而延长设备的使用寿命。

在第二章中,我们了解了深度学习模型压缩的基础理论,包括模型压缩的必要性、技术分类,以及评价指标。通过这些内容,我们对模型压缩的背景、目的和方法有了一个基本的认识。接下来的章节将会深入探讨模型压缩的核心技术,进一步深入了解模型压缩的具体实现和优化策略。

# 3. 深度学习模型压缩的核心技术

深度学习模型压缩的目标是减小模型的规模,同时尽可能保持其性能,这对于移动设备和边缘计算设备尤为重要。在本章中,我们将深入探讨模型压缩的核心技术,包括参数剪枝、权重量化以及知识蒸馏,并在每个部分展示具体的技术细节和实际应用。

## 3.1 参数剪枝技术

参数剪枝是模型压缩中应用广泛的一种技术,其基本思想是去除那些对模型输出贡献较小的权重参数,以达到减少模型参数数量的目的。

### 3.1.1 基于重要性的剪枝方法

基于重要性的剪枝方法通常是通过计算每个参数的重要性来确定哪些参数可以被移除。重要性的衡量标准可以是权重的绝对值、梯度、Hessian矩阵的特征值等。例如,权重的绝对值越大,其对模型输出的影响通常也越大,因此可以通过设定一个阈值来决定是否剪枝。

```python

# 示例:基于权重绝对值的剪枝函数

def prune_weights_by_importance(model, threshold):

weights_to_prune = {}

for name, param in model.named_parameters():

if 'weight' in name and param.requires_grad:

flattened_weights = param.view(-1)

abs_weights = flattened_weights.abs()

num_prune = int(threshold * len(abs_weights)

```

0

0