【数据处理艺术】:UserList在数据清洗和预处理中的10大应用案例

发布时间: 2024-10-06 22:43:40 阅读量: 5 订阅数: 6

# 1. 数据清洗和预处理概述

在当今的数据驱动时代,数据的准确性与可靠性对于任何企业或研究机构的决策都至关重要。数据清洗和预处理作为数据科学流程中的初始环节,扮演着至关重要的角色。它涵盖了从原始数据集中识别并移除错误和不一致性、处理缺失值、检测和修正异常值以及将数据转换为适合分析的格式等一系列操作。这些步骤确保了后续分析结果的精确度和可信度。

## 2.1 数据清洗的定义和重要性

### 2.1.1 数据质量的影响因素

数据质量会受到多种因素的影响,包括数据收集的准确性、记录的完整性、数据类型和格式的统一性以及数据的时效性。在企业环境和研究项目中,高质量数据是成功实施机器学习模型、进行有效数据挖掘或支持决策制定的基础。

### 2.1.2 数据清洗的目标和过程

数据清洗的主要目标是确保数据的准确性和一致性,以提高数据的可用性。整个过程包含识别数据中的错误、纠正错误、处理缺失和重复的数据以及规范化数据格式。这通常涉及到一系列策略和技术的运用,从简单的手动检查到使用先进的数据清洗工具,例如我们接下来要讨论的UserList。

# 2. 数据清洗技术基础

## 2.1 数据清洗的定义和重要性

数据清洗是一个重要的数据预处理步骤,旨在改善数据质量,为数据挖掘、分析、以及机器学习等后续处理提供更准确的数据基础。本节将深入探讨数据清洗的定义及其重要性。

### 2.1.1 数据质量的影响因素

数据质量可能受到各种因素的影响,包括数据的准确性、一致性、完整性和时效性。准确性指的是数据的正确性和可信度。一致性则涉及数据在不同时间、不同地点或在不同系统中的一致表现。完整性要求数据中不应有缺失值或空值。时效性则关注数据是否能够及时更新,以反映最新的状态。

### 2.1.2 数据清洗的目标和过程

数据清洗的主要目标是发现并修正数据集中的错误和不一致,以提高数据的可用性。这个过程通常包括以下几个步骤:

- **探测和识别问题**:通过数据探索发现数据集中的潜在问题,如重复、缺失值、异常值等。

- **解决已识别的问题**:实施适当的技术和策略对问题数据进行处理,例如填充缺失值、删除或修正错误。

- **验证和监控**:在数据清洗后,通过统计分析和可视化方法来验证清洗效果,并确保清洗后的数据集符合要求。

## 2.2 常见的数据清洗任务

在数据清洗过程中,常见的任务包括处理缺失值、检测并删除重复数据以及识别和处理异常值。下面将具体分析这些任务。

### 2.2.1 缺失值的处理

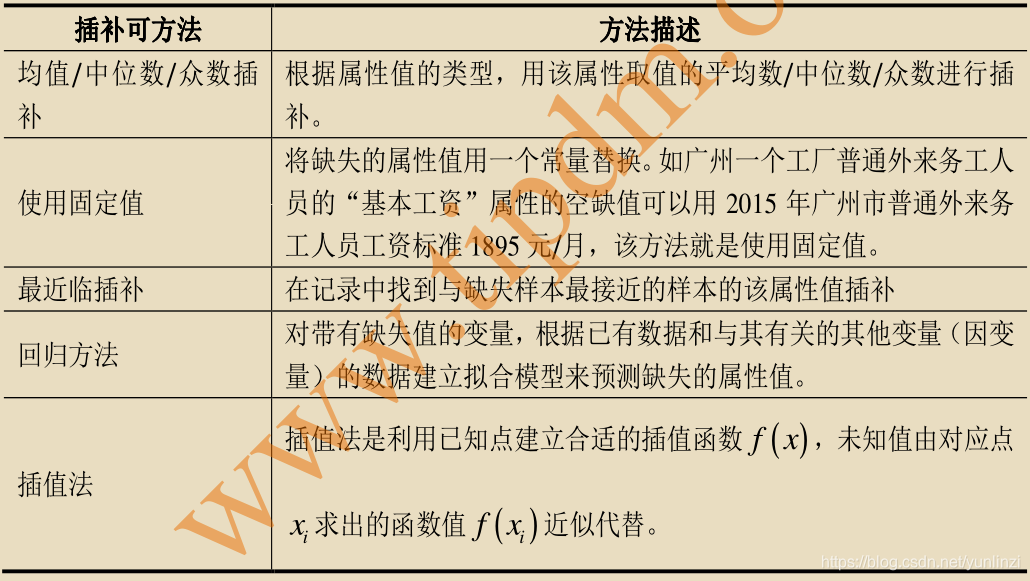

在处理缺失值时,常见的方法有:

- **删除含有缺失值的记录**:适用于数据量大且缺失值较多的情况。

- **填充缺失值**:可以使用统计方法,例如均值、中位数或者众数进行填充,或者基于其他记录进行预测填充。

#### 示例代码块:使用Python进行缺失值填充

```python

import pandas as pd

# 假设有一个名为data的数据框,其中含有缺失值

data = pd.DataFrame({

'A': [1, 2, None, 4],

'B': [5, None, None, 8]

})

# 使用均值填充数值型数据列的缺失值

data.fillna(data.mean(), inplace=True)

# 使用众数填充分类数据列的缺失值

data['B'] = data['B'].fillna(data['B'].mode()[0])

print(data)

```

在上述代码中,`fillna`函数用于填充缺失值。参数`data.mean()`计算每列的均值并用其填充对应列的缺失值,`data['B'].mode()[0]`则用于填充列B的众数。此代码段展示了如何针对不同类型的数据采用不同的缺失值处理方法。

### 2.2.2 重复数据的检测与删除

重复数据可能会扭曲分析结果,因此需要在数据清洗中识别和删除重复项。

#### 示例代码块:使用Python删除重复数据

```python

# 使用pandas的drop_duplicates方法删除重复数据

data = pd.DataFrame({

'Name': ['John', 'Anna', 'John', 'Peter', 'Anna'],

'Age': [19, 20, 19, 21, 20]

})

# 删除完全重复的行

data.drop_duplicates(inplace=True)

# 删除指定列的重复数据(例如只在Name列有重复的情况)

data.drop_duplicates(subset='Name', keep='first', inplace=True)

print(data)

```

在这个代码块中,`drop_duplicates`函数被用来移除重复的数据行。`subset`参数指定了哪些列应该用来检测重复,`keep`参数控制保留哪一个重复项(在这里,保留第一次出现的记录)。

### 2.2.3 异常值的识别与处理

异常值可以是数据集中的离群点或错误值,通常需要通过特定的方法进行识别和处理。

#### 示例代码块:使用Python识别和处理异常值

```python

import numpy as np

# 假设data['Age']列中含有异常值

data = pd.DataFrame({

'Age': [19, 20, 19, 21, 100]

})

# 使用标准差方法识别异常值

z_scores = np.abs((data['Age'] - data['Age'].mean()) / data['Age'].std())

outliers = data[z_scores > 3]

# 处理异常值,例如将其替换为均值

data['Age'] = np.where(z_scores > 3, data['Age'].mean(), data['Age'])

print(data)

```

该代码段首先计算了数据列的均值和标准差,并用这些统计参数找出异常值。然后,使用`np.where`函数将这些异常值替换为均值。处理异常值的方法很多,具体采取哪种方法应根据数据的特性和分析目标来决定。

## 2.3 数据预处理技术

数据预处理旨在转换原始数据为适合模型分析的格式。本节将介绍数据标准化、归一化、离散化、编码等技术。

### 2.3.1 数据标准化和归一化

数据标准化和归一化是转换数据特征以保证在分析过程中具有同等重要性的常用方法。

#### 示例代码块:数据标准化和归一化的Python实现

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 假设有标准化和归一化前的特征数据

data = pd.DataFrame({

'Feature1': [100, 200, 300],

'Feature2': [20, 30, 40]

})

# 数据标准化:特征值减去均值后除以标准差

scaler_standard = StandardScaler()

data_standard = scaler_standard.fit_transform(data)

# 数据归一化:将数据特征缩放到0到1之间

scaler_minmax = MinMaxScaler()

data_minmax = scaler_minmax.fit_transform(data)

print("Standardized data:\n", data_standard)

print("Normalized data:\n", data_minmax)

```

在这段代码中,`StandardScaler`和`MinMaxScaler`是`sklearn`库中用来执行数据标准化和归一化的两个不同的类。标准化使数据具有零均值和单位方差,而归一化则是把数据缩放到0到1之间的范围,这有助于加速模型收敛和提升模型表现。

### 2.3.2 数据离散化和编码

某些算法需要数据是离散的或者以数值型代码的形式存在。将类别变量转换为适合机器学习模型处理的形式是数据预处理的一部分。

#### 示例代码块:数据离散化与编码

```python

import pandas as pd

from sklearn.preprocessing import LabelEncoder

# 假设有一个包含类别数据的dataframe

data = pd.DataFrame({

'Category': ['Low', 'Medium', 'High', 'Medium', 'Low']

})

# 使用LabelEncoder将类别标签转换为数值

label_encoder = LabelEncoder()

data['CategoryEncoded'] = label_encoder.fit_transform(data['Category'])

print(data)

```

在这个例子中,`LabelEncoder`类将类别标签转换为数值代码。原始的类别数据通过`.fit_transform`方法被转换为数值型,这在构建机器学习模型时特别有用。

### 2.3.3 数据转换与集成

数据转换涉及对数据进行一些数学操作,以增加模型的有效性。集成方法则是将来自不同源的数据集合并为一个数据集的过程。

#### 示例代码块:数据转换与集成的Python实现

```python

from sklearn.preprocessing import PowerTransformer

import pandas as pd

# 假设有一个包含非正态分布数据的数据框

data = pd.DataFrame({

'Feature1': [100, 200, 300],

'Feature2': [20, 30, 40]

})

# 使用PowerTransformer进行Yeo-Johnson转换,以改善数据的正态性

transformer = PowerTransformer(method='yeo-johnson')

data_transformed = transformer.fit_transform(data)

print("Transformed data:\n", data_transformed)

```

在这个例子中,`PowerTransformer`用Yeo-Johnson转换来改善数据的正态性。这种转换适用于连续型数据,有助于后续的分析和建模工作。

以上详细介绍了数据清洗和预处理技术的基础知识,并通过具体的代码示例展示了这些方法的实现步骤。数据清洗是数据分析与建模之前的必要步骤,只有通过有效的清洗过程,才能确保数据的准确性和可靠性,为数据分析和决策提供坚实的基础。下一章将通过一个实际应用案例,展示如何将这些数据清洗技术应用于具体场景中。

# 3. UserList在数据清洗中的应用案例

## 3.1 UserList简介及应用环境

### 3.1.1 UserList工具的特点和功能

UserList是一款专门为数据清洗和预处理设计的工具,它集成了多种功能来帮助数据科学家和分析师快速有效地处理数据问题。UserList的关键特点在于其直观的用户界面、强大的脚本能力以及灵活性,允许用户轻松创建、修改和应用数据清洗规则。它支持批量数据处理,可以处理各种格式的数据文件,如CSV、JSON和数据库表等。

UserList提供的功能覆盖数据清洗的各个方面,包括但不限于缺失值处理、重复数据的检测与删除、数据类型转换、异常值的识别与处理等。它还支持数据的合并、分割和重组,使得处理复杂的数据结构变得

0

0