【系统级仿真的数据管理】:有效管理仿真数据和结果的技巧

发布时间: 2024-12-28 15:50:45 阅读量: 4 订阅数: 9

基于MODBUS总线的数据采集与开关控制系统设计仿真

# 摘要

系统级仿真在工程设计和验证中扮演着关键角色,而高效的数据管理是仿真成功的关键要素。本文从数据管理的基础出发,详细探讨了数据采集、预处理、存储、检索、分析以及安全备份等核心环节。针对数据采集,本文强调了工具选择和数据格式标准化的重要性。在数据预处理环节,着重分析了处理缺失值、异常值检测与处理以及数据归一化的技术。在存储策略章节,比较了关系型与非关系型数据库,并深入探讨了数据仓库的设计和实现。在高效数据检索与分析方面,索引技术和查询优化技巧被提出。最后,数据安全与备份章节涵盖了加密、访问控制及备份与灾难恢复计划。通过案例研究与实战技巧的分享,本文为系统级仿真中的数据管理提供了实用的指导和解决方案。

# 关键字

系统级仿真;数据管理;采集技术;预处理;数据库管理;数据安全

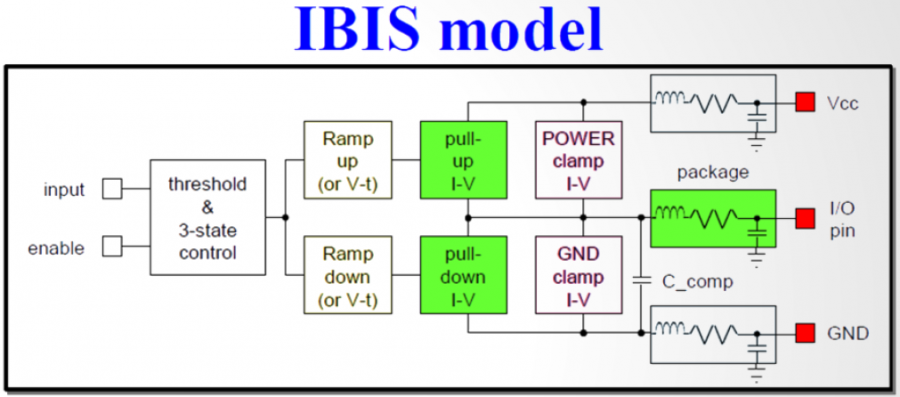

参考资源链接:[使用LTspice创建IBIS模型:系统级仿真的实践指南](https://wenku.csdn.net/doc/qcv43qg4wg?spm=1055.2635.3001.10343)

# 1. 系统级仿真的数据管理基础

在现代的系统级仿真中,数据管理是确保仿真准确性和高效性的关键。作为数据管理的基础,本章将介绍数据管理的核心概念以及它在仿真中的应用,并解释为什么精确的数据管理对于生成可靠仿真结果至关重要。

## 数据管理的重要性

数据管理涉及数据的收集、存储、处理、分析和保护。在系统级仿真中,数据可能是多来源、高维度和动态变化的。一个良好的数据管理策略将帮助工程师和研究人员有效地组织和访问数据,从而加速仿真模型的开发过程并提高其准确性。

## 数据管理与仿真准确性

仿真准确性依赖于高质量的数据。数据管理能够确保数据的一致性、完整性和准确性,从而避免在仿真过程中因数据错误导致的偏差。此外,通过合理的数据管理,可以实现数据的快速检索,使得工程师能够迅速获取历史数据和仿真结果,用于验证和改进仿真模型。

# 2. 数据采集与预处理

在当今高度数字化的世界,数据成为了企业最宝贵的资产之一。数据采集与预处理是数据管理过程中的关键步骤,它确保了数据的质量、一致性和可用性,为后续的数据分析和决策提供了坚实的基础。在本章节中,我们将深入探讨数据采集技术以及数据预处理方法,帮助您更好地理解和掌握如何从原始数据中提取有用信息,并为数据的存储、检索与分析打下坚实的基础。

## 2.1 数据采集技术

数据采集技术的选择对于确保数据质量至关重要。它不仅涉及工具的选择,还包含数据格式的标准化,以便于在不同的系统和应用程序之间进行交换和使用。

### 2.1.1 采集工具的选择与使用

选择合适的采集工具是数据采集的第一步。工具的选择应基于数据源的类型、采集频率、数据规模以及企业的技术栈。以下是一些常见的数据采集工具及其使用场景:

- **日志文件分析工具**:如Fluentd或Logstash,适合于从服务器日志文件中采集数据。

- **数据库集成工具**:如Talend或Pentaho,适用于从关系型数据库和非关系型数据库中抽取数据。

- **网络爬虫**:如Scrapy或BeautifulSoup,用于从网站采集公开可用的数据。

- **API集成**:使用编程语言内置的HTTP库(例如Python的requests库),从Web API获取数据。

选择工具后,接下来是实际的使用步骤。以Python的requests库为例:

```python

import requests

# 从Web API获取数据

response = requests.get('https://api.example.com/data')

data = response.json()

# 将获取的数据保存到本地文件或数据库

with open('data.json', 'w') as file:

file.write(data)

```

在上述代码块中,我们使用requests库从一个假想的API地址获取数据,并将其保存为JSON格式。选择合适的采集工具和正确的使用方法能够有效提升数据采集的效率和质量。

### 2.1.2 数据格式标准化

数据格式的标准化是数据采集的另一个重要环节。标准化后的数据不仅易于交换和存储,还可以提高数据处理和分析的效率。常用的数据格式包括CSV、JSON、XML等。

标准化步骤可以包括:

- **数据映射**:将采集到的数据映射到标准的数据模型中。

- **数据转换**:将非标准格式的数据转换为标准格式,如将XML转换为JSON。

- **数据清洗**:确保数据符合标准化要求,移除或填补不一致的数据。

```mermaid

flowchart LR

A[原始数据] --> B[数据映射]

B --> C[数据转换]

C --> D[数据清洗]

D --> E[标准化数据]

```

在mermaid格式的流程图中,我们展示了数据标准化的过程。通过逐一处理,最终获得符合要求的标准化数据。

## 2.2 数据预处理方法

数据预处理是数据采集后的关键步骤,其目的是将原始数据转换为适合分析的格式。主要方法包括缺失值处理、异常值检测与处理以及数据归一化和特征提取。

### 2.2.1 缺失值处理

在实际数据采集过程中,缺失值是一个常见问题。数据缺失可能是由于采集过程中传感器故障、数据传输问题或人为因素造成的。处理缺失值的方法有很多,如删除含有缺失值的记录、数据插补和平均值填充等。

例如,在Python中使用pandas库处理缺失值:

```python

import pandas as pd

# 加载数据

data = pd.read_csv('data.csv')

# 处理缺失值,这里用列的平均值进行填充

data.fillna(data.mean(), inplace=True)

```

在上述代码中,我们读取了一个CSV格式的数据文件,并用该列的平均值来填充缺失值。处理缺失值是数据预处理中不可或缺的一步,因为大多数分析算法无法处理含有缺失值的数据集。

### 2.2.2 异常值检测与处理

异常值是数据集中那些不符合其他数据分布的观测值,可能是数据错误或真实现象的反映。检测异常值通常使用统计方法,如Z-score法和IQR(四分位距)法。

```python

# 使用Z-score法检测异常值

from scipy import stats

import numpy as np

data['z_scores'] = np.abs(stats.zscore(data))

data = data[(data['z_scores'] < 3).all(axis=1)]

```

在上面的代码示例中,我们使用了SciPy库来计算Z-score,然后过滤掉z_scores大于3的记录,以排除可能的异常值。异常值的检测与处理能够帮助提高数据分析的准确性。

### 2.2.3 数据归一化和特征提取

数据归一化是调整不同数值范围的数据以实现统一标准,这在很多机器学习算法中非常重要。常用的归一化方法包括最小-最大归一化和Z-score标准化。

```python

# 最小-最大归一化

data_normalized = (data - data.min()) / (data.max() - data.min())

```

特征提取则是从原始数据中提取出有助于分析和预测的特征的过程。这对于提高模型性能和解释性至关重要。特征提取通常涉及主成分分析(PCA)和自动编码器等高级技术。

```python

from sklearn.decomposition import PCA

# 应用PCA进行特征提取

pca = PCA(n_components=2)

data_reduced = pca.fit_transform(data)

```

在上面的代码中,我们使用PCA将数据从高维空间降至二维,这样可以简化模型并提高性能。数据归一化和特征提取是数据预处理中用于提高模型性能的重要步骤。

预处理后的数据可以进一步用于存储、检索和分析,为后续的数据处理流程提供了准确和一致的数据源。在下一章,我们将讨论如何有效地存储这些数据,以便于高效检索和分析。

# 3. 仿真数据存储策略

在仿真系统中,数据存储是至关重要的环节,它不仅需要保证数据的完整性和安全性,还要满足系统性能的需要。合理的数据存储策略可以提升数据检索速度,优化数据处理流程,确保数据的有效利用。

## 3.1 数据库管理系统选择

选择合适的数据库管理系统(DBMS)是数据存储策略的首要任务。根据不同的应用场景

0

0