Spark大数据分析实战:深入解析Spark生态系统和应用场景

发布时间: 2024-08-18 08:24:38 阅读量: 48 订阅数: 48

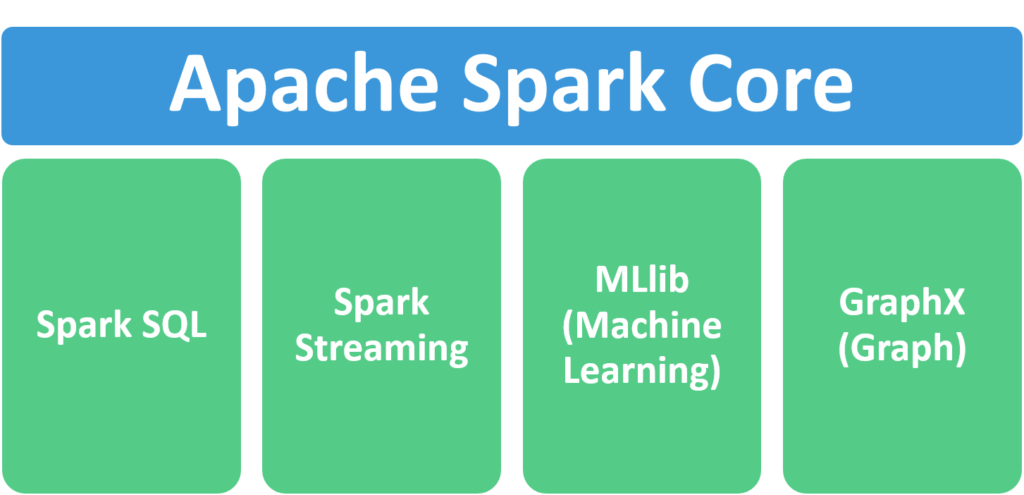

# 1. Spark生态系统概览

Apache Spark是一个强大的分布式计算框架,用于处理大规模数据集。它提供了一个统一的平台,用于执行各种数据分析任务,包括数据预处理、机器学习和图形分析。

Spark生态系统由一组组件组成,包括:

* **Spark Core:**提供分布式计算引擎、内存管理和容错机制。

* **Spark SQL:**提供对结构化数据的支持,允许使用SQL查询和转换数据。

* **Spark Streaming:**提供对实时数据流的处理,支持窗口和聚合操作。

* **Spark MLlib:**提供机器学习库,用于构建和训练机器学习模型。

* **Spark GraphX:**提供图形处理库,用于分析图形数据和社交网络。

# 2. Spark核心组件和原理

### 2.1 Spark的分布式计算框架

#### 2.1.1 RDD和DAG

**RDD(弹性分布式数据集)**是Spark中用于表示分布式数据集的基本抽象。RDD是一个不可变的、分区的数据集合,可以并行处理。它提供了在集群中的不同节点上高效地存储和处理大型数据集的方法。

**DAG(有向无环图)**表示RDD之间的依赖关系。当一个RDD被创建或转换时,Spark会创建一个DAG来跟踪其依赖关系。这使Spark能够优化计算,只重新计算受影响的RDD,而不是整个数据集。

#### 2.1.2 内存管理和容错机制

**内存管理**对于Spark的性能至关重要。Spark使用一种称为**弹性分布式数据集(RDD)**的抽象来管理内存。RDD将数据存储在集群中的不同节点上,并提供了一个统一的接口来访问数据。Spark还使用一种称为**内存池**的机制来管理不同类型数据的内存分配。

**容错机制**对于Spark在分布式环境中可靠地运行至关重要。Spark使用**检查点**和**血统跟踪**来实现容错。检查点将RDD持久化到外部存储,以便在节点故障时可以恢复。血统跟踪记录RDD之间的依赖关系,以便在节点故障时可以重新计算受影响的RDD。

### 2.2 Spark SQL和DataFrames

#### 2.2.1 SQL查询和数据转换

**Spark SQL**是一个Spark模块,它允许用户使用SQL查询和转换数据。Spark SQL将SQL查询编译成优化后的RDD操作,从而可以在分布式环境中高效地执行查询。

**DataFrames**是Spark SQL中表示结构化数据的抽象。DataFrames是RDD的扩展,它提供了对数据进行操作的更高级别的API。DataFrames支持各种数据类型,并提供了一个类似于关系数据库的编程模型。

#### 2.2.2 优化和性能调优

**优化**对于提高Spark SQL查询的性能至关重要。Spark SQL使用各种优化技术,例如**谓词下推**、**连接重排**和**查询计划优化**。这些优化有助于减少数据处理量和提高查询速度。

**性能调优**涉及调整Spark SQL的配置和参数以获得最佳性能。一些常见的性能调优技术包括**调整内存设置**、**启用批处理**和**使用索引**。

### 2.3 Spark Streaming和Structured Streaming

#### 2.3.1 实时数据处理模型

**Spark Streaming**是一个Spark模块,它允许用户处理实时数据流。Spark Streaming将数据流分成小批次,并使用RDD对其进行处理。这使Spark Streaming能够以低延迟处理实时数据。

**Structured Streaming**是Spark Streaming的进化,它提供了对实时数据处理的更高级别的抽象。Structured Streaming使用DataFrames和SQL查询来表示和处理数据流。这简化了实时数据处理并提高了性能。

#### 2.3.2 窗口和聚合操作

**窗口**允许用户在数据流上定义时间范围。这使Spark Streaming和Structured Streaming能够执行基于时间的聚合和分析。

**聚合操作**允许用户对数据流中的数据进行聚合。Spark Streaming和Structured Streaming支持各种聚合操作,例如**求和**、**求平均值**和**求最大值**。

# 3. Spark大数据分析实战

### 3.1 数据预处理和特征工程

#### 3.1.1 数据清洗和转换

数据清洗是数据分析过程中至关重要的一步,它涉及识别和处理数据中的错误、缺失值和异常值。Spark提供了丰富的函数和操作来执行数据清洗任务,例如:

- `drop()`:删除包含缺失值的行或列

- `fillna()`:使用指定值填充缺失值

- `cast()`:将数据类型转换为所需的类型

- `replace()`:替换特定值或正则表达式匹配的值

#### 3.1.2 特征提取和选择

特征工程是将原始数据转换为机器学习模型可用的特征的过程。Spark MLlib提供了多种特征提取和选择方法,包括:

- **特征提取:**

- `VectorAssembler`:将多个列组合成一个特征向量

- `OneHotEncoder`:将类别变量转换为独热编码

- `HashingTF`:将文本数据转换为哈希特征向量

- **特征选择:**

- `ChiSqSelector`:基于卡方检验选择特征

- `VarianceThresholdSelector`:基于方差阈值选择特征

- `LinearRegression`:使用线性回归模型选择特

0

0