PLS UDE UAD数据质量优化:处理高级技巧大公开

发布时间: 2024-12-03 23:18:07 阅读量: 13 订阅数: 25

PLS UDE UAD 入门级使用说明.pptx

参考资源链接:[UDE入门:Tricore多核调试详解及UAD连接步骤](https://wenku.csdn.net/doc/6412b6e5be7fbd1778d485ca?spm=1055.2635.3001.10343)

# 1. 数据质量优化概述

在当今的数据驱动时代,数据质量是组织决策过程中的核心资产。数据质量优化指的是通过一系列方法和策略,提升数据的准确性、一致性、完整性和时效性。高质量的数据对于企业决策、市场分析、产品优化以及风险管理等都至关重要。

数据质量问题如果得不到妥善解决,将直接影响到企业的运营效率和竞争优势。因此,企业需要对数据质量进行定期评估和维护,确保数据在各个业务流程中能够发挥其应有的价值。

为了优化数据质量,企业通常需要构建一套完整的工作流程,包括数据清洗、数据集成、数据转换以及持续的数据质量评估与监控。在下一章节中,我们将详细探讨数据清洗的重要性及其实践方法。

# 2. 数据清洗的理论与实践

数据清洗是数据质量优化的首要步骤,它旨在提高数据的准确性和可用性,确保数据分析和决策的质量。在这一章节中,我们将深入探讨数据清洗的理论基础,并提供实践技巧,帮助读者有效地进行数据清洗工作。

## 2.1 数据清洗的重要性

数据清洗工作在任何数据处理流程中都占据着至关重要的地位。不准确或不完整的信息会导致错误的分析结果,进而影响决策质量。

### 2.1.1 数据质量问题的影响

在数据驱动的决策过程中,数据质量问题会带来多方面的负面影响。数据不准确可能导致错误的商业判断、客户关系管理的失误、甚至财务报告的失真。而数据不完整则会限制分析的深度和准确性,无法提供全面的业务洞察。数据不一致则会造成不同系统间的数据差异,影响数据的可靠性。

### 2.1.2 数据清洗的目标与作用

数据清洗的主要目标是确保数据的准确性、完整性和一致性,从而提高数据质量。通过数据清洗,我们可以移除或修正错误的数据记录,填充缺失值,识别并处理异常值,合并重复数据。数据清洗的作用远不止于此,它还能帮助我们发现数据中的模式和关联,为数据分析和挖掘提供更加坚实的基础。

## 2.2 数据清洗的基本技术

数据清洗涉及多种基本技术,包括处理缺失值、检测和处理异常值、识别和合并重复数据等。

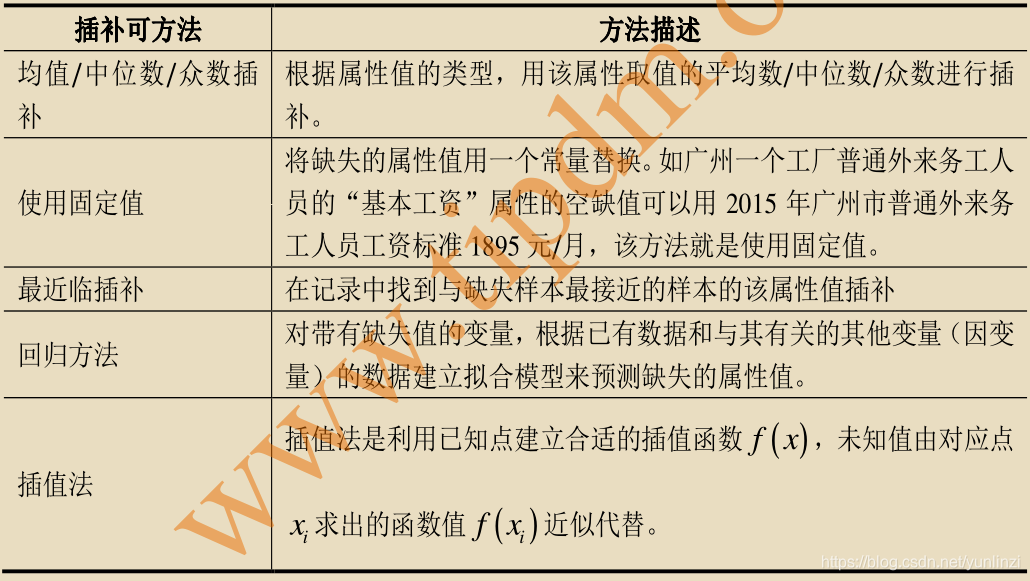

### 2.2.1 缺失值处理

缺失值是数据集中常见的问题之一。处理缺失值有多种方法:

- 删除含有缺失值的记录。

- 用平均值、中位数或众数填充缺失值。

- 使用预测模型预测缺失值。

选择合适的方法取决于数据和分析需求。例如,在Python中,我们可以用Pandas库的`fillna`方法进行缺失值填充:

```python

import pandas as pd

# 创建DataFrame示例

data = pd.DataFrame({

'A': [1, 2, None, 4],

'B': [5, None, 7, 8]

})

# 用列的均值填充缺失值

data_filled = data.fillna(data.mean())

print(data_filled)

```

### 2.2.2 异常值检测与处理

异常值指的是那些不符合预期模式的数据点,可能由错误或噪声造成。异常值的处理方法包括:

- 删除异常值。

- 修正异常值,使其更接近正常数据。

- 保留异常值,但进行标记,以备后续分析。

使用Z-score或IQR(四分位距)等统计方法可以帮助我们检测异常值。

```python

from scipy import stats

import numpy as np

# 生成数据

data = np.random.normal(0, 1, 1000)

# 添加异常值

data = np.append(data, [10, -10])

# 计算Z-score

z_scores = np.abs(stats.zscore(data))

threshold = 3

# 标记异常值

data[(z_scores > threshold)]

```

### 2.2.3 重复数据的识别与合并

重复数据是指完全相同的记录在数据集中出现多次。识别和合并重复数据可以减少分析的偏差,提高数据质量。Pandas库提供了`duplicated`方法来标记重复记录:

```python

# 假定data是之前创建的DataFrame

# 检测并删除重复数据

data_deduped = data.drop_duplicates()

print(data_deduped)

```

## 2.3 数据清洗的高级技巧

随着数据集的增长和复杂性的提高,数据清洗的方法也需要更加高级和精细。

### 2.3.1 自然语言处理在清洗中的应用

自然语言处理(NLP)技术可以应用于文本数据的清洗。例如,去除停用词、词干提取、文本分类等,以提取有用信息和减少噪声。

```python

import nltk

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

# 下载停用词集

nltk.download('stopwords')

nltk.download('wordnet')

# 初始化词干提取器

lemmatizer = WordNetLemmatizer()

def clean_text(text):

stop_words = set(stopwords.words('english'))

words = text.split()

cleaned_words = [lemmatizer.lemmatize(w) for w in words if w not in stop_words]

return ' '.join(cleaned_words)

# 示例文本处理

cleaned_text = clean_text("The quick br

```

0

0