JSON数据库事务处理:深入解析事务机制,提升数据一致性

发布时间: 2024-07-29 12:54:11 阅读量: 28 订阅数: 29

基于微信小程序的社区门诊管理系统php.zip

# 1. JSON数据库事务概述**

JSON数据库事务是一种机制,用于确保数据库操作的原子性、一致性、隔离性和持久性(ACID)。它允许应用程序执行一组操作,这些操作要么全部成功,要么全部失败,从而确保数据库的完整性。

事务处理在JSON数据库中至关重要,因为它可以防止数据不一致,例如当多个用户同时尝试更新同一记录时。事务机制通过锁定机制或乐观锁和悲观锁等并发控制机制来实现,这些机制确保在事务执行期间,其他用户无法访问受影响的数据。

# 2. 事务机制的理论基础

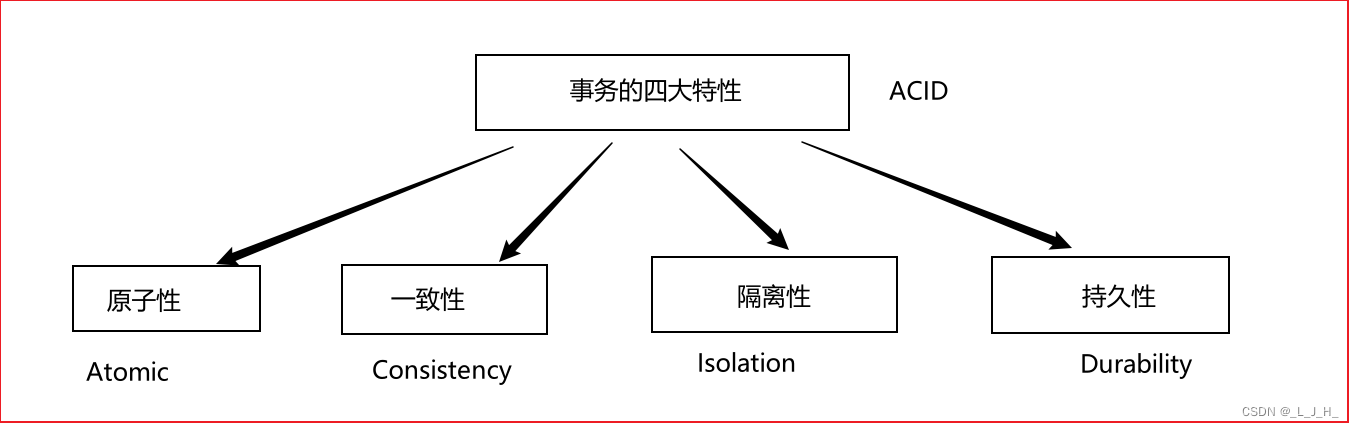

### 2.1 事务的特性(ACID)

事务是数据库系统中一个不可分割的工作单元,它具有以下四个特性,即 ACID 特性:

- **原子性(Atomicity):**事务中的所有操作要么全部成功,要么全部失败,不存在中间状态。

- **一致性(Consistency):**事务执行前后,数据库必须处于一致状态,即满足所有业务规则和约束。

- **隔离性(Isolation):**多个并发事务相互隔离,不会互相影响,每个事务都像在独立执行一样。

- **持久性(Durability):**一旦事务提交成功,其对数据库的修改将永久生效,即使系统发生故障也不会丢失。

### 2.2 事务的并发控制机制

并发控制机制是确保事务隔离性的关键技术,它通过协调多个并发事务的执行,防止数据不一致的发生。

#### 2.2.1 锁机制

锁机制是传统的并发控制机制,它通过对数据对象加锁的方式,防止其他事务同时访问和修改数据。锁的类型包括:

- **排他锁(X 锁):**允许事务独占访问数据对象,其他事务不能同时访问。

- **共享锁(S 锁):**允许多个事务同时读数据对象,但不能修改。

- **意向锁(IX 锁):**表示事务打算对数据对象加排他锁,阻止其他事务加共享锁。

- **意向共享锁(IS 锁):**表示事务打算对数据对象加共享锁,阻止其他事务加排他锁。

#### 2.2.2 乐观锁和悲观锁

乐观锁和悲观锁是两种不同的并发控制策略:

- **乐观锁:**假设事务不会冲突,只在事务提交时才检查数据是否被修改。如果检测到冲突,则回滚事务。

- **悲观锁:**假设事务会冲突,在事务开始时就对数据加锁,防止其他事务修改数据。

### 2.3 事务的隔离级别

隔离级别定义了事务之间相互隔离的程度,不同隔离级别下,事务看到的其他事务执行结果不同。常见的隔离级别包括:

- **读未提交(Read Uncommitted):**事务可以读取其他事务未提交的数据,可能读取到不一致的数据。

- **读已提交(Read Committed):**事务只能读取其他事务已提交的数据,保证了数据一致性。

- **可重复读(Repeatable Read):**事务在执行过程中,不会看到其他事务提交的修改,保证了事务内的读操作一致性。

- **串行化(Serializable):**事务执行的顺序与串行执行完全相同,保证了最高程度的隔离性。

**代码块:**

```python

import json

# 开启事务

with db.transaction() as tx:

# 执行事务操作

tx.insert("users", {"name": "Alice"})

tx.update("users", {"name": "Bob"}, {"name": "Alice"})

# 提交事务

tx.commit()

```

**逻辑分析:**

这段代码演示了如何使用 Python 客户端开启和提交事务。`with` 语句用于开启事务,事务操作在 `with` 块中执行。`tx.commit()` 方法用于提交事务,使修改永久生效。

**参数说明:**

- `db`:JSON 数据库的客户端对象。

- `tx`:事务对象。

- `insert()`:插入数据的函数。

- `update()`:更新数据的函数。

# 3. JSON数据库事务实践

### 3.1 JSON数据库的事务操作

#### 3.1.1 事务的开启和关闭

**开启事务**

```json

{

"start_transaction": true

}

```

**参数说明:**

- `start_transaction`: 布尔值,指定是否开启事务。

**逻辑分析:**

该命令开启一个新的事务,后续对数据库的操作都将在该事务中进行。

**关闭事务**

```json

{

"end_transaction": true

}

```

**参数说明:**

- `end_transaction`: 布尔值,指定是否关闭事务。

**逻辑分析:**

该命令关闭当前事务,提交或回滚事务中的所有操作。

#### 3.1.2 事务的提交和回滚

**提交事务**

```json

{

"commit_transaction": true

}

```

**参数说明:**

- `commit_transaction`: 布尔值,指定是否提交事务。

**逻辑分析:**

该命令提交当前事务,将事务中的所有操作永久性地应用到数据库中。

**回滚事务**

```json

{

"rollback_transaction": true

}

```

**参数说明:**

- `rollback_transaction`: 布尔值,指定是否回滚事务。

**逻辑分析:**

该命令回滚当前事务,撤销事务中的所有操作,使数据库恢复到事务开启前的状态。

### 3.2 JSON数据库的事务隔离级别

#### 3.2.1 事务隔离级别的影响

**隔离级别** | **影响**

---|---|

读未提交 | 允许读取未提交的事务中的数据,可能导致脏读。

读已提交 | 只允许读取已提交的事务中的数据,避免脏读。

可重复读 | 确保事务在执行期间不会看到其他事务对同一数据的更新,避免不可重复读。

串行化 | 严格保证事务的串行执行,避免幻读。

#### 3.2.2 不同隔离级别下的并发场景

**隔离级别** | **并发场景**

---|---|

读未提交 | 并发高,数据一致性要求低。

读已提交 | 并发中等,数据一致性要求较高。

可重复读 | 并发低,数据一致性要求极高。

串行化 | 并发极低,数据一致性要求最高。

**表格说明:**

- **并发高**:允许多个事务同时执行,数据一致性要求较低。

- **并发中等**:允许一定程度的并发,但需要保证数据一致性。

- **并发低**:限制并发,以确保数据的一致性。

- **并发极低**:严格限制并发,以保证数据的绝对一致性。

**mermaid流程图:**

```mermaid

graph LR

subgraph 事务隔离级别

A[读未提交] --> B[读已提交]

B[读已提交] --> C[可重复读]

C[可重复读] --> D[串行化]

end

```

# 4. 事务机制的性能优化

### 4.1 事务性能瓶颈分析

事务性能瓶颈通常是由以下因素引起的:

- **事务范围过大:**事务包含的更新操作过多,导致锁定的数据范围过大,影响并发性能。

- **事务并发度过高:**同时执行的事务过多,导致锁冲突频繁,影响事务吞吐量。

- **隔离级别过高:**隔离级别越高,锁定的范围越大,对并发性能的影响越大。

- **死锁:**多个事务相互等待释放锁,导致系统陷入僵局。

### 4.2 事务优化策略

#### 4.2.1 减少事务范围

- **拆分事务:**将大事务拆分成多个小事务,减少单次事务锁定的数据范围。

- **使用批量更新:**一次性更新多个数据,减少事务执行次数。

#### 4.2.2 优化事务并发

- **使用乐观锁:**乐观锁只在提交事务时才检查数据冲突,减少锁冲突的概率。

- **调整隔离级别:**根据实际业务场景,选择合适的隔离级别,降低锁冲突的频率。

- **使用索引:**为经常查询的数据创建索引,加快数据访问速度,减少锁等待时间。

### 4.3 事务监控和故障处理

**事务监控**

- **监控事务执行时间:**识别执行时间过长的事务,分析原因并优化。

- **监控事务回滚率:**高回滚率可能表明存在数据冲突或其他问题。

- **监控锁等待时间:**锁等待时间过长可能表明存在死锁或并发问题。

**故障处理**

- **回滚策略:**定义事务回滚的策略,确保数据一致性。

- **死锁检测和处理:**定期检测死锁,并采取措施释放锁或终止事务。

- **故障恢复:**建立故障恢复机制,在系统故障后恢复事务状态,保证数据完整性。

**代码示例:**

```python

# 使用乐观锁更新数据

def update_data(id, new_value):

data = get_data(id)

if data["version"] == current_version:

data["value"] = new_value

data["version"] += 1

save_data(data)

else:

raise OptimisticLockError("Data has been modified by another transaction.")

```

**参数说明:**

- `id`: 要更新的数据的ID。

- `new_value`: 要更新的数据的新值。

**逻辑分析:**

此代码使用乐观锁更新数据。它首先获取数据的当前版本号,然后检查当前版本号是否与数据库中的版本号一致。如果一致,则更新数据并增加版本号。如果不一致,则抛出乐观锁错误,表明数据已被另一个事务修改。

# 5.1 事务设计原则

在设计 JSON 数据库事务时,遵循以下原则至关重要:

- **原子性:**事务中的所有操作要么全部成功,要么全部失败。

- **一致性:**事务执行后,数据库处于一致状态,满足业务规则。

- **隔离性:**并发事务相互独立,不受彼此影响。

- **持久性:**一旦事务提交,其修改将永久保存,即使发生系统故障。

## 5.2 事务性能测试和监控

**事务性能测试:**

- 确定事务的性能基准。

- 模拟并发事务负载,测试事务处理能力。

- 识别性能瓶颈并进行优化。

**事务监控:**

- 监控事务执行时间、回滚率和死锁情况。

- 识别异常事务并采取补救措施。

- 确保事务机制正常运行,保障数据一致性。

## 5.3 事务故障恢复和数据一致性保障

**事务故障恢复:**

- **回滚机制:**当事务失败时,自动回滚所有已执行的操作,恢复数据库到事务开始时的状态。

- **故障转移:**在主数据库故障时,自动将事务转移到备用数据库,确保数据可用性。

**数据一致性保障:**

- **校验和:**定期检查数据库中的数据完整性,确保事务未导致数据损坏。

- **数据备份:**定期备份数据库,以防数据丢失或损坏。

- **灾难恢复计划:**制定灾难恢复计划,在发生重大故障时恢复数据和业务运营。

0

0