YOLOv10的部署与优化:从模型部署到性能调优,全面提升模型效能

发布时间: 2024-07-19 22:32:49 阅读量: 592 订阅数: 129

YOLOv8:预训练模型的多样性与效能

# 1. YOLOv10模型部署**

**1.1 模型下载与环境配置**

- 下载预训练的YOLOv10模型权重和配置文件。

- 配置必要的软件环境,包括Python、PyTorch和CUDA。

- 安装YOLOv10官方库或第三方实现。

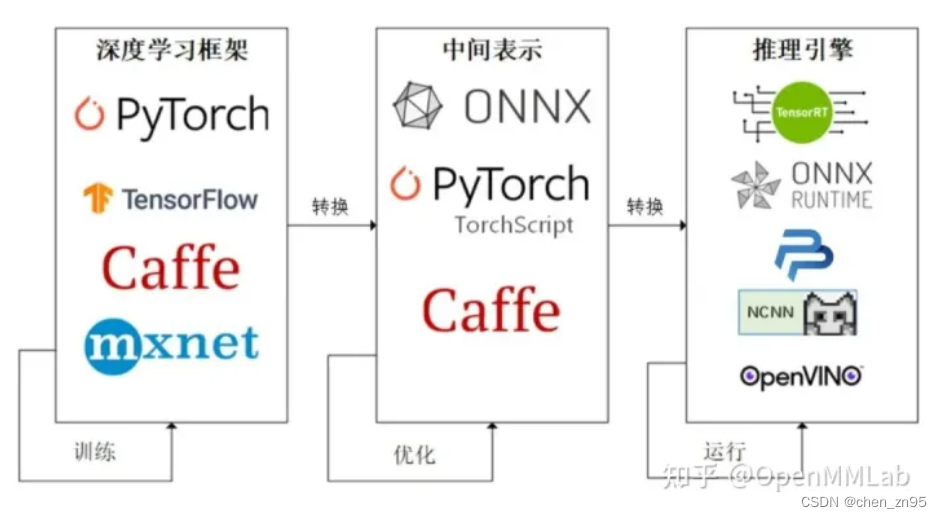

**1.2 模型推理引擎选择与安装**

- 选择合适的推理引擎,如TensorRT、ONNX Runtime或OpenVINO。

- 安装推理引擎并配置与YOLOv10模型兼容的选项。

- 优化推理引擎设置以获得最佳性能。

# 2. YOLOv10模型优化

### 2.1 模型量化与裁剪

#### 2.1.1 模型量化的原理与方法

模型量化是一种将浮点模型转换为定点模型的技术,可以有效降低模型的大小和计算成本。YOLOv10模型量化的主要方法有:

- **整数量化:**将浮点权重和激活值转换为整数,从而减少存储和计算开销。

- **二值化:**将权重和激活值转换为二进制值(0或1),进一步降低计算成本。

量化过程通常涉及以下步骤:

1. **训练量化感知模型:**在训练过程中,使用量化感知训练算法,在浮点模型中引入量化误差。

2. **校准:**使用代表性数据集校准量化模型,以最小化量化误差。

3. **量化:**将浮点模型转换为定点模型,并根据校准结果调整量化参数。

#### 2.1.2 模型裁剪的策略与实践

模型裁剪是一种去除冗余权重的技术,可以减小模型的大小和计算成本。YOLOv10模型裁剪的主要策略有:

- **权重剪枝:**移除对模型输出影响较小的权重,通常使用正则化技术或剪枝算法。

- **通道剪枝:**移除对模型输出影响较小的通道,通常使用卷积层输出的激活图进行评估。

裁剪过程通常涉及以下步骤:

1. **训练可裁剪模型:**在训练过程中,使用可裁剪训练算法,在模型中引入冗余权重。

2. **评估:**使用代表性数据集评估模型,并确定冗余权重。

3. **裁剪:**根据评估结果,移除冗余权重,并重新训练模型以恢复性能。

### 2.2 算法优化与超参数调整

#### 2.2.1 算法优化技巧与案例分析

算法优化旨在通过修改模型结构或训练算法来提高模型性能。YOLOv10模型优化的常见技巧包括:

- **改进骨干网络:**使用更深或更宽的骨干网络,以提高模型的特征提取能力。

- **增强特征融合:**使用注意力机制或跳层连接,增强不同阶段的特征融合。

- **优化损失函数:**修改损失函数,以更有效地处理类不平衡或小目标检测问题。

#### 2.2.2 超参数调整的原则与方法

超参数调整是指调整模型训练过程中的超参数,以优化模型性能。YOLOv10模型优化的常见超参数包括:

- **学习率:**控制模型训练过程中的学习步长。

- **批量大小:**指定每个训练批次中样本的数量。

- **正则化参数:**控制模型的过拟合程度。

超参数调整通常涉及以下步骤:

1. **确定超参数范围:**根据经验或文献,确定超参数的合理取值范围。

2. **网格搜索或随机搜索:**使用网格搜索或随机搜索算法,在超参数范围内进行搜索。

3. **评估:**使用验证集评估不同超参数组合下的模型性能。

4. **选择最优超参数:**根据评估结果,选择最优的超参数组合。

# 3. YOLOv10性能调优

### 3.1 硬件加速与并行化

**3.1.1 GPU加速的原理与实现**

GPU(图形处理单元)是一种专门用于处理图形和视频计算的硬件设备。它具有强大的并行计算能力,可以显著提高YOLOv10模型的推理速度。

要使用GPU加速YOLOv10模型,需要:

1. 安装CUDA(Compute Unified Device Architecture)工具包,它提供了GPU编程的接口和工具。

2. 使用PyTorch或TensorFlow等支持GPU计算的深度学习框架。

3. 在模型推理代码中指定使用GPU设备。

**代码块:**

```python

import torch

# 指定使用GPU设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 将模型加载到GPU设备

model = model.to(device)

# 在GPU设备上推理

outputs = model(input_tensor)

```

**逻辑分析:**

* `torch.device("cuda")`:创建一个指定GPU设备的对象。

* `model.to(device)`:将模型加载到指定的设备。

* `model(input_tensor)`:在指定的设备上执行推理。

**3

0

0