【数据处理】:CL1689 ADC数据后处理的高效方法

发布时间: 2024-12-18 14:00:17 订阅数: 6

国产核芯互联的高速8通道16bit双极性输入200kSPS采样率真同步采样ADC芯片CL1606

# 摘要

本文全面概述了CL1689 ADC数据后处理的关键概念、理论基础和实践技巧。首先介绍了ADC数据的格式与转换原理,探讨了信号数字化过程中的关键问题,并构建了数据后处理的数学模型。随后,文中分析了数据质量评估标准,包括信号噪声和数据完整性的检查。在实践技巧方面,重点阐述了数据预处理、分析方法以及高效工具和库的选择。高级应用部分讨论了实时数据处理优化、机器学习和深度学习技术在数据后处理中的应用,并强调了数据安全与隐私保护的重要性。最后,通过具体案例研究,详细解析了CL1689 ADC数据后处理的实战应用,并提出了后续改进的方向和建议。

# 关键字

ADC数据后处理;数据格式转换;数学模型构建;数据质量评估;实时数据优化;机器学习;深度学习;数据安全;隐私保护;案例研究

参考资源链接:[CL1689:低功耗16位250KSPS 8通道SAR ADC详解及其特性](https://wenku.csdn.net/doc/fq1k8qfijw?spm=1055.2635.3001.10343)

# 1. CL1689 ADC数据后处理概述

在当今的IT行业中,尤其是在信号处理领域,ADC(模数转换器)扮演着至关重要的角色。它能够将模拟信号转换为数字信号,使计算机和其他数字系统能够处理这些数据。CL1689 ADC数据后处理是这个过程的延伸,它不仅包括了基本的信号转换,还包含了对采集到的数据进行深度解析和优化。本章节将为读者提供一个概览,解释为何后处理在数据处理中占有重要地位,以及它如何影响最终的结果。

## 1.1 数据后处理的重要性

数据后处理涉及到从数据采集到数据输出的每一个步骤,它确保了数据的准确性和可用性。通过对原始数据的进一步分析、校准和优化,数据后处理能够消除噪声、校正误差并提高数据的质量和价值。例如,在医疗成像、航空遥感等领域,数据后处理直接影响到图像的清晰度和诊断的准确性。

## 1.2 数据后处理的应用场景

数据后处理在各种应用场景中都有广泛的应用,包括但不限于:

- 工业自动化控制,提高生产效率和安全性。

- 智能家居系统,通过数据分析提供个性化服务。

- 生物医学领域,增强临床诊断的准确性和可靠性。

## 1.3 本章小结

本章通过概述CL1689 ADC数据后处理的重要性,为读者搭建了一个基础框架,让大家对数据后处理有一个全面的认识。后续章节将深入探讨数据后处理的理论基础、实践技巧以及高级应用,以实现更高效和精准的数据处理目标。

# 2. ```

# 第二章:数据后处理的理论基础

## 2.1 ADC数据格式与转换原理

### 2.1.1 ADC的基本概念和分类

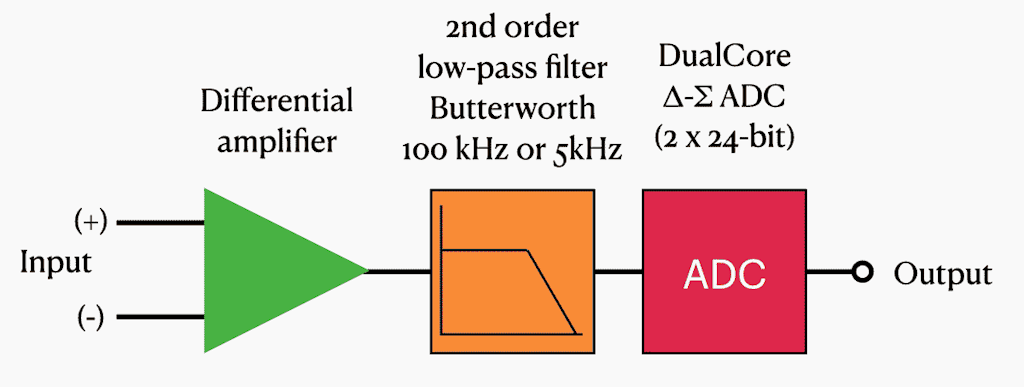

模数转换器(ADC, Analog-to-Digital Converter)是数据后处理中至关重要的一个组件,它将连续的模拟信号转换为离散的数字信号。ADC的工作基于采样定理,即如果一个模拟信号在最高频率下的采样率高于其两倍,则可以通过适当的数字处理完全恢复出原始信号。

ADC可以按照多种方式分类,比如按照转换速度可以分为高速ADC和低速ADC;按照精度可以分为高精度、中精度和低精度ADC。常见的分类还包括积分型ADC、逐次逼近型ADC以及ΔΣ(Delta-Sigma)ADC等。

### 2.1.2 信号数字化过程中的关键问题

信号在转换为数字格式时可能会遇到几个关键问题:

- **量化误差**:这是由有限分辨率所引起的,意味着模拟信号在转换过程中会有损失。

- **采样率**:采样率必须足够高以满足奈奎斯特采样定理,避免混叠现象的出现。

- **动态范围**:动态范围描述了ADC可以区分的最小和最大信号水平的能力,这对信号的信噪比(SNR)有着直接的影响。

## 2.2 数据后处理的数学模型

### 2.2.1 数学模型的构建和验证

构建数学模型是数据后处理的理论基础,其目的是尽可能准确地反映出原始信号的特征。这通常包括以下几个步骤:

1. **选择模型**:根据信号的特性选择合适的数学模型,如线性模型、多项式模型或非线性模型。

2. **参数估计**:确定模型参数,通常使用最小二乘法等统计方法。

3. **模型验证**:通过拟合优度检验,如决定系数(R²)来验证模型是否能很好地描述数据。

### 2.2.2 常见的数据处理算法

数据处理算法包括但不限于:

- **滤波算法**:例如高通、低通、带通和带阻滤波,用于提取有用信号,去除噪声。

- **插值算法**:如线性插值、样条插值,用于处理不连续的数据点。

- **去噪算法**:例如均值滤波、中值滤波和维纳滤波,用于提高数据质量。

## 2.3 数据质量评估

### 2.3.1 信号的噪声分析

噪声是影响数据质量的重要因素。常见的噪声类型包括:

- **热噪声**:由电阻器的热能随机运动产生。

- **散粒噪声**:例如在光电探测器中的电子随机发射。

- **1/f噪声**:在低频时噪声功率与频率成反比。

噪声分析通常会通过功率谱密度(PSD)来进行,PSD显示了信号功率在频率上的分布。

### 2.3.2 数据完整性和准确性的检查

数据完整性和准确性是评估数据质量的两个重要指标。完整性检查可能会涉及到数据丢失率、重复数据的识别和处理等。准确性则包括对数据值的真实性和可靠性进行检验,如使用对照组或标准样本进行验证。

数据完整性可以通过记录数据生成和传输过程的元数据来确保,而准确性则可以通过校准过程和统计检验方法来保证。例如,使用t检验来确定两组数据的均值是否有显著差异。

```

# 3. 数据后处理的实践技巧

## 3.1 数据预处理步骤

在任何数据分析和处理的工作流程中,数据预处理占据了至关重要的位置,它不仅影响最终处理结果的准确性,也是后续高级分析的前提。数据预处理通常涉及数据清洗、格式化、噪声去除以及异常值处理等步骤。

### 3.1.1 数据清洗和格式化

数据清洗的目的在于识别和修正数据集中的错误、不一致性或缺失值。格式化则是将数据转换为适合分析的格式,例如,将时间戳统一转换为ISO 8601标准格式,或者将字符串格式的数字转换为数值型。

```python

import pandas as pd

import numpy as np

# 示例:数据清洗与格式化

# 假设我们有一个包含噪声和格式不一致数据的CSV文件

df = pd.read_csv('raw_data.csv')

# 处理缺失值

df = df.dropna() # 删除缺失值

df.fillna(method='ffill', inplace=True) # 前向填充缺失值

# 统一时间格式

df['timestamp'] = pd.to_datetime(df['timestamp'], errors='coerce', format='%Y-%m-%d %H:%M:%S')

# 示例数据转换

df['value'] = pd.to_

```

0

0