HiGale数据流ETL优化:关键转换步骤的4个高效策略

发布时间: 2024-12-19 07:16:33 阅读量: 15 订阅数: 14

使用 SQL 简化 ETL 管道:数据处理的三个技巧

# 摘要

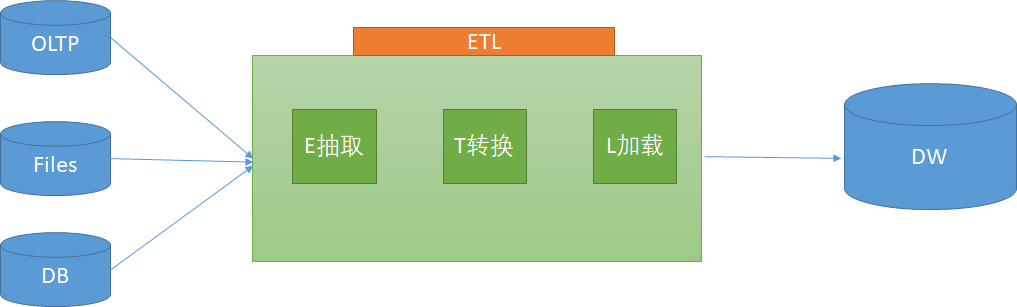

本文综述了HiGale数据流ETL(提取、转换、加载)优化的关键策略和实践方法。通过详述数据采集与清洗、转换步骤性能提升、数据存储与效率改进以及数据转换的扩展与集成等环节,本文旨在提供一套全面的ETL优化框架。强调了多源数据合并、实时数据采集、数据清洗规则定制、性能监控、并行处理、缓存与批处理优化等技术的应用。此外,本文还探讨了在大数据环境下存储挑战和扩展性设计原则,并结合实际案例深入分析了优化策略的应用。文章最后展望了ETL未来发展趋势及新兴技术的可能影响,提供了数据处理领域的行业见解。

# 关键字

HiGale数据流;ETL优化;数据清洗;并行处理;缓存批处理;系统扩展性;大数据存储

参考资源链接:[HiGale实时仿真机技术手册](https://wenku.csdn.net/doc/20ztfjytu0?spm=1055.2635.3001.10343)

# 1. HiGale数据流ETL优化概述

随着大数据技术的迅猛发展,企业对数据处理的效率和质量有了更高的要求。ETL(提取、转换和加载)过程作为数据仓库建设的核心,对于数据流的处理尤为关键。HiGale作为一站式大数据处理平台,其数据流ETL优化不仅需要关注传统的数据处理效率,还要适应实时性、海量性和多样性带来的挑战。本章节将从数据流ETL优化的整体视角出发,概览优化目标和挑战,并介绍后续章节中针对数据采集、转换、存储等关键步骤的优化策略与技术细节。

接下来的章节将逐步深入,首先从数据源接入、数据清洗预处理以及数据质量保证等方面探讨数据采集与清洗策略,然后分析如何在转换步骤中提升性能,以及如何在数据存储环节进一步提高效率,最后探讨数据转换的扩展性和集成问题,并通过案例分析展望未来的发展方向。

# 2. 数据采集与清洗策略

数据作为ETL(提取、转换、加载)过程的起点,其质量直接影响整个数据流的效率和最终的数据分析结果。因此,有效的数据采集与清洗策略是确保数据质量和流程顺畅的关键。本章将深入探讨数据源接入优化、数据清洗和预处理以及数据质量保证方法,旨在为读者提供一个全面的数据采集与清洗策略框架。

## 2.1 数据源接入优化

数据源接入是数据采集的第一步,它决定了数据采集的广度和速度。在当今多元化的数据环境中,如何高效地接入多种数据源,并保证实时性,是企业数据管理面临的重大挑战。

### 2.1.1 多源数据合并技术

随着企业内部系统多样化,来自不同源的数据往往需要在采集阶段进行合并。多源数据合并技术能够将结构化、半结构化和非结构化的数据源整合到一个统一的视图中,这对于后续的数据清洗和分析至关重要。

#### 代码块示例

```python

# 示例:使用Python中的pandas库进行多源数据合并

import pandas as pd

# 假设我们有两个数据源,一个是CSV文件,另一个是Excel表格

dataframe_csv = pd.read_csv('data_source_1.csv')

dataframe_excel = pd.read_excel('data_source_2.xlsx')

# 使用pandas的merge函数进行数据合并

merged_dataframe = pd.merge(dataframe_csv, dataframe_excel, on='common_column')

# 保存合并后的数据到新的CSV文件

merged_dataframe.to_csv('merged_data.csv', index=False)

```

#### 参数说明与执行逻辑

上述代码块中,我们首先导入了pandas库,接着读取了两个数据源文件(一个CSV和一个Excel),并使用`pd.merge()`函数根据公共列(`common_column`)将它们合并。最后,合并后的数据被保存为一个新的CSV文件。这个过程涉及到了数据类型统一、公共键值对识别等关键合并技术要点。

### 2.1.2 实时数据采集机制

对于需要实时处理的数据流,实时数据采集机制是必不可少的。这通常依赖于消息队列(如Kafka)和流处理框架(如Apache Flink)来实现高效的数据传输和处理。

#### 流程图示例

```mermaid

graph LR

A[数据源] -->|消息| B(Kafka集群)

B -->|实时消费| C[数据处理节点]

C -->|流输出| D[数据接收系统]

```

#### 技术解释

流程图展示了实时数据采集的基本架构。数据源首先将数据以消息的形式发送至消息队列Kafka集群,数据处理节点实时消费这些消息,并进行相应的处理,最后流输出至数据接收系统。

## 2.2 数据清洗和预处理

数据清洗和预处理是ETL过程中最为关键的步骤之一。高质量的清洗和预处理不仅能够提高数据的准确性,还能显著提升数据处理的效率。

### 2.2.1 清洗规则的应用与定制

在数据清洗过程中,根据业务需求定制清洗规则是至关重要的。这些规则通常包括去除无效数据、纠正错误、填充缺失值、转换数据格式等。

#### 表格示例

| 清洗规则类型 | 描述 | 应用示例 |

|------------|--------------------------------------|--------------------------|

| 数据去重 | 去除重复的记录 | 删除数据库中的重复用户信息 |

| 缺失值处理 | 填充或删除缺失的值 | 用平均值填充缺失的销售额数据 |

| 异常值处理 | 识别并处理数据集中的异常值 | 过滤掉超出平均销量2个标准差的记录 |

| 格式统一 | 确保数据格式一致性 | 将日期格式统一为YYYY-MM-DD |

| 数据类型转换 | 将数据转换为正确的类型 | 字符串类型转换为数值类型 |

#### 代码块示例

```python

import numpy as np

import pandas as pd

# 创建一个包含缺失值、异常值的DataFrame示例

data = {'Date': ['2023-01-01', '2023-01-02', np.nan, '2023-01-04'],

'Sales': [100, 200, -10, 300]}

df = pd.DataFrame(data)

# 应用清洗规则

df['Date'] = pd.to_datetime(df['Date'], errors='coerce') # 将日期转换为标准日期格式

df['Sales'] = df['Sales'].clip(lower=0) # 处理负值异常数据

# 删除缺失值

df.dropna(subset=['Date'], inplace=True)

# 输出清洗后的数据

print(df)

```

### 2.2.2 数据去重和格式统一

数据去重是确保数据准确性的常见步骤,而格式统一则保证了不同数据源之间的数据兼容性和一致性。

#### 代码块示例

```python

# 继续使用上面的DataFrame示例

# 删除重复数据

df = df.drop_duplicates()

# 输出去重后的数据

print(df)

```

#### 参数说明与执行逻辑

在该代码块中,我们使用`drop_duplicates()`函数去除了DataFrame中的重复数据行。这个步骤是数据清洗中的常规操作,有助于提升数据的唯一性和准确性。

## 2.3 数据质量保证方法

确保数据质量是数据采集与清洗策略的终极目标。高质量的数据可以减少数据处理过程中的错误,并提高数据决策的准确性。

### 2.3.1 质量监控指标

为了保证数据质量,需要定义和监控一系列关键质量指标。这些指标包括完整性、一致性、准确性、时效性和唯一性。

### 2.3.2 异常数据的识别与处理

异常数据的识别和处理是数据质量保证的重要组成部分。通过建立规则和模型来检测和处理异常数据,可以避免在数据流的后续处理中产生误导性的分析结果。

以上就是第二章“数据采集与清洗策略”的全部内容。在下一章节中,我们将深入探讨在数据转换步骤中的性能提升策略,敬请期待。

# 3. 转换步骤中的性能提升

随着数据量的日益增长,数据转换步骤的性能优化成为提升整个ETL流程效率的关键。在这一章节中,我们将深入探讨转换步骤中的性能提升策略,包括转换脚本的优化、数据流的并行处理以及

0

0