揭秘YOLOv8图像分类模型可解释性:了解模型决策过程,让你掌控模型

发布时间: 2024-08-18 20:45:49 阅读量: 215 订阅数: 70

YOLOv8模型参数调整指南:定制化视觉任务的秘诀

# 1. YOLOv8图像分类模型简介

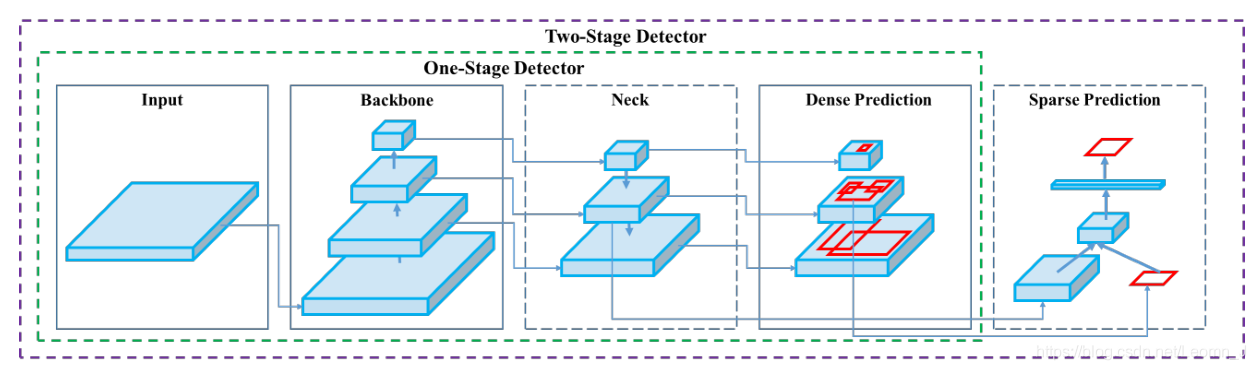

YOLOv8是计算机视觉领域中一款先进的图像分类模型,以其速度快、精度高而闻名。它采用深度学习技术,通过对大量图像数据的训练,可以识别和分类各种物体。YOLOv8的架构基于卷积神经网络(CNN),它包含多个卷积层、池化层和全连接层,这些层共同提取图像特征并进行分类决策。

# 2. YOLOv8模型的可解释性

### 2.1 可解释性的概念和重要性

**可解释性**是指理解机器学习模型决策过程的能力。对于图像分类模型,可解释性至关重要,因为它可以帮助我们了解模型如何做出预测,并提高对模型可靠性的信心。

### 2.2 YOLOv8模型的可解释性方法

YOLOv8模型的可解释性方法主要分为两类:

- **后验可解释性方法:**在模型训练后应用,通过分析模型输出来解释其决策。

- **先验可解释性方法:**在模型训练过程中应用,通过修改模型结构或训练过程来增强其可解释性。

#### 2.2.1 后验可解释性方法

**2.2.1.1 热力图**

heatmap 是一个可视化工具,用于显示模型对图像中每个像素的预测置信度。它可以帮助我们识别模型关注的区域,并了解其做出决策的依据。

**代码块:**

```python

import cv2

import numpy as np

# 加载模型

model = cv2.dnn.readNetFromDarknet("yolov8.cfg", "yolov8.weights")

# 加载图像

image = cv2.imread("image.jpg")

# 预处理图像

blob = cv2.dnn.blobFromImage(image, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

# 输入图像

model.setInput(blob)

# 前向传播

detections = model.forward()

# 生成热力图

heatmap = np.zeros((image.shape[0], image.shape[1], 3))

for detection in detections:

heatmap[int(detection[0][1]):int(detection[0][3]), int(detection[0][0]):int(detection[0][2])] += detection[1]

# 显示热力图

cv2.imshow("Heatmap", heatmap)

cv2.waitKey(0)

```

**逻辑分析:**

* `cv2.dnn.readNetFromDarknet` 函数加载 YOLOv8 模型。

* `cv2.dnn.blobFromImage` 函数将图像预处理为模型输入。

* `model.setInput` 函数将预处理后的图像输入模型。

* `model.forward` 函数执行前向传播,得到检测结果。

* 循环遍历检测结果,并根据检测框的坐标更新热力图。

* 最后,显示热力图,展示模型对图像中每个像素的置信度。

**2.2.1.2 梯度凸显**

梯度凸显是一种技术,用于可视化模型对输入图像的敏感性。它可以帮助我们识别图像中影响模型决策的关键区域。

**代码块:**

```python

import torch

from torchvision.models import resnet18

# 加载模型

model = resnet18(pretrained=True)

# 加载图像

image = torch.rand(1, 3, 224, 224)

# 计算梯度

model.zero_grad()

output = model(image)

output.backward()

# 生成梯度凸显图

gradient_cam = torch.abs(image.grad).mean(dim=(1, 2))

gradient_cam = cv2.resize(gradient_cam.numpy(), (image.shape[2], image.shape[3]))

# 显示梯度凸显图

cv2.imshow("Gradient CAM", gradient_cam)

cv2.waitKey(0)

```

**逻辑分析:**

* `resnet18` 函数加载 ResNet-18 模型。

* `torch.rand` 函数生成一个随机图像作为输入。

* `model.zero_grad` 函数将模型的梯度清零。

* `model(image)` 函数执行前向传播,得到模型输出。

* `output.backward` 函数计算模型输出相对于输入图像的梯度。

* `torch.abs(image.grad).mean(dim=(1, 2))` 函数计算梯度的绝对值,并对图像的通道和高度、宽度求平均。

* `cv2.resize` 函数将梯度凸显图调整为与输入图像相同的大小。

* 最后,显示梯度凸显图,展示图像中影响模型决策的关键区域。

#### 2.2.2 先验可解释性方法

**2.2.2.1 可解释性层**

可解释性层是一种神经网络层,专门设计用于提高模型的可解释性。它们可以捕获模型决策的中间表示,并提供对模型内部工作原理的见解。

**代码块:**

```python

import torch

from torch.nn import Module, Linear, Conv2d, ReLU, MaxPool2d

# 定义可解释性层

clas

```

0

0