内存管理揭秘:掌握Python从垃圾回收到避免内存泄漏的全技巧

发布时间: 2024-12-25 14:23:02 阅读量: 9 订阅数: 6

白色大气风格的商务团队公司模板下载.zip

# 摘要

本文系统探讨了Python内存管理的基本概念,详细解析了内存分配原理和垃圾回收机制。通过对引用计数机制、分代和循环垃圾回收的优缺点分析,以及内存泄漏的识别、分析和解决策略,提出了提高内存使用效率和防止内存泄漏的实践方法。此外,本文还介绍了编写高效代码的最佳实践,包括数据结构优化、缓存技术、对象池设计模式以及使用内存分析工具的策略。最后,展望了Python内存管理技术的未来发展趋势,指明了性能改进和内存优化的方向,推荐了相关的开源项目和学习资源。

# 关键字

内存管理;Python;垃圾回收;内存泄漏;性能优化;数据结构

参考资源链接:[Python面试必备:八股文与实战解析](https://wenku.csdn.net/doc/6iej6purpe?spm=1055.2635.3001.10343)

# 1. 内存管理的基本概念

在现代计算环境中,内存管理是一个至关重要的过程,它涉及有效地分配、使用和释放计算机内存资源。内存管理不仅确保每个运行的程序都能得到所需的内存空间,而且还要确保系统的整体性能不受过多内存碎片的影响。在本章中,我们将探讨内存管理的基本概念,为理解后续章节关于Python内存管理的更深层次内容奠定基础。

内存管理的主要任务可以概括为以下几个方面:

1. **内存分配**:为程序中的数据和代码分配足够的内存空间,确保程序运行流畅。

2. **内存回收**:当数据不再被使用时,释放内存空间以便系统可以重新分配。

3. **内存优化**:通过各种策略减少内存碎片,提高内存利用率,减少内存泄漏。

内存管理的效率直接影响程序的性能,特别是在内存需求较高的应用中更是如此。接下来的章节,我们将深入探讨Python环境下的内存管理机制,包括其内存分配原理、垃圾回收机制以及如何识别和分析内存泄漏等问题。通过这些内容的学习,我们能够更好地管理内存资源,编写出性能更优的Python应用。

# 2. Python内存分配原理

### 2.1 Python对象的内存表示

Python是一门高级编程语言,为了给开发者提供快速和便利的开发体验,Python隐藏了底层内存管理的复杂性。在Python中,每一个值都是一个对象,包括基本的数据类型,如整数、浮点数、字符串等。为了理解Python如何管理内存,首先我们需要了解Python对象的内存表示。

Python中的对象,或称Python对象,由其类型和值组成。每个对象都包含以下几个主要部分:

- **引用计数器(Reference Counting)**: 记录有多少引用指向该对象,当引用计数器为零时,对象将被垃圾回收。

- **类型标识(Type Identification)**: 表明对象是什么类型,例如是整数、列表还是字典等。

- **值(Value)**: 表示对象的数据,可以是整数的值、字典的键值对等。

Python通过一个内部的“对象分配器”(Allocator)管理对象的创建和销毁。这个分配器决定如何从底层操作系统中申请内存,以及如何将这些内存分配给特定的对象。在Python的实现中(如CPython),对象的内存分配通常是通过`malloc`等底层函数直接向操作系统的堆(Heap)申请的。

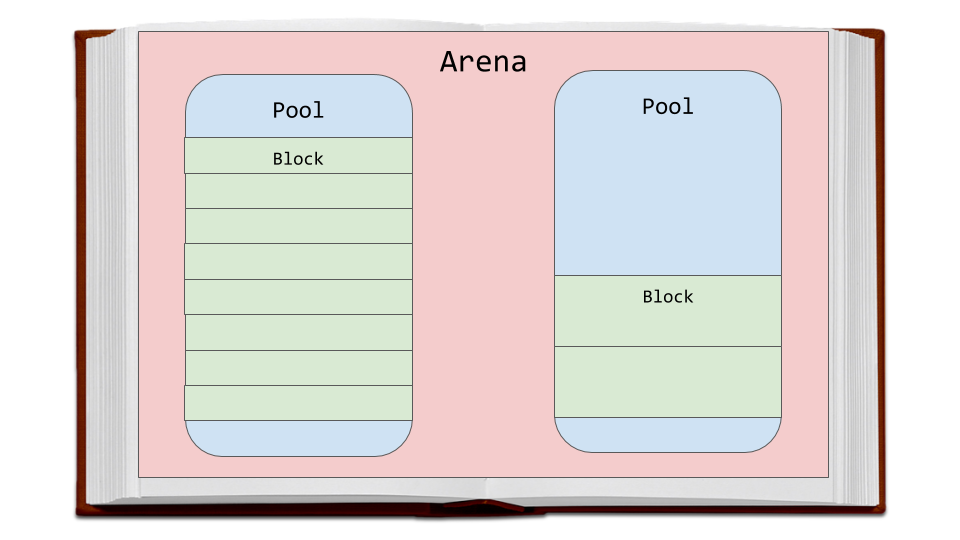

### 2.2 对象内存分配策略

在Python中,对象的内存分配策略依赖于Python的实现。CPython作为官方的Python解释器,采用的策略包括预先分配和延迟分配。预先分配策略是指解释器在启动时分配一块较大的内存块,用于后续的对象分配,这可以减少频繁的系统调用。延迟分配则是当需要为新的对象分配内存时,再进行内存的分配。

这种策略为Python带来一定的性能优势,但也意味着Python对象的内存分配并不是完全透明的。开发者应该意识到内存的使用和管理实际上对程序的性能有较大影响,特别是在涉及大量小对象的场景下。

### 代码块分析示例

```python

# 创建一个简单的Python对象

obj = 'Hello World'

```

上述代码创建了一个字符串对象`obj`,尽管在代码层面上看似简单,但其背后的内存操作却相当复杂。首先,Python解释器会计算字符串`'Hello World'`的字节大小,然后根据该大小从堆上分配一块内存。分配完成后,解释器会填充这块内存,设置字符串的类型和值。如果之前的内存中没有这个字符串对象的引用,Python的垃圾回收机制可能会将这块内存标记为可回收。此外,如果字符串对象的内容未发生变化,Python的内部机制(如小对象的短字符串优化)可能会复用内存中的对象,以优化性能。

```python

# 创建一个大的整数对象

big_number = 10**1000

```

创建大整数对象涉及到更复杂的内存和性能考虑。Python必须分配足够的内存来表示这个大数,并进行相应的数学运算。由于大整数对象不常出现,Python通常不会为它们复用内存。此外,大整数的计算涉及到更复杂的数学运算和可能的内存分配,因此速度会比操作小整数慢很多。

### 内存分配策略的影响

Python的内存分配策略对开发者编写高效代码有着深远的影响。例如,开发者应该尽量避免创建大量小对象,因为这会导致频繁的内存分配和释放,从而影响程序的性能。在涉及大量数据的处理时,例如数据科学、机器学习等任务,使用向量化的操作和NumPy等库能够显著提高内存效率和计算速度。

在后续章节中,我们将深入探讨Python的垃圾回收机制,了解它是如何与内存分配协同工作的,并且给出一些内存优化的最佳实践。

# 3. 垃圾回收机制详解

## 3.1 引用计数机制

### 3.1.1 引用计数的工作原理

引用计数是一种简单的垃圾回收机制,它通过跟踪记录每个对象被引用的次数来工作。每当一个对象被创建时,它的引用计数就会被初始化为1。之后,每当有新的引用指向这个对象时,引用计数就会增加。相对地,如果一个引用被移除或者一个引用指向另一个对象时,对象的引用计数就会减少。当一个对象的引用计数降到0时,意味着没有任何引用指向这个对象,它就成为了垃圾回收的候选对象。

引用计数的一个关键特征是它几乎实时地回收了不再使用的对象,因为对象一旦变成不可达,它们的引用计数就会迅速下降至0。这种方法的优点是能够快速回收垃圾对象,但缺点是存在循环引用问题,以及维护引用计数带来的性能开销。

```python

import sys

# 创建一个对象,引用计数为1

obj = {}

# 另一个变量也引用该对象,引用计数增加

another_obj = obj

# 当前obj和another_obj都引用了该对象,引用计数为2

print(sys.getrefcount(obj)) # 输出引用计数

# 删除一个引用

del another_obj

# 现在只有obj引用该对象,引用计数为1

print(sys.getrefcount(obj)) # 输出引用计数

```

### 3.1.2 引用计数的优缺点分析

引用计数的主要优点是其简单和高效。它能够在对象变为垃圾时立即回收,从而保持内存使用高效。对于那些需要即时释放资源的应用来说,引用计数特别有用。此外,引用计数还能够帮助检测和处理程序中的循环引用问题,因为它能精确地追踪每个对象的引用。

然而,引用计数也有其缺点。首先,维护引用计数需要额外的资源和时间,这在性能上可能是一个负担,特别是对于那些大量创建和销毁对象的应用。其次,引用计数不能处理循环引用的情况,也就是当两个或多个对象互相引用,而没有任何其他引用指向它们时。这种情况下的对象不会被视为垃圾,即使程序实际上已经无法访问到它们,这就导致了内存泄漏。

在Python中,引用计数是通过`sys.getrefcount()`函数进行测试的。它提供了一个对象当前的引用计数,包括传入函数时的隐式引用。但需要注意的是,返回值总是比实际的引用计数多1,因为函数调用本身会创建一个临时的引用。

## 3.2 分代垃圾回收

### 3.2.1 分代假设理论基础

分代垃圾回收基于一个观察到的现象,即大多数创建的对象都很快会变得不再可达(即被废弃)。这个现象被称为弱代假设(weak generational hypothesis),它是现代垃圾回收机制设计的重要基础之一。根据这个假设,垃圾回收器将对象分为不同的代(generation),通常分为三代:年轻代、中年代和老年代。

年轻代通常包含最新创建的对象,它们很快就可能变得不可达。因此,年轻代的垃圾回收更为频繁,回收算法通常是较为轻量级的。相对地,老年代包含的对象是在多次垃圾回收后仍然存活的对象,因此老年代的垃圾回收较少,且使用更复杂的算法来处理。

分代垃圾回收利用了对象存活时间的分布特征,通过区分不同代别的对象,减少了每次回收需要检查的对象数量,从而提高了垃圾回收的效率。

### 3.2.2 分代收集的实现细节

在Python中,分代垃圾回收是通过名为“标记-清除”(Mark-Sweep)和“分代收集”(Generational Collection)的算法实现的。标记-清除算法主要负责跟踪和回收那些不可达的对象。它通过标记所有可达对象,并清除那些未被标记的对象,来实现垃圾回收。而分代收集则将对象分为不同的代,并根据代来调整垃圾回收的频率和方法。

Python的垃圾回收器在对象创建时并不立即进行垃圾回收,而是在对象的引用计数变为0后,再进行标记-清除。如果对象在经过几次垃圾回收后仍然存活,那么它会被提升到老年代。而年轻代中的对象如果在某次回收中存活,也会被提升到更高的代中。这种逐步提升对象到老年代的过程称为对象老化(object aging)。

在Python的实现中,还有一个特殊的阈值系统来决定何时进行垃圾回收。阈值会根据代的级别来设置,越老的代对应更大的阈值。通过这种方式,分代垃圾回收器能够在保证效率的同时,也保持了内存使用的紧凑性。

## 3.3 循环垃圾回收

### 3.3.1 循环引用的概念与问题

循环引用是指在程序中两个或多个对象互相引用,形成闭环的情况。由于引用计数机制无法检测出循环引用,因此这些对象即使在程序中已经不可达,它们的引用计数也不会降到0,导致它们无法被垃圾回收器回收。这种情况下,即使程序不再使用这些对象,它们也会占用内存资源,造成内存泄漏。

一个典型的循环引用场景是在图、树等数据结构中,对象之间相互引用,或者在编写回调函数和事件处理程序时,由于闭包或内部函数引用了外部变量,形成了不易察觉的循环引用。

```python

a = []

b = [a]

a.append(b)

# 现在a和b相互引用形成循环引用

# 即使没有任何外部引用指向a或b,它们也不会被回收

```

### 3.3.2 解决循环引用的策略与实践

为了解决循环引用的问题,Python引入了一种称为循环垃圾回收(Cyclic Garbage Collection)的机制。这个机制通过一种称为引用链(reference chain)的跟踪算法,能够检测并打破循环引用。循环垃圾回收器定期运行,它会在标记阶段收集所有的引用对象,然后构建一个图结构,来分析哪些对象是可达的,哪些是由于循环引用而孤立的。

当检测到循环引用时,Python垃圾回收器会断开引用链,使原本相互引用的两个对象中的一个或多个的引用计数降为0,从而允许这些对象被正常回收。但需要注意的是,由于检测循环引用本身也有性能开销,循环垃圾回收器并不会频繁运行,因此循环引用仍然可能导致临时的内存泄漏。

在实际应用中,避免循环引用的最好方式是确保数据结构的设计合理,并在代码中显式地管理对象的生命周期。例如,使用弱引用(weakref)来代替强引用,可以创建对对象的引用而不会增加其引用计数,从而避免形成循环引用。

```python

import weakref

a = []

b = weakref.ref(a)

# b现在持有对a的弱引用,不会增加a的引用计数

```

在使用集合(如列表、字典)时,也可以通过删除集合内的引用,来帮助垃圾回收器回收那些不再需要的对象,从而避免循环引用。

总结来看,Python的垃圾回收机制融合了引用计数和分代收集技术,以及特别的循环垃圾回收算法,来维护内存的高效和稳定。尽管存在一些限制,通过理解这些机制,开发者可以更好地编写内存安全的代码。下一章我们将探讨内存泄漏的识别与分析,包括如何使用工具来诊断和解决内存泄漏问题。

# 4. 内存泄漏的识别与分析

## 4.1 内存泄漏的定义和原因

### 4.1.1 内存泄漏的定义及常见场景

内存泄漏是指程序在申请内存后,未能在不再需要时释放,导致随着时间推移,无用的内存逐渐累积,系统可用内存不断减少的现象。在长期运行的应用中,内存泄漏可能会导致性能下降,甚至程序崩溃。

内存泄漏在软件开发中是一个常见的问题,尤其在长时间运行的应用中更为突出。常见的内存泄漏场景包括:

- 循环引用:在复杂的数据结构中,如图和树,多个对象相互引用,形成了一个无法被垃圾回收机制回收的环。

- 长生命周期对象持有临时对象:长生命周期的对象如全局变量或者单例对象持有临时对象的引用,导致临时对象无法被回收。

- 第三方库或组件的内存问题:开发者往往无法控制第三方库的实现细节,这些库可能隐藏着内存泄漏问题。

### 4.1.2 导致内存泄漏的Python特性分析

在Python中,内存泄漏可能由以下几个特性导致:

- 动态类型系统:Python是动态类型语言,这意味着在运行时才确定变量的类型和内存分配,使得一些潜在的内存问题难以察觉。

- 引用计数机制:虽然引用计数是一种有效的内存管理机制,但它依赖于对象引用的准确计数。当对象之间形成循环引用时,就可能导致泄漏。

- C扩展:Python允许开发者使用C语言编写扩展,而C语言中的内存管理需要开发者自己控制,不当的内存操作可以导致泄漏。

## 4.2 内存泄漏的检测工具和方法

### 4.2.1 使用memory_profiler分析内存使用

`memory_profiler`是Python的一个扩展模块,它可以帮助开发者监控程序运行时的内存使用情况。通过它可以识别程序中内存使用的峰值和异常,从而定位内存泄漏的位置。

安装memory_profiler:

```bash

pip install memory_profiler

```

使用memory_profiler分析脚本的示例:

```python

from memory_profiler import memory_usage

def test_func():

a = [1] * (10 ** 6)

b = [2] * (2 * 10 ** 7)

del b

return a

if __name__ == '__main__':

mem_usage = memory_usage((test_func, ()))

print(mem_usage)

```

通过分析函数`test_func`在执行前后的内存变化,我们可以得到其内存使用情况的列表。

### 4.2.2 通过gc模块检测和诊断内存泄漏

Python的垃圾回收模块(gc模块)提供了丰富的接口来检测和诊断内存泄漏。`gc`模块可以报告当前的垃圾回收器统计信息,包括不可达对象的数量等。

使用gc模块检测循环引用的示例代码:

```python

import gc

def create_circular_reference():

a = []

b = [a]

a.append(b)

create_circular_reference()

print('Number of unreachable objects:', gc.garbage)

```

`gc.garbage`会列出所有被回收的不可达对象,这些对象可能就是循环引用导致的内存泄漏源。

## 4.3 内存泄漏的案例剖析

### 4.3.1 典型内存泄漏案例分析

假设有一个简单的Web应用,使用Flask框架。在长时间运行中,开发者注意到可用内存逐渐减少,怀疑存在内存泄漏。通过`memory_profiler`的分析,我们定位到了内存消耗的异常增长点:

```bash

$ python -m memory_profiler example_app.py

```

发现`database_session`函数每次调用后内存都会增加,进一步检查代码,发现数据库会话没有被正确关闭。

### 4.3.2 案例解决策略和预防措施

解决上述内存泄漏问题的策略是确保每次请求结束后,数据库会话能够被正确关闭。可以在Flask的请求钩子中添加关闭会话的逻辑:

```python

from flask import request, g, session

@app.teardown_appcontext

def shutdown_session(exception=None):

db.session.remove()

```

为了预防未来的内存泄漏,可以采取以下措施:

- 定期使用内存分析工具监控应用程序的内存使用情况。

- 开发过程中使用`gc.set_debug(gc.DEBUG_LEAK)`来帮助检测循环引用。

- 尽可能使用上下文管理器(例如`with`语句)来管理资源的获取和释放。

- 在代码审查时,特别注意对象的生命周期和相互之间的引用关系。

通过以上方法,我们不仅解决了当前的内存泄漏问题,还为预防未来的内存问题打下了基础。

# 5. 内存管理最佳实践

## 5.1 编写高效代码减少内存占用

在开发过程中,编写高效且内存占用少的代码是一个重要的实践。这不仅能够提升程序的性能,还能减少因内存不足而导致的应用崩溃问题。

### 5.1.1 数据结构的选择与优化

选择合适的数据结构对于程序性能和内存使用有直接的影响。例如,使用列表(list)时,如果需要频繁地插入或删除元素,那么使用`deque`(双端队列)可能更为合适,因为`deque`提供了平均常数时间复杂度的插入和删除操作。

在处理大量数据时,使用集合(set)和字典(dict)通常比列表(list)更加高效,因为它们提供了快速的查找能力,并且内部实现了哈希表,大大减少了搜索时间。

例子代码如下:

```python

import time

# 使用列表查找

def find_in_list(lst, value):

for item in lst:

if item == value:

return True

return False

# 使用字典查找

def find_in_dict(dct, value):

return value in dct

# 测试性能

big_list = list(range(1000000))

big_dict = {key: key for key in range(1000000)}

start_time = time.time()

print(find_in_list(big_list, 999999))

print("List search time:", time.time() - start_time)

start_time = time.time()

print(find_in_dict(big_dict, 999999))

print("Dictionary search time:", time.time() - start_time)

```

在这个例子中,字典的查找速度会比列表快很多,因为字典内部实现了哈希表来快速定位元素。

### 5.1.2 优化循环和递归以减少内存压力

循环和递归是编写高效代码时常用的两种控制结构。在处理大量数据时,优化循环和递归可以显著降低内存的使用。

- **循环优化**: 应避免在循环中创建临时对象,尤其是在循环体内部。此外,应使用生成器表达式代替列表推导式,从而减少内存占用。

- **递归优化**: 对于递归,应使用尾递归优化或者迭代来替代。在Python中,默认情况下不支持尾递归优化,因此需要手动实现循环逻辑来避免栈溢出和过多的内存占用。

例如,对于递归函数,我们可以将其转换为迭代形式:

```python

# 递归计算阶乘

def factorial_recursive(n):

if n == 0:

return 1

else:

return n * factorial_recursive(n-1)

# 迭代计算阶乘

def factorial_iterative(n):

result = 1

for i in range(1, n+1):

result *= i

return result

print("Recursive factorial of 5:", factorial_recursive(5))

print("Iterative factorial of 5:", factorial_iterative(5))

```

迭代版本的阶乘函数更适合处理大数据量,因为它不会像递归版本那样大量占用调用栈空间。

## 5.2 利用缓存和对象池技术

### 5.2.1 缓存机制及其应用场景

缓存是一种存储临时数据的技术,目的是减少对后端系统(如数据库或远程服务)的访问次数,提高访问速度。在Python中,可以使用`functools.lru_cache`装饰器来实现简单的函数调用缓存。

例子代码如下:

```python

from functools import lru_cache

@lru_cache(maxsize=100)

def compute_heavy_function(arg):

# 模拟计算开销大的函数

return arg * 2

# 第一次调用会进行实际计算

print(compute_heavy_function(10))

# 后续相同参数的调用会使用缓存

print(compute_heavy_function(10))

# 清除缓存

compute_heavy_function.cache_clear()

```

在这个例子中,函数`compute_heavy_function`被调用多次时,第一次的计算结果被缓存,后续相同参数的调用直接返回缓存结果,从而节省资源。

### 5.2.2 对象池设计模式及其优势

对象池是一种创建对象的缓存池,用于管理对象的生命周期。当需要一个新对象时,它会先检查池中是否有可用对象,如果有就复用,否则再创建新对象。这种方式可以减少频繁创建和销毁对象所消耗的资源,特别是在对象创建成本很高时。

对象池在数据库连接池、网络连接池等场景下尤为有用,因为这些操作的开销相对较大。

例如,我们可以创建一个简单的数据库连接池:

```python

import threading

from queue import Queue

class ConnectionPool:

def __init__(self, max_size):

self.max_size = max_size

self.pool = Queue(maxsize=max_size)

self.lock = threading.Lock()

def checkout(self):

return self.pool.get()

def checkin(self, connection):

if self.pool.full():

self.pool.put_nowait(connection)

else:

raise ValueError('Pool cannot exceed max size')

def create_connection(self):

# 模拟数据库连接创建

return 'Connection'

pool = ConnectionPool(5)

# 模拟获取连接

with pool.lock:

connection = pool.checkout()

if not connection:

connection = pool.create_connection()

# 模拟使用完毕后归还连接

pool.checkin(connection)

```

在这个例子中,`ConnectionPool`类管理着一个连接池,确保最多不会超过设定的`max_size`数量的数据库连接。这有助于减少每次获取和释放数据库连接时的开销。

## 5.3 使用内存分析工具进行优化

### 5.3.1 介绍常用的内存分析工具

在Python中,有几种内存分析工具可以帮助开发者识别和优化内存使用。比较著名的有`memory_profiler`和`objgraph`等。

- **memory_profiler**: 这是一个Python扩展,它提供了装饰器和命令行工具来监控和报告程序的内存使用情况。

- **objgraph**: 这个库允许我们可视化对象之间的关系,并且可以进行更深入的对象数量统计。

通过这些工具,我们可以发现内存泄漏和过度使用的对象,从而对程序进行优化。

### 5.3.2 实际应用内存分析工具优化程序

为了演示如何使用内存分析工具,以下是使用`memory_profiler`来分析一个简单程序内存使用情况的例子。

首先,安装`memory_profiler`库:

```shell

pip install memory_profiler

```

然后,我们可以使用以下代码来分析函数的内存使用情况:

```python

from memory_profiler import memory_usage

@profile

def my_func():

my_list = []

for i in range(100000):

my_list.append(i)

if __name__ == '__main__':

memory_usage((my_func, ()), interval=0.1)

```

执行上述程序后,`memory_usage`函数会报告每个时间点的内存使用量,帮助我们理解`my_func`函数在运行时的内存消耗情况。

通过以上章节的介绍,我们可以看到内存管理不仅涉及到理论知识,更重要的是通过实际的工具和策略应用到具体的开发实践中去。在下一章节中,我们将探讨Python内存管理技术的未来展望,包括即将出现的新技术和开源项目。

# 6. Python内存管理未来展望

随着计算机科学的不断进步和Python语言的广泛应用,内存管理技术也在不断演进。Python社区对性能优化和内存使用的关注正在推动着内存管理技术的发展,这不仅影响到Python语言本身,也为开发者提供了更多的工具和资源来编写高效的程序。接下来将详细探讨Python内存管理技术的演进和相关开源项目及资源的推荐。

## 6.1 Python内存管理技术的演进

Python版本更新带来了内存管理技术上的不少改进。在这些更新中,优化内存使用的特性尤为重要,因为它们直接影响到Python程序的性能。

### 6.1.1 新版本Python中的内存管理特性

Python的最新版本中包含了许多对内存管理的改进。例如,Python 3.6引入了“字典合并”操作,允许开发者合并两个字典,而不需要创建一个新的字典实例,这减少了内存分配的操作。Python 3.7进一步引入了“字典顺序保留”的特性,这有助于提高内存的利用效率。

### 6.1.2 性能改进和内存优化的方向

性能改进通常涉及到对解释器底层实现的优化。在内存优化方面,Python社区正致力于减少内存碎片、提升垃圾回收效率、优化数据结构等。这包括使用更加精细化的内存分配策略和改进引用计数机制。

## 6.2 相关开源项目和资源推荐

Python社区中的开源项目和资源为内存管理提供了丰富的工具和知识库,使开发者能更深入地了解和优化内存使用。

### 6.2.1 推荐关注的Python内存管理项目

- **PyPy**: PyPy是一个Python解释器,它使用即时编译技术来提高性能。PyPy还包含了一个自动的内存管理器,这个内存管理器对内存使用进行了优化。

- **PSF Garbage Collection**: Python官方社区提供了关于垃圾回收的研究项目,旨在改善Python的垃圾回收机制,提高资源的利用效率。

### 6.2.2 学习资源和社区分享平台

- **Python Wiki**: Python的官方Wiki包含了关于内存管理的深入讨论和相关资料,是学习和了解最新进展的好去处。

- **Reddit社区**: 特别是r/Python和r/learnpython等子版块,经常有开发者分享关于内存管理的经验和技巧。

- **PyCon和EuroPython会议**: 这些会议提供了关于Python内存管理的演讲和工作坊,是了解当前最佳实践和最新研究的好地方。

通过关注这些项目和资源,开发者不仅能够保持对内存管理技术发展动态的了解,还能不断学习和实践,提高自己编写高效程序的能力。

Python内存管理技术的未来充满了无限可能。通过不断地优化和创新,我们可以期待Python会变得更加高效和强大,更好地服务于各种应用场景。随着相关技术的发展,相信Python在未来的编程语言舞台上依然能够保持其重要的地位。

0

0