Maxwell架构深度剖析:分布式数据同步的6大挑战与对策

摘要

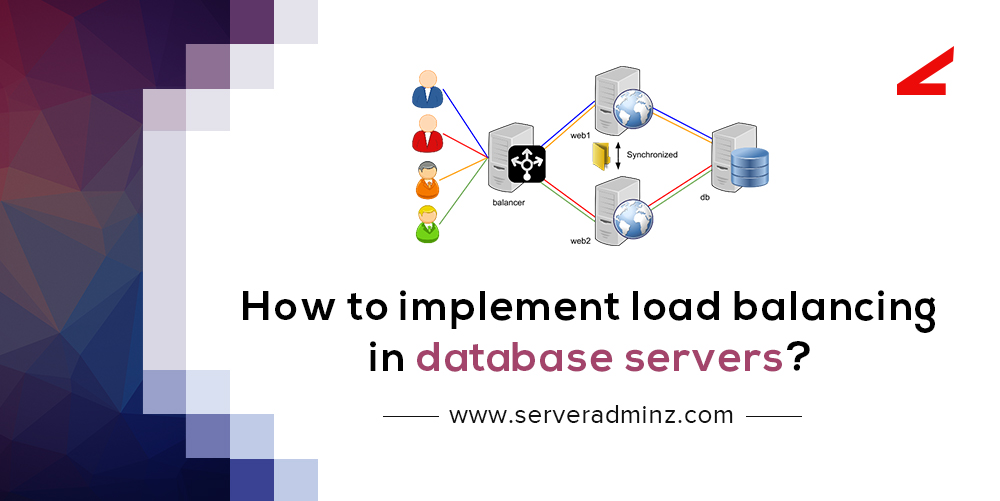

分布式数据同步是构建可靠和高效分布式系统的核心技术之一。本文全面探讨了分布式数据同步的基本概念、面临的挑战以及解决策略。文中详细分析了数据一致性问题、网络延迟、分区容错、负载均衡和故障转移等关键挑战,并介绍了乐观并发控制、读写分离、数据分片与路由策略等同步策略。进一步,本文深入讨论了分布式事务处理、时间戳与向量时钟等高级技术,并通过案例分析展示了Maxwell架构在生产环境中的应用。最后,本文对未来云原生环境下数据同步的挑战进行了展望,提出了相关技术趋势和建议。

关键字

分布式数据同步;数据一致性;网络延迟;负载均衡;故障转移;乐观并发控制;读写分离;数据分片;向量时钟;分布式事务处理;监控与诊断

参考资源链接:Maxwell静电场教程:实战构建平板电容器电容仿真

1. 分布式数据同步的基本概念

分布式数据同步是指在分布式计算环境中,确保不同节点间数据的实时或近实时一致性的一系列技术与策略。在一个分布式系统中,数据可能存储在多个服务器上,这些服务器可能分布在世界各地。因此,当一个数据项在系统的一个节点上被修改时,需要将这一变更同步到其他所有节点上,以保持数据的一致性和整体的逻辑一致性。

同步的基本目标是在保证系统可用性的前提下,尽可能地减少延迟,确保数据的强一致性或最终一致性,这取决于业务需求。一致性模型的选择,如强一致性、因果一致性、会话一致性等,对于实现数据同步具有指导意义。

在分布式系统中,数据同步的一个关键挑战是处理节点间网络的不可靠性。网络延迟和分区故障可能导致数据同步问题,因此,有效的数据同步机制需要具备应对这些挑战的能力。接下来的章节将详细探讨分布式数据同步面临的挑战和实现策略。

2. 分布式数据同步的挑战

2.1 数据一致性问题

2.1.1 引发数据不一致的原因

在分布式系统中,数据一致性问题通常由以下几个原因引发:

- 并发更新:多个用户或服务同时对同一数据进行更新操作,导致数据状态的不一致。

- 网络分区:分布式系统中的网络问题,如延迟或分区导致的网络延迟,可以导致某些节点的数据未能及时更新。

- 操作失败:更新操作可能因为各种原因(如硬件故障、软件错误等)在某些节点上失败,而其他节点上却成功了。

- 副本延迟:数据在多个副本之间同步时可能会出现延迟,特别是在跨地域部署的系统中。

2.1.2 数据一致性模型

为了解决数据不一致问题,分布式系统采用不同的数据一致性模型:

- 强一致性:所有副本在同一时间点上的数据状态必须完全相同。它通常通过同步复制实现,但可能影响系统的可用性和性能。

- 弱一致性:系统并不保证立即看到数据更新,只要求最终数据达到一致状态。这种模型在某些对延迟不敏感的应用中很有用。

- 最终一致性:系统保证,如果没有新的更新发生,数据最终将达到一致的状态。Amazon的Dynamo就是采用了最终一致性模型。

2.2 网络延迟与分区容错

2.2.1 网络延迟的影响

网络延迟在分布式系统中是不可避免的问题,它会直接导致数据同步的延迟,从而引发如下问题:

- 响应时间延长:客户端发起的请求需要等待数据同步完成,这增加了系统的响应时间。

- 系统可用性下降:在网络延迟严重的情况下,可能会导致系统对外提供的服务无法正常运行。

- 数据一致性风险:数据更新操作在网络延迟中可能会导致不一致的数据状态。

为了应对网络延迟,系统设计者需要在设计时考虑网络因素,实现一些补偿机制,如超时重试、异步复制等。

2.2.2 分区容错策略

分区容错是分布式系统设计中必须考虑的因素。常见的分区容错策略包括:

- 复制:通过将数据在多个节点上进行复制,以提高数据的可用性与容错性。

- 分区键:合理设计分区键(如哈希分区、范围分区等)来保证数据均匀分布,减少因分区带来的数据热点问题。

- 故障检测与恢复:实时监控各节点的健康状态,一旦发现分区,能够快速进行故障检测和数据恢复。

2.3 负载均衡与故障转移

2.3.1 负载均衡的需求分析

随着业务量的增长,单个节点往往无法满足高并发请求,此时就需要负载均衡:

- 高可用性:通过合理的流量分配,可以避免单点故障,提高系统的可用性。

- 扩展性:负载均衡可以根据流量的变化动态调整资源,更好地适应业务的扩展需求。

- 性能优化:通过合理的调度,可以将请求分配到性能较好的节点上,提升整体服务的响应速度。

2.3.2 故障转移机制

在分布式系统中,任何节点都有可能因为各种原因发生故障,故障转移机制保证了服务的连续性:

- 故障检测:系统需要实时检测各节点的健康状态,发现故障节点。

- 请求重定向:一旦节点故障,需要将该节点承担的请求重定向到其他健康节点。

- 状态同步:在故障节点恢复后,需要同步其状态,以保证数据的一致性和完整性。

在实际操作中,常用的负载均衡工具包括Nginx、HAProxy,而故障转移常通过集群管理工具如Kubernetes来实现。

3. 分布式数据同步的策略与实践

3.1 乐观并发控制

3.1.1 乐观并发控制的原理

乐观并发控制(Optimistic Concurrency Control,OCC)是一种并发控制机制,它假设多个事务在执行过程中很少发生冲突。在这种策略下,事务可以在开始时不锁定任何资源,而是各自独立地读取和处理数据。当事务提交时,会检查数据自读取之后是否被其他事务修改过,如果没有,则可以顺利提交;如果发生冲突,则回滚事务并重试。

乐观并发控制的核心思想是避免不必要的锁竞争,从而提高系统的吞吐量。这在读操作远多于写操作的环境下特别有效。然而,当冲突频繁发生时,大量的重试会导致系统性能下降。

3.1.2 实践中的应用案例

在实践中,乐观并发控制经常被用于数据库系统中,特别是在读写比例较高的Web应用中。例如,Facebook的MySQL数据库就使用了乐观并发控制机制。

以MySQL为例,其通过版本号或者时间戳来检测数据行是否被其他事务修改。在更新数据前,事务会获取当前版本号,当事务尝试提交时,数据库会检查数据版本号是否一致,如果一致则更新并提交,否则事务将失败并提示冲突。

- UPDATE table_name SET column1 = value1, column2 = value2 WHERE id = 1 AND version = current_version;

上述SQL语句中,version字段用以记录数据的版本信息。当执行更新操作时,必须满足version = current_version的条件,否则更新不会执行,事务需要重新处理。

3.2 读写分离机制

3.2.1 读写分离的基本概念

读写分离是一种常见的分布式数据库架构模式,通过将读和写操作分离到不同的数据库服务器上,以提高系统的性能和可用性。在这个模式中,通常会有一个主数据库负责处理写请求,然后将数据的变化复制到多个从数据库中,从数据库则负责处理读请求。

读写分离的优点在于可以将数据的读写负载分配到不同的服务器上,使得读操作可以在多个从服务器之间进行负载均衡,而写操作的压力则集中在主服务器上。这有助于提高大规模读取操作的性能,并且还能在一定程度上提高系统的容错性。

3.2.2 分布式环境下的读写分离实践

在分布式环境下实现读写分离,需要一个可靠的复制机制来同步数据变更。常见的复制技术包括异步复制、半同步复制和全同步复制。例如,MySQL的复制方式有基于日志的复制、基于语句