消息队列面试题深度解析:Kafka、RabbitMQ与ActiveMQ的比较

发布时间: 2025-01-08 17:00:25 阅读量: 6 订阅数: 6

高性能架构面试题系列:Nginx+ActiveMQ+RabbitMQ+Kafka.zip

# 摘要

消息队列作为一种先进的异步通信机制,在软件开发和运维中扮演了至关重要的角色。本文深入探讨了消息队列的三大主流技术——Kafka、RabbitMQ与ActiveMQ,并对其核心原理、应用场景及高级特性进行了详细分析。通过对这三种消息队列的架构特点、性能优化、协议支持、集群配置等方面的对比,本文旨在为技术选型提供指导,并展望消息队列技术的未来发展趋势。本文着重强调了不同应用场景下消息队列的选择标准,以帮助开发者和企业决策者根据业务需求做出明智的选择,并有效应对大数据、流处理及企业级应用的集成挑战。

# 关键字

消息队列;Kafka;RabbitMQ;ActiveMQ;性能优化;技术对比

参考资源链接:[Java面试必备:208道面试题全面解析](https://wenku.csdn.net/doc/21iteimjec?spm=1055.2635.3001.10343)

# 1. 消息队列基础与应用场景

消息队列(Message Queuing, MQ)是现代应用架构中一种重要组件,它允许应用程序之间通过异步的方式进行通信。这种技术可以解耦各个系统模块,提高系统的可用性和伸缩性。消息队列在处理大量数据、降低系统延迟和保证消息的可靠传输等方面发挥着至关重要的作用。

## 1.1 消息队列基本概念

在消息队列的上下文中,核心概念包括生产者(Producer)、消费者(Consumer)和消息(Message)。生产者创建消息,消费者接收并处理消息。消息队列作为中介,存储未处理的消息并管理其传递。

## 1.2 消息队列的作用与优势

消息队列能够缓冲生产者的消息,使得消费者可以按照自己的节奏消费消息,这在负载波动较大时,可以有效保护系统不至于因为突发流量而崩溃。此外,消息队列还能提供数据一致性保障和系统解耦等优势。

## 1.3 消息队列的应用场景

消息队列广泛应用于各种分布式系统中,如日志收集、流量削峰、异步处理和系统解耦等。它使得业务处理更加灵活,同时也提高了系统的可维护性。

在下一章节,我们将深入探讨Kafka的核心原理与技术细节。

# 2. ```

# 第二章:Kafka核心原理与技术细节

## 2.1 Kafka架构概览

### 2.1.1 Kafka集群组件

Kafka是一个分布式流处理平台,其核心组件包括Broker、Producer、Consumer、Topic、Partition和Replica。

- **Broker**:Kafka集群中的一个服务器节点,用于接收来自生产者的数据,并提供给消费者消费。一个Kafka集群可以由多个broker组成。

- **Producer**:生产者,负责将数据发送到Kafka的topic中。

- **Consumer**:消费者,负责从Kafka的topic中读取数据。

- **Topic**:主题,是Kafka处理消息的分类命名实体,生产者向主题发布消息,消费者从主题订阅消息。

- **Partition**:分区,是topic的逻辑概念。每个分区是一个有序的队列,生产者向分区写入消息,消费者从分区读取消息。

- **Replica**:副本,保证了Kafka的高可用性和持久性。每个分区可以有多个副本,其中一个为主副本(Leader),其余为从副本(Followers)。

在Kafka集群中,Broker节点不是静态的,可以动态增加或减少以实现系统的伸缩。当新Broker加入集群时,它可以从现有的Broker节点上接管一些分区,以实现负载均衡。

### 2.1.2 主题、分区与副本机制

在Kafka中,主题(Topic)是消息分发的核心概念,它被分为一个或多个分区(Partition),而每个分区又被复制到多个副本(Replica)。

**分区策略**:为了提高并行处理能力,Kafka允许将消息分散到多个分区中,每个分区是有序的,但分区间的消息顺序无法保证。分区的主要策略有两种:

1. **轮询策略**:默认情况下,Kafka采用轮询策略,生产者消息均匀地分布到不同的分区中。

2. **键值策略**:根据消息中带有的key值进行分区。相同key的消息会被发送到同一个分区。

**副本机制**:Kafka中的副本机制是实现数据冗余和系统高可用的关键。在创建topic时,可以指定副本因子(即副本数量),这些副本会被均匀地分布在不同的broker上。分区的主副本负责处理所有读写请求,而从副本则会定期与主副本同步,以保持数据一致性。

```

## 2.2 Kafka数据处理模型

### 2.2.1 生产者和消费者的模型

生产者(Producer)向Kafka集群发送数据,消费者(Consumer)则订阅并消费这些数据。生产者将数据推送到topic的指定分区中,消费者通过订阅topic来拉取数据。

生产者的模型设计为高吞吐量和低延迟,它通过消息批次(Batching)和压缩(Compression)技术来优化发送效率。生产者可以通过配置不同的确认级别(acks)来控制消息发送的可靠性。

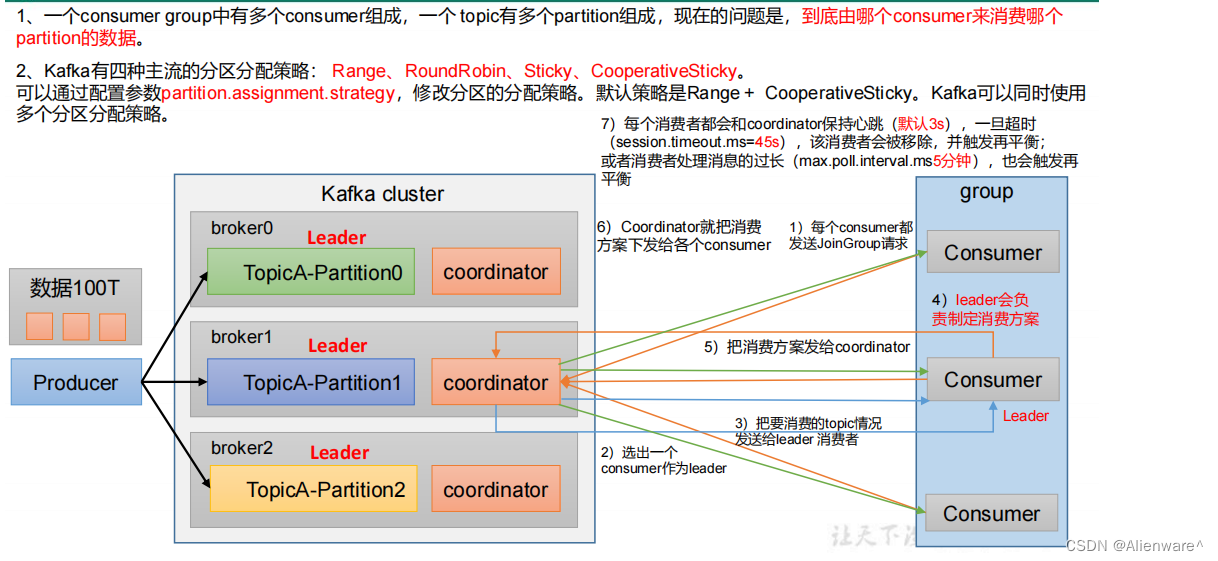

消费者的模型则是面向流的处理,消费者组(Consumer Group)的概念使得多个消费者可以共享和负载均衡处理topic中的数据。消费者会定期向Kafka发送心跳信息,以维持会话,并在崩溃或宕机时能够重新加入消费者组。

### 2.2.2 消息的存储与传输

在Kafka中,消息以二进制的形式存储在磁盘上,每个消息包含了一个时间戳、一个偏移量(Offset)、消息大小、可选的键和值等信息。消息的存储格式设计为易于磁盘存储和网络传输。

Kafka通过日志段(Log Segments)机制管理消息存储,每个分区对应一个或多个日志段文件。日志段通过索引文件维护消息的偏移量和物理位置的映射关系,使得消息查找更加高效。

消息的传输基于TCP协议,并通过ZooKeeper来维护元数据信息。Kafka使用异步的I/O模型,生产者发送消息和消费者拉取消息均通过NIO的Selector来实现多路复用。

```

## 2.3 Kafka的高可用性与扩展性

### 2.3.1 分区策略与领导者选举

分区策略直接关系到Kafka的高可用性和扩展性。在Kafka中,每个分区都有一个主副本(Leader),负责处理所有读写请求,而从副本(Followers)负责与主副本的数据同步。

分区的领导者选举机制是Kafka保证高可用性的关键部分。当主副本所在节点发生故障时,集群会触发领导者选举过程,自动选择新的主副本来接管分区。这一过程对于生产者和消费者是透明的。

分区策略通常采用的是均匀分布原则,以确保每个broker上处理的分区数量大致相同,从而实现负载均衡。在Kafka 0.11及以后的版本中,引入了新的副本分配策略(如副本平衡器),进一步优化了分区和副本的分配。

### 2.3.2 Kafka集群的扩缩容策略

Kafka集群的扩缩容是实现动态伸缩的关键操作,这包括增加或删除broker节点,以及增加或减少topic的分区数。

- **增加Broker**:在Kafka集群中增加新的broker节点相对简单,新节点会自动从现有的broker上接管一部分分区,同时,新加入的分区会根据配置的副本策略创建副本并同步数据。

- **删除Broker**:删除broker节点时,需要先将其上的分区转移至其他broker节点,确保集群的副本总数不变,然后才能安全地删除节点。

- **调整分区数**:调整topic的分区数量需要谨慎操作,因为分区数的增加会带来数据重新分配的问题,影响集群的稳定性。而分区数的减少则涉及到数据的合并和迁移。

在扩缩容过程中,Kafka提供了工具如`kafka-reassign-partitions`,能够辅助完成这些操作,并确保过程的稳定性和数据的一致性。

```

## 2.3 Kafka的高可用性与扩展性

### 2.3.1 分区策略与领导者选举

分区策略直接关系到Kafka的高可用性和扩展性。在Kafka中,每个分区都有一个主副本(Leader),负责处理所有读写请求,而从副本(Followers)负责与主副本的数据同步。

分区的领导者选举机制是Kafka保证高可用性的关键部分。当主副本所在节点发生故障时,集群会触发领导者选举过程,自动选择新的主副本来接管分区。这一过程对于生产者和消费者是透明的。

0

0