Hadoop在医疗行业的应用:大数据分析助力疾病预测与诊断的实战经验

发布时间: 2025-01-10 05:42:23 阅读量: 3 订阅数: 12

大数据处理领域Hadoop技术在大规模数据分析与挖掘中的应用"

# 摘要

本文探讨了Hadoop技术在医疗行业中的应用背景和意义,详细解析了Hadoop技术框架及其核心组件,并针对医疗数据处理进行了具体阐述。文章深入分析了Hadoop分布式文件系统(HDFS)和MapReduce编程模型在医疗大数据存储和分析中的作用,以及YARN资源管理在医疗行业中的应用。此外,本文还探讨了基于Hadoop的医疗大数据分析与疾病预测模型的构建,以及如何在医疗影像诊断中利用Hadoop技术进行数据挖掘和系统集成。最后,文章展望了Hadoop在医疗领域应用的未来前景,包括面临的挑战、机遇以及与人工智能结合的趋势。

# 关键字

Hadoop;医疗大数据;分布式文件系统;MapReduce;资源管理;疾病预测模型

参考资源链接:[Hadoop生态系统与MapReduce详解](https://wenku.csdn.net/doc/2r72igz978?spm=1055.2635.3001.10343)

# 1. Hadoop在医疗行业的背景与意义

随着信息技术的飞速发展,医疗行业正经历着前所未有的变革。尤其是大数据技术的引入,为医疗服务的优化、疾病预测与个性化治疗等提供了全新的途径。Hadoop作为大数据技术的核心代表,在医疗行业的应用日益广泛。本章将探讨Hadoop在医疗行业应用的背景和其意义,为我们深入理解大数据在医疗领域的作用奠定基础。

## 1.1 医疗行业中的数据挑战

现代医疗系统每天都会产生海量的数据,包括患者信息、诊断记录、药物反应、临床试验结果等。这些数据的规模与复杂性要求我们采用新的技术架构来处理和分析。Hadoop作为一种分布式计算平台,能够高效地处理大量数据,它所具备的可扩展性、容错性和成本效益使其成为处理医疗数据的理想选择。

## 1.2 Hadoop技术与医疗数据

Hadoop技术使得医疗机构可以更有效地存储、处理和分析医疗数据。它不仅能够应对数据量激增带来的挑战,还能提供更深入的数据洞察,从而辅助临床决策、提升患者护理质量、优化资源分配,甚至为研究者提供宝贵的数据资源以支持疾病研究和新药开发。

通过理解Hadoop在医疗行业中的背景和意义,我们可以看到,其带来的不仅是技术的进步,更是医疗行业的转型机遇。接下来,我们将深入探讨Hadoop技术框架的各个组成部分,以及它们是如何在实际医疗数据分析中发挥作用的。

# 2. Hadoop技术框架详解

## 2.1 Hadoop生态系统概述

### 2.1.1 Hadoop的核心组件介绍

Hadoop是一个由Apache基金会开发的开源框架,它允许用户使用简单的编程模型,在大量普通硬件上存储和处理大型数据集。Hadoop的核心包括两个重要的组件:Hadoop分布式文件系统(HDFS)和MapReduce。

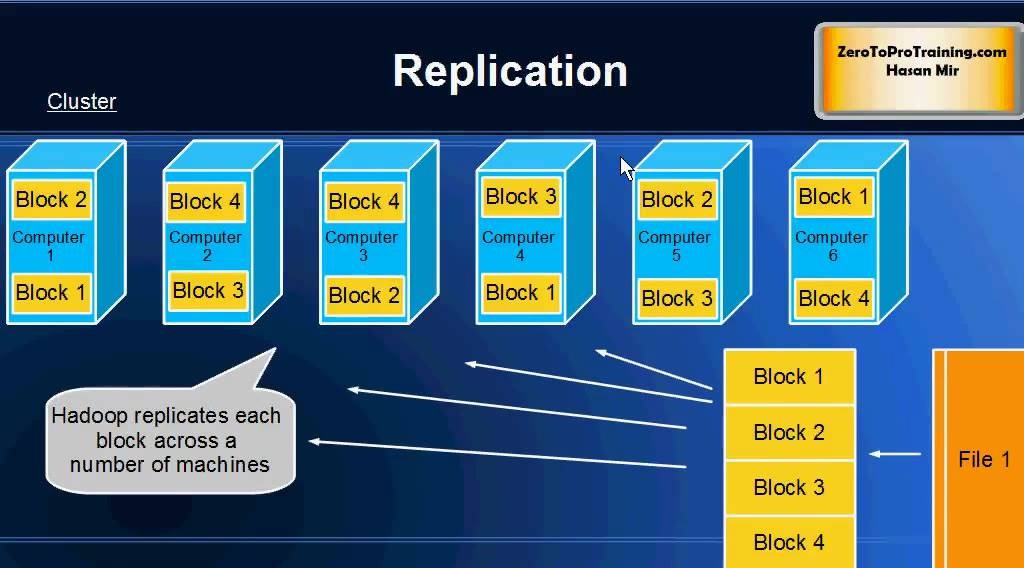

- **HDFS(Hadoop Distributed File System)**:HDFS是Hadoop的核心,负责数据的存储,它通过将数据分割成块(block),然后在多个节点之间复制这些块,从而保证了数据的高可用性和容错性。

- **MapReduce**:MapReduce是一个编程模型和处理大数据的软件框架,它通过在集群上分布计算任务,使得开发者可以轻易地在Hadoop上编写和运行处理大规模数据集的分布式应用。

除了这两个核心组件之外,Hadoop生态系统还包括其他几个重要组件,如YARN、Zookeeper、HBase、Hive、Pig等,共同构成了一个全面的大数据处理解决方案。

### 2.1.2 各组件在医疗数据处理中的作用

在医疗行业中,Hadoop生态系统能够支持各种复杂的数据处理任务。例如:

- **数据存储**:HDFS可以存储大量的医疗图像文件、患者记录、基因组数据等。

- **数据处理**:MapReduce能够处理来自不同来源的医疗数据,进行数据清洗、格式化和分析。

- **实时查询**:HBase和Hive提供对医疗数据的快速访问,支持复杂的查询和数据整合任务。

- **数据集成**:Pig提供了一个高级语言平台用于处理复杂的数据转换任务,而Zookeeper用于协调分布式应用。

这些组件共同工作,为医疗行业提供了一个健壮、灵活和可扩展的数据处理环境。

## 2.2 Hadoop分布式文件系统(HDFS)

### 2.2.1 HDFS的设计原理与架构

HDFS的设计原理基于以下几个关键概念:

- **高容错性**:通过数据块的复制,保证即使硬件失败,数据仍然可用。

- **流式数据访问**:适合大规模数据集的批处理,不适用于低延迟数据访问。

- **简单的一致性模型**:一次写入,多次读取,适合批量处理。

HDFS的基本架构包含以下主要部分:

- **NameNode**:负责管理文件系统的命名空间和客户端对文件的访问。它不存储实际的数据,而是存储文件系统的元数据。

- **DataNode**:运行在集群中的每个节点上,实际存储数据块。DataNode负责处理文件系统客户端的读写请求。

- **Secondary NameNode**:辅助NameNode,合并编辑日志和文件系统状态信息,防止NameNode出现故障时数据丢失。

### 2.2.2 HDFS在大规模医疗数据存储中的应用

在医疗行业中,HDFS用于存储大量的医疗图像、病历记录和基因组数据等,这些数据通常要求高效可靠的存储能力。HDFS可以轻松处理PB级别的数据存储需求,同时由于其高容错性的设计,它特别适合于医疗行业这种数据安全至关重要的环境。

例如,一家医院可以使用HDFS来存储其电子病历系统中的所有数据。由于数据在多个节点上进行了复制,因此即使某一台服务器发生故障,数据也不会丢失,可以保证系统的高可用性。

## 2.3 Hadoop MapReduce编程模型

### 2.3.1 MapReduce工作原理简述

MapReduce是一种编程模型,用于大规模数据集的并行运算。它的核心思想是将大任务分解成许多小任务(Map阶段),然后对每个小任务的结果进行汇总(Reduce阶段)。整个过程可简单地分为以下几个步骤:

1. **分割**:输入数据被分割成独立的块(通常为64MB到256MB之间),以便并行处理。

2. **Map阶段**:Map函数处理输入数据块,并产生中间键值对。

3. **Shuffle**:系统自动进行洗牌,将所有Map任务输出的键值对进行排序,并根据键将它们分发到各个Reduce任务。

4. **Reduce阶段**:Reduce函数将具有相同键的值合并起来,形成最终的结果。

### 2.3.2 实现医疗数据分析任务的MapReduce案例

在医疗行业,MapReduce可以用于分析和处理大量患者数据。例如,医院需要统计过去一年中所有患者的诊断情况,以便进行资源分配和疾病预防策略的制定。以下是使用MapReduce进行这项任务的简化案例。

**Map阶段**:

```java

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void ma

```

0

0