深度学习神经网络设计精讲:Hagan习题的深入解析与实践技巧

发布时间: 2025-01-02 17:13:28 阅读量: 8 订阅数: 13

# 摘要

随着深度学习技术的飞速发展,神经网络设计成为该领域研究的核心内容之一。本文首先回顾了深度学习中神经网络的基础知识,阐述了其工作原理和理论框架。接着,深入探讨了神经网络设计的关键方面,包括网络初始化、防止过拟合的策略,以及批量归一化和正则化的应用。此外,文章还分析了权重与激活函数的选择、网络架构优化,以及超参数调整的最佳实践。最后,通过具体案例,本文提供了在图像识别和自然语言处理任务中网络设计的实战分析,并针对实战问题提供了解决策略。整体而言,本文旨在为神经网络设计提供全面的理论和实践指南,帮助研究者和工程师有效应对设计挑战。

# 关键字

深度学习;神经网络;激活函数;权重初始化;过拟合;批量归一化;正则化;超参数优化;图像识别;自然语言处理

参考资源链接:[《神经网络设计(第2版)》习题解答详解](https://wenku.csdn.net/doc/5s0uf5ddu3?spm=1055.2635.3001.10343)

# 1. 深度学习神经网络基础回顾

## 1.1 神经网络概述

深度学习是机器学习的一个分支,它受到人脑中神经网络的启发,旨在构建能够从数据中学习复杂模式的模型。人工神经网络(ANN)由大量的节点(或称为神经元)组成,这些节点通过连接(或称为边)互相传递信息。网络中的每个神经元通常执行简单的运算:接收输入信号、加权求和并应用一个非线性函数(称为激活函数)。

## 1.2 神经网络的历史与发展

神经网络的研究最早可以追溯到20世纪40年代。起初,由于计算能力的限制和理论基础的不完善,神经网络的研究进展缓慢。直至21世纪初,随着大量数据的可用性和计算资源的显著提升,深度神经网络才迎来了飞速发展。深度学习模型,尤其是卷积神经网络(CNN)和循环神经网络(RNN),在图像识别、语音识别、自然语言处理等领域取得了显著的成果。

## 1.3 神经网络的基础概念

在开始深入学习神经网络之前,理解以下基础概念至关重要:

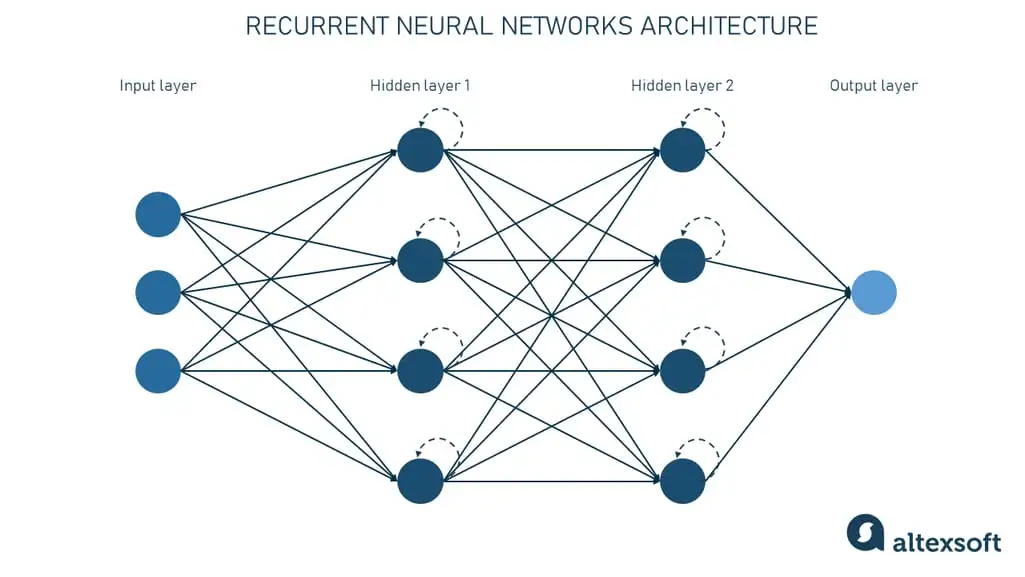

- 输入层、隐藏层和输出层:神经网络根据其位置和作用可以被分为输入层、隐藏层和输出层。输入层接收原始数据,隐藏层处理数据,输出层产生最终的预测结果。

- 权重(weights):神经网络中的边被赋予数值称为权重,这些权重在网络训练过程中通过学习算法不断更新。

- 激活函数(activation functions):激活函数决定了神经元的输出是否应该被传递到下一个神经元。常用的激活函数包括sigmoid、tanh和ReLU等。

在深入理解这些基础概念后,我们将继续探索神经网络设计的理论框架,逐步深入到网络训练、泛化能力和防止过拟合等关键话题。

# 2. 神经网络设计的理论框架

## 2.1 神经网络的工作原理

### 2.1.1 生物神经网络与人工神经网络

在深入探讨人工神经网络之前,首先有必要了解其灵感来源——生物神经网络。生物神经系统是由数以亿计的神经元构成,这些神经元通过突触连接,互相传递电信号和化学信号。每个神经元接收到信号后,经过加权求和和激活函数处理,决定是否向下一个神经元传递信号。

人工神经网络(Artificial Neural Networks, ANN)是尝试模拟生物神经网络行为的计算模型。尽管实际的ANN在复杂性和功能上远不及生物神经网络,但它们仍然能够在特定任务上展现出类似于生物网络的处理能力。基本的ANN由输入层、一个或多个隐藏层以及输出层组成。每一层由若干神经元(或称为节点)构成,神经元之间通过权重连接,权重代表了层与层之间信号传递的重要性。

### 2.1.2 激活函数的角色与选择

激活函数在神经网络中的角色至关重要,它为网络引入了非线性因素,使得神经网络有能力学习和模拟复杂的函数映射。激活函数通常作用于神经元的加权输入,决定该神经元是否“激活”及其激活的程度。

常用激活函数包括:

- Sigmoid函数:将任何实数值压缩到(0,1)区间,但存在梯度消失问题,不常在深层网络中使用。

- Tanh函数:输出范围是(-1,1),相比于Sigmoid函数,它在原点处对称,但同样存在梯度消失问题。

- ReLU(Rectified Linear Unit)函数:输出输入的最大值,其好处在于计算简单且缓解了梯度消失问题,因此在深层网络中被广泛使用。

- Leaky ReLU和PReLU等变体,为负值部分提供一个较小的斜率,使得梯度不会完全消失。

选择合适的激活函数对于设计有效的神经网络至关重要。它影响模型的收敛速度、稳定性以及最终的性能表现。

## 2.2 神经网络的训练过程

### 2.2.1 前向传播与反向传播算法

神经网络的训练过程可以分为前向传播和反向传播两个阶段。在前向传播阶段,输入数据通过网络从输入层传到输出层,每层的神经元根据其权重、偏置以及激活函数计算输出值。最终,这些值与预期输出进行比较,计算得到损失函数值。

反向传播算法是训练神经网络的核心。根据损失函数的梯度,反向传播算法逐层计算每组权重对损失函数的影响,然后利用梯度下降或其变种(如Adam、RMSprop等优化器)来更新权重。这个过程使得网络能够“学习”到如何调整权重以减少预测误差。

### 2.2.2 损失函数与优化器的作用

损失函数衡量了模型预测值与实际值之间的差异,是指导神经网络优化过程的“指南针”。在回归任务中,均方误差(MSE)是最常用的损失函数。对于分类任务,交叉熵损失被广泛应用,尤其是多分类问题。

优化器则是更新网络权重的具体算法,其目的是快速且有效地减少损失函数值。常见的优化器有SGD(随机梯度下降)、Adam、RMSprop等。优化器的参数(如学习率)对于训练效率和模型性能有着重大影响。

## 2.3 神经网络的泛化与过拟合

### 2.3.1 泛化能力的重要性

泛化能力是指模型对于未知数据的预测能力。一个模型如果在训练数据上表现很好,但是在新的、未见过的数据上表现不佳,就说明该模型存在泛化能力差的问题。泛化能力是衡量模型实际应用价值的关键指标。

### 2.3.2 防止过拟合的策略

过拟合是模型在训练数据上学到了太多噪声和细节,导致模型泛化能力下降。为了防止过拟合,可以采取以下策略:

- **数据增强**:通过对训练数据进行旋转、缩放、裁剪等变换,增加训练集的多样性,减少模型对特定训练样本的过度拟合。

- **正则化**:通过在损失函数中增加一个正则化项(如L1或L2正则项)来惩罚大的权重值,强制模型学习更简单的函数。

- **dropout**:在训练过程中随机丢弃一部分神经元,迫使网络不依赖于任何一个神经元,增强网络的泛化能力。

- **早停(early stopping)**:在验证集上监控模型性能,一旦验证集上的性能开始下降,停止训练过程。

这些策略可以帮助提高模型的泛化能力,降低过拟合的风险。

**接下来将进入第三章:Hagan习题的深入解析,其中包含对网络初始化、梯度消失与爆炸、批量归一化与正则化等关键问题的详细讨论和案例解析。**

# 3. Hagan习题的深入解析

在这一章节中,我们将深入分析Hagan教授在其著作中提出的多个习题,这些习题覆盖了神经网络初始化、梯度问题、批量归一化以及正则化的不同方面。通过解析这些习题,不仅可以加深对基础概念的理解,还能掌握解决实际问题的策略。

## 3.1 习题解析:网络初始化

### 3.1.1 权重初始化方法

在开始神经网络的训练之前,权重初始化是一个不可或缺的步骤。初始化方法对网络的训练效果有直接影响,选择不当可能会导致网络无法有效学习。常见的初始化方法包括:

- 零初始化(Zero Initialization):将所有权重初始化为零。这种方法在早期被使用,但会导致梯度消失问题,因为反向传播中所有权重的梯度都会相同。

- 随机初始化(Random Initialization):权重被初始化为很小的随机值,通常以0为中心。这有助于解决对称性问题,避免了所有神经元以相同方式更新。

- 以1为中心的初始化(He Initialization):He初始化方法特别适用于使用ReLU激活函数的网络,权重被初始化为具有变体的较小值,以减少梯度消失问题。

- Xavier初始化(Glorot Initialization):这种方法在权重初始化时考虑到前一层神经元的数量,有利于保持信号在正向和反向传播时的方差一致性。

```python

import numpy as np

# He Initialization示例

def he_initialization(layer_size):

fan_in, fan_out = layer_size[0], layer_size[1]

std = np.sqrt(2. / fan_in)

return np.random.randn(fan_in, fan_out) * std

```

以上代码展示了如何使用He初始化方法。函数`he_initialization`根据网络层的输入和输出维度来计算权重的标准差,并使用这个标准差来生成符合He初始化方法的权重矩阵。

### 3.1.2 初始化对性能的影响

权重初始化方法的选取,对网

0

0