【TPA-LSTM的可解释性研究】:深入理解模型预测的工作原理

摘要

TPA-LSTM模型结合了长短期记忆网络(LSTM)和时序模式注意力(Temporal Pattern Attention, TPA)机制,旨在提升时序数据预测的准确性和模型的可解释性。本文首先概述了TPA-LSTM的模型结构,深入探讨了LSTM的基础原理及其在序列预测中的优势,随后详细阐述了TPA机制及其在模式识别中的作用。接着,文章介绍了TPA-LSTM模型的数学模型、编程框架选择、核心代码实现以及模型训练的实验设置。此外,本文重点分析了TPA-LSTM的可解释性,探讨了其重要性、方法论和实证研究。最后,本文展示了TPA-LSTM在实际问题中的应用,并展望了模型的研究挑战与未来发展方向。

关键字

TPA-LSTM;长短期记忆网络;时序模式注意力;可解释性;序列预测;深度学习

参考资源链接:TPA-LSTM: 时间序列预测的深度学习模型

1. TPA-LSTM模型概述

深度学习模型的复杂性和黑箱特性常常使得模型的决策过程难以理解,特别是在处理时序数据时。为了增强对模型决策的洞察力,研究人员提出了一种结合长短期记忆网络(LSTM)与时间模式注意力(TPA)机制的新型深度学习模型,即TPA-LSTM。本章节将简要介绍TPA-LSTM的基本概念和主要功能,为读者提供一个总体认识。

1.1 TPA-LSTM的定义和功能

TPA-LSTM是利用注意力机制来增强传统LSTM网络对时序数据中关键时间点信息捕获能力的一种改进模型。它的主要功能在于通过注意力加权来识别序列中重要的时间模式,从而提高预测的准确性和解释性。

1.2 TPA-LSTM的应用场景

由于TPA-LSTM特别擅长处理和分析具有时间依赖性的序列数据,因此它在金融市场分析、气象预测、语音识别等领域具有广阔的应用前景。通过精确地识别和分析关键时间点,TPA-LSTM能为决策支持系统提供更为可靠的依据。

2. TPA-LSTM的理论基础

2.1 LSTM网络结构解析

2.1.1 LSTM的基本单元和工作原理

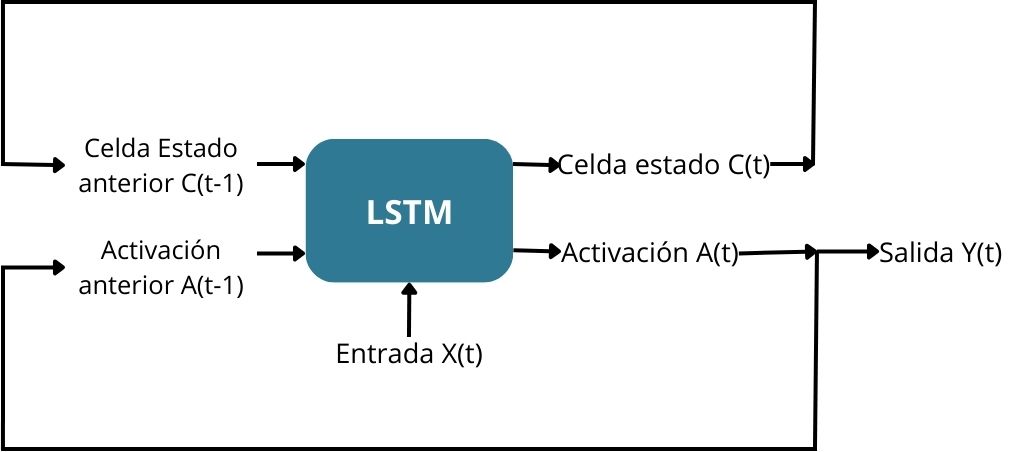

长短期记忆网络(Long Short-Term Memory, LSTM)是一种特殊类型的循环神经网络(RNN),能够学习长期依赖信息。LSTM的关键在于引入了“记忆单元”(memory cells),这些单元能够通过精心设计的门结构来控制信息的流动。

- 细胞状态(Cell State):LSTM内部的一个“高速公路”概念,信息可以沿着这个路径流动,而不需要经过复杂的变换。

- 门控机制(Gating Mechanism):包括输入门(input gate)、遗忘门(forget gate)和输出门(output gate)。这些门的目的是增加或减少信息通过的流量,以此来保护和控制细胞状态。 遗忘门决定哪些信息需要从细胞状态中删除,而输入门控制哪些新信息需要添加到细胞状态中。最终,输出门决定下一个隐藏状态需要输出什么信息。

LSTM单元的运作逻辑

假设有一系列时间点 (t=1, 2, …, T),在每个时间点,LSTM单元都会接受当前的输入 (x_t),并依赖于上一时刻的状态 (h_{t-1}) 和当前单元状态 (C_{t-1}) 来更新状态。以下为门控操作的数学表达:

-

遗忘门: [ f_t = \sigma(W_f \cdot [h_{t-1}, x_t] + b_f) ] 其中,(f_t) 表示遗忘门的输出,(W_f) 和 (b_f) 分别是遗忘门的权重矩阵和偏置向量,(\sigma) 是sigmoid函数。

-

输入门: [ i_t = \sigma(W_i \cdot [h_{t-1}, x_t] + b_i) ] [ \tilde{C}t = \tanh(W_C \cdot [h{t-1}, x_t] + b_C) ] 其中,(i_t) 是输入门的输出,(\tilde{C}_t) 是候选细胞状态,而 (W_i, W_C) 和 (b_i, b_C) 分别是对应的权重矩阵和偏置向量。

-

细胞状态更新: [ C_t = f_t \odot C_{t-1} + i_t \odot \tilde{C}_t ] 这里,(\odot) 表示Hadamard乘积(按元素乘法),用于更新细胞状态。

-

输出门: [ o_t = \sigma(W_o \cdot [h_{t-1}, x_t] + b_o) ] [ h_t = o_t \odot \tanh(C_t) ] 其中,(o_t) 表示输出门的输出,(h_t) 是最终的隐藏状态输出。

LSTM通过这一系列复杂的门控操作,有效避免了传统RNN长期依赖问题中的梯度消失和梯度爆炸问题。

2.1.2 LSTM在序列预测中的优势

序列预测问题需要模型能够理解并记住输入序列中重要的时间步信息,同时忘记那些不重要的信息。LSTM在这样的任务中显示出其独特的优势:

- 记忆能力:LSTM通过细胞状态机制能够存储和传递关键信息,对长时间跨度的依赖关系建模有很好的效果。

- 选择性记忆:遗忘门和输入门的引入允许LSTM单元选择性地保留和忘记信息,这有助于过滤掉噪声,专注于任务的关键特征。

- 长期依赖的建模:LSTM通过门控的结构可以维持较长时间内的稳定梯度,这样模型能够学习到跨多个时间步的依赖关系。

- 灵活性:LSTM的可塑性使其能够在各种任务上取得优异表现,包括语言模型、时间序列预测、语音识别等。

2.2 Temporal Pattern Attention机制

2.2.1 注意力机制在TPA中的作用

注意力机制(Attention Mechanism)已经被广泛应用于序列模型中,用以增强模型对输入序列重要部分的聚焦能力。在TPA-LSTM模型中,注意力机制发挥着至关重要的作用。它的主要作用是:

- 突出重要特征:通过为序列中的每个时间步分配不同的权重,注意力机制可以让模型更加关注那些对于预测任务更为重要的部分。

- 增加模型的解释性:注意力权重作为模型内部的一种解释工具,可以帮助研究者和工程师理解模型是如何做出预测的。

2.2.2 时序数据的模式识别

在处理时序数据时,识别出关键的模式和趋势至关重要。TPA-LSTM通过其注意力机制来识别时序数据中的重要模式。它主要包含以下步骤:

-

计算注意力分数:对于序列中的每个时间步,TPA-LSTM会计算一个注意力分数,该分数反映了此时间步在做出预测时的重要性。 [ e_t = \text{score}(h_t, \mathbf{H}) ] 这里,(h_t) 是时间步 (t) 的隐藏状态,(\mathbf{H}) 是整个序列的隐藏状态矩阵,而 (\text{score}(\cdot)) 是用于计算注意力分数的函数。

-

转换为注意力权重:通过softmax函数将注意力分数转化为概率分布,即注意力权重。 [ \alpha_t = \text{softmax}(e_t) = \frac{\exp(e_t)}{\sum_{t’} \exp(e_{t’})} ]

-

加权和:最后,将所有时间步的隐藏状态按照注意力权重加权求和,得到一个加权的上下文表示。 [ \mathbf{c} = \sum_{t} \alpha_t h_t ] 这个上下文表示被用于后续的输出或决策过程。

通过这样的过程,TPA-LSTM能够动态地根据输入数据的特性调整其对不同时间步的关注程度,从而更准确地进行序列预测。

3. TPA-LSTM的实现细节

3.1 模型的编程框架选择

3.1.1 框架对比和选择理由

在实现TPA-LSTM模型时,选择一个合适的编程框架至关重要,因为它会直接影响模型的开发效率、运行性能和可维护性。目前,主流的深度学习框架包括TensorFlow、PyTorch、Keras等。TensorFlow以其强大的计算图和分布式计算能力受到开发者青睐,尤其在工业界得到了广泛应用。PyTorch则以其动态计算图和易用性在学术界更为流行。Keras提供了简洁的API,适合快速实现和部署深度学习模型。

对于TPA-LSTM这样的复杂模型,我们更倾向于选择PyTorch。PyTorch的动态计算图设计使模型的调试更为方便,代码编写也更为直观。此外,PyTorch的API设计更加Pyt