【i.MX6ULL音视频处理能力挖掘】:编解码与流媒体技术实战

发布时间: 2025-01-04 22:27:18 阅读量: 8 订阅数: 11

i.mx6ull终结者开发板使用手册_v1.1.pdf

# 摘要

本文全面介绍了i.MX6ULL平台在音视频处理领域的应用。首先,概述了i.MX6ULL平台及其音视频处理基础,随后深入探讨了音视频编解码技术,包括硬件与软件编解码器的配置使用、编解码算法和性能优化。第三章关注流媒体技术的实现和性能优化,包括传输协议和网络延迟、带宽优化。第四章详述了音视频系统集成的实战经验,包括捕获、显示、音频处理和系统级同步。第五章提供了应用开发的实战指导,从开发环境配置到性能分析和调试技巧。最后,第六章通过案例分析,探讨了i.MX6ULL在不同音视频项目中的实际应用。本文旨在为从事i.MX6ULL平台音视频处理的开发者提供详实的参考和指导。

# 关键字

i.MX6ULL平台;音视频编解码;流媒体技术;系统集成;应用开发;案例分析

参考资源链接:[i.MX6ULL应用处理器中文参考手册](https://wenku.csdn.net/doc/iip3qi8o4y?spm=1055.2635.3001.10343)

# 1. i.MX6ULL平台概述与音视频处理基础

## 1.1 i.MX6ULL平台概述

i.MX6ULL是恩智浦半导体推出的一款高性能、低功耗的处理器,广泛应用于工业自动化、车载信息娱乐系统、移动医疗设备等领域。它具有ARM Cortex-A7架构,支持双核和四核配置,主频最高可达1GHz。该平台集成了丰富的外设接口,例如GPIO、UART、I2C、SPI等,同时支持多种音频和视频输入输出格式,使其成为音视频处理的理想选择。

## 1.2 音视频处理基础

音视频处理是通过特定的算法对音视频数据进行采集、编码、传输、解码和播放等操作的过程。在i.MX6ULL平台上,音视频处理涉及多个关键技术点,包括但不限于:

- **采样与量化**:音频信号通过模数转换器(ADC)进行采样和量化,视频信号通过图像传感器进行采样。采样定理指出,采样频率必须大于信号最高频率的两倍,以保证信号的完整性。

- **编解码技术**:音视频数据在存储和传输前需要压缩,以减少带宽和存储需求。常用压缩标准包括H.264和H.265等。

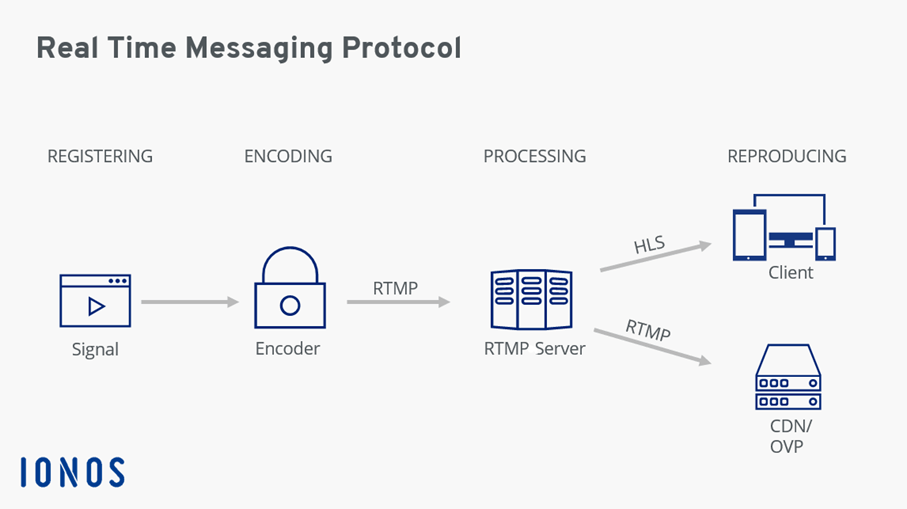

- **传输协议**:音视频数据通常通过RTP/RTSP等协议在IP网络上进行实时传输。

i.MX6ULL平台通过其集成的硬件加速器和软件库,为音视频处理提供了强大的支持。接下来的章节将详细探讨这些技术点,并展示如何在i.MX6ULL平台上实现高效的音视频处理。

# 2. i.MX6ULL音视频编解码技术详解

### 2.1 i.MX6ULL硬件编解码支持

#### 2.1.1 硬件编解码器概述

i.MX6ULL处理器内置了高性能的硬件编解码器,可以提供高效且低功耗的音视频处理能力。硬件编解码器主要负责将原始音视频数据编码成压缩格式,以便于存储和网络传输,同时也能够将压缩的音视频数据解码为可显示或播放的格式。在众多硬件编解码器中,i.MX6ULL支持包括但不限于H.264、H.265/HEVC、VP8、MP3、AAC等主流编解码标准。

硬件编解码器相对于软件编解码而言,在速度和能耗上具有明显的优势。这是因为硬件编解码器通常是由专用的硬件电路实现,可以并行处理大量数据,并且能耗更低,特别适合于移动设备和嵌入式系统。

#### 2.1.2 硬件编解码器的配置与使用

在i.MX6ULL上使用硬件编解码器,需要配置相应的IP核。这通常涉及到对处理器内部的VPU(视频处理单元)进行初始化和设置。初始化过程会涉及到设置编解码器的工作模式,如选择编解码标准、分辨率、帧率以及码率等参数。举例来说,以下是一段示例代码,用于初始化H.264编解码器:

```c

// 示例代码:初始化H.264编解码器

h264 Encoder;

Encoder.ConfigureEncoder(H264_PROFILE_HIGH, 1280, 720, 30);

Encoder.SetBitrate(4000000); // 设置码率为4Mbps

Encoder.SetIFrameInterval(30); // 设置关键帧间隔为30帧

```

在这个例子中,我们配置了一个H.264编码器,使用高级配置文件(HIGH profile),分辨率为1280x720,帧率为30fps,并设置了4Mbps的码率和每30帧一个关键帧的间隔。这一系列配置工作为后续的编解码流程打下了基础。

### 2.2 i.MX6ULL软件编解码框架

#### 2.2.1 GStreamer框架入门

GStreamer是一个跨平台的多媒体框架,它提供了一个灵活的管道(pipeline)系统来构建音视频应用。GStreamer通过插件机制实现各种音视频处理功能,从简单的音频播放到复杂的流媒体传输,都可以通过组合不同的插件来实现。

使用GStreamer的一个关键优势是它具有良好的可扩展性和跨平台性。i.MX6ULL平台通过交叉编译,可以将GStreamer框架和必要的插件集成到嵌入式设备上。在实际操作中,我们首先需要配置GStreamer的环境,包括安装库文件、编译插件等。

```shell

# 示例:在Linux环境下安装GStreamer

sudo apt-get install libgstreamer1.0-dev

sudo apt-get install gstreamer1.0-plugins-base gstreamer1.0-plugins-good

sudo apt-get install gstreamer1.0-plugins-bad gstreamer1.0-plugins-ugly

```

安装完成后,我们就可以在代码中引入GStreamer头文件,并开始构建管道。GStreamer的核心是通过管道将数据在各个元素(element)间流转。下面是一个创建简单播放管道的例子:

```c

#include <gst/gst.h>

int main(int argc, char *argv[]) {

GstElement *pipeline, *source, *sink;

GstBus *bus;

GstMessage *msg;

GstStateChangeReturn ret;

/* 初始化GStreamer */

gst_init(&argc, &argv);

/* 创建元素 */

source = gst_element_factory_make("filesrc", "file-source");

sink = gst_element_factory_make("autoaudiosink", "audio-sink");

pipeline = gst_pipeline_new("test-pipeline");

/* 设置源的属性 */

g_object_set(source, "location", "file:///path/to/some/audio/file.mp3", NULL);

/* 构建管道 */

gst_bin_add_many(GST_BIN(pipeline), source, sink, NULL);

if (gst_element_link_many(source, sink, NULL) != TRUE) {

g_error("Elements could not be linked.");

gst_object_unref(pipeline);

return -1;

}

/* 开始播放 */

ret = gst_element_set_state(pipeline, GST_STATE_PLAYING);

if (ret == GST_STATE_CHANGE_FAILURE) {

g_error("Unable to set the pipeline to the playing state.");

gst_object_unref(pipeline);

return -1;

}

/* 等待一段时间,或者等待某个消息 */

bus = gst_element_get_bus(pipeline);

do {

msg = gst_bus_timed_pop_filtered(bus, GST_CLOCK_TIME_NONE,

GST_MESSAGE_STATE_CHANGED | GST_MESSAGE_ERROR | GST_MESSAGE_EOS);

/* 处理消息 */

} while (msg != NULL);

/* 清理 */

gst_object_unref(bus);

gst_element_set_state(pipeline, GST_STATE_NULL);

gst_object_unref(pipeline);

return 0;

}

```

#### 2.2.2 GStreamer插件与流水线设计

在GStreamer中,插件是扩展功能的基础单元。每种插件提供一种特定的处理功能,如解码、编码、格式转换等。流水线(pipeline)则是由这些插件元素组成的处理链,它们按照特定的顺序连接,协同完成复杂的多媒体处理任务。

设计流水线时,需要考虑数据流的顺序和同步问题。以下是一个典型的流水线设计,包含了解码器、音视频同步和显示三个主要部分:

```mermaid

graph LR

A(filesrc) -->|Source| B(decodebin)

B -->|Video| C(mpg123audioparse)

B -->|Audio| D(mpg123audioparse)

C --> E(audiomixer)

D --> E

E --> F(xvimagesink)

B -->|Video| G(mpgvdec)

G --> H(xvimagesink)

```

在这个示例中:

- `filesrc` 是媒体文件源。

- `decodebin` 自动选择合适的解码器对音视频进行解码。

- `mpg123audioparse` 和 `mpgvdec` 分别处理音频和视频流。

- `audiomixer` 将音频流混合,`xvimagesink` 用于视频显示。

- `mpgvdec` 输出视频流到`xvimagesink`。

设计流水线时,重点是正确配置每个插件的属性,并确保插件间的数据能够顺利流动。例如,为了确保音视频同步,我们需要使用同步机制,如音视频混音器(`audiomixer`)。

### 2.3 编解码算法与性能优化

#### 2.3.1 H.264、H.265等主流编解码标准

H.264和H.265是视频编解码领域中最常用的两种标准。H.264,也被称作MPEG-4 AVC,是广泛应用于广播、存储和通信等领域的高效视频压缩标准。H.265,即HEVC(High Efficiency Video Coding),在H.264的基础上,进一步提高了编码效率,尤其是在高分辨率视频方面。H.265的压缩效率比H.264提高了大约50%,在相同的视频质量下,所需的比特率可以减半。

i.MX6ULL处理器支持这两种编码标准,可以通过硬件加速进行高效编码。在设计音视频编解码系统时,选择合适的编解码标准对于优化性能和减少资源消耗至关重要。

#### 2.3.2 优化编解码性能的策略与实践

优化编解码性能通常涉及算法优化、资源配置和系统调优。在算法层面,可以采用更高效的编解码算法,如选择合适的帧类型和参考帧数量。资源配置方面,可以根据任务需求调整CPU/GPU的负载分配,以及分配合适的内存大小。系统调优则是通过参数调整和优化来提升系统整体性能。

例如,H.264编码时,可以通过设置B帧(双向预测

0

0