揭秘MySQL复制:从原理到实战,打造高可用数据库环境

发布时间: 2024-07-26 10:27:19 阅读量: 25 订阅数: 41

# 1. MySQL复制概述**

MySQL复制是一种将数据从一个数据库(主服务器)复制到另一个数据库(从服务器)的技术。它主要用于以下目的:

* **数据冗余和高可用性:**从服务器可以作为主服务器的备份,在主服务器出现故障时提供数据冗余和高可用性。

* **读写分离:**从服务器可以用于处理读操作,从而减轻主服务器的负载,提高性能。

* **异地容灾:**从服务器可以部署在不同的地理位置,以提供异地容灾保护,防止数据丢失。

# 2. MySQL复制原理**

**2.1 复制架构和组件**

MySQL复制是一种异步复制机制,它允许将一个MySQL服务器(主服务器)上的数据更改复制到另一个或多个MySQL服务器(从服务器)。复制架构主要包括以下组件:

* **主服务器:**负责处理客户端请求并执行数据更改。

* **从服务器:**从主服务器接收数据更改并将其应用到自己的数据库中。

* **二进制日志(binlog):**主服务器上的一个日志文件,记录了所有已提交的数据更改。

* **中继日志(relay log):**从服务器上的一个日志文件,存储从主服务器接收到的binlog事件。

* **I/O线程:**从服务器上的一个线程,从主服务器读取binlog事件并将其写入中继日志。

* **SQL线程:**从服务器上的一个线程,从重放中继日志中的事件,将数据更改应用到自己的数据库中。

**2.2 复制过程详解**

MySQL复制过程主要包括以下步骤:

1. **主服务器执行数据更改:**当客户端向主服务器发送数据更改请求时,主服务器执行该请求并记录更改到binlog中。

2. **I/O线程读取binlog:**从服务器的I/O线程从主服务器读取binlog事件并将其写入中继日志。

3. **SQL线程重放中继日志:**从服务器的SQL线程从重放中继日志中的事件,将数据更改应用到自己的数据库中。

**2.3 主从复制和多源复制**

**主从复制:**是最常见的复制模式,其中一个主服务器复制到一个或多个从服务器。

**多源复制:**一种更高级的复制模式,其中多个主服务器可以复制到一个或多个从服务器。这允许从不同的数据源创建数据副本,并实现更灵活的数据管理。

**代码示例:**

```sql

# 在主服务器上启用binlog

SET GLOBAL binlog_format = ROW;

SET GLOBAL binlog_row_image = FULL;

# 在从服务器上配置复制

CHANGE MASTER TO

MASTER_HOST='192.168.1.100',

MASTER_USER='repl',

MASTER_PASSWORD='repl_pass',

MASTER_LOG_FILE='mysql-bin.000001',

MASTER_LOG_POS=100;

# 启动从服务器上的I/O线程和SQL线程

START SLAVE;

```

**逻辑分析:**

* `SET GLOBAL binlog_format = ROW;`:设置binlog格式为基于行的格式,记录每一行的更改。

* `SET GLOBAL binlog_row_image = FULL;`:设置binlog记录每一行的完整图像,包括旧值和新值。

* `CHANGE MASTER TO`:在从服务器上配置复制,指定主服务器信息和binlog位置。

* `START SLAVE;`:启动从服务器上的I/O线程和SQL线程,开始复制过程。

# 3.1 主从复制配置

### 3.1.1 主服务器配置

主服务器是复制体系中的数据源,负责将数据变更同步到从服务器。主服务器的配置主要包括以下步骤:

1. **开启二进制日志(binary log)**:二进制日志记录了数据库中所有已提交的事务,是复制的基础。使用以下命令开启二进制日志:

```

SET GLOBAL binlog_format = ROW;

SET GLOBAL binlog_row_image = FULL;

```

2. **创建复制用户**:复制用户是主服务器用于与从服务器通信的专用用户。使用以下命令创建复制用户:

```

CREATE USER 'repl'@'%' IDENTIFIED BY 'password';

GRANT REPLICATION SLAVE ON *.* TO 'repl'@'%';

FLUSH PRIVILEGES;

```

3. **记录二进制日志位置**:在主服务器上记录当前的二进制日志位置,以便从服务器连接时使用。使用以下命令记录位置:

```

SHOW MASTER STATUS;

```

### 3.1.2 从服务器配置

从服务器是复制体系中的数据接收方,负责从主服务器接收数据变更并应用到自己的数据库中。从服务器的配置主要包括以下步骤:

1. **连接到主服务器**:使用以下命令连接到主服务器:

```

CHANGE MASTER TO

MASTER_HOST='master_host',

MASTER_USER='repl',

MASTER_PASSWORD='password',

MASTER_LOG_FILE='master_log_file',

MASTER_LOG_POS=master_log_pos;

```

2. **开启复制线程**:使用以下命令开启复制线程,从主服务器接收数据变更:

```

START SLAVE;

```

3. **检查复制状态**:使用以下命令检查复制状态:

```

SHOW SLAVE STATUS;

```

如果复制状态正常,则会显示以下信息:

```

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

```

### 3.2 多源复制配置

多源复制允许一个从服务器同时从多个主服务器接收数据变更。这可以提高数据的可用性和可靠性。多源复制的配置主要包括以下步骤:

1. **在主服务器上配置复制过滤器**:复制过滤器用于指定哪些数据变更应该复制到从服务器。使用以下命令配置复制过滤器:

```

CREATE REPLICATION FILTER 'filter_name' DO REPLICATE DO_DB = 'db_name', DO_TABLE = 'table_name';

```

2. **在从服务器上配置复制通道**:复制通道用于指定从服务器应该从哪些主服务器接收数据变更。使用以下命令配置复制通道:

```

CREATE REPLICATION CHANNEL 'channel_name' FOR REPLICATION FILTER 'filter_name' TO 'slave_host';

```

3. **开启复制线程**:使用以下命令开启复制线程,从主服务器接收数据变更:

```

START REPLICATION CHANNEL 'channel_name';

```

### 3.3 复制故障排查

在复制过程中可能会遇到各种故障,需要及时排查和解决。常见的故障排查步骤包括:

1. **检查复制状态**:使用 `SHOW SLAVE STATUS` 命令检查复制状态,了解复制线程是否正在运行以及是否存在错误。

2. **查看错误日志**:在主服务器和从服务器上查看错误日志,查找与复制相关的错误信息。

3. **检查网络连接**:确保主服务器和从服务器之间的网络连接正常。

4. **检查磁盘空间**:确保主服务器和从服务器都有足够的磁盘空间来存储二进制日志和重做日志。

5. **重启复制线程**:如果复制线程停止运行,可以尝试使用 `START SLAVE` 命令重新启动。

# 4. MySQL复制高级应用**

**4.1 读写分离和负载均衡**

**4.1.1 读写分离原理**

读写分离是一种将数据库读写操作分离到不同的服务器上的技术。主服务器负责处理写入操作,而从服务器负责处理读取操作。这样可以减轻主服务器的负载,提高数据库的并发处理能力。

读写分离的实现原理是通过复制技术。主服务器将数据变更同步到从服务器,从服务器上的数据与主服务器保持一致。当客户端进行读取操作时,可以将请求路由到从服务器,从而减轻主服务器的压力。

**4.1.2 负载均衡策略**

负载均衡是将请求均匀地分配到多个服务器上的技术。在读写分离场景中,可以采用以下负载均衡策略:

- **DNS轮询:**将客户端请求轮流分配到不同的从服务器。

- **反向代理:**使用反向代理服务器将请求转发到不同的从服务器。

- **客户端路由:**在客户端应用程序中实现路由逻辑,根据需要将请求路由到不同的从服务器。

**4.2 异地容灾和数据备份**

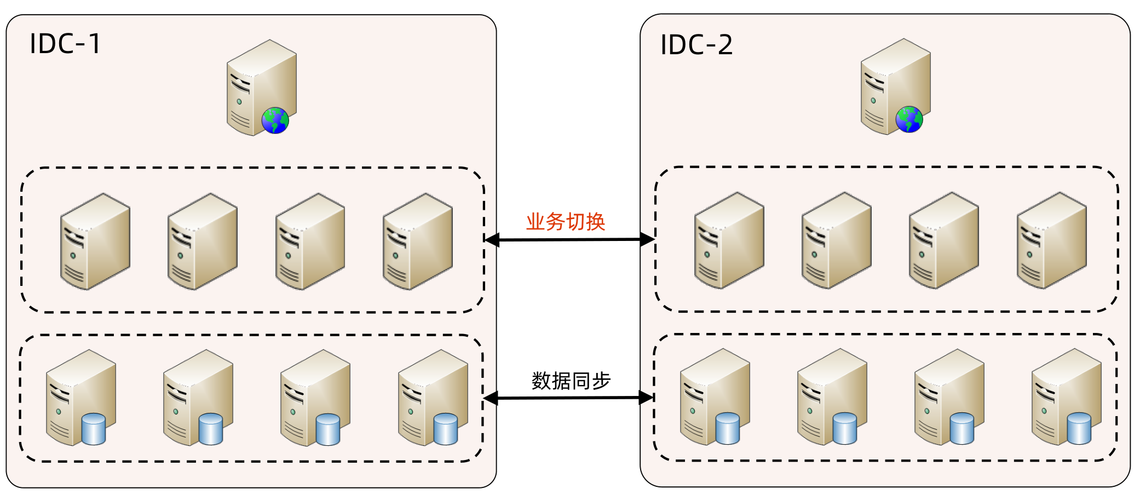

**4.2.1 异地容灾架构**

异地容灾是一种将数据和应用程序部署在不同地理位置的技术。这样可以避免单点故障,当一个数据中心发生故障时,另一个数据中心可以继续提供服务。

MySQL复制可以用于实现异地容灾。通过将主服务器和从服务器部署在不同的数据中心,可以确保数据在两个数据中心之间保持同步。当主服务器发生故障时,可以将其中一个从服务器提升为主服务器,从而继续提供服务。

**4.2.2 数据备份策略**

数据备份是一种定期将数据复制到其他存储介质上的技术。这样可以防止数据丢失,当数据发生损坏或丢失时,可以从备份中恢复数据。

MySQL复制可以用于实现数据备份。通过将主服务器的数据同步到从服务器,可以将从服务器作为备份服务器。当主服务器发生故障时,可以从备份服务器恢复数据。

**代码示例:**

```

# 配置主服务器

CHANGE MASTER TO

MASTER_HOST='192.168.1.100',

MASTER_USER='repl',

MASTER_PASSWORD='repl_password',

MASTER_PORT=3306,

MASTER_LOG_FILE='mysql-bin.000001',

MASTER_LOG_POS=456;

# 配置从服务器

CHANGE REPLICATION SOURCE TO

SOURCE_HOST='192.168.1.100',

SOURCE_USER='repl',

SOURCE_PASSWORD='repl_password',

SOURCE_PORT=3306;

```

**逻辑分析:**

上述代码配置了主从复制关系。主服务器将数据变更同步到从服务器,从服务器上的数据与主服务器保持一致。

**参数说明:**

- `MASTER_HOST`:主服务器的IP地址或主机名。

- `MASTER_USER`:主服务器的复制用户。

- `MASTER_PASSWORD`:主服务器的复制用户密码。

- `MASTER_PORT`:主服务器的端口号。

- `MASTER_LOG_FILE`:主服务器的二进制日志文件。

- `MASTER_LOG_POS`:主服务器的二进制日志位置。

- `SOURCE_HOST`:从服务器的IP地址或主机名。

- `SOURCE_USER`:从服务器的复制用户。

- `SOURCE_PASSWORD`:从服务器的复制用户密码。

- `SOURCE_PORT`:从服务器的端口号。

**mermaid流程图:**

```mermaid

graph LR

subgraph 主服务器

A[主服务器]

end

subgraph 从服务器

B[从服务器]

end

A --> B

```

# 5. MySQL复制性能优化

### 5.1 复制延迟优化

#### 5.1.1 减少网络延迟

**优化方法:**

1. **优化网络拓扑结构:**将主从服务器放置在同一局域网内,减少网络跳数和延迟。

2. **使用高速网络:**使用千兆以太网或万兆以太网等高速网络连接,提高数据传输速度。

3. **配置网络QoS:**为复制流量分配更高的优先级,确保其在网络拥塞时优先传输。

#### 5.1.2 优化服务器配置

**优化方法:**

1. **调整innodb_flush_log_at_trx_commit参数:**将该参数设置为2,减少事务提交时的日志刷新次数,提高写入性能。

2. **调整innodb_io_capacity参数:**设置该参数为服务器的I/O容量,避免I/O瓶颈。

3. **使用SSD存储:**使用固态硬盘(SSD)作为数据库存储,提高I/O性能。

### 5.2 复制带宽优化

#### 5.2.1 使用并行复制

**优化方法:**

1. **启用并行复制:**在主服务器上启用并行复制,允许多个线程同时执行复制任务,提高复制速度。

2. **调整并行复制线程数:**根据服务器资源和网络带宽,调整并行复制线程数,优化性能。

#### 5.2.2 压缩复制数据

**优化方法:**

1. **启用复制数据压缩:**在主服务器上启用复制数据压缩,减少复制数据的大小,降低网络带宽占用。

2. **选择合适的压缩算法:**根据复制数据类型和网络带宽,选择合适的压缩算法,如zlib、lz4等。

**代码示例:**

```

# 启用并行复制

CHANGE MASTER TO MASTER_HOST='192.168.1.100', MASTER_USER='repl', MASTER_PASSWORD='repl_pass', MASTER_PORT=3306, MASTER_AUTO_POSITION=1, MASTER_CONNECT_RETRY=10, MASTER_DELAY=0, MASTER_HEARTBEAT_PERIOD=10, MASTER_SSL=1, MASTER_SSL_CA='/path/to/ca.pem', MASTER_SSL_CERT='/path/to/cert.pem', MASTER_SSL_KEY='/path/to/key.pem', MASTER_SSL_CIPHER='DHE-RSA-AES256-SHA';

# 启用复制数据压缩

SET GLOBAL binlog_transaction_dependency_tracking=COMMIT_ORDER;

SET GLOBAL binlog_transaction_compression=zlib;

```

# 6.1 搭建高可用MySQL集群

### 需求分析

在实际生产环境中,为了保证数据库系统的稳定性和可靠性,需要搭建高可用的MySQL集群。高可用集群可以保证在发生故障时,数据库系统仍然能够继续提供服务,避免数据丢失和服务中断。

### 架构设计

高可用MySQL集群一般采用主从复制架构,其中一台服务器作为主服务器,负责处理写入操作,并将其复制到多台从服务器上。从服务器负责处理读操作,减轻主服务器的压力。

### 主从复制配置

**主服务器配置**

```

# 启用二进制日志

log-bin=mysql-bin

# 设置服务器ID

server-id=1

# 设置复制账号

create user 'repl'@'%' identified by 'password';

grant replication slave on *.* to 'repl'@'%';

```

**从服务器配置**

```

# 设置服务器ID

server-id=2

# 设置主服务器地址和端口

master_host=192.168.1.100

master_port=3306

# 设置复制账号

user='repl'

password='password'

```

### 集群管理

搭建好高可用集群后,需要进行集群管理,包括:

* **监控复制状态:**使用 `show slave status` 命令查看复制状态,确保复制正常进行。

* **故障转移:**当主服务器发生故障时,需要将其中一台从服务器提升为主服务器,以保证服务不中断。

* **数据同步:**当从服务器出现故障时,需要将其重新同步到主服务器上,以确保数据一致性。

### 优点

高可用MySQL集群具有以下优点:

* **高可用性:**在发生故障时,集群能够自动切换到备用服务器,保证服务不中断。

* **负载均衡:**从服务器可以分担主服务器的读操作压力,提高系统性能。

* **数据冗余:**数据被复制到多台服务器上,保证了数据的安全性。

0

0