Java并发控制的艺术:线程池与锁协同机制详解

发布时间: 2024-10-19 11:23:42 阅读量: 17 订阅数: 27

# 1. Java并发基础回顾

并发编程是Java语言的核心特性之一,它允许程序在多核处理器上高效地同时执行多个操作。本章将回顾Java并发编程的基础知识,为后续章节的深入探讨奠定理论基础。

## 1.1 Java内存模型

Java内存模型定义了多线程之间共享变量的可见性、原子性和有序性规则。理解内存模型是掌握并发控制的前提。

## 1.2 线程的状态和生命周期

Java线程从创建到终止会经历多种状态:新建、就绪、运行、阻塞和死亡。这些状态的转换是线程同步机制设计的关键。

## 1.3 同步机制

同步机制保证了多线程环境下数据的一致性。在Java中,synchronized关键字和volatile关键字是实现同步的两个主要工具。

要真正理解和应用并发编程,需要深入学习这些基础概念。接下来的章节,我们将在此基础上进一步探讨Java中的线程池和锁机制。

# 2. 线程池的理论与实现

### 2.1 线程池的概念和作用

#### 2.1.1 线程池的定义

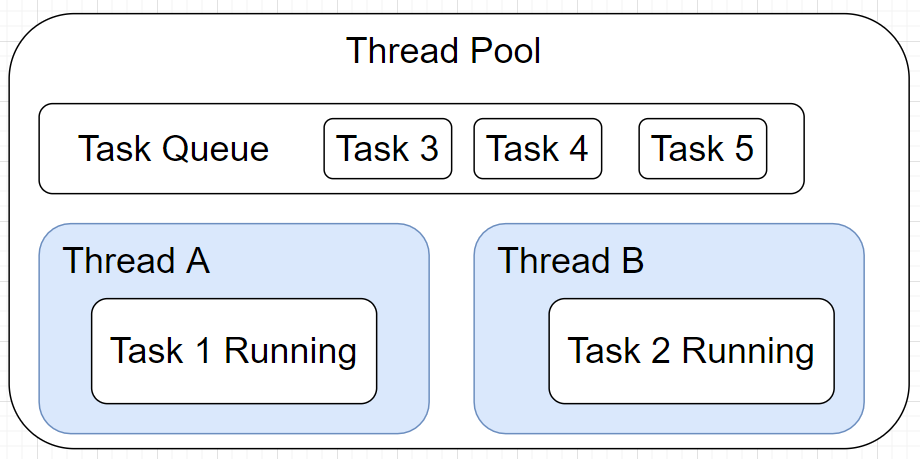

线程池是一种多线程处理形式,它通过预创建一定数量的线程,实现对任务的快速处理。线程池中的线程可以反复使用,它们在任务完成后并不立即销毁,而是等待着被再次调用。这种方式有效地减少了线程创建和销毁的开销,避免了频繁地分配和回收内存。

线程池的结构主要包括以下几个部分:

- **线程池管理器(ThreadPool)**:用于创建并管理线程池,包括线程的创建、任务的分配、执行等。

- **工作线程(Worker Thread)**:线程池中的线程,用来执行具体任务。

- **任务接口(Task)**:表示一个将要执行的作业,通常是一个实现了Runnable或Callable接口的类实例。

- **任务队列(Task Queue)**:用于存放待执行的任务,不同的线程池实现可能会使用不同类型的队列。

#### 2.1.2 线程池的优势

线程池的主要优势体现在以下几个方面:

- **资源复用**:通过重用线程,减少了线程创建和销毁所带来的系统开销。

- **控制并发数**:线程池可以有效控制并发线程的数量,避免过多线程造成系统资源耗尽。

- **管理简单**:线程池提供了一种快速处理大量任务的方式,简化了任务管理。

- **提供异步处理能力**:线程池可以用来执行一些耗时操作,而不阻塞调用者。

### 2.2 Java中的线程池实现

#### 2.2.1 ThreadPoolExecutor详解

`ThreadPoolExecutor`是Java中实现线程池的核心类,它提供了丰富的构造方法和参数配置,允许开发者根据需要创建不同类型的线程池。以下是`ThreadPoolExecutor`的基本使用方法:

```java

ThreadPoolExecutor executor = new ThreadPoolExecutor(

corePoolSize, // 核心线程数

maximumPoolSize, // 最大线程数

keepAliveTime, // 非核心线程空闲存活时间

TimeUnit.TimeUnit, // 时间单位

new LinkedBlockingQueue<Runnable>(), // 工作队列

new ThreadPoolExecutor.CallerRunsPolicy() // 拒绝策略

);

```

参数说明:

- `corePoolSize`:核心线程数,即使它们是空闲的,也会保留在池中等待任务。

- `maximumPoolSize`:池中允许的最大线程数。

- `keepAliveTime`:当线程数超出核心线程数时,非核心线程的保持存活时间。

- `TimeUnit`:`keepAliveTime`的时间单位。

- `LinkedBlockingQueue`:阻塞队列,用于存放等待执行的任务。

- `CallerRunsPolicy`:拒绝策略,当线程池无法接受新任务时,它会将任务返回给调用者执行。

`ThreadPoolExecutor`提供了灵活的任务处理能力,可以自定义任务队列、线程工厂、拒绝策略等。

#### 2.2.2 ForkJoinPool的应用

`ForkJoinPool`是Java提供的另一种特殊的线程池,专为执行可以递归拆分的任务而设计。它采用了“工作窃取”算法,能高效地利用处理器资源。`ForkJoinPool`特别适用于执行可以分而治之的并行任务,如大数据集的处理。

使用`ForkJoinPool`的基本示例:

```java

ForkJoinPool forkJoinPool = new ForkJoinPool();

forkJoinPool.execute(new FibonacciTask(30)); // 执行一个计算斐波那契数的任务

```

斐波那契数任务`FibonacciTask`是一个实现了`RecursiveTask`接口的自定义类,它能够将自身拆分为更小的任务来执行。

### 2.3 线程池的参数配置与优化

#### 2.3.1 核心参数的作用和调整

线程池的核心参数包括核心线程数、最大线程数、存活时间、工作队列等。合理配置这些参数对于提升线程池的性能至关重要。核心线程数通常设置为CPU的核心数,以充分利用CPU资源。最大线程数则根据任务类型和系统负载来设置,避免过多线程导致上下文切换增加。

工作队列的选择也很重要,常见的队列类型包括:

- `LinkedBlockingQueue`:基于链表的阻塞队列,无界,可缓存大量任务。

- `ArrayBlockingQueue`:基于数组的有界阻塞队列,适用于限制队列大小。

- `SynchronousQueue`:一个不存储元素的阻塞队列,提交的任务必须立即执行。

调整这些参数可以帮助线程池更好地适应不同场景的需求。

#### 2.3.2 性能调优技巧

线程池的性能调优涉及多个方面,包括任务分配策略、线程创建策略和饱和处理策略。以下是一些调优技巧:

- **合理配置线程数**:根据任务类型和系统负载调整核心线程数和最大线程数。

- **使用合适的队列**:根据任务特性和系统资源选择适合的工作队列。

- **实现自定义拒绝策略**:当线程池无法接受新任务时,应有合理的拒绝策略处理。

- **优化任务处理**:对于任务执行时间差异较大的情况,考虑分拆大任务或合并小任务。

- **监控和调整**:通过监控线程池状态和性能指标来不断调整和优化配置。

通过这些调优手段,可以有效提升线程池的处理能力和系统整体性能。

# 3. ```

# 第三章:锁的机制与分类

锁是并发编程中的核心概念,旨在保证在多线程环境下对共享资源的安全访问。理解锁的机制和分类对于设计高性能、高可靠性的并发程序至关重要。

## 3.1 锁的理论基础

### 3.1.1 锁的定义和目的

锁是一种同步机制,用于控制多个线程对共享资源的访问顺序。其目的在于防止数据竞争(race condition),确保数据的一致性和完整性。当多个线程尝试访问同一资源时,锁会保证一次只有一个线程可以执行访问操作,其他线程则需等待,直到锁被释放。

### 3.1.2 锁的分类概述

```

0

0