大数据框架对决:MapReduce与Spark优劣全面分析

发布时间: 2024-12-20 20:50:02 阅读量: 5 订阅数: 8

大数据实验5实验报告:MapReduce 初级编程实践

# 摘要

随着数据量的爆炸性增长,大数据处理框架成为了现代数据科学的核心。本文首先对大数据处理框架进行了概述,然后详细探讨了MapReduce的工作原理和编程模型,并分析了其优势与局限性。随后,本文转向了Spark,描述了其核心架构、编程模型,并着重强调了其性能优势。通过对比研究MapReduce与Spark的性能、应用场景及生态系统,本文揭示了两者在现代大数据处理中的不同定位和适用场景。最后,本文展望了大数据处理技术的未来方向,探讨了MapReduce和Spark的潜在演进路径,特别是在云原生架构和人工智能融合方面的发展潜力。

# 关键字

大数据处理;MapReduce;Spark;性能对比;生态系统;未来趋势

参考资源链接:[MapReduce编程实践:文件合并与去重实验](https://wenku.csdn.net/doc/3t1idgwi78?spm=1055.2635.3001.10343)

# 1. 大数据处理框架概述

在这个信息爆炸的时代,数据量呈指数级增长。为了从海量数据中提取有价值的信息,大数据处理框架应运而生。这些框架通过分布式计算,处理大规模数据集。本文将对这些框架进行概览,从MapReduce的历史起源讲起,过渡到当下流行的Spark处理模型,再到两者之间的比较,最后展望未来的大数据处理趋势。

大数据处理框架的核心在于利用集群中的多个计算节点,并行处理和分析数据。这种并行处理不仅缩短了处理时间,而且提高了数据处理能力。本文的目标是为IT行业的专业人士提供一个清晰的大数据处理框架概览,让他们能够根据不同的应用场景,选择合适的技术。让我们开始深入了解大数据处理框架的奥秘吧。

# 2. MapReduce的工作原理与实践

## 2.1 MapReduce的基本概念

### 2.1.1 MapReduce的起源和发展

MapReduce是一个由Google提出的编程模型,用于简化大规模数据集的并行运算。它最初由Google工程师Jeff Dean和Sanjay Ghemawat在2004年的一篇论文中提出,此后迅速成为处理大数据的关键技术之一。MapReduce模型特别适合于需要处理的数据分布在多个机器上的场合,因此它成为了Hadoop框架的核心组件之一。

Hadoop是一个开源的分布式存储与计算平台,它模仿了Google内部的一些系统设计,最初由Doug Cutting于2005年发起。Hadoop实现了MapReduce编程模型,支持处理PB级别的数据量,可以部署在由廉价硬件构成的集群上。

MapReduce框架通过自动并行化和分发任务到集群上,使得开发者无需关心底层的分布式计算细节。开发者只需关注于编写Map函数和Reduce函数。Map函数处理输入数据,产生中间数据,而Reduce函数则对中间数据进行合并处理。

随着技术的演进,虽然MapReduce在处理大规模数据时仍然很有效,但是它的局限性也逐渐显现,比如处理延迟较高,不能很好支持复杂的多阶段处理任务。这促使了像Apache Spark这样新一代的大数据处理框架的出现,它们提供更灵活的数据处理模式和更好的性能。

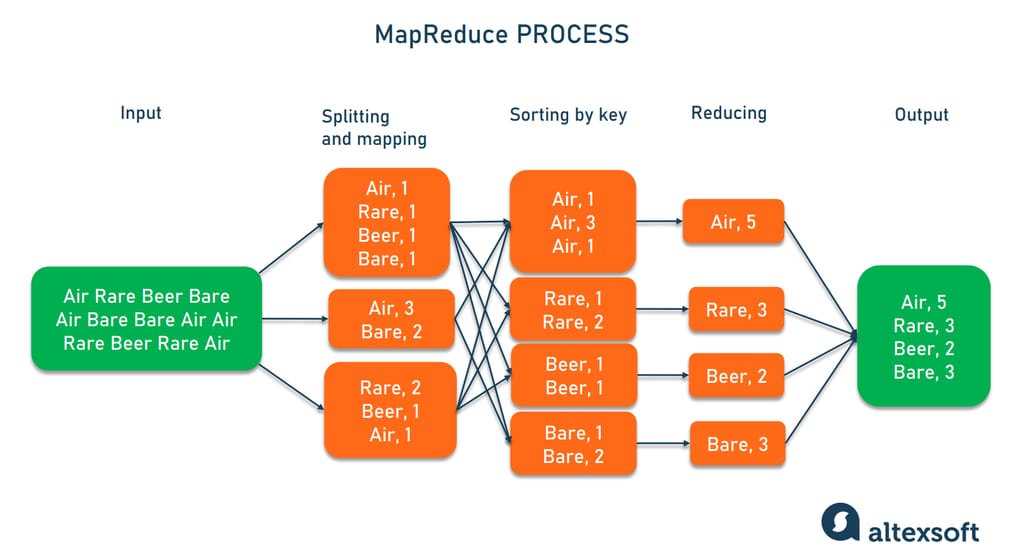

## 2.1.2 MapReduce的核心组件和工作流程

MapReduce框架主要由三个核心组件构成:JobTracker、TaskTracker和Task。

- **JobTracker**:负责整个作业的调度和管理,将任务分配给TaskTracker。

- **TaskTracker**:在集群中每个节点运行,负责执行由JobTracker分配的任务,并向JobTracker报告任务状态。

- **Task**:是实际执行工作负载的基本单元,包括Map任务和Reduce任务。

MapReduce的工作流程大致如下:

1. **输入阶段**:用户程序提交一个MapReduce作业给JobTracker,输入数据被切分成固定大小的块(通常为64MB或128MB),存储在HDFS上。

2. **Map阶段**:JobTracker将输入数据的块分配给可用的TaskTracker,TaskTracker再将任务分配给各个Map任务。Map函数处理输入数据块,执行用户自定义的Map逻辑,产生一系列中间键值对(key-value pairs)。

3. **Shuffle阶段**:框架负责将Map输出的所有中间键值对根据键(key)进行排序,保证具有相同键的所有值(values)都被分发到同一个Reduce任务。

4. **Reduce阶段**:Map输出的中间数据被传输到指定的Reduce任务所在的TaskTracker。Reduce任务接收具有相同键的所有值,并调用Reduce函数对它们进行合并处理。

5. **输出阶段**:Reduce函数处理完所有中间数据后,其输出结果被写入HDFS,供后续使用或进一步分析。

MapReduce的这种分而治之的方法简化了大数据处理流程,允许开发者专注于编写业务逻辑而不是分布式计算的细节。它在Hadoop生态系统中有着广泛的应用,是许多大数据应用的基础。

## 2.2 MapReduce的编程模型

### 2.2.1 Map和Reduce函数的实现

在MapReduce编程模型中,开发者需要实现两个关键的函数:Map函数和Reduce函数。

- **Map函数**:处理原始数据,转换为中间键值对。它通常执行以下操作:

1. 读取输入数据块。

2. 执行用户自定义的处理逻辑,将输入数据转换为键值对。

3. 输出键值对到一个缓冲区中。

下面是一个简单的Map函数的示例代码:

```java

public static class MyMapClass extends Mapper<LongWritable, Text, Text, IntWritable> {

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 这里假设我们正在处理文本文件,并将每个单词作为键,出现次数作为值。

String[] words = value.toString().split("\\s+");

for (String word : words) {

context.write(new Text(word), new IntWritable(1));

}

}

}

```

- **Reduce函数**:接收具有相同键的所有值,执行归并操作。它通常执行以下操作:

1. 从Map阶段接收键和值的列表。

2. 根据键将这些值进行归并或计算统计结果。

3. 输出最终的键值对。

以下是一个简单的Reduce函数的示例代码:

```java

public static class MyReduceClass extends Reducer<Text, IntWritable, Text, IntWritable> {

pub

```

0

0