信用风险控制中的机器学习算法比较分析

发布时间: 2024-09-03 03:00:46 阅读量: 296 订阅数: 68

机器学习-使用机器学习算法进行银行客户风险评估.zip

# 1. 信用风险控制与机器学习概述

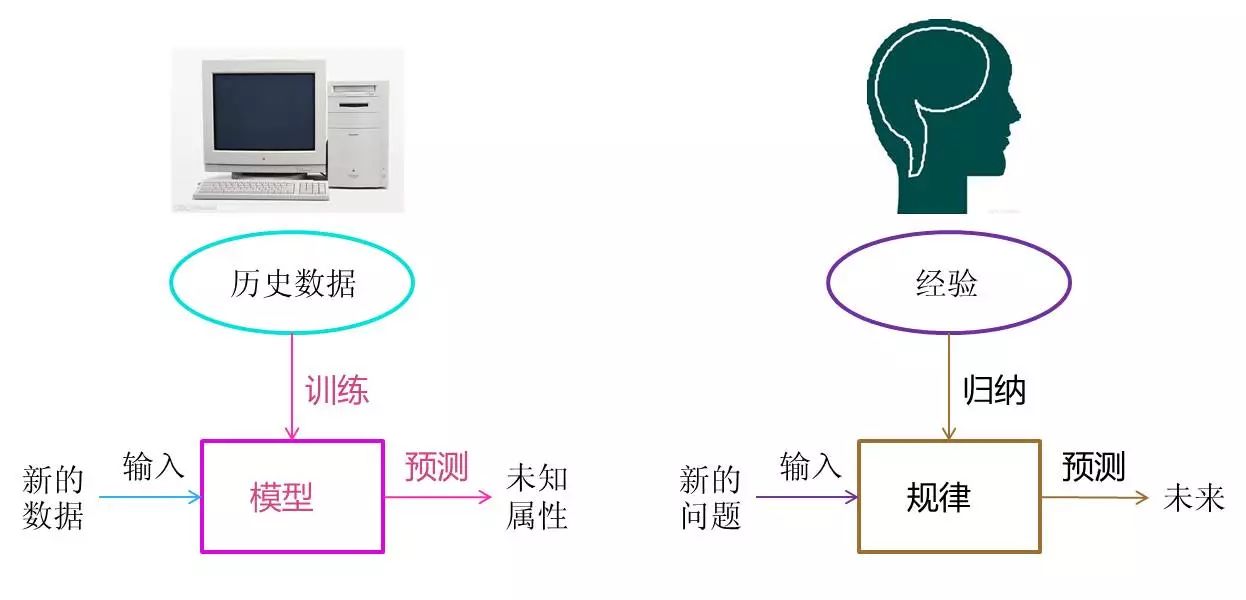

信用风险控制是金融领域中至关重要的环节,机器学习技术的应用为这一领域带来了革命性的变革。机器学习,作为一种人工智能的技术,可以高效地处理大量数据,识别出潜在的信用风险,这对于银行、信贷机构乃至整个金融生态系统的健康运行具有深远的影响。

在信用风险控制的背景下,机器学习模型通过分析历史数据来预测未来的信贷违约概率。这些模型能够从复杂的金融交易中提取模式和特征,这通常是人类专家难以捕捉的。例如,它们可以从成千上万的交易记录中识别出那些预示着潜在信用风险的行为模式,比如异常的消费习惯、收入水平的突变或其它关键的生活变化。

机器学习在信用风险控制中的应用不仅仅局限于违约预测。它还在信贷审批流程中发挥着重要作用,通过自动化决策过程来提高效率和精确性。在本章的后续部分,我们将深入探讨基础的机器学习算法理论,并分析它们在信用风险控制中的具体应用。接下来,我们将揭开机器学习神秘面纱,理解其核心算法,并探讨它们如何改善信用风险评估的准确性和效率。

# 2. 基础机器学习算法理论分析

## 2.1 监督学习算法简介

监督学习是机器学习领域中的一种主要方法,它涉及从标记的训练数据中学习一个模型,该模型能够预测目标变量的值。在此过程中,模型会尝试找到输入数据和输出数据之间的关系。常见的监督学习算法包括逻辑回归、决策树、支持向量机等。本节将深入探讨逻辑回归和决策树算法的原理及其在信用风险控制中的应用。

### 2.1.1 逻辑回归的原理与应用

逻辑回归是用于二分类问题的广泛算法,它以sigmoid函数作为激活函数,将线性回归的输出映射到(0,1)区间,从而得到概率预测。该模型的参数可以通过极大似然估计来优化。

在信用风险控制中,逻辑回归常用于客户违约概率的预测。通过历史数据,我们可以训练出一个模型,当输入客户的个人资料、财务状况等特征时,模型将输出客户违约的概率。

逻辑回归模型的优缺点如下:

- **优点**:模型简单、易于理解和实施,计算成本低。

- **缺点**:对于非线性问题的处理能力有限。

下面展示一个使用Python中的scikit-learn库进行逻辑回归模型训练的示例代码。

```python

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 假设 X 是特征矩阵,y 是标签

X, y = load_your_data() # 加载数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 实例化逻辑回归模型

logreg = LogisticRegression()

# 训练模型

logreg.fit(X_train, y_train)

# 预测测试集结果

y_pred = logreg.predict(X_test)

# 计算准确率

print("Accuracy:", accuracy_score(y_test, y_pred))

```

在此代码中,`train_test_split` 函数用于将数据集分为训练集和测试集。`LogisticRegression` 类创建逻辑回归模型实例并使用训练数据拟合模型。最终使用 `accuracy_score` 函数计算模型在测试集上的准确率。

### 2.1.2 决策树与随机森林的差异及选择

决策树是一种简单直观的监督学习算法,它通过一系列问题来构建决策规则,并基于问题的答案进行分类。决策树易于理解和解释,但容易过拟合。

随机森林是一种集成学习方法,它构建多个决策树并将它们的预测结果进行汇总。随机森林在许多问题上表现优异,并能够减少过拟合。

在信用风险控制中,随机森林可用于从复杂的数据中提取重要的特征,提高分类的准确性。比较决策树和随机森林,选择时应考虑模型的性能、复杂度和计算资源的可用性。

下面是一个使用scikit-learn库实现随机森林分类器的代码示例。

```python

from sklearn.ensemble import RandomForestClassifier

# 实例化随机森林模型

rf = RandomForestClassifier(n_estimators=100, random_state=42)

# 训练模型

rf.fit(X_train, y_train)

# 预测测试集结果

y_pred_rf = rf.predict(X_test)

# 计算准确率

print("Random Forest Accuracy:", accuracy_score(y_test, y_pred_rf))

```

在此代码中,`RandomForestClassifier` 类被用来创建随机森林模型实例,并利用训练数据进行拟合。然后在测试集上进行预测并计算准确率。通过比较逻辑回归和随机森林在测试集上的准确率,我们可以决定哪个模型更适合当前的问题。

## 2.2 无监督学习算法探究

无监督学习不依赖于标记的数据,而是试图在未标记的数据中找出隐藏的结构和模式。聚类和关联规则学习是无监督学习中的两种重要技术。本节将详细介绍K-Means和层次聚类算法,并探讨关联规则学习中的Apriori算法。

### 2.2.1 聚类算法:K-Means与层次聚类比较

聚类是将相似的对象分组在一起的过程。K-Means和层次聚类是两种常见的聚类方法。

- **K-Means算法**:该算法通过随机选择k个点作为聚类中心,然后迭代地将每个点分配到最近的聚类中心,并更新聚类中心的位置,直到收敛。

- **层次聚类算法**:该方法通过构建一个树状的聚类层次来展现数据点间的相似性,然后根据需要从层次结构中剪切得到聚类结果。

在信用风险控制中,聚类可用于识别相似的客户群体或交易行为,为信用评分提供辅助信息。

以下是使用Python实现K-Means聚类的代码示例:

```python

from sklearn.cluster import KMeans

# 假设 X 是需要进行聚类的数据集

X = get_your_data()

# K-Means模型实例化

kmeans = KMeans(n_clusters=3, random_state=42)

# 拟合模型并获取聚类标签

labels = kmeans.fit_predict(X)

# 输出聚类中心和对应的聚类标签

print("Cluster centers:\n", kmeans.cluster_centers_)

print("Labels:", labels)

```

在这个代码中,`KMeans` 类创建一个K-Means聚类模型实例,并用数据集 `X` 进行拟合,从而获得聚类结果。聚类中心和每个数据点的聚类标签都可以通过模型对象直接访问。

对于层次聚类,可以使用以下代码:

```python

from sklearn.cluster import AgglomerativeClustering

# 层次聚类模型实例化

hierarchical = AgglomerativeClustering(n_clusters=3)

# 拟合模型并获取聚类标签

labels_hierarchical = hierarchical.fit_predict(X)

# 输出聚类标签

print("Labels (Hierarchical):", labels_hierarchical)

```

在上述代码中,`AgglomerativeClustering` 类被用来构建一个层次聚类模型实例,通过拟合数据 `X` 得到层次聚类的标签。

### 2.2.2 关联规则学习与Apriori算法

关联规则学习旨在发现在大型事务数据集中不同变量之间的有趣关系,如频繁出现的模式、关联和相关性。在信用风险评估中,关联规则可用于分析客户交易行为和信用记录之间的潜在联系。

Apriori算法是一种经典的关联规则学习算法,它通过迭代方式,逐层搜索频繁项集,然后从频繁项集中导出强规则。

以下是一个使用Apriori算法分析信用风险中交易数据的简化例子:

```python

from mlxtend.frequent_patterns import apriori

from mlxtend.preprocessing import TransactionEncoder

# 假设 transactions 是交易数据集的列表,每个元素是交易中包含的商品列表

transactions = [['商品1', '商品2'],

['商品2', '商品3'],

['商品1', '商品3'],

['商品2', '商品3']]

# 将交易数据转换为独热编码格式

te = TransactionEncoder()

te_ary = te.fit(transactions).transform(transactions)

df = pd.DataFrame(te_ary, columns=te.columns_)

# 使用Apriori算法找出频繁项集

frequent_itemsets = apriori(df, min_support=0.5, use_colnames=True)

# 输出频繁项集

print("Frequent Itemsets:")

print(frequent_itemsets)

# 根据频繁项集导出关联规则

from mlxtend.frequent_patterns import association_rules

rules = association_rules(frequent_itemsets, metric="confidence", min_threshold=0.7)

print("\nRules:")

print(rules)

```

在这个代码段中,`TransactionEncoder` 类用于将交易数据转换为布尔型独热编码格式,然后使用 `apriori` 函数挖掘频繁项集。最后,我们通过 `association_rules` 函数导出关联规则。这里设置了最小支持度为0.5(表示项集出现的频率),最小置信度为0.7(表示规则的强度)。

## 2.3 强化学习在信用风险控制中的潜力

强化学习是机器学习的一个分支,它关注的是如何基于环境采取行动,以取得最大的累积奖励。在信用风险控制中,强化学习可以用于决策过程,比如确定贷给客户多少额度以及何时进行信贷审查。

### 2.3.1 马尔可夫决策过程

马尔可夫决策过程(MDP)是强化学习中的核心概念,它是一个决策过程的数学模型。MDP主要由状态、动作、奖励和转移概率四个元素构成。

- **状态**:系统的当前状况。

- **动作**:决策者可以执行的行为。

- **奖励**:根据状态和动作得到的即时反馈。

- **转移概率**:执行动作后系统转移到下一个状态的概率。

在信用风险管理中,可以利用MDP来确定最优的信贷策略。比如,根据客户的信用历史和当前风险评估来决定是否批准贷款,以及批准多少额度。

### 2.3.2 Q-learning与Deep Q-Network

Q-learning是一种基于值的强化学习算法,它用于学习在给定状态下采取特定动作的预期回报。Q-learning不需要模型来预测环境如何变化,直接通过试错来学习Q值函数,然后利用Q值函数选择最优动作。

Deep Q-Network(DQN)是将Q-learning与深度学习相结合的方法,它通过深度神经网络来近似Q值函数。DQN在处理高维状态空间的问题时表现更加出色。

DQN在信用风险管理中的应用可能包括优化贷款审批流程,通过考虑大量的客户特征和历史数据来做出更加精准的信贷决策。

下面是一个简化的Q-learning算法实现的例子:

```python

import numpy as np

import random

# 初始化Q表

q_table = np.zeros((env.observation_space.n, env.action_space.n))

# 定义学习参数

learning_rate = 0.01

discount_factor = 0.9

exploration_rate = 1.0

max_episodes = 1000

# Q-learning算法主体

for episode in range(max_episodes):

state = env.reset()

done = False

while not done:

```

0

0