【Pandas新手必读】:10分钟内完成Pandas库的安装和验证

发布时间: 2024-12-07 02:56:34 阅读量: 21 订阅数: 18

python pandas库的安装和创建

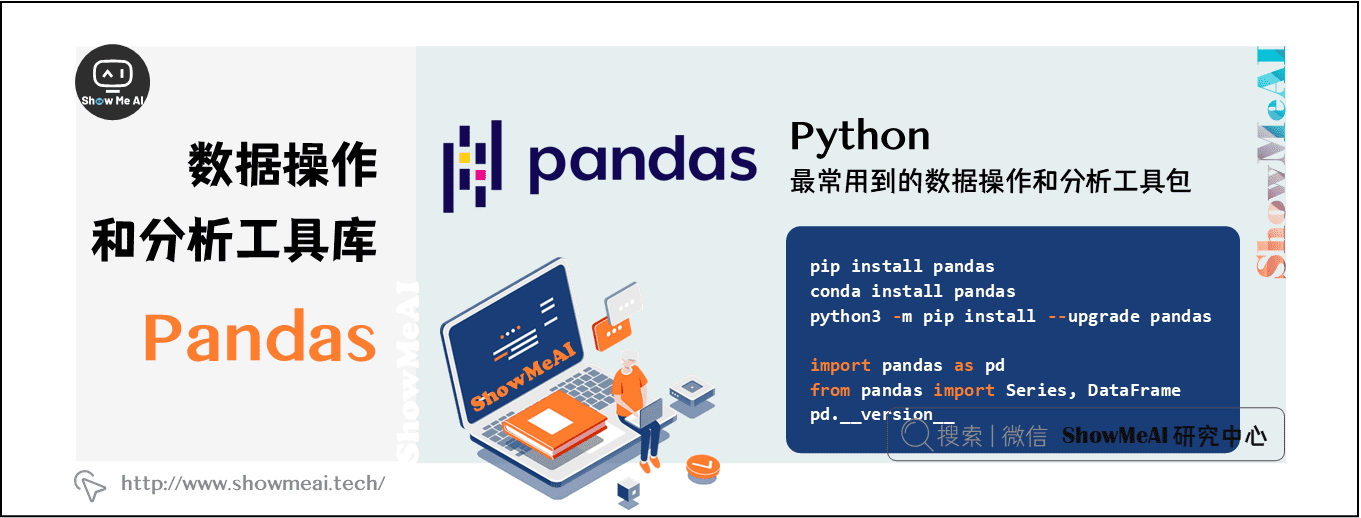

# 1. Pandas库快速入门

Python数据分析领域中,Pandas库已经成为数据处理的首选工具。它提供了大量快速、灵活和表达能力强的数据结构,专为数据分析设计。Pandas库的基础数据结构包括Series和DataFrame,它们能够处理不同类型的数据。本章节将介绍如何进行基础的数据结构操作,为之后更深层次的学习打下坚实的基础。

## 1.1 Pandas库概述

Pandas 是一个开源的 Python 数据分析库,它提供了高性能、易于使用的数据结构和数据分析工具。Pandas 的核心数据结构是 DataFrame,可以看作是一个表格或者说是 Excel 电子表格的一个单元格区域。DataFrame 能够容纳不同数据类型的列,并且它支持数据的插入、删除和假设的多维数组操作。

## 1.2 Pandas 基本操作

要使用 Pandas 库,首先需要导入相应的模块:

```python

import pandas as pd

```

以下是Pandas库中经常使用的几种基本操作:

- 创建 Series 和 DataFrame 对象

- 访问数据

- 修改数据

- 数据筛选

- 数据排序

Pandas 通过简洁的代码提供了强大的数据处理能力,例如创建一个简单的 Series:

```python

s = pd.Series([1, 3, 5, np.nan, 6, 8])

```

接着我们可以展示数据、获取数据描述、进行数据筛选等操作:

```python

print(s) # 输出数据

print(s.describe()) # 数据描述性统计

print(s[0]) # 数据筛选

```

通过以上步骤,我们已经迈出了使用 Pandas 库进行数据分析的第一步。对于初学者来说,Pandas 的易用性和功能强大性能够快速提升数据处理和分析的效率。对于更高级的数据操作和技巧,我们将在后续章节中进行详细讲解。

在掌握了Pandas库的基本概念和操作之后,你将能处理更多实际的数据问题,并逐渐深入到数据处理的高级应用之中。

# 2. Pandas环境搭建与配置

### 2.1 Pandas安装指南

在开始使用Pandas之前,确保你的Python环境已经搭建完成,并且具备了安装Pandas的能力。本节将会介绍如何在不同的操作系统上,通过pip这一Python包管理工具来安装Pandas,并进行安装后的验证。

#### 2.1.1 选择合适的Python环境

选择合适的Python环境是开始使用Pandas的第一步。你可以使用Python的官方版本或通过包管理器,如Anaconda或Miniconda来管理Python环境。Anaconda提供了一个完整的科学计算环境,而Miniconda则提供了一个更轻量级的版本,你可以根据自己的需要选择。

安装Anaconda或Miniconda后,推荐创建一个独立的环境用于Pandas的学习和实践,这样可以避免不同项目之间的依赖冲突。

#### 2.1.2 使用pip安装Pandas

安装好Python环境后,打开终端或命令提示符,输入以下命令来安装Pandas:

```bash

pip install pandas

```

对于使用Anaconda的用户,也可以使用conda命令来安装:

```bash

conda install pandas

```

#### 2.1.3 验证Pandas安装成功

安装完成后,需要验证Pandas是否安装成功。可以在Python解释器中输入以下代码:

```python

import pandas as pd

print(pd.__version__)

```

如果系统显示了Pandas的版本号,那么恭喜你,Pandas已经安装成功。

### 2.2 Pandas与Jupyter Notebook集成

Jupyter Notebook是一个开源的Web应用程序,允许用户创建和共享包含实时代码、方程、可视化和解释性文本的文档。Pandas与Jupyter Notebook的集成,使得数据探索和分析变得更加直观和简单。

#### 2.2.1 Jupyter Notebook简介

Jupyter Notebook支持多种编程语言,它使得代码的开发和运行更加直观。每一个notebook由多个单元格组成,每个单元格可以执行代码或者存放Markdown文本。

#### 2.2.2 在Jupyter中安装和配置Pandas

如果你尚未安装Jupyter Notebook,可以通过pip或conda安装:

```bash

pip install notebook

# 或者

conda install notebook

```

安装完成后,启动Jupyter Notebook:

```bash

jupyter notebook

```

打开一个新的notebook,并尝试导入Pandas来验证是否已经配置成功:

```python

import pandas as pd

```

如果没有任何错误提示,说明Pandas已经可以在Jupyter Notebook中使用了。

#### 2.2.3 创建并运行Pandas代码单元格

在Jupyter Notebook中,你可以通过点击工具栏上的“+”按钮来创建新的代码单元格,然后在单元格中输入Pandas代码。输入代码后,按下Shift+Enter键,即可运行当前单元格并自动跳转到下一个单元格。这是一个非常直观和灵活的方式来进行数据分析和探索。

### 2.3 理解Pandas数据结构

Pandas有三种主要的数据结构:Series、DataFrame和Index。理解这些数据结构是使用Pandas进行数据分析的基础。

#### 2.3.1 Series基础

Series是Pandas中的一维数组对象,它能够存储任意数据类型(整数、字符串、浮点数、Python对象等)。每个Series对象都有一个与之相关的数组,包含数据,还有一个与之相关的数据标签,被称为索引(index)。

一个Series的示例如下:

```python

import pandas as pd

s = pd.Series([1, 3, 5, np.nan, 6, 8])

print(s)

```

#### 2.3.2 DataFrame概念

DataFrame是Pandas中一个二维的、表格型的数据结构,可以看作是一个“表格”,其中包含一组有序的列,每列可以是不同的值类型(数值、字符串、布尔值等)。DataFrame既有行索引也有列索引,可以看作是Series对象的容器。

创建一个DataFrame的示例如下:

```python

data = {

'Country': ['USA', 'Germany', 'UK', 'France'],

'Population': [300, 200, 50, 100],

'Area': [20, 5, 10, 8]

}

df = pd.DataFrame(data)

print(df)

```

#### 2.3.3 Index对象介绍

Index对象是Pandas中的一个用于存储轴标签和其他元数据的对象。Index是不可变的,它支持多种数据类型(整数、字符串、时间序列等)。在Pandas中,无论是Series还是DataFrame,都有一个与之关联的Index对象。

获取Index对象的示例如下:

```python

s = pd.Series([1, 2, 3], index=['a', 'b', 'c'])

print(s.index)

```

以上就是Pandas环境搭建与配置的基本内容。在下一章,我们将继续深入了解Pandas的基本操作,包括数据的导入导出、探索与清洗以及数据选择与过滤等。

# 3. Pandas基本操作实践

## 3.1 数据导入与导出

### 3.1.1 从CSV导入数据

在数据分析中,数据的导入与导出是基础且核心的操作之一。Pandas库在处理CSV文件导入导出方面提供了强大的支持。

```python

import pandas as pd

# 从CSV导入数据到DataFrame

data = pd.read_csv('example.csv')

print(data.head()) # 查看前5行数据以确保导入正确

```

在上面的代码块中,我们使用了 `pd.read_csv()` 函数来导入CSV文件。该函数默认会读取文件的第一行作为列名,每行作为一条记录,并自动识别常见的数据格式。`head()` 函数用于返回DataFrame对象的前五行,以检查数据是否正确导入。

### 3.1.2 导出数据到CSV和Excel

导入数据之后,我们常常需要将处理后的数据导出,以便于进一步分析或用于报告。

```python

# 将数据导出到CSV文件

data.to_csv('output.csv', index=False)

# 将数据导出到Excel文件

data.to_excel('output.xlsx', sheet_name='Sheet1', index=False)

```

`to_csv()` 函数将DataFrame导出为CSV文件,`index=False` 参数避免将行索引作为一列导出。类似地,`to_excel()` 函数用于将数据导出到Excel格式,`sheet_name` 参数指定工作表的名称,`index=False` 同样避免导出行索引。

### 3.1.3 读取和保存数据的其他选项

Pandas支持多种文件格式的数据读取与保存,例如JSON、HTML、SQL等。每种格式都有其对应的函数,例如 `pd.read_json()` 和 `data.to_json()`。

```python

# 读取JSON文件

json_data = pd.read_json('data.json')

# 保存数据到JSON文件

json_data.to_json('data_out.json')

```

这里,我们用 `read_json()` 函数导入JSON格式的数据,并用 `to_json()` 函数将DataFrame保存为JSON格式。这些操作让数据在不同格式之间转换变得非常便捷,同时Pandas还提供了大量参数以适应不同场景下的需求。

## 3.2 数据探索与清洗

### 3.2.1 缺失值处理

在处理数据时,经常会遇到数据集中的缺失值,处理缺失值是数据清洗的一个重要步骤。

```python

# 检查数据中的缺失值

missing_values = data.isnull().sum()

# 删除包含缺失值的行

data_cleaned = data.dropna()

# 填充缺失值

data_filled = data.fillna(0) # 用0填充

```

我们使用 `isnull()` 函数来检查每个元素是否是缺失值,并用 `sum()` 函数统计每一列的缺失值数量。`dropna()` 函数可以删除包含任何缺失值的行,而 `fillna()` 函数则可以用来填充缺失值。

### 3.2.2 数据类型转换

数据类型对于后续的处理至关重要,Pandas提供了灵活的数据类型转换方法。

```python

# 将字符串转换为日期时间格式

data['date'] = pd.to_datetime(data['date'])

# 将数据类型转换为浮点数

data['float_column'] = data['float_column'].astype(float)

```

`to_datetime()` 函数可以将字符串转换为日期时间格式,这对时间序列分析非常有用。`astype()` 函数则用于转换数据类型,这里将某一列的数据类型转换为浮点数。

### 3.2.3 重复数据的识别和删除

重复数据会对数据分析和模型训练产生负面影响,因此需要识别和删除。

```python

# 检查重复数据

duplicates = data.duplicated()

# 删除重复数据

data_unique = data.drop_duplicates()

```

使用 `duplicated()` 函数可以返回一个布尔序列,表示每行是否重复。`drop_duplicates()` 函数则可以从DataFrame中删除重复的行。

## 3.3 数据选择与过滤

### 3.3.1 基于位置的数据选择

在Pandas中,可以通过位置索引直接访问数据。

```python

# 选择前5行数据

rows = data.iloc[:5]

# 选择第一列的所有数据

columns = data.iloc[:, 0]

```

`iloc` 是基于位置的索引器,使用行号和列号来选择数据。这种方式适用于不知道列名的情况下。

### 3.3.2 基于标签的数据选择

基于标签的数据选择方法则更加直观,因为可以直接使用列名。

```python

# 使用列名选择数据

column_data = data['column_name']

# 使用loc选择行和列

specific_data = data.loc[row_indexer, column_name]

```

`loc` 用于基于标签的数据选择,可以同时选择行和列。`row_indexer` 和 `column_name` 分别代表行索引和列名。

### 3.3.3 条件过滤和布尔索引

Pandas允许使用条件过滤数据,这在需要根据特定条件选择数据时非常有用。

```python

# 使用条件过滤数据

filtered_data = data[data['column_name'] > value]

# 使用布尔索引

boolean_filtered_data = data[(data['column_name1'] > value1) & (data['column_name2'] < value2)]

```

条件过滤通常与比较运算符一起使用,创建布尔序列。Pandas自动将这些布尔值应用到每一行上,返回满足条件的数据子集。多个条件可以通过 `&` (AND) 和 `|` (OR) 运算符组合。

以上是本章节的内容概览,接下来将进一步详细介绍每个操作的具体应用场景和技巧,使读者能够更加深刻地理解Pandas在数据操作中的强大能力。

# 4. Pandas高级应用技巧

在第三章中,我们已经掌握了Pandas库的基本操作,包括数据的导入导出、探索与清洗、选择与过滤等。这些技能为处理和分析数据打下了坚实的基础。进入第四章,我们将深入Pandas的高级应用技巧,包括数据聚合与分组操作、数据合并与重塑,以及数据可视化基础。

## 4.1 数据聚合与分组操作

### 4.1.1 聚合函数简介

聚合操作是对数据进行汇总计算的过程。Pandas中常见的聚合函数包括`sum()`, `mean()`, `median()`, `min()`, `max()`, 和`count()`等。这些函数可以直接应用于Series或DataFrame对象,并能够快速得到所需的数据统计信息。

```python

import pandas as pd

# 假设我们有一个DataFrame

df = pd.DataFrame({

'A': [1, 2, 3, 4],

'B': [10, 20, 30, 40]

})

# 使用聚合函数

result = df.agg(['sum', 'mean', 'median', 'min', 'max'])

print(result)

```

### 4.1.2 分组数据处理

分组操作允许我们根据某些标准将数据分组,并对每个组执行聚合函数。`groupby()` 方法是实现这一功能的关键。例如,如果我们想根据某个列的值对数据进行分组,并计算每个组的平均值,可以这样做:

```python

# 假设df是我们之前创建的DataFrame

# 按照'A'列的值分组,并计算'B'列的平均值

grouped = df.groupby('A')['B'].mean()

print(grouped)

```

### 4.1.3 使用apply函数

`apply()` 函数是Pandas中的一个强大工具,允许我们对DataFrame或Series应用自定义函数。它广泛用于进行复杂的数据转换。例如,我们可以创建一个自定义函数,然后使用`apply()`来应用它:

```python

def custom_function(x):

return x * 2

# 应用自定义函数到'A'列

df['A'] = df['A'].apply(custom_function)

print(df)

```

## 4.2 数据合并与重塑

### 4.2.1 DataFrame合并方法

在数据分析中,合并多个数据集是常见的操作。Pandas提供了多种合并DataFrame的方法,如`merge()`、`join()`和`concat()`等。每种方法适用于不同的场景:

- `merge()`通常用于基于一个或多个键将不同的DataFrame的行连接起来。

- `join()`默认基于索引来合并DataFrame,并且可以处理更复杂的连接操作。

- `concat()`用于沿着一个轴将多个对象堆叠到一起。

```python

# 生成示例数据

df1 = pd.DataFrame({'key': ['K0', 'K1', 'K2', 'K3'],

'A': ['A0', 'A1', 'A2', 'A3'],

'B': ['B0', 'B1', 'B2', 'B3']})

df2 = pd.DataFrame({'key': ['K0', 'K1', 'K2', 'K3'],

'C': ['C0', 'C1', 'C2', 'C3'],

'D': ['D0', 'D1', 'D2', 'D3']})

# 使用merge方法

merged_df = pd.merge(df1, df2, on='key')

print(merged_df)

```

### 4.2.2 重塑数据透视表

数据透视表是一种用于汇总和分析数据的方法,能够将数据以不同的形式进行重组。在Pandas中,`pivot_table()`函数用于创建数据透视表:

```python

# 使用pivot_table创建数据透视表

pivot = pd.pivot_table(df, values='B', index=['A', 'key'], aggfunc='sum')

print(pivot)

```

### 4.2.3 堆叠与展开操作

堆叠和展开是Pandas中用于重置DataFrame索引的有用技术。`stack()`方法用于将DataFrame从宽格式转换为长格式,而`unstack()`方法执行相反操作:

```python

# 将DataFrame堆叠

stacked_df = df.set_index(['A', 'key']).stack()

print(stacked_df)

# 将堆叠后的数据展开

unstacked_df = stacked_df.unstack()

print(unstacked_df)

```

## 4.3 数据可视化基础

### 4.3.1 使用matplotlib进行绘图

Pandas与matplotlib库紧密集成,使得数据可视化变得非常简单。任何Pandas对象都可以直接用`plot()`方法绘图:

```python

# 绘制'A'列的线性图表

df['A'].plot(kind='line')

```

### 4.3.2 Pandas内置绘图功能

除了与matplotlib集成外,Pandas还提供了自己的绘图接口,使得从数据操作到可视化更加流畅:

```python

# 使用Pandas内置方法绘制直方图

df['B'].hist()

```

### 4.3.3 高级可视化技巧

随着数据量的增大,内置的可视化功能可能不足以展示所有的信息。此时,可以采用更高级的可视化技巧,例如使用seaborn库,或者利用Pandas的`style`属性进行样式定制等:

```python

import seaborn as sns

# 使用seaborn进行高级绘图

sns.boxplot(x='A', y='B', data=df)

```

至此,我们已经详细探讨了Pandas库的高级应用技巧,包括数据聚合与分组操作、数据合并与重塑,以及数据可视化基础。在第五章,我们将通过一个完整的项目实战案例来综合运用这些技能。

# 5. Pandas项目实战案例

在之前的章节中,我们已经学习了Pandas库的基础知识,包括环境搭建、基本数据结构与操作,以及一些高级应用技巧。然而,真正的数据分析技能往往是在解决实际问题中磨练出来的。本章将通过一个实战案例,带领读者将Pandas应用到一个完整的数据分析项目中,进一步加深对Pandas的理解,并提供一些项目实施过程中的关键技巧和经验总结。

## 5.1 数据分析项目准备

### 5.1.1 确定项目目标和数据需求

项目实战的第一步是明确项目的最终目标。在这个阶段,我们需要回答以下几个问题:

- 我们希望解决的问题是什么?

- 需要哪些数据来解决这个问题?

- 数据需要满足什么质量标准?

例如,假设我们的项目目标是分析某个零售公司的销售数据,以发现销售趋势,优化库存管理和市场营销策略。那么,我们需要销售记录、顾客信息、产品目录等相关数据。

### 5.1.2 数据收集与初步处理

收集完所需数据后,我们进入数据初步处理阶段。这里需要完成以下几个任务:

- 数据清洗:处理缺失值、去除重复记录、修正错误。

- 数据转换:将数据转换为适合分析的格式,例如日期字段的标准化。

- 数据抽取:根据项目需求筛选出重要字段和记录。

例如,在处理销售数据时,我们可能需要剔除无效的销售记录,统一产品价格格式,并提取出重要的销售时间戳信息。

## 5.2 项目中的关键Pandas操作

### 5.2.1 复杂数据清洗技巧

在Pandas中,数据清洗通常涉及多个步骤,对于复杂的数据清洗任务,我们可以组合使用多个Pandas函数来高效完成。以下是一些关键操作:

- 使用 `pd.isnull()` 和 `dropna()` 处理缺失值。

- 使用 `pd.duplicated()` 检测并删除重复记录。

- 使用 `pd.to_datetime()` 转换数据类型,比如日期和时间。

- 使用正则表达式(`str.replace()`)进行文本数据清洗。

```python

# 示例:处理缺失值

df['price'] = df['price'].replace('[\$,]', '', regex=True).astype(float)

df.dropna(subset=['date'], inplace=True)

```

### 5.2.2 数据聚合分析实例

数据分析中不可或缺的部分是对数据的聚合与分组。Pandas提供了强大而灵活的数据聚合工具:

- `groupby()` 方法对数据进行分组。

- `agg()` 或 `apply()` 方法应用聚合函数。

- `pivot_table()` 进行数据重塑和汇总。

```python

# 示例:销售数据按月份和产品类别聚合分析

monthly_sales = df.groupby(['month', 'product_category']).agg({'sales': 'sum'})

```

### 5.2.3 数据可视化与报告生成

数据分析的结果需要通过可视化的方式展现给决策者,Pandas与matplotlib库的结合可实现这一目标:

- 使用 `df.plot()` 进行基本图表绘制。

- 使用 `plt.figure()` 等方法对图表进行高级自定义。

- 将分析结果整合到报告中,例如使用Jupyter Notebook。

```python

# 示例:绘制销售额趋势图

plt.figure(figsize=(10, 6))

df.groupby('date')['sales'].sum().plot(kind='line')

plt.title('Monthly Sales Trend')

plt.xlabel('Date')

plt.ylabel('Sales')

plt.show()

```

## 5.3 项目总结与反思

### 5.3.1 项目中的问题与解决方案

在实施数据分析项目的过程中,总会遇到各种预料之外的问题,如何解决这些问题是我们积累经验的重要途径。例如:

- 数据质量问题:如何处理不一致和不完整数据。

- 性能瓶颈:大型数据集处理时可能遇到的性能问题。

- 可视化效果不佳:如何选择正确的图表类型和样式提升可视化效果。

### 5.3.2 项目经验总结

数据分析项目结束后,我们应当回顾项目中的关键点,总结得失,为以后的项目打下更好的基础。

- 明确项目目标和数据需求的重要性。

- 灵活运用Pandas的数据处理功能。

- 注重数据可视化和沟通技巧在数据分析报告中的作用。

通过本章的内容,读者应能将Pandas的实用技能运用于一个完整的数据分析项目,同时在项目实践中不断学习和提高。希望本章能为你的数据分析之旅增添一份宝贵的实战经验。

0

0