Python爬虫中常见数据格式解析问题及解决方案

发布时间: 2024-04-16 10:08:47 阅读量: 131 订阅数: 46

python爬虫数据可视化分析大作业

# 1. Python爬虫基础概念

网络爬虫是一种可以自动访问互联网并获取信息的程序,在网页抓取、内容分析等方面发挥重要作用。其工作原理主要包括发送HTTP请求、解析HTML页面、提取数据等步骤。通过模拟用户浏览器的行为,爬虫能够获取网站上的数据,并将其保存或进一步处理。Python在爬虫领域应用广泛,拥有丰富的爬虫库和工具,如Beautiful Soup、lxml等,可以帮助开发者更便捷地进行数据采集和解析。掌握Python爬虫基础概念能够为后续深入学习和实践打下良好基础,对于从事网络数据抓取和分析的工作者来说,具有重要意义。

# 2. 数据解析基础知识

数据解析在网络爬虫中扮演着至关重要的角色,它能帮助爬虫程序有效地从网页中提取所需信息。本章将介绍数据解析的概念和常见的数据格式,以及如何使用Python处理这些数据格式。

#### 2.1 数据解析的概念和重要性

数据解析是指从各种数据源中提取所需信息,并将其转换成更容易分析和处理的格式的过程。在网络爬虫中,数据解析用于从网页中抽取结构化数据,如文本、图片、链接等,以便进行后续的分析和存储。

数据解析在爬虫中的重要性不言而喻,它直接影响着爬虫程序的效率和准确性。合理的数据解析方法可以帮助爬虫提高数据提取的准确性,同时也能降低数据处理的复杂度。

#### 2.2 常见的数据格式介绍

##### 2.2.1 JSON 数据格式

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,也易于机器解析和生成。它常用于前端与后端之间的数据交互。

###### 2.2.1.1 JSON 格式简介

JSON由键值对组成,数据格式为`{"key": "value"}`,其中键值对之间用逗号分隔。例如:

```json

{

"name": "Alice",

"age": 30,

"city": "New York"

}

```

###### 2.2.1.2 使用Python处理JSON数据的方法

Python内置了json模块,可以方便地处理JSON数据。以下是一个简单的例子:

```python

import json

# JSON字符串

json_str = '{"name": "Bob", "age": 25}'

# 将JSON字符串转换为字典

data = json.loads(json_str)

print(data['name']) # 输出: Bob

```

##### 2.2.2 XML 数据格式

XML(eXtensible Markup Language)是一种可扩展标记语言,用于存储和传输数据。它被广泛应用于各种领域,如网页开发、数据交换等。

###### 2.2.2.1 XML 格式简介

XML使用自定义标记来描述数据的结构,具有良好的可读性。例如:

```xml

<person>

<name>Alice</name>

<age>30</age>

<city>New York</city>

</person>

```

###### 2.2.2.2 使用Python处理XML数据的方法

Python提供了ElementTree模块用于解析XML数据,下面是一个简单示例:

```python

import xml.etree.ElementTree as ET

# XML字符串

xml_str = '<person><name>Bob</name><age>25</age></person>'

# 解析XML字符串

root = ET.fromstring(xml_str)

print(root.find('name').text) # 输出: Bob

```

通过上述介绍,我们了解了JSON和XML两种常见数据格式以及在Python中的处理方法。这为后续章节中更深入的数据解析技巧奠定了基础。

# 3. Python爬虫中的数据解析技巧

3.1 选择合适的解析库

数据解析在网络爬虫中起着至关重要的作用,而选择合适的解析库可以极大地提高数据提取的效率和准确性。在Python爬虫中,常用的解析库包括Beautiful Soup和lxml,它们都具有解析HTML和XML等数据格式的能力。

#### 3.1.1 Beautiful Soup库

Beautiful Soup是一个强大的解析库,能够帮助我们快速解析HTML和XML等文档,提取我们需要的信息。下面简要介绍一下Beautiful Soup的基本用法。

##### 3.1.1.1 Beautiful Soup的基本用法

首先,我们需要安装Beautiful Soup库。使用pip可以很方便地进行安装:

```bash

pip install beautifulsoup4

```

接下来,我们可以通过导入库来开始解析文档:

```python

from bs4 import BeautifulSoup

```

##### 3.1.1.2 使用Beautiful Soup解析HTML

假设我们有一个HTML文档,要提取其中的某个标签内容,可以这样操作:

```python

html_doc = "<html><head><title>Test</title></head><body><p>This is a test.</p></body></html>"

soup = BeautifulSoup(html_doc, 'html.parser')

print(soup.p.get_text())

```

这段代码将输出`This is a test.`,即`<p>`标签中的文本内容。

##### 3.1.1.3 使用Beautiful Soup解析XML

除了解析HTML,Beautiful Soup也可以用于解析XML数据。比如我们有一个XML文档,要提取其中的节点内容,可以这样做:

```python

xml_doc = "<note><to>Tove</to><from>Jani</from><heading>Reminder</heading><body>Don't forget me this weekend!</body></note>"

soup = BeautifulSoup(xml_doc, 'xml')

print(soup.body.get_text())

```

以上代码将输出`Don't forget me this weekend!`,即`<body>`节点内的文本内容。

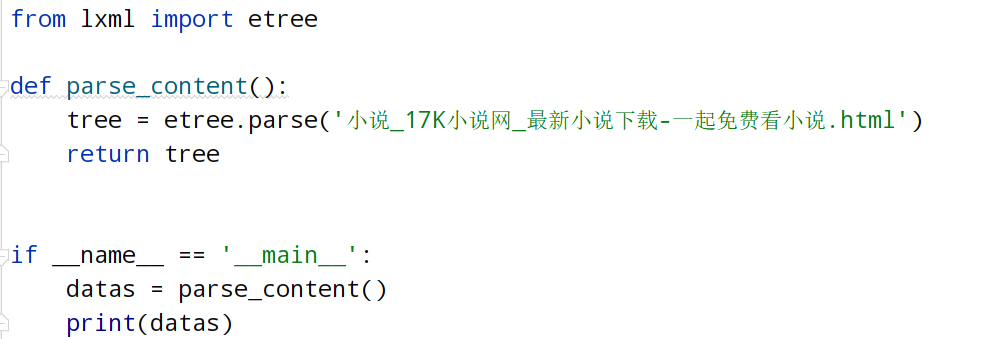

#### 3.1.2 lxml库

lxml是Python中另一个常用的解析库,与Beautiful Soup类似,可以用于解析HTML和XML文档,但在某些方面有着不同的优势。

##### 3.1.2.1 lxml库的优势

lxml解析速度较快,且能够处理较为复杂的XML文档。要使用lxml库,首先需要安装:

```bash

pip install lxml

```

接着,可以这样导入库:

```python

from lxml import etree

```

##### 3.1.2.2 使用lxml库解析HTML

假设我们有一个HTML文档,要提取其中的某个标签内容,可以这样操作:

```python

html = "<html><body><h1>Heading</h1><p>Paragraph</p></body></html>"

tree = etree.HTML(html)

print(tree.xpath('//h1/text()')[0])

```

这段代码将输出`Heading`,即`<h1>`标签中的文本内容。

##### 3.1.2.3 使用lxml库解析XML

类似地,如果我们有一个XML文档,想要提取其中的某个节点内容,可以这样进行:

```python

xml = "<root><child>Child Node</child></root>"

root = etree.fromstring(xml)

print(root.xpath('//child/text()')[0])

```

以上代码将输出`Child Node`,即`<child>`节点内的文本内容。

# 4. 高级数据解析技巧与应用

4.1 使用正则表达式进行数据匹配

正则表达式(Regular Expression)是一种强大的文本匹配工具,通过一系列字符和字符组合构成的搜索模式,可以用来匹配和查找符合特定模式的文本内容。在数据解析中,正则表达式常被用于从文本中提取特定信息或匹配特定模式的数据。

#### 4.1.1 正则表达式基础知识

正则表达式中的基本元字符:

- `.`:匹配任意一个字符

- `^`:匹配字符串的开头

- `$`:匹配字符串的结尾

- `*`:匹配前一个字符0次或多次

- `+`:匹配前一个字符1次或多次

- `?`:匹配前一个字符0次或1次

- `\d`:匹配数字字符

- `\w`:匹配字母、数字或下划线字符

- `[]`:匹配括号内的任意一个字符

#### 4.1.2 在Python中如何使用正则表达式

在Python中,可以使用内置的re模块来操作正则表达式。以下是一个简单的示例代码,展示了如何使用正则表达式从文本中匹配出所有的ip地址:

```python

import re

data = "IP addresses: 192.168.0.1, 10.0.0.1, 172.16.0.1"

pattern = r'\b(?:\d{1,3}\.){3}\d{1,3}\b'

ip_addresses = re.findall(pattern, data)

print("Found IP addresses:")

for ip in ip_addresses:

print(ip)

```

通过以上代码,你可以轻松地利用正则表达式匹配出指定格式的数据,实现灵活的数据提取和匹配操作。

4.2 处理动态加载页面数据

动态加载页面数据指的是网页内容通过JavaScript等前端技术实现异步加载,从而使页面内容在不刷新的情况下动态更新。在爬虫中,如果需要获取这部分数据,传统的静态解析方法可能无法满足需求,需要借助一些工具来模拟浏览器行为来获取动态加载的数据。

#### 4.2.1 网页数据加载方式简介

网页数据加载方式主要分为两种:

- 静态页面加载:一次性加载完整页面内容

- 动态页面加载:通过JavaScript等技术动态获取和更新部分页面内容

#### 4.2.2 使用Selenium实现动态页面数据解析

Selenium是一个自动化测试工具,也可以用于模拟浏览器操作,支持多种浏览器,可以实现对JavaScript渲染的页面进行操作和数据获取。

以下是一个简单示例,介绍了如何使用Selenium来获取动态加载页面数据:

```python

from selenium import webdriver

# 使用Chrome浏览器驱动

driver = webdriver.Chrome()

driver.get("https://example.com")

# 等待网页加载完成

driver.implicitly_wait(10)

# 获取动态数据

dynamic_data = driver.find_element_by_css_selector(".dynamic-data").text

print("Dynamic Data:", dynamic_data)

driver.quit()

```

通过Selenium,你可以方便地模拟浏览器操作,实现对动态加载页面数据的抓取与解析,提升爬虫的灵活性和适用性。

# 5. 实战项目:利用Python爬虫和数据解析完成网站信息汇总

在本章中,我们将通过一个实战项目来展示如何利用Python爬虫和数据解析技巧来完成网站信息的汇总。我们将选择一个示例网站进行爬取,并使用不同的库和技术来解析和处理网站数据,最终将信息进行汇总分析。这个实战项目将包括以下内容:

#### 5.1 选定示例网站和分析需求

为了方便演示,我们选择一个包含新闻和文章的示例网站作为目标网站。我们的任务是爬取网站上的文章内容、作者、发布时间等信息,并将这些信息进行汇总统计。

#### 5.2 利用Requests库爬取网页内容

首先,我们将使用Python的Requests库来发送HTTP请求,获取网站的HTML内容。这一步是爬虫的起点,通过获取网页内容,我们才能进行后续的数据解析工作。

```python

import requests

url = 'https://example-website.com'

response = requests.get(url)

html_content = response.text

print(html_content)

```

#### 5.3 使用Beautiful Soup解析HTML内容

接下来,我们将使用Beautiful Soup库来解析获取到的HTML内容,从中提取我们需要的信息,如文章标题、作者、发布时间等。

```python

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'html.parser')

# 解析HTML内容,获取文章标题

title = soup.find('h1').text

# 获取作者信息

author = soup.find(class_='author').text

# 获取发布时间

publish_date = soup.find(class_='publish-date').text

print('文章标题:', title)

print('作者:', author)

print('发布时间:', publish_date)

```

#### 5.4 数据汇总与分析

在这一步,我们将汇总所有爬取到的数据,包括文章标题、作者、发布时间等信息,并进行一些简单的数据分析,如计算文章数量、作者排名等。

```python

# 将文章信息存储到字典中

article_info = {

'title': title,

'author': author,

'publish_date': publish_date

}

# 可以将多篇文章信息存储在列表中,进行进一步的分析

# 进行数据分析

# 比如计算文章数量

num_articles = len(article_info)

print('总共爬取到', num_articles, '篇文章')

```

#### 5.5 结果展示与可视化

最后,我们可以根据爬取和分析的结果,结合一些数据可视化的方法,如绘制条形图、饼图等,来直观展示网站信息的统计结果。

```python

import matplotlib.pyplot as plt

# 假设有一个authors列表包含了所有文章的作者信息

authors = ['Alice', 'Bob', 'Alice', 'Charlie', 'Dave']

# 统计作者出现次数

author_counts = {}

for author in authors:

author_counts[author] = author_counts.get(author, 0) + 1

# 绘制作者排名条形图

plt.bar(author_counts.keys(), author_counts.values())

plt.xlabel('Authors')

plt.ylabel('Number of Articles')

plt.title('Author Ranking')

plt.show()

```

通过以上实战项目,我们展示了如何利用Python爬虫和数据解析技巧,完成对网站信息的爬取、解析和统计分析,为数据采集和处理提供了一个具体的实例。在实际项目中,可以根据需求和情景进一步拓展和优化这些方法,实现更加复杂和高效的数据处理过程。

0

0