Redis缓存失效策略详解:如何避免缓存击穿、穿透和雪崩

发布时间: 2024-07-06 04:50:53 阅读量: 74 订阅数: 26

# 1. Redis缓存失效概述

缓存失效是指缓存中存储的数据不再有效,需要从源数据重新获取。Redis提供了多种失效策略来管理缓存失效,包括惰性失效、定期失效和主动失效。

惰性失效策略在缓存数据被访问时才检查其是否失效,如果失效则重新获取数据。定期失效策略定期检查缓存中的所有数据,如果发现失效则删除。主动失效策略通过监听源数据的变化,在源数据发生变化时主动使缓存数据失效。

# 2. 缓存失效策略

缓存失效策略是针对缓存中数据的生命周期进行管理的策略,其目的是在保证数据一致性的同时,提高缓存的命中率和性能。不同的失效策略有不同的优缺点和适用场景,选择合适的失效策略对于优化缓存性能至关重要。

### 2.1 惰性失效策略

惰性失效策略是一种基于访问数据的策略。当数据被访问时,才会检查其是否失效。如果数据已经失效,则重新从数据源获取并更新缓存。

#### 2.1.1 优点和缺点

**优点:**

- 命中率高:只有在数据被访问时才会检查失效,避免了不必要的失效检查。

- 节省资源:只在需要时才更新缓存,减少了对数据源的访问和缓存的更新操作。

**缺点:**

- 可能导致缓存击穿:当多个请求同时访问同一个失效的数据时,可能会导致缓存击穿。

- 数据不一致:在数据失效后,直到被访问之前,缓存中仍然是失效的数据。

#### 2.1.2 应用场景

惰性失效策略适用于以下场景:

- 数据访问频率较低,更新频率较高的场景。

- 缓存击穿风险较低的场景。

- 数据不一致性容忍度较高的场景。

### 2.2 定期失效策略

定期失效策略是一种基于时间的策略。在数据被写入缓存时,同时设置一个失效时间。当失效时间到期后,数据将从缓存中移除。

#### 2.2.1 优点和缺点

**优点:**

- 避免缓存击穿:通过设置失效时间,可以避免多个请求同时访问同一个失效的数据。

- 数据一致性:失效时间到期后,缓存中不会再有失效的数据。

**缺点:**

- 命中率较低:即使数据没有失效,也会在失效时间到期后被移除,导致命中率降低。

- 资源浪费:即使数据没有被访问,也会在失效时间到期后被重新加载,造成资源浪费。

#### 2.2.2 应用场景

定期失效策略适用于以下场景:

- 数据访问频率较高,更新频率较低的场景。

- 缓存击穿风险较高的场景。

- 数据一致性要求较高的场景。

### 2.3 主动失效策略

主动失效策略是一种基于事件的策略。当数据源中的数据发生变化时,会触发缓存失效操作,将该数据从缓存中移除。

#### 2.3.1 优点和缺点

**优点:**

- 数据一致性高:数据源中的数据发生变化后,缓存中的数据也会立即失效,保证了数据的一致性。

- 命中率较高:由于数据失效后会被立即移除,避免了缓存中存在失效数据的现象,提高了命中率。

**缺点:**

- 性能开销:需要在数据源中实现失效通知机制,增加了系统复杂度和性能开销。

- 适用场景受限:只有当数据源支持失效通知时,才能使用主动失效策略。

#### 2.3.2 应用场景

主动失效策略适用于以下场景:

- 数据更新频率较高,数据一致性要求极高的场景。

- 数据源支持失效通知的场景。

- 性能开销可以接受的场景。

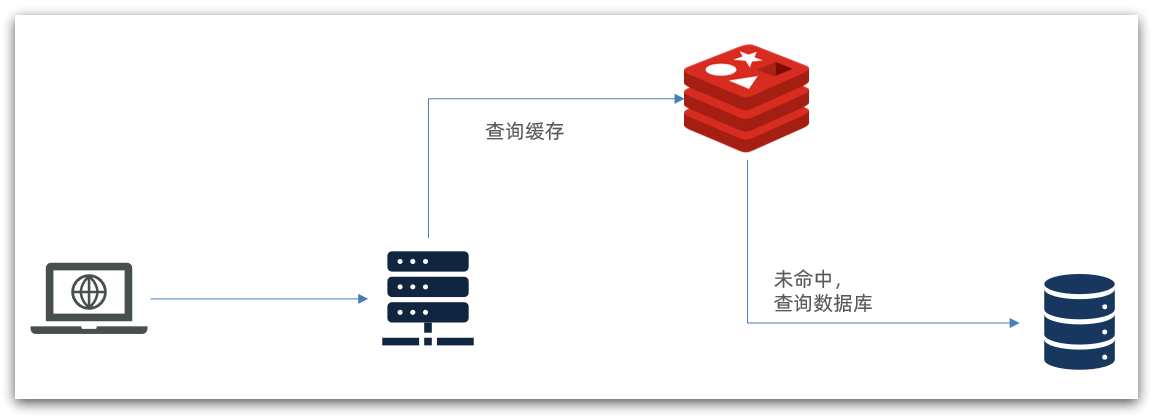

# 3.1 缓存击穿

#### 3.1.1 产生原因

缓存击穿是指缓存中没有数据,并且在同一时间有多个请求同时访问同一个 key,导致所有请求都直接穿透到后端存储系统,给后端存储系统造成巨大压力。

缓存击穿通常发生在以下场景:

- **热点数据过期:**当热点数据过期时,缓存中没有数据,大量请求同

0

0