Kubernetes在VMware中的高级配置:专家解析与最佳实践

发布时间: 2024-12-10 02:33:38 阅读量: 32 订阅数: 11

VMware vSphere: 安装配置与高级管理全面指南

# 1. Kubernetes基础与VMware概述

## 1.1 Kubernetes的定义与重要性

Kubernetes是一个开源的容器编排平台,用于自动化部署、扩展和管理容器化应用程序。它简化了微服务架构的复杂性,使得开发者能够专注于创建和优化业务逻辑。Kubernetes通过自动化容器的调度、运维和扩展,提供了一种灵活和可伸缩的系统,旨在加速创新并减少运维成本。

## 1.2 VMware的介绍与特点

VMware是业界领先的虚拟化和云平台提供商,其核心产品包括vSphere、vCenter等,为用户提供了构建和管理虚拟环境的强大工具。VMware不仅支持传统IT环境的虚拟化,还能很好地与现代云计算技术相结合,提供稳定可靠的基础设施服务。

## 1.3 Kubernetes与VMware的集成优势

将Kubernetes部署在VMware基础架构之上,可以结合两者的优势:Kubernetes为容器化应用提供了快速迭代和高度弹性的运行环境,而VMware则保证了底层虚拟化资源的高效管理和稳定性。这种组合使得用户既能够享受容器技术带来的便利,又能够在复杂的IT环境中保持高可用性和可靠性。

```mermaid

graph LR

A[应用开发] -->|容器化| B(Kubernetes)

B -->|编排与调度| C(VMware虚拟环境)

C --> D[IT资源管理]

```

在下一章节中,我们将深入探讨如何在VMware环境中部署和配置Kubernetes集群。

# 2. Kubernetes在VMware中的部署与配置

在当今的云原生时代,Kubernetes已成为容器编排的代名词,而VMware则依然是企业级虚拟化技术的代表。将Kubernetes部署在VMware环境上,可以使得传统IT基础设施与新兴技术实现无缝对接,为数据中心提供更高的灵活性和可扩展性。下面我们将深入探讨在VMware环境下搭建Kubernetes集群的详细步骤以及高级网络配置和存储解决方案。

### 2.1 Kubernetes集群的搭建

#### 2.1.1 准备工作与环境要求

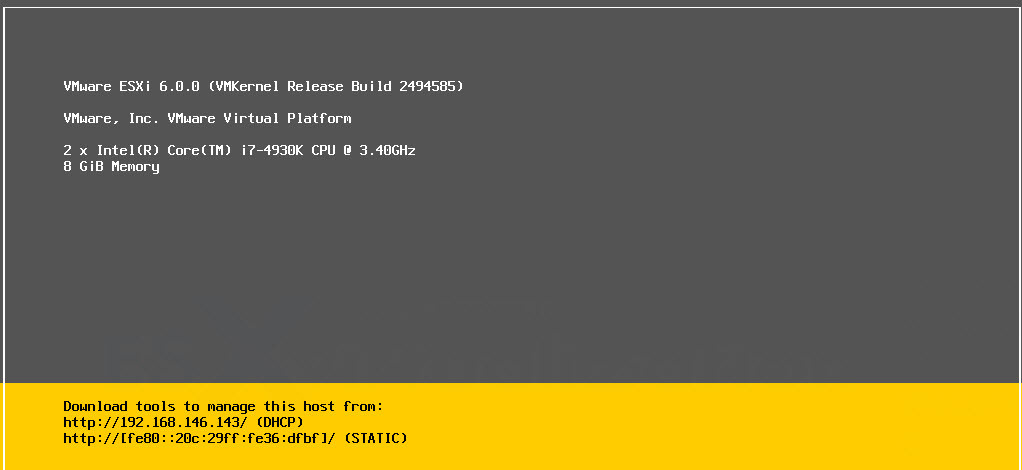

在开始部署Kubernetes集群之前,需要确保已经安装并配置好了VMware环境,比如VMware vSphere。此外,还需要准备一台或几台物理服务器来运行Kubernetes控制平面(Master)和工作节点(Node)。物理服务器的硬件要求取决于集群的规模,但通常包括足够的CPU核心、内存和存储空间。例如,控制平面节点至少需要2个CPU核心和2GB内存,而工作节点则需要至少1个CPU核心和2GB内存。

在部署之前,需要在VMware vSphere中创建虚拟机模板,并以此模板来部署所有的Kubernetes节点。每个节点还需要安装Docker或者containerd作为容器运行时环境。

```bash

# 以CentOS 7为例,安装Docker

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

yum install docker-ce docker-ce-cli containerd.io -y

systemctl start docker

```

上述命令会在VMware中创建的每个虚拟机上安装Docker容器运行时,并启动Docker服务。

#### 2.1.2 使用VMware部署Kubernetes集群

在准备好了环境和安装了必要的软件后,下一步是在VMware中创建虚拟机并部署Kubernetes集群。可以通过自动化部署工具,如Kubeadm,来简化这一过程。首先,需要在控制平面节点上初始化集群,然后将工作节点加入到集群中。

初始化集群的命令如下:

```bash

# 在控制平面节点上执行

kubeadm init --pod-network-cidr=10.244.0.0/16 --kubernetes-version=$(kubelet --version | cut -d ' ' -f 2 | sed 's/-.*//')

```

初始化完成后,使用`kubeadm join`命令将工作节点加入到集群:

```bash

# 在工作节点上执行,该命令会显示在kubeadm init的输出信息中

kubeadm join [api-server-endpoint]:[port] --token [token] --discovery-token-ca-cert-hash sha256:[hash]

```

### 2.2 高级网络配置

#### 2.2.1 Kubernetes网络模型简介

Kubernetes网络模型是基于每个容器都有自己的IP地址,且所有容器都能够无须NAT直接与其它容器通信的模型。为了实现这一点,Kubernetes使用了CNI(Container Network Interface)插件。CNI插件为容器提供了网络连接能力,并在容器创建时分配IP地址。

#### 2.2.2 配置网络插件和策略

部署集群时,可以使用Calico、Flannel、Cilium等网络插件。以下是使用Calico网络插件的一个示例配置:

首先下载Calico的配置文件:

```bash

curl https://docs.projectcalico.org/master/manifests/calico.yaml -O

```

然后可以自定义该配置文件,比如设置Pod网络范围,启用IP地址池等:

```yaml

# 部分配置示例

apiVersion: projectcalico.org/v3

kind: CalicoAPIVersion

metadata:

name: v3

spec:

apiVersion: projectcalico.org/v3

apiVersion: projectcalico.org/v3

kind: IPPool

metadata:

name: default-ippool

spec:

cidr: 10.244.0.0/16

blockSize: 26

nodeSelector: all()

ipipMode: Always

natOutgoing: true

```

配置完成后,使用kubectl命令部署Calico:

```bash

kubectl apply -f calico.yaml

```

### 2.3 存储解决方案

#### 2.3.1 集群存储概述

在Kubernetes集群中,持久化存储通常通过Persistent Volume (PV) 和 Persistent Volume Claim (PVC)来实现。PV是集群中的存储资源,而PVC则是对这些资源的申请。用户通过PVC请求存储资源,而PV则是实际提供给Pod使用的存储。

#### 2.3.2 配置VMware中的持久存储

在VMware环境下配置持久存储,通常会使用VMware vSAN或者NFS共享存储。以下是一个使用NFS作为持久存储的示例。

首先,部署一个NFS服务器作为共享存储:

```bash

# 在NFS服务器上安装nfs-utils包

yum install -y nfs-utils

# 创建一个共享目录

mkdir -p /var/nfs_share

chmod 755 /var/nfs_share

# 配置/etc/exports以共享目录

echo "/var/nfs_share *(rw,sync,no_root_squash)" >> /etc/exports

exportfs -a

systemctl enable rpcbind

systemctl start rpcbind

systemctl enable nfs-server

systemctl start nfs-server

```

然后,在Kubernetes集群中的每个节点上安装nfs-client:

```bash

# 安装nfs-client-provisioner

kubectl apply -f https://raw.githubusercontent.com/kubernetes-sigs/nfs-subdir-external-provisioner/master/deploy/nfs-client-provisioner.yaml

```

最后,配置一个StorageClass来指定NFS存储的提供者:

```yaml

# 示例StorageClass配置

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: nfs-client

provisioner: cluster.local/nfs-client

parameters:

archiveOnDelete: "true"

```

配置完StorageClass后,就可以在PVC中引用它来动态分配存储了。

通过上述步骤,Kubernetes集群就可以在VMware环境上成功搭建并配置网络和存储了。下一章,我们将探讨如何对这个集群进行监控和日志管理。

# 3. Kubernetes集群的监控与日志管理

## 3.1 监控工具的选择与配置

### 3.1.1 介绍常用的Kubernetes监控工具

在现代的云原生环境中,监控是确保服务质量的关键组成部分。针对Kubernetes环境,有许多优秀的监控工具可以用于跟踪资源利用率、系统性能以及应用健康状况。一些广泛使用的工具包括Prometheus、Grafana、Heapster(已被废弃)、Kube-state-metrics等。

- **Prometheus**:这是一个开源的监控和警报工具,它对于动态的云原生环境特别有用。Prometheus的设计理念是高可用性,并且它非常适合对Kubernetes集群进行监控,因为它可以轻松地抓取和存储时间序列数据。

- **Grafana**:这是一个开源的可视化工具,经常与Prometheus一起使用,因为Grafana支持Prometheus的数据源,并提供了丰富的图表和仪表板功能,这使得数据可视化变得直观且易于理解。

- **Heapster**:这是Kubernetes集群的旧有监控解决方案,它能够聚合节点和Pod的监控数据。但是,Heapster已经在多个版本中被弃用,并被推荐使用的替代方案所取代,如kube-state-metrics和metrics-server。

- **Kube-state-metrics**:这个工具提供了关于Kubernetes对象状态的只读指标。与Heapster不同,kube-state-metrics不会聚合任何数据,但它提供了对集群状态的更细致视图。

### 3.1.2 集成监控工具到VMware环境

要将监控工具集成到VMware环境中的Kubernetes集群,可以遵循以下步骤:

1. **部署Prometheus:** 在Kubernetes集群中部署Prometheus服务器。可以通过Helm chart来实现,Helm是Kubernetes的包管理器,能简化安装过程。例如,使用下面的Helm命令部署Prometheus:

```bash

helm install stable/prometheus --name prometheus-server

```

2. **配置Grafana:** 部署Grafana服务器,并将其连接到Prometheus实例。同样,Helm可以简化Grafana的安装:

```bash

helm install stable/grafana --name grafana

```

3. **配置数据源:** 在Grafana中设置Prometheus作为数据源,并创建仪表板来展示集群状态。

4. **部署监控代理:** 如果需要更细粒度的监控,可以在每个VMware虚拟机上部署node_exporter,这是Prometheus的一个组件,用于收集主机级别的指标。

5. **设置警报规则:** 通过Prometheus定义警报规则,当达到某个阈值时,Grafana可以根据这些规则发送通知。

通过以上步骤,您可以将监控工具集成到VMware环境中的Kubernetes集群,并实时监控资源使用情况和集群状态。

## 3.2 日志收集与分析

### 3.2.1 配置日志收集机制

在Kubernetes环境中,日志收集是至关重要的,因为它能够帮助开发人员和运维人员了解应用行为和集群的健康状况。对于集群中的日志收集,通常会使用如Fluentd或ELK(Elasticsearch, Logstash, Kibana)堆栈等工具。

要配置日志收集机制,您可以按照以下步骤操作:

1. **部署Fluentd或ELK:** 选择一个日志处理工具,并在Kubernetes集群中进行部署。例如,使用Fluentd作为日志收集器,可以通过Helm chart来部署:

```bash

helm install stable/fluentd-elasticsearch --name fluentd

```

2. **配置日志源:** 为Kubernetes工作负载(Pods)配置日志源。这通常涉及到更新容器的配置,让它们将日志输出到标准输出(stdout)和标准错误(stderr)。

3. **配置日志传输:** Fluentd需要配置文件来指定如何读取、解析和转发日志数据。在Helm部署Fluentd时,通常会有默认的配置文件,但根据实际需求可能需要自定义。

4. **设置存储目的地:** 定义日志数据的存储目的地。例如,Fluentd可以将日志数据发送到Elasticsearch或直接发送到对象存储服务。

### 3.2.2 日志分析和可视化工具应用

日志分析的目的是从日志数据中提取有用的信息,帮助团队了解问题的根本原因,进行故障排查和性能优化。配置好日志收集机制后,接下来就是设置日志分析和可视化工具。

1. **配置Elasticsearch(如果使用ELK):** Elasticsearch是一个分布式搜索和分析引擎。当Fluentd将日志数据发送到Elasticsearch时,可以创建索引来存储日志数据,并允许执行搜索和分析。

2. **设置Kibana仪表板:** Kibana是一个基于Web的分析和可视化工具,可以连接到Elasticsearch集群。使用Kibana,可以创建自定义的仪表板来展示日志数据的实时视图。

3. **利用ELK进行日志分析:** 通过Elasticsearch强大的查询语言(Elasticsearch Query DSL)来查询日志数据,使用Kibana进行数据可视化,从而快速识别出集群中的问题或异常行为。

4. **利用Fluentd的过滤功能:** 如果使用Fluentd,可以利用其内置的过滤器插件来处理和丰富日志数据,例如,可以使用fluent-plugin-record-reformer插件来修改和重构日志格式。

5. **集成第三方分析服务:** 根据需要,还可以集成第三方日志分析服务,如Splunk、Loggly或Papertrail等。

通过上述配置和分析步骤,您可以在Kubernetes集群中实现有效的日志管理和监控,为集群的稳定运行提供保障。

到此,我们已经介绍了如何在Kubernetes集群中配置和集成监控与日志管理工具。在下一章节,我们将深入探讨如何进行高级Kubernetes配置以及优化,从而提高集群的性能和可靠性。

# 4. 高级Kubernetes配置与优化

## 4.1 资源管理与调度策略

### 4.1.1 高级调度器使用

Kubernetes 提供了高度灵活的调度机制,允许用户根据特定需求对 Pod 进行调度。在高级调度器中,可以使用调度预选和优选阶段来细化 Pod 调度过程。调度预选阶段过滤掉不满足条件的节点,而优选阶段则根据设定的规则给节点打分,选出最佳节点。

```yaml

apiVersion: v1

kind: Pod

metadata:

name: my-pod

spec:

containers:

- name: my-container

image: my-image

schedulerName: my-custom-scheduler

```

在上述示例中,`schedulerName` 字段指定了使用名为 `my-custom-scheduler` 的自定义调度器。实现自定义调度器需要编写一个调度器程序,该程序通过监听 Kubernetes API 服务器事件来调度 Pod。

```go

// Go 伪代码示例展示如何监听 Pod 事件

func main() {

watch, err := clientset.CoreV1().Pods("default").Watch(metav1.ListOptions{

FieldSelector: fields.OneTermEqualSelector("spec.schedulerName", "my-custom-scheduler").String(),

})

if err != nil {

log.Fatalf("Error setting up watch: %v", err)

}

for event := range watch.ResultChan() {

switch event.Type {

case watch.Added, watch.Modified:

// 处理添加或修改的 Pod 事件

}

}

}

```

### 4.1.2 资源配额和限制策略

在多租户环境中,资源配额和限制策略对于保证集群稳定性和服务质量至关重要。资源配额可以限制命名空间中可以创建的资源数量,而资源限制可以指定 Pod 可以使用的最小和最大资源。

```yaml

apiVersion: v1

kind: ResourceQuota

metadata:

name: compute-quota

namespace: my-namespace

spec:

hard:

pods: "10"

requests.cpu: "4"

requests.memory: 5Gi

limits.cpu: "8"

limits.memory: 10Gi

```

在此配置中,为 `my-namespace` 命名空间设置了 Pod 数量的配额上限为 10,并对 CPU 和内存的请求和限制进行了定义。

## 4.2 高可用性配置

### 4.2.1 高可用集群设计

为了实现 Kubernetes 高可用集群,通常需要部署至少三个控制平面节点以及多个工作节点。每个控制平面节点都运行着 etcd、API 服务器、调度器和控制器管理器。高可用性配置确保即使某些节点或组件出现故障,集群也能继续提供服务。

```mermaid

graph LR

A[Client] -->|请求| B(API Server)

B --> C{etcd}

C -->|数据同步| B

B --> D[Scheduler]

B --> E[Controller Manager]

F[Worker Node] -->|心跳| B

G[Worker Node] -->|心跳| B

H[Worker Node] -->|心跳| B

```

### 4.2.2 失效转移与故障恢复

失效转移确保控制平面的高可用性。当控制平面的一个节点宕机时,其他节点会接管工作,保证集群的持续运行。故障恢复则涉及到恢复失败的节点,使其重新加入集群。

故障恢复流程包括:

1. 检测到节点故障。

2. 控制平面节点开始同步数据到 etcd 集群中的其他节点。

3. 故障节点上的 Pod 会在其他工作节点上重新调度。

4. 故障节点修复后,与 etcd 集群同步数据,然后重新加入集群。

## 4.3 自动伸缩与弹性策略

### 4.3.1 Kubernetes自动伸缩机制

Kubernetes 提供了水平 Pod 自动伸缩 (Horizontal Pod Autoscaler, HPA) 和集群自动伸缩 (Cluster Autoscaler, CA) 功能。HPA 根据 CPU 利用率等指标自动调整 Pod 的副本数量,而 CA 根据资源需求自动增加或减少节点数量。

HPA 配置示例如下:

```yaml

apiVersion: autoscaling/v2beta2

kind: HorizontalPodAutoscaler

metadata:

name: my-hpa

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: my-deployment

minReplicas: 1

maxReplicas: 10

metrics:

- type: Resource

resource:

name: cpu

target:

type: Utilization

averageUtilization: 50

```

在此配置中,HPA 将根据 CPU 利用率自动调整名为 `my-deployment` 的 Deployment 的 Pod 副本数,最小副本数为 1,最大为 10。

### 4.3.2 实现VMware环境中的弹性伸缩

在 VMware 环境中,CA 和 HPA 的集成需要确保自动伸缩与 VMware 的虚拟化资源管理相匹配。这通常需要配置 VMware 资源池和相应的资源限制,以确保在伸缩时可以及时提供或回收资源。

CA 配置需要与 VMware 的 vSphere API 进行集成,以便在节点资源紧张时自动启动新实例或在资源过剩时关闭实例。在 VMware 环境中实施 CA 通常需要以下步骤:

1. 创建 CA 与 vSphere 环境的集成。

2. 确保 vSphere 资源池有足够的资源。

3. 配置 CA 以监控和调整 vSphere 实例。

通过这些高级配置和优化策略,Kubernetes 集群在 VMware 环境中可以实现更高的性能和稳定性,同时保持灵活性和可伸缩性,以满足不断变化的工作负载需求。

# 5. Kubernetes安全实践

随着企业对云原生技术的依赖日益增加,Kubernetes的安全性已经成为了不容忽视的议题。本章节将深入探讨Kubernetes环境下的安全实践,包括认证授权机制、网络策略与安全上下文等关键领域。

## 5.1 认证与授权机制

### 5.1.1 Kubernetes安全模型

Kubernetes安全模型是基于角色的访问控制(RBAC),它允许管理员为集群中的用户和组分配角色。这些角色定义了他们可以执行的操作。为了深入理解这个模型,首先需要了解以下几个核心组件:

- **API Server**: Kubernetes集群的控制平面,是集群内外沟通的桥梁。

- **Subject**: 包括用户、服务账户和用户组等。

- **Role/ClusterRole**: 定义一组规则,这些规则定义了可以执行的操作。

- **RoleBinding/ClusterRoleBinding**: 将角色绑定到一个或多个主体上。

在Kubernetes安全模型中,认证和授权是两个主要的安全机制。

#### 认证

认证是验证用户或服务身份的过程。Kubernetes支持多种认证方式,包括客户端证书认证、密码认证、Token认证以及Webhooks等。一旦用户身份被认证成功,Kubernetes将用户关联到相应的角色。

#### 授权

授权发生在认证之后,是决定用户是否有权限执行请求操作的过程。Kubernetes使用基于角色的访问控制(RBAC)来处理授权。系统将请求的操作与角色关联的权限规则进行比对,从而决定是否授权。

### 5.1.2 配置角色基础认证与授权

#### 创建角色和角色绑定

为了演示如何配置认证和授权,我们首先需要创建一个角色和角色绑定。角色定义了可以访问的资源和允许的操作。

下面是一个创建名为`view-role`的角色的示例,它允许用户读取大多数资源,但不允许修改:

```yaml

kind: Role

apiVersion: rbac.authorization.k8s.io/v1

metadata:

namespace: default

name: view-role

rules:

- apiGroups: ["", "extensions", "apps"]

resources: ["deployments", "pods", "services"]

verbs: ["get", "watch", "list"]

```

创建角色之后,我们需要创建一个角色绑定将角色与用户关联起来:

```yaml

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: view-role-binding

namespace: default

subjects:

- kind: User

name: alice

apiGroup: rbac.authorization.k8s.io

roleRef:

kind: Role

name: view-role

apiGroup: rbac.authorization.k8s.io

```

在这个角色绑定中,用户`alice`被授予了`view-role`角色。这意味着`alice`现在可以在默认命名空间内对部署、Pod和服务进行读取操作。

#### 使用TLS证书进行用户认证

为了使用TLS证书进行用户认证,需要生成一个证书,并为该证书创建一个密钥。以下是创建客户端证书和私钥的基本步骤:

1. 创建一个私钥

```bash

openssl genrsa -out alice.key 2048

```

2. 创建一个证书签名请求(CSR)

```bash

openssl req -new -key alice.key -out alice.csr -subj "/CN=alice/O=users"

```

3. 使用Kubernetes集群的CA证书对CSR进行签名

```bash

openssl x509 -req -in alice.csr -CA /path/to/kubernetes/ca.crt -CAkey /path/to/kubernetes/ca.key -CAcreateserial -out alice.crt -days 365

```

这将生成两个文件:`alice.crt`和`alice.key`,分别代表证书和私钥。将这两个文件配置到用户客户端,当与API Server交互时,API Server会验证证书的有效性并根据角色绑定来授权操作。

## 5.2 网络策略与安全上下文

### 5.2.1 高级网络安全策略实施

Kubernetes的网络策略允许集群管理员控制Pod间的通信。通过定义一组规则,可以指定哪些Pod可以与哪些其他Pod通信,以及允许哪些类型的通信。

#### 网络策略资源定义

网络策略定义了在特定的命名空间内,Pod间通信的规则。以下是一个示例,展示了如何创建一个网络策略来限制特定Pods的入站和出站流量:

```yaml

kind: NetworkPolicy

apiVersion: networking.k8s.io/v1

metadata:

name: test-network-policy

namespace: default

spec:

podSelector:

matchLabels:

role: db

policyTypes:

- Ingress

- Egress

ingress:

- from:

- podSelector:

matchLabels:

role: frontend

ports:

- protocol: TCP

port: 6379

egress:

- to:

- podSelector:

matchLabels:

role: backend

ports:

- protocol: TCP

port: 80

```

在上面的配置中,`test-network-policy`策略指定了`default`命名空间中带有`role: db`标签的Pods。它定义了允许从带有`role: frontend`标签的Pods访问的入站规则,以及允许访问带有`role: backend`标签的Pods的出站规则。

#### 网络策略应用

应用网络策略后,只有符合规则的Pod间通信才会被允许。不符合规则的流量将被拒绝。网络策略的实现依赖于网络插件(例如Calico、Cilium等),这些插件必须被配置为支持Kubernetes的网络策略API。

### 5.2.2 安全上下文和Pod安全策略

Pod安全上下文定义了Pod级别的安全设置,例如运行Pod的用户ID、文件系统的访问控制等。

#### 定义安全上下文

在Pod定义中,可以添加`securityContext`字段来指定安全上下文,如下例所示:

```yaml

apiVersion: v1

kind: Pod

metadata:

name: security-context-demo

spec:

securityContext:

runAsUser: 1000

runAsGroup: 3000

fsGroup: 2000

volumes:

- name: sec-ctx-vol

emptyDir: {}

containers:

- name: sec-ctx-demo

image: gcr.io/google-samples/node-hello:1.0

volumeMounts:

- name: sec-ctx-vol

mountPath: /data/demo

securityContext:

allowPrivilegeEscalation: false

```

在这个示例中,Pod和容器级别的安全上下文被定义为非特权用户(`runAsUser`)和用户组(`runAsGroup`、`fsGroup`)运行。此外,容器的`allowPrivilegeEscalation`设置为`false`以禁止提升权限。

#### 集群级别的Pod安全策略

为了在集群级别强制执行安全策略,可以使用Pod安全策略资源。Pod安全策略定义了Pod可以使用的安全上下文选项和宿主机资源的访问权限。

```yaml

kind: PodSecurityPolicy

apiVersion: policy/v1beta1

metadata:

name: restricted

spec:

privileged: false

seLinux:

rule: RunAsAny

supplementalGroups:

rule: MustRunAs

ranges:

- min: 1

max: 65535

runAsUser:

rule: MustRunAsNonRoot

volumes:

- 'configMap'

- 'emptyDir'

- 'projected'

- 'secret'

- 'downwardAPI'

- 'persistentVolumeClaim'

```

这个策略禁止特权模式运行容器,要求容器运行的用户必须是非根用户,并且限制了容器能够访问的卷类型。在集群中启用Pod安全策略之前,需要确保相关的安全组件已经正确部署,并且所有相关的Pod定义都符合策略规则。

## 总结

Kubernetes的安全实践涉及到多层面的防护,从身份认证、授权机制到网络策略和安全上下文,都需要细致的配置和管理。在本章中,我们深入探讨了如何实现这些安全措施,包括角色基础认证授权、实施高级网络安全策略,以及定义Pod安全上下文。通过这些最佳实践,Kubernetes集群可以更安全地托管关键业务应用和数据。在下一章中,我们将讨论Kubernetes集群的监控与日志管理,这对于维护集群的健康和安全运行至关重要。

# 6. 故障排查与维护

在本章节中,我们将探讨在Kubernetes集群运行过程中可能遇到的常见问题,并提供有效的诊断和解决方案。此外,我们还将讨论如何对系统进行有效的维护以及升级集群的最佳实践。

## 6.1 常见故障诊断与解决

### 6.1.1 故障排查流程

在面对Kubernetes集群的故障时,一个有序的排查流程是至关重要的。通常,排查流程应该遵循以下步骤:

1. **检查事件日志**:利用`kubectl get events`命令查看集群事件,分析异常事件的时间点与可能的原因。

2. **查看Pod状态**:使用`kubectl get pods --all-namespaces`命令查看各个Pod的状态和运行状态,特别是`STATUS`列,可以提供故障的线索。

3. **分析资源使用情况**:通过`kubectl top`命令监控资源使用情况,比如CPU和内存的使用情况,检查是否存在资源不足的问题。

4. **检查网络连接**:确保Pod间的网络通信正常,检查服务的Endpoint以及网络策略是否正确配置。

5. **验证持久化存储**:检查PV和PVC的状态和配置,使用`kubectl describe`来获取详细信息,确保存储的正确性。

6. **检查配置文件**:回顾修改过的配置文件和部署脚本,确认是否有配置错误导致故障。

7. **查看集群节点**:使用`kubectl get nodes`检查集群节点的状态,必要时使用`kubectl describe nodes`获取更详细的信息。

### 6.1.2 实例故障案例分析

举一个常见的故障案例:假设有用户报告说应用程序的Pod一直处于`Pending`状态,无法调度到任何节点上执行。

1. **事件查看**:

```bash

kubectl get events --sort-by=.metadata.creationTimestamp

```

查看最新事件,可能会发现有相关的错误信息,如资源不足。

2. **节点状态分析**:

```bash

kubectl describe node [NodeName]

```

检查节点状态,确认是否有资源不足的情况,比如CPU或内存不足。

3. **调度器日志分析**:

```bash

kubectl logs kube-scheduler-[master-node] -n kube-system

```

查看调度器的日志,确认调度决策过程中是否出现了问题。

通过以上步骤,可能发现的问题原因和解决方案包括:

- 集群资源不足,需要扩展节点或优化资源分配。

- 某个节点出现故障,需要重启或重新调度Pod。

- 配置了不恰当的资源请求和限制,导致无法调度。

## 6.2 系统维护与升级策略

### 6.2.1 定期维护的最佳实践

定期维护是确保Kubernetes集群稳定运行的关键。以下是一些推荐的维护实践:

1. **监控健康状态**:通过内置的`/healthz`和`/livez`端点监控Kubernetes组件的健康状态。

2. **清理无用资源**:定期执行`kubectl delete`命令清理不再使用的资源,比如未使用的PersistentVolumes。

3. **备份重要数据**:使用如Velero之类的备份工具定期备份集群状态,确保数据安全。

4. **维护事件日志**:保持事件日志的清晰和有序,便于故障排查和审计。

### 6.2.2 Kubernetes集群升级方案

集群升级需要谨慎进行,以避免升级过程中出现问题导致服务中断。升级的最佳实践包括:

1. **版本兼容性检查**:在升级前,确保所有使用的插件和应用程序与新版本的Kubernetes兼容。

2. **备份数据**:升级前做好集群状态的备份。

3. **执行升级**:根据Kubernetes的升级指南执行升级,一般采用滚动更新的方式。

4. **验证升级结果**:升级后,通过一系列的测试验证集群功能正常运行。

5. **监控升级过程**:在整个升级过程中,持续监控集群的状态,以便快速响应任何异常。

本章内容详细介绍了在使用Kubernetes集群中可能遇到的常见故障诊断和解决方法,以及有效的系统维护和升级策略。掌握这些知识对于维护一个健康稳定的Kubernetes集群至关重要。

0

0